Znaczenie pliku /robots.txt

Opublikowany: 2020-07-27Ostatnia aktualizacja 27 lipca 2020 r.

Na poprzednim blogu omawialiśmy zalety pliku sitemap.xml na naszej stronie internetowej. Na tym blogu omówimy znaczenie pliku /robots.txt na naszej stronie internetowej.

Na poprzednim blogu omawialiśmy zalety pliku sitemap.xml na naszej stronie internetowej. Na tym blogu omówimy znaczenie pliku /robots.txt na naszej stronie internetowej.

Co to jest /Robots.Txt?

Plik /robots.txt to plik tekstowy znajdujący się w katalogu głównym serwera WWW naszej witryny. Jest to ważny plik, ponieważ służy do przekazywania robotom sieciowym instrukcji dotyczących zawartości naszej witryny. Roboty sieciowe, roboty indeksujące lub pająki to programy używane przez wyszukiwarki do indeksowania zawartości internetowej witryny. Te podane instrukcje nazywają się Protokołem wykluczania robotów.

Plik /robots.txt to plik publiczny, do którego można uzyskać dostęp, wpisując adres URL, taki jak http://wwwmojawitryna.com/robots.txt. Każdy może zobaczyć zawartość pliku i lokalizacje, do których roboty sieciowe nie mają mieć dostępu. Oznacza to, że plik /robots.txt nie powinien być używany do ukrywania krytycznych informacji w Twojej witrynie.

Plik /robots.txt to pierwsza rzecz, której szukają roboty wyszukiwarek podczas odwiedzania witryny... Kliknij, aby tweetowaćSkładnia i zawartość pliku Robot.txt

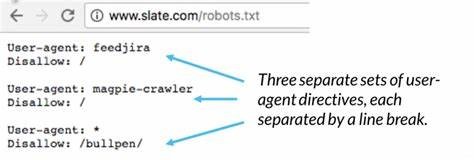

Instrukcje podane w pliku /robots.txt zawierają lokalizację mapy witryny naszej witryny, katalog, do którego chcemy, a którego nie chcemy, aby roboty sieciowe miały dostęp, oraz do jakich stron chcemy, a do których nie chcemy mieć dostępu. Prosta instrukcja składni pliku /robots.txt to:

Agent użytkownika: *

Uniemożliwić: /

Wiersz „User-agent: *” oznacza, że instrukcje w pliku dotyczą wszystkich robotów. „Disallow: /” mówi robotowi, aby nie indeksował żadnych stron w witrynie.

Inne standardowe instrukcje w pliku /robots.txt to:

- Zezwól na pełny dostęp do zawartości witryny internetowej, ale zablokuj folder lub stronę:

Agent użytkownika: *

Nie zezwalaj: /folder/

Zabroń: /strona.html

- Zezwól na pełny dostęp do zawartości witryny, ale zablokuj plik:

Agent użytkownika: *

Nie zezwalaj: / nazwa-pliku.pdf

- Zezwól na pełny dostęp do zawartości witryny, ale zablokuj indeksowanie określonego robota internetowego:

Agent użytkownika: *

Uniemożliwić:

Klient użytkownika: Googlebot

Uniemożliwić: /

Aby uzyskać listę niektórych robotów internetowych, odwiedź stronę https://www.robotstxt.org/db.html

Musimy oddzielić wiersz „Disallow” dla każdego prefiksu adresu URL, który chcemy wykluczyć. Globing i wyrażenia regularne nie są obsługiwane w wierszach User-agent ani Disallow. Znak „*” w polu User-agent to specjalna wartość oznaczająca „dowolny robot”.

Prawidłowy:

Agent użytkownika: *

Nie zezwalaj: / nazwa-pliku.pdf

Nie zezwalaj: /folder1/

Nie zezwalaj: /folder2/

Błąd:

Agent użytkownika: *

Nie zezwalaj: / nazwa-pliku.pdf

Nie zezwalaj: /folder1/ /folder2/

Nie zezwalaj: /folder3/*

Dlaczego plik Robots.txt jest ważny?

Powinniśmy wiedzieć, jak ważny jest plik /robots.txt, ponieważ niewłaściwe użycie tego pliku może zaszkodzić rankingowi witryny . Jest to pierwszy plik, którego szuka robot wyszukiwarki podczas odwiedzania strony internetowej.

Plik /robots.txt zawiera instrukcje, które kontrolują sposób, w jaki roboty wyszukiwarek widzą i wchodzą w interakcję ze stronami internetowymi witryny. Ten plik, a także boty, z którymi wchodzi w interakcje, są podstawowymi elementami działania wyszukiwarki.

Plik /robots.txt jest pierwszą rzeczą, której szukają roboty wyszukiwarki podczas odwiedzania witryny, ponieważ chce wiedzieć, czy ma uprawnienia dostępu do zawartości witryny i jaki folder, strony i pliki mogą być indeksowane.

Niektóre z powodów, dla których plik /robots.txt znajduje się w naszej witrynie, mogą obejmować:

- Mamy treści, które chcemy zablokować w wyszukiwarkach.

- Istnieją płatne linki lub reklamy, które wymagają specjalnych instrukcji dla różnych robotów internetowych.

- Chcemy ograniczyć dostęp do naszej strony renomowanym robotom.

- Opracowujemy działającą witrynę, ale nie chcesz, aby wyszukiwarki ją jeszcze indeksowały.

- Niektóre lub wszystkie powyższe są prawdziwe, ale nie mamy pełnego dostępu do naszego serwera WWW i jego konfiguracji.

Inne metody mogą kontrolować powyższe powody, jednak plik /robots.txt jest właściwym i prostym centralnym miejscem, w którym można się nimi zająć. Jeśli nie posiadamy na naszej stronie pliku /robots.txt, roboty wyszukiwarek będą miały pełny dostęp do naszej strony.

Jakie jest znaczenie kluczowych słów w instrukcji?

„User-agent:” -> Określ, jakie instrukcje zastosować do konkretnego robota. Stwierdzenie takie jak „User-agent: *” oznacza, że dyrektywy dotyczą wszystkich robotów. Oświadczenie takie jak „Klient użytkownika: Googlebot” oznacza, że instrukcje dotyczą tylko Googlebota.

„Disallow:” -> Powiedz robotom internetowym, których folderów nie powinny przeglądać. Oznacza to, że jeśli na przykład nie chcesz, aby wyszukiwarki indeksowały obrazy w Twojej witrynie, możesz umieścić te obrazy w jednym folderze i wykluczyć je, np. „Disallow: /images/”.

„Zezwól:” -> Powiedz robotowi, że może zobaczyć plik w folderze, który został „Zabroniony” przez inne instrukcje. Na przykład:

Agent użytkownika: *

Nie zezwalaj: /obrazy/

Zezwól: /images/myphoto.jpg

„Mapa witryny:” -> Poinformuj robota o lokalizacji pliku mapy witryny. Na przykład:

Agent użytkownika: *

Mapa witryny: https://www.mysite.com/sitemap.xml

Nie zezwalaj: /obrazy/

Zezwól: /images/myphoto.jpg

Metatag Robots, czy to ważne?

Omówiliśmy znaczenie i wykorzystanie pliku /robots.txt na naszej stronie internetowej, ale istnieje inny sposób kontrolowania odwiedzin robotów internetowych na naszych stronach. W ten inny sposób można użyć metatagu Robots.

<nazwa meta=”ROBOTS” content=”NOINDEX, FOLLOW”>

Jak każdy tag <meta>, powinien być umieszczony w sekcji <head> strony HTML. Ponadto najlepiej jest umieścić go na każdej stronie w witrynie, ponieważ robot może napotkać precyzyjny link do dowolnej strony w witrynie.

Jak każdy tag <meta>, powinien być umieszczony w sekcji <head> strony HTML. Ponadto najlepiej jest umieścić go na każdej stronie w witrynie, ponieważ robot może napotkać precyzyjny link do dowolnej strony w witrynie.

Atrybut „nazwa” musi mieć wartość „ROBOTY”.

Prawidłowe wartości atrybutu „treść” to: „INDEX”, „NOINDEX”, „FOLLOW”, „NOFOLLOW”. Dozwolone jest wiele wartości oddzielonych przecinkami, ale oczywiście tylko niektóre kombinacje mają sens. Jeśli nie ma tagu <meta> robots, wartością domyślną jest „INDEX, FOLLOW”, więc nie ma potrzeby opisywania tego. Inne możliwe zastosowania znacznika robots <meta> to:

<nazwa meta=”ROBOTS” content=”INDEX, NOFOLLOW”>

<nazwa meta=”ROBOTS” content=”NOINDEX, NOFOLLOW”>

Użycie metatagu jest bardziej związane z określonymi stronami, których nie chcemy indeksować robotami internetowymi. Nie jest powszechnie używany i jest dokładniejszy i prostszy w kontrolowaniu odwiedzin roboty internetowe za pośrednictwem pliku /robots.txt.

Wniosek

Widzieliśmy, jak ważny jest plik /robots.txt w naszej witrynie, jego składnia i co możemy z nim zrobić w korzyściach płynących z naszej witryny. Widzieliśmy również zastosowanie metatagu robots i jego ograniczenia.

Jeśli jednak z niego korzystamy, musimy upewnić się, że jest on używany prawidłowo. Nieprawidłowy plik /robots.txt może zablokować robotom internetowym indeksowanie naszych stron internetowych, a co ważniejsze, musimy upewnić się, że nie blokujemy stron, które muszą być pozycjonowane przez wyszukiwarki.

—–

Napisane przez Artura S.