Koszmary kampanii optymalizacji pod kątem wyszukiwarek – nieuczciwi programiści

Opublikowany: 2022-01-13

Każdy konsultant SEO natrafia na koszmar optymalizacji wyszukiwarek polegający na tym, że w pewnym momencie swojej kariery musi mieć do czynienia z nieuczciwym programistą.

Poniżej znajduje się kilka zarysów tego, co stanowi nieuczciwego programistę i wpływ, jaki może to mieć na wysiłki kampanii optymalizacji wyszukiwarek Twojego klienta, aby odnieść sukces i stać się rentownym podmiotem online RENTOWNYM.

Tutaj, w That Company, specjalizujemy się nie tylko w dostarczaniu nie tylko usług PPC typu white label, ale także usług optymalizacji wyszukiwarek bezpośrednio dla klientów, ale także prowadzimy bardzo zdrową lokalną agencję SEO.

Jako dostawca usług white label, działamy jako członkowie zespołów naszych firm partnerskich white label. Możemy pracować bezpośrednio z klientami naszego partnera white label pod ich marką lub możemy pracować dla partnera white label jako konsultant, a partner white label może następnie przekazać nasze rekomendacje do wdrożenia przez siebie lub przez swojego klienta.

Niedawno jeden z naszych bardzo silnych partnerów zajmujących się optymalizacją wyszukiwarek pod marką White Label przyniósł nam nowego klienta, z którym moglibyśmy współpracować bezpośrednio pod marką White Label. Podczas naszej pierwszej rozmowy wprowadzającej z klientem końcowym stało się oczywiste, że mamy do czynienia z koszmarem optymalizacji pod kątem wyszukiwarek, jakim jest kontakt z nieuczciwym programistą.

Umowa została podpisana 4 kwietnia 2021 r., a większość naszych rekomendacji nie została jeszcze wdrożona w imieniu klienta.

Umowa została podpisana 4 kwietnia 2021 r., a większość naszych rekomendacji nie została jeszcze wdrożona w imieniu klienta.

Przygotowując się do tej wstępnej rozmowy wprowadzającej, dokonuję wstępnej analizy wszystkich dokumentów, aby sformułować plan strategiczny.

Jednym z tych dokumentów są wyniki indeksowania narzędzia do audytu witryny, które ujawniło następujące elementy:

- txt Blokowanie robotów indeksujących – 1 błąd

- Nie znaleziono XML – 1 błąd

- Brak odniesienia Sitemap.xml – 1 błąd

Od pierwszego pojawienia się wydawało mi się, że będę mógł zacząć od standardowej strategii optymalizacji na stronie.

I to właśnie przygotowałem do zaprezentowania klientowi podczas mojej pierwszej rozmowy.

Mieliśmy dowiedzieć się później, dlaczego w naszych danych raportowania było niewiele błędów audytu witryny, ale omówimy to poniżej.

Procedury wdrażania zarządzania kampanią optymalizacji pod kątem wyszukiwarek

Podczas procesu rozmowy onboardingowej klienta w zakresie optymalizacji pod kątem wyszukiwarek staramy się uzyskać kilka elementów, które są kluczowe dla naszego sukcesu dla klienta.

Prosimy o przyznanie dostępu do ich administracji strony internetowej i plików serwera strony internetowej.

Po około miesiącu deweloper nie przyznał dostępu, a klient, jak się dowiedzieliśmy, nigdy nie miał dostępu do swojej strony internetowej.

Z dalszych rozmów dowiedzieliśmy się, że klient był z tym deweloperem i tzw. ekspertem SEO od 15 lat.

Przez cały ten czas nie było nawet prostej konfiguracji Google Analytics dla witryny.

Więcej dowodów na nieuczciwego programistę.

Kiedy braliśmy pod uwagę, klient miał 349 słów kluczowych w rankingu 100 najlepszych SERP Google, tylko 1 słowo kluczowe na pozycji 1, nazwę marki i tylko 11 słów kluczowych na stronie 1.

Raczej niezdrowe wyniki, aby móc odnieść sukces online w bardzo ograniczonej branży.

Okazało się, że klient próbował rozstać się z tym deweloperem, a nawet zasięgnął porady prawnej. Ta rada brzmiała „zrób to bardzo delikatnie”.

Nawet doradca prawny klienta wiedział, że ten deweloper miał klienta za wróżki.

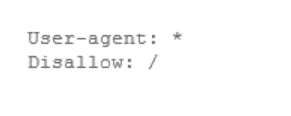

Każdy konsultant SEO natrafia na koszmar związany z optymalizacją wyszukiwarek, polegający na tym, że w pewnym momencie swojej kariery musi mieć do czynienia z nieuczciwym programistą. Kliknij, aby tweetowaćCo z tym blokiem Robots.txt wymienionym powyżej?

Cóż, widzieliśmy tylko trzy błędy generowane przez nasze narzędzie do audytu witryn, gdy zazwyczaj są to setki, jeśli nie tysiące. Począwszy od:

- brak opisów meta

- brakujące tytuły stron

- zduplikowane opisy meta

- zduplikowane tytuły stron

- długie tytuły stron

- krótkie tytuły stron

- długie meta opisy

- krótkie meta opisy

- brakujące tagi h1

- wiele tagów h1

- przekierowane wewnętrzne adresy URL

- uszkodzone linki zewnętrzne

- uszkodzone linki wewnętrzne

- brakujące znaczniki kanoniczne

- i wiele więcej…

Ale żaden z tych błędów nie został zgłoszony.

Wizualna ocena witryny strona po stronie wykazała, że ta witryna nie może być aż tak idealna.

Tak więc ponownie odwiedziliśmy blok w pliku robots.txt i na pewno tam był.

Deweloper zablokował Google i nasze narzędzia do audytu witryny, aby żadne strony nie były indeksowane, z wyjątkiem losowych linków, które witryna z czasem zbierała, umożliwiając Google indeksowanie strony, do której prowadzi łącze, ale żadnych innych, dzięki czemu indeksowane były jakiekolwiek strony.

Jeśli to nie jest nieuczciwe tworzenie stron internetowych, to na pewno nie wiemy, czym jest nieuczciwe tworzenie stron internetowych, ale rozpoznaliśmy oznaki już na samym początku.

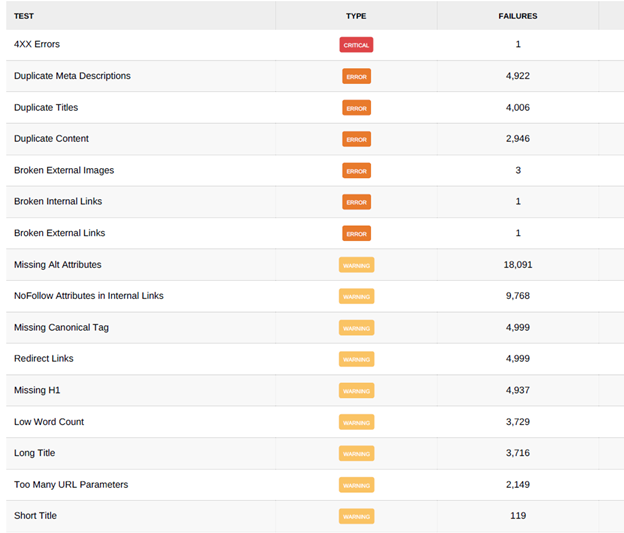

Gdy skłoniliśmy programistę do usunięcia blokady indeksowania, cały krajobraz optymalizacji pod kątem wyszukiwarek drastycznie się zmienił.

Zaindeksowaliśmy witrynę za pomocą naszego podstawowego narzędzia do audytu witryny na początku dnia 17 maja 2021 r. i nadal nie zaindeksowaliśmy żadnych stron, a wynik witryny wynosi 50%, co widać na poniższym obrazku.

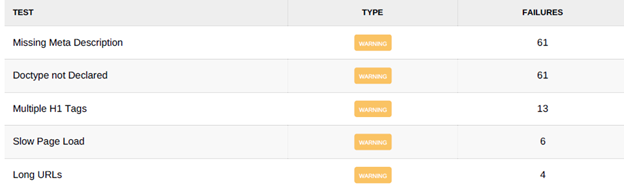

Później tego samego dnia blokada indeksowania została zniesiona z następującymi wynikami osiągnięcia limitu indeksowania stron 5000 i obniżenia wyniku witryny do 22%.

Należy pamiętać, że limit naszego podstawowego narzędzia do indeksowania witryny to 5000 stron na indeksowanie. Poniżej kilka zrzutów ekranu z wynikami po podniesieniu bloku indeksowania.

Zrzut ekranu 1:

Zrzut ekranu 2:

Pod każdym względem ta strona była koszmarem optymalizacji wyszukiwarek. Wszystko przez nieuczciwego programistę.

Wiele zgłoszonych błędów było spowodowanych zduplikowanymi stronami lub po prostu ich brakiem. Odsyłacze w stopce i górnym menu witryny prowadzą do nieistniejących stron.

Mając na uwadze, że nasze podstawowe narzędzie do indeksowania witryny jest ograniczone do 5000 stron na indeksowanie, zauważysz, że istnieje kilka zgłoszonych powyżej problemów, które osiągają ten limit.

Konkretnie:

- Zduplikowane opisy meta

- Brakujące znaczniki kanoniczne

- Przekierowane linki

Przeglądając dane, które znaleźliśmy, na przykład przekierowane linki pochodziły z jednego linku w stopce lub jednego linku w górnym menu.

Dostarczyliśmy programiście instrukcje do poprawienia, co zwykle wymagało od klienta trzech do czterech wiadomości e-mail, które następnie przekazywały rekomendację programiście.

Przy limicie 5000 stron indeksowanych na indeksowanie, za każdym razem, gdy programista wdroży zalecenie, kolejne indeksowanie ujawni, że pojawiło się 5000 nowych problemów związanych z pierwotnym problemem, który powtarzał się w czasie dla każdego problemu.

Od początku czerwca nie zostały wdrożone żadne rekomendacje, a klient nadal zmaga się z kampanią SEO.

Od początku czerwca nie zostały wdrożone żadne rekomendacje, a klient nadal zmaga się z kampanią SEO.

To ostatecznie spowodowało, że klient zapytał nas jako swoich konsultantów SEO, czy powinni zacząć od nowa.

Naszą odpowiedzią było serdeczne TAK!

Przeanalizowaliśmy z klientem, ile rekomendacji wydaliśmy w ciągu ostatnich kilku miesięcy. Że nic nie zostało zaimplementowane, a strona klienta nie prowadziła donikąd, dopóki nie uzyskaliśmy kontroli nad przeznaczeniem serwisu.

Zaowocowało to tym, że nasz partner white label otrzymał satysfakcjonujący kontrakt na przebudowę strony internetowej i zapewnienie pełnego dostępu do klienta i naszego zespołu SEO white label.

Ostatnim zajęciem dla wszystkich właścicieli witryn jest posiadanie WŁASNEJ WITRYNY INTERNETOWEJ!

Dwa z pierwszych pytań, które należy zadać, szukając programisty internetowego, to:

- Czy będę mieć dostęp administracyjny do mojej strony internetowej?

- Czy będę miał dostęp administratora do plików serwera mojej witryny?

Jeśli odpowiedź na którekolwiek z tych pytań brzmi „nie”, musisz odejść i uniknąć koszmaru optymalizacji pod kątem wyszukiwarek, w jaki sposób nieuczciwy programista może zrujnować Twoją kampanię optymalizacji pod kątem wyszukiwarek, a ostatecznie Twój biznes online.