Co to jest audyt witryny SEO?

Opublikowany: 2021-08-11Spis treści

Czym jest audyt strony SEO i jak go wykonać? Wraz z planem treści i strategią organicznej widoczności, ten dokument (lub zestaw dokumentów) stanowi podstawę Twojej działalności SEO. Wdrożenie go dobrze wprowadzi Cię na drogę do sukcesu.

Mając to na uwadze postanowiliśmy przeprowadzić Cię krok po kroku przez proces przeprowadzania audytu SEO .

Audyt SEO to zestaw analiz wykonywanych przez specjalistę SEO. Ma na celu zapewnienie, że witryna spełnia najnowsze standardy optymalizacji wyszukiwarek i nic nie stoi na przeszkodzie, aby realizować strategię organicznego wzrostu.

Co ważne, audyt sam w sobie nie jest strategią. Na początku współpracy zazwyczaj przekazujemy klientowi oba dokumenty jednocześnie. Jednak większość audytów nie obejmuje analizy słów kluczowych ani planu treści (istnieją wyjątki).

Jeśli strona nie zawiera podstawowych błędów, nawet najdokładniejszy audyt ujawni tylko kilka zmarszczek do usunięcia. To najlepszy scenariusz, ponieważ oznacza to, że możesz od razu uruchomić naszą strategię SEO, zamiast wdrażać zalecenia z audytu, co generowałoby dodatkowe koszty dla klienta. W pewnym sensie eksperci SEO są jak lekarze – wszystko, co chcesz im powiedzieć, to „wszystko jest w porządku”.

Ekspert SEO może dokonać ogólnej oceny stanu witryny już na etapie wyceny. Ta wstępna diagnoza służy dopasowaniu oferty audytu i zakresu analizy do potrzeb klienta.

Kiedy wykonać audyt SEO? 4 sytuacje, kiedy potrzebujesz jednego

W miarę wdrażania aktualizacji technicznych

Ekspert SEO powinien przeanalizować wszelkie plany dotyczące głównych aktualizacji przed wdrożeniem. „Główne” aktualizacje obejmują:

- przeniesienie na inny CMS (system zarządzania treścią),

- aktualizacja kodu HTML,

- zmiana adresów URL lub wewnętrznej struktury witryny,

- dodawanie lub usuwanie określonych sekcji, stron lub funkcji.

Czy wiesz, co jest najczęstszym zabójcą wzrostu organicznego w Google? Nie poprawki algorytmu, ale główne aktualizacje zaimplementowane bez wsparcia lub analizy SEO.

Z tego powodu agencja lub ekspert SEO powinien od samego początku uczestniczyć w projektach web designu. Jeśli jesteś na pokładzie od pierwszego dnia, możesz upewnić się, że sama struktura witryny napędza Twoją strategię SEO.

W przypadku problemów z widocznością organiczną

Jeśli Twoje działania SEO zostaną wstrzymane, należy się spodziewać losowych spadków ruchu lub plateau widoczności. Jednak podczas aktywnej kampanii brak wyników jest powodem do niepokoju.

Nagły spadek ruchu organicznego może wskazywać na błędy na stronie lub aktualizację algorytmu Google, która zmieniła ocenę istniejących treści. W obu przypadkach możesz wymagać audytu SEO, który ma na celu zidentyfikowanie problemów, które wymagają naprawy lub dostosowanie strony do nowych kryteriów oceny stosowanych przez roboty wyszukiwarek.

W przypadku aktywnej strategii content marketingu i/lub budowania linków, stagnacja może sugerować obecność niewykrytych błędów, które skutecznie hamują Twój rozwój.

Współpracując z nową agencją SEO

Audyt SEO to standardowa procedura na początku współpracy z dowolną agencją lub ekspertem specjalizującym się w SEO. Aby skutecznie realizować naszą strategię, musimy wiedzieć, że serwis jest sprawny.

Klienci często sprzeciwiają się temu pomysłowi, argumentując, że nowoczesna strona internetowa nie może zawierać żadnych błędów lub że poprzednia agencja przeprowadziła audyt SEO rok wcześniej.

Jednak jako specjalista, który przejmuje odpowiedzialność za nowy projekt i jego wyniki, masz pełne prawo do wglądu w stronę internetową według własnego uznania.

Jako rutyna

Nawet jeśli jakiś czas temu wykonałeś główny audyt SEO, a w międzyczasie nie było żadnych większych zmian, najlepiej przeprowadzać okresowe kontrole. Nie muszą mieć formy pełnowymiarowych audytów technicznych od podstaw. W zależności od wybranych metod audyty rutynowe obejmują:

- przeglądy miesięczne lub kwartalne na podstawie błędów wykrytych podczas audytu wstępnego,

- analizy koncentrowały się na kluczowych kwestiach, takich jak nowe błędy 404.

Dlatego rutynowy audyt ma na celu sprawdzenie, czy od ostatniej kontroli nic nie poszło nie tak. Jak wiemy, każda strona internetowa jest żywa – strony pojawiają się i znikają lub zmieniają lokalizację. Średnie sklepy internetowe są zwykle zarządzane przez kilka osób w firmie i zawsze jest miejsce na błąd ludzki.

Rodzaje audytów SEO

Pełny audyt techniczny SEO

Mówiąc o audycie SEO, mamy na myśli przede wszystkim pełnowymiarową inspekcję techniczną mającą na celu wykrycie wszystkich potencjalnych błędów i niedoskonałości optymalizacji. Audyty te skupiają się na samej stronie internetowej, obejmując perspektywy on-site i off-site. Wyniki przedstawiane są w raporcie SEO sporządzonym przez eksperta SEO, który za pomocą wybranych narzędzi zbiera dane, analizuje wyniki i proponuje rekomendacje dopasowane do produktu klienta.

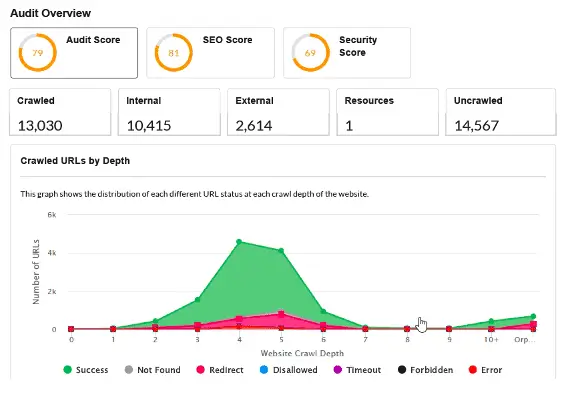

Automatyczne audyty SEO

Audyty automatyczne można podzielić na dwie kategorie:

- szczegółowe raporty PDF generowane przez nowoczesne i wyspecjalizowane roboty, takie jak Sitebulb;

- audyty stron internetowych wykonywane automatycznie za pomocą bezpłatnych narzędzi.

Raporty obu typów mają swoje zastosowania. O ile jednak ten pierwszy typ ułatwia pracę wytrawnemu ekspertowi, o tyle drugi zwykle sprowadza się do pochopnej analizy pewnych podstawowych danych, która nie wystarcza do wyciągnięcia szerszych wniosków.

Raporty drugiego typu są ogólnie dostępne jako bezpłatna zachęta dla klientów.

Audyty konkurencji SEO – benchmarking

Coś zupełnie innego to audyt konkurencji SEO, zwykle przeprowadzany, gdy zaczynamy opracowywać strategię SEO. Łączy analizę widoczności Twojej konkurencji z krótkim audytem technicznym i merytorycznym wybranych rywali.

Audyt ten zapewnia:

- Twój aktualny test porównawczy z konkurencją . Audyt pokazuje, jak Twoja witryna plasuje się w widoczności w Google na tle konkurencji. Możesz aktualizować audyt co kwartał, aby określić, w jaki sposób Twoja strategia wpływa na Twoją pozycję rynkową.

- róg obfitości wiedzy na drodze naszych konkurentów do ich dzisiejszej pozycji i wyników.

Możesz użyć audytu do:

- poznaj rozwiązania optymalizacyjne wykraczające poza standardowe rekomendacje,

- wymyślić nowe pomysły na link building,

- i, co ważne, zdefiniuj lukę treści , która może wskazać Ci nową drogę do organicznego rozwoju – coś, co przegapiłeś, co generuje duży ruch dla konkurencji.

Audyty powdrożeniowe

Po pierwszym audycie klient może zaangażować Cię we wdrożenie rekomendacji (co upraszcza) lub wziąć to na siebie. W tym drugim przypadku najlepiej zakończyć całą procedurę jedną końcową kontrolą, przechodząc przez listę kontrolną punkt po punkcie. Żeby się upewnić, że wszystko jest w porządku.

Audyty e-commerce

Po pierwsze, audyt e-commerce skupia się na architekturze witryny, w tym na głównej nawigacji, kategoriach i podkategoriach. W związku z tym audyty techniczne sklepów internetowych często wymagają dodania strategii użycia słów kluczowych.

Po drugie, audyt powinien przyjrzeć się paginacji i całej strukturze witryny, ponieważ wielu programistów zajmujących się handlem elektronicznym uważa notoryczne stosowanie rel=canonical i robots noindex za lekarstwo na wszystkie bolączki. Efekt: sklepy internetowe z 1000 SKU (jednostek magazynowych), które generują ponad milion zbędnych stron.

Po trzecie, należy skoncentrować się na wyeliminowaniu duplikatów treści – zarówno wewnętrznych (powtarzanych w wielu opcjach produktów), jak i zewnętrznych (w różnych sklepach).

Audyty treści

Audyty treści (nie mylić ze strategią rozwoju lub planem treści) skupiają się na maksymalizacji ruchu organicznego przy wykorzystaniu istniejących zasobów. Mogą obejmować analizy:

- Aktualny stan linkowania wewnętrznego w domenie – cel: ustalić, czy wszystkie Twoje treści tematycznie łączą się ze sobą i czy ten samotny link w zakładce kategorii nie jest jedynym sposobem na odkrycie wartościowego artykułu.

- Potencjalne problemy z kanibalizacją słów kluczowych lub sytuacje, w których jeden temat jest niepotrzebnie dzielony na kilka osobnych artykułów, z których żaden nie ma szans na zdobycie najwyższej rangi.

- Identyfikacja nisko wiszącego owocu, czyli treści, które wymagają jedynie kosmetycznych zmian (linkowanie, reoptymalizacja), aby zacząć generować ruch organiczny.

Dopiero gdy wszystko jest w porządku, możesz przystąpić do tworzenia nowych treści i dalszego rozwoju.

Audyt SEO serwisu lokalnego

Firmy działające lokalnie często korzystają z mniejszych serwisów internetowych, gdzie struktura serwisu i architektura informacji mają drugorzędne znaczenie.

Priorytetem jest tutaj odpowiednia (lokalna) analiza słów kluczowych , która posłuży jako podstawa do planowania stron ofertowych. Poza tym nacisk kładziony jest na:

- przeglądanie i optymalizacja profilu firmy w Google Moja Firma,

- dodawanie lub optymalizacja uporządkowanych danych firmy Lokalna,

- audyt zewnętrznych linków i współczynnik NAP (Nazwa + Adres + Numer Telefonu).

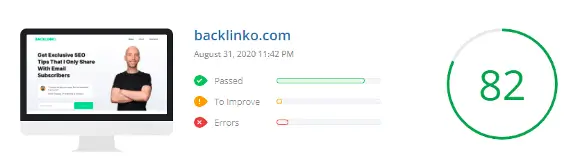

Czy warto wykonać bezpłatny audyt SEO?

Darmowe audyty SEO dostępne w Internecie służą zazwyczaj tylko jednemu celowi – wykryciu wielu (często nieistotnych) błędów, aby w końcu zaoferować płatne usługi.

Pamiętaj, że te audyty są zwykle generowane automatycznie przez narzędzia cyfrowe, a nie opracowywane przez ekspertów SEO.

Często audyt SEO musi wykonać kilka osób specjalizujących się w kwestiach technicznych lub optymalizacji treści.

W niektórych przypadkach zakres audytu, wielkość witryny lub termin wymaga zaangażowania całego zespołu zatrudnionego przez agencję SEO.

Nie ma więc czegoś takiego jak godny zaufania bezpłatny audyt SEO dowolnej strony internetowej.

Jak rozpocząć audyt SEO

Pierwszą rzeczą, którą robię wykonując audyt (lub wcześniej, jak dostaję zapytanie od klienta) jest:

- sprawdź wykres widoczności organicznej w Senuto

- skorzystaj z witryny operatora wyszukiwania:

Zajmuje to łącznie pięć minut i często pozwala mi zidentyfikować wiele problemów na stronie.

Pamiętaj, że na etapie wyceny (a w niektórych przypadkach nawet podczas przeprowadzania audytu) możesz nie mieć dostępu do Google Search Console czy Analytics, więc narzędzia zewnętrzne są niezbędne .

Wystarczy rzut oka na wykres widoczności witryny w Senuto, aby uzyskać mnóstwo informacji na temat dobrego samopoczucia witryny. Przy bliższej inspekcji skoncentruj się na następujących punktach:

- Kierunek wykresu – aby sprawdzić, czy widoczność stale rośnie w ciągu ostatnich kilku lat, bez nagłych skoków i spadków. Jeśli wykres wygląda płasko, zwykle sugeruje brak aktywności organicznej lub poważne problemy, które hamują wzrost.

- Jeśli zauważysz nagłe spadki w krótkim czasie, spróbuj :

- porównanie anomalii z listą głównych znanych aktualizacji algorytmów w wyszukiwarce Google. Jeśli się nakładają, przynajmniej wiesz, z czym walczysz.

- za pomocą WayBackMachine, aby zobaczyć, jak wyglądała strona miesiąc przed i po spadku. W większości przypadków widoczność spada po zakończeniu migracji bez wsparcia eksperta SEO.

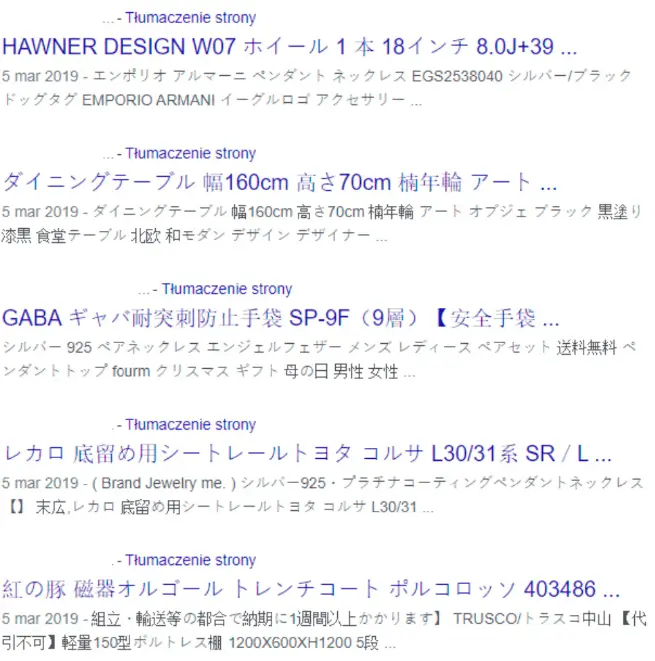

Innym dobrym rozwiązaniem jest użycie często pomijanego operatora site:domena.com. Kliknij kilka pierwszych wyników, aby:

- z grubsza oszacuj rozmiar witryny – nawet jeśli powinieneś przejść do Google Search Console + wybranego robota, aby uzyskać najdokładniejsze dane,

- zobacz ogólną jakość tagów tytułu, tagów metaopisu oraz prezentację wyników.

- często: znajdź podstawowe błędy , takie jak włamanie na stronę lub problemy z indeksacją.

Przykładem:

Klient, który od lat prowadzi swoją działalność, zauważył spadek liczby zamówień i nowe zapytania ze strony firmowej. Za pomocą polecenia site:domena.pl zagadka została natychmiast rozwiązana:

Kluczowe punkty do sprawdzenia podczas audytu SEO

W świecie analizy technicznej uwaga przesunęła się z pojedynczych tagów, takich jak nagłówki Hx, na bardziej globalne kwestie: architekturę witryny, strukturę lub renderowanie (co wynika m.in. z coraz większej sprawności Google w obsłudze różnych typów witryn i technologii). .

Do największych wyzwań przy tworzeniu unikalnego przewodnika po audytach SEO należą:

- Ogromna różnorodność sytuacji i miejsc do sprawdzenia podczas audytu. Różne cele, typy i systemy CMS generują mnóstwo możliwych konfiguracji.

- Wynikające z tego różnice w wadze wykrytych problemów i ich potencjalnych rozwiązaniach.

Teoretycznie mógłbym sporządzić osobną listę najlepszych praktyk optymalizacyjnych i typowych błędów dla każdego systemu CMS i e-commerce. Mając to na uwadze, prawdopodobnie trafniej byłoby nazwać poniższą listę – popartą moją wiedzą z dziesiątek audytów – czymś w rodzaju: Fantastyczne błędy SEO i jak je znaleźć.

Indeksowanie i indeksacja

Robots.txt

Plik robots.txt zarządza lokalizacjami na stronie, które chcesz ukryć przed robotami wyszukiwarek. Służy do blokowania indeksowania, a nie samej indeksacji. W dzisiejszych czasach pliki robots.txt rzadko zawierają błędy, ale może to naprawdę boleć.

Mapa witryny XML

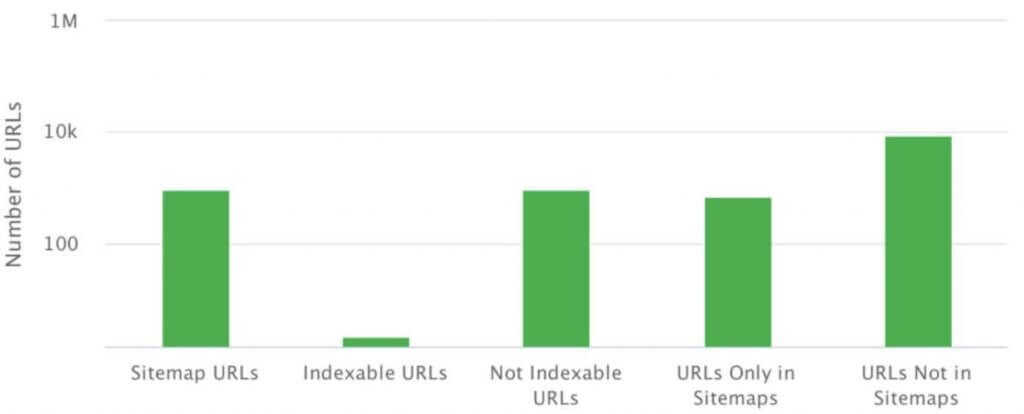

Mapa witryny XML to plik lub zestaw plików zawierający listę wszystkich stron, które chcesz zindeksować w danej strukturze.

Mapę witryny możesz zlokalizować pod dowolnym adresem. Musi jednak prezentować dane w formacie XML zgodnym ze specyfikacją.

Podstawowe błędy związane z mapami witryn XML to:

- brak mapy witryny XML,

- błędy składniowe (zgłaszane w GSC), które uniemożliwiają Google pobranie mapy witryny,

- niezgodność mapy serwisu i struktury serwisu,

- nieuwzględnienie w mapie witryny plików, takich jak grafiki i filmy.

Strony osierocone

Strony osierocone nie są połączone wewnętrznie, ale często renderują się poprawnie i odpowiadają kodem statusu 200. Pojawiają się w Google Search Console, a czasem nawet wspinają się po szczeblach rankingów i generują ruch.

Strony osierocone pojawiają się z wielu powodów, począwszy od błędów CMS, a skończywszy na błędach ludzkich w linkowaniu wewnętrznym lub zewnętrznym.

Rel=kanoniczny

Rel=canonical nie stanowi problemu, gdy jest używany zgodnie z przeznaczeniem – odwołuje się do oryginalnego adresu strony w przypadku duplikacji wewnętrznej. Często jednak mylona jest z panaceum na wszelkie kłopotliwe strony i źle zaplanowane struktury.

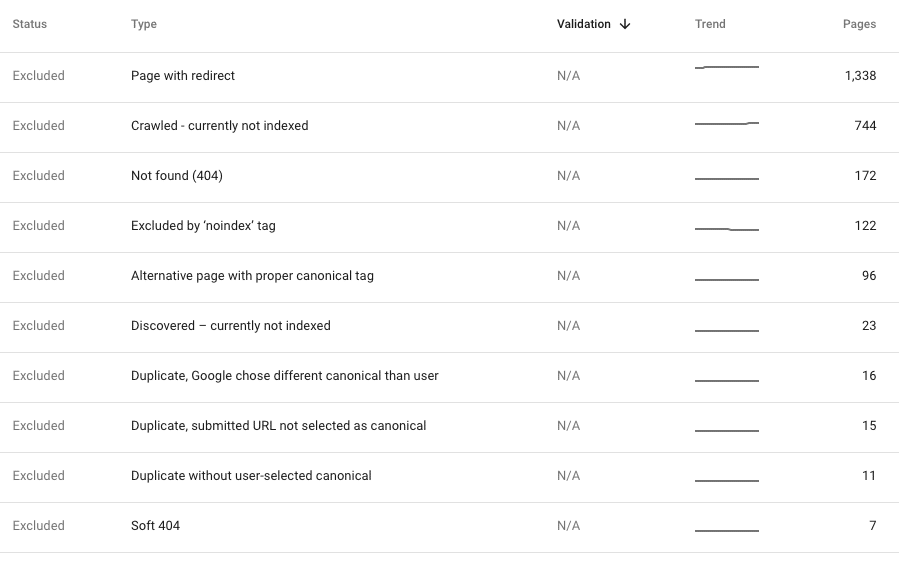

Błędy wewnętrzne 404

Za każdym razem, gdy wykryjemy wewnętrzne błędy 404 w strukturze działającej witryny, czyli w naszym aktualnym indeksowaniu, ich poprawienie powinno być naszym priorytetem. Takie błędy oznaczają, że nasza witryna zawiera linki do stron, które już nie istnieją, co jest niepożądane zarówno dla użytkowników, jak i botów. Jednak w większości przypadków indeksowanie jest czyste, ale GSC ujawnia tony 404.

Ogólnie sugeruje to jeden z problemów wymienionych powyżej: błędy w strukturze witryny, błędna mapa witryny XML odwołująca się do nieistniejących stron lub echa nieodpowiedniej migracji z niewłaściwymi przekierowaniami.

Niestety, te błędy są czasami powoli indeksowane przez Google. Jeśli jednak są stosunkowo świeże, powinniśmy zbadać sytuację, aby zobaczyć, dlaczego się pojawiają. Jeśli nowe indeksowanie witryny jest czyste, musimy zdecydować, jak najlepiej naprawić błędy wykryte w GSC. Zwykle optymalnym rozwiązaniem jest przekierowanie odwiedzających do najbliższego tematycznego odpowiednika problematycznej treści.

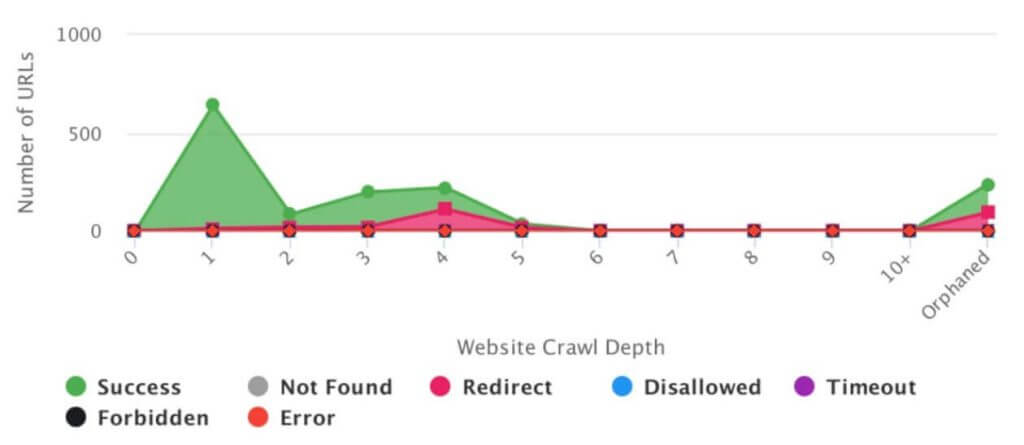

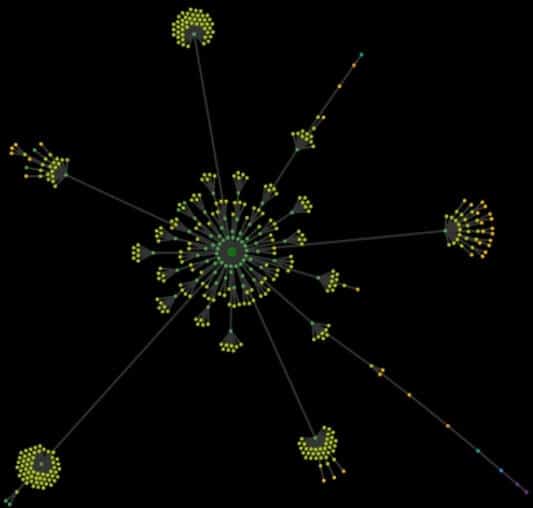

Analiza architektury strony internetowej

Bez możliwości wizualizacji rzeczywistego wyglądu witryny, wszystko, co masz, to tajemniczy Excel z tysiącami adresów URL. Analiza architektury serwisu (tzw. mapa indeksowania) pozwala w mgnieniu oka wykryć błędy i wąskie gardła w strukturze serwisu.

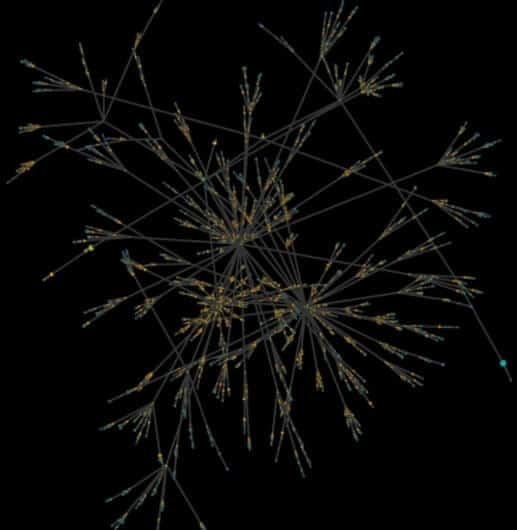

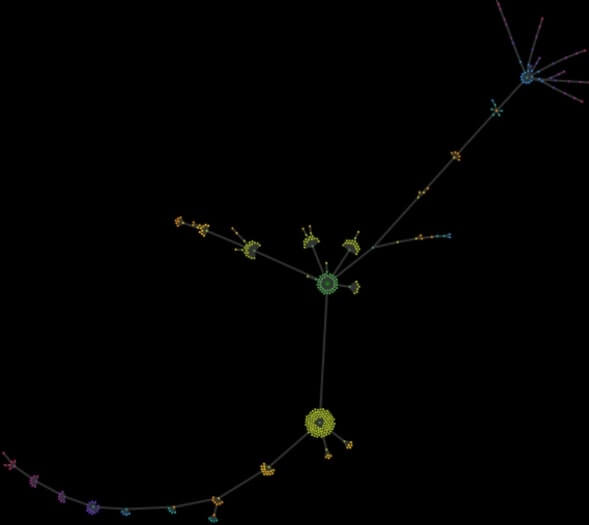

Ogólnie rzecz biorąc, mapa indeksowania to wizualizacja wszystkich adresów URL znalezionych w witrynie, począwszy od strony głównej. Zasada jest prosta: jeśli na pierwszy rzut oka widać idealny porządek i harmonijne „kwiaty” konstrukcji bez wąskich gardeł, to nie jest źle. Im bardziej chaotyczna mapa, tym więcej trzeba zastanowić się nad źródłami problemów.

Poniższy obraz przedstawia mapę indeksowania witryny z treścią. Jeśli chodzi o SEO, jego struktura została odpowiednio zaplanowana od samego początku, a nad całym procesem czuwał specjalista SEO. Na pierwszy rzut oka widać porządek, harmonię, wyraźnie podzielone sekcje i kategorie oraz prawidłowe linkowanie.

Poniższy obrazek przedstawia mapę indeksowania witryny z treścią rozwijanej od lat. Nowe sekcje były dodawane i rozbudowywane bez większego zastanowienia. W pewnym momencie klient poprosił o pomoc, mówiąc, że gubi się na własnej stronie internetowej. Mapa ujawniła totalny chaos, więc struktura musiała zostać przeplanowana od nowa.

Jako dodatek dodaję mapę indeksowania małej strony lokalnej składającej się z kilku stron z ofertami i kilkunastu newsów. Dwa dziwne i zaskakujące „ogony” są produktem rozszerzeń kalendarza, które generowały nowe, zbędne, ale indeksowalne strony z głębokością indeksowania do ponad 50 kliknięć ze strony głównej.

Czynniki na miejscu

Tytuł meta

Wykorzystaj to na swoją korzyść i ulepsz tytuły stron za pomocą słów kluczowych zgodnych z Twoją strategią. Poza tym tytuły stron wpływają na klikalność witryny w wynikach wyszukiwania.

Do najczęstszych błędów związanych z tytułami należą:

- tworzenie tytułów, które nie są oparte na badaniu słów kluczowych i strategii widoczności organicznej,

- brak globalnego schematu tytułu, np.: [komponent unikalny dla strony] – [komponent zwykły/nazwa/marka],

- zduplikowane tytuły w witrynie – często oznacza zduplikowane treści.

Często mówimy, że tytuły powinny mieć około 65-75 znaków (w zależności od szerokości liter). W praktyce jednak ważniejsze jest to, czy zawierają nasze docelowe słowa kluczowe.

Meta opis

Zawartość tagów meta description nie podlega ocenie przez algorytm. Jednak jej odpowiednia konstrukcja poprawia wygląd strony w wynikach wyszukiwania, co przekłada się na lepszą klikalność ogłoszenia.

Najczęstsze błędy związane z metaopisem to:

- brak opisu meta,

- zduplikowane opisy w witrynie (co może wskazywać na zduplikowane treści, takie jak zduplikowane tytuły),

- nadmierna długość opisów.

W idealnym przypadku każda strona mająca na celu generowanie ruchu w wyszukiwarkach powinna mieć swój własny opis meta z wezwaniem do działania. Jednak często okazuje się to nierealne. W wielu przypadkach, takich jak sklepy internetowe, możemy tworzyć unikalne opisy meta dla głównych stron i kategorii, natomiast dla stron produktów – generować opisy meta z szablonu wypełnionego cechami produktu.

Hierarchia nagłówka Hx

Wszyscy wiemy, jak wygląda właściwa hierarchia nagłówków. Jednak podczas audytów SEO rutynowo spotykamy się z nagłówkami H1 z logo.

Wpływ nagłówków Hx na rankingi jest bardzo dyskusyjny, szczególnie w erze HTML5. Jednak korzystanie z nich to nadal standardowa praktyka w świecie SEO.

W związku z tym powinieneś mieć tylko jeden nagłówek H1 na stronę. Powinien zawierać tytuł główny oraz ważne słowa kluczowe.

Liczba innych nagłówków nie ma znaczenia, o ile trzymasz się zasad priorytetu i zagnieżdżania (H3 wewnątrz H2) itp.

Podczas audytów SEO problemy z nagłówkami zwykle spadają na dół listy priorytetów.

JavaScript

W większości przypadków użycie JavaScript jest naturalne i nie koliduje z indeksacją ani renderowaniem, co jest mocną stroną Google. Jednak w niewielkim odsetku przypadków powoduje błędy krytyczne dla widoczności witryny.

Z reguły wystarczy sprawdzić, czy strona nie wymaga dodatkowej akcji (najczęściej kliknięcia) w celu wyświetlenia dodatkowych treści generowanych przez JavaScript. Jeśli tak, prawdopodobnie GoogleBot nie wykona tej czynności.

Prostą i skuteczną metodą sprawdzenia tego jest przeprowadzenie dwóch indeksowań jeden po drugim za pomocą preferowanego narzędzia. Pierwsze indeksowanie powinno analizować tylko HTML, przy wyłączonym silniku Chrome. Drugi powinien zawierać JavaScript z włączonym silnikiem Chrome.

Porównanie dwóch indeksowań ujawni różnice w strukturze, linkowaniu i treści obu wersji. Same różnice nie stanowią problemu – jeśli narzędzie z włączonym renderowaniem może indeksować stronę, Google prawdopodobnie też sobie z tym poradzi.

Ponadto dobrym pomysłem jest przejrzenie głównych stron witryny i obserwowanie w Chrome DevTools, jakie dodatkowe zasoby są ładowane, jeśli w ogóle. Skoncentruj swoją uwagę na kluczowych elementach, takich jak menu, linkowanie wewnętrzne i implementacja treści.

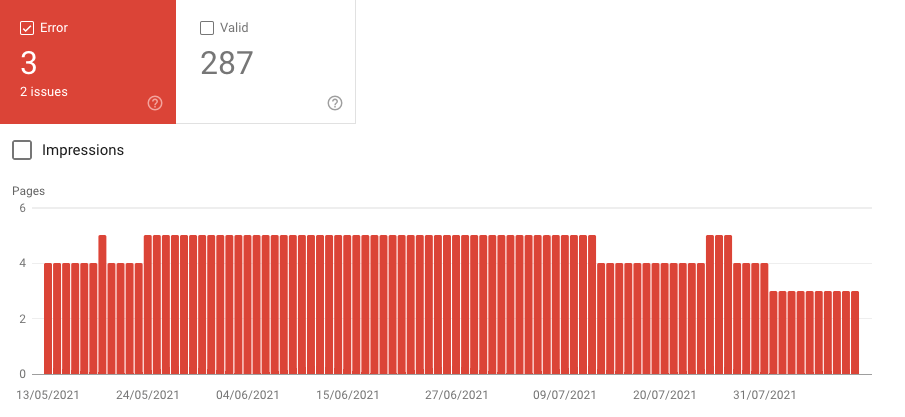

Dane strukturalne / fragmenty rozszerzone

Na większości stron internetowych dane strukturalne są wykorzystywane automatycznie, co jest plusem. Mogą jednak nadal generować problemy omówione poniżej:

- Brak uporządkowanych danych.

- Wykorzystanie formatów zredukowanych do absolutnego minimum (częsty scenariusz). Większość formatów oferuje wymagane i opcjonalne pola treści do wypełnienia. Jednak systemy e-commerce często ograniczają dane zawarte w formacie Produktu do wymaganych informacji.

- Brak otagowania nawigacji w bułce tartej – proste i przydatne narzędzie, które może poprawić wygląd Twojej aukcji w wynikach wyszukiwania.

- Ograniczone wykorzystanie danych strukturalnych. Obecnie Google oferuje galerię 31 obsługiwanych formatów – w tym logo, formaty lokalne, artykuły – do wykorzystania i łączenia na niezliczone sposoby.

Czynniki doświadczenia użytkownika

Szybkość ładowania strony

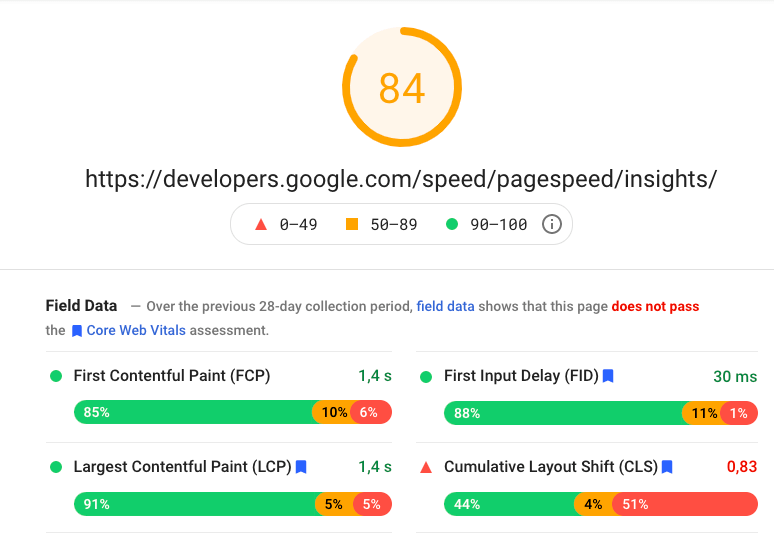

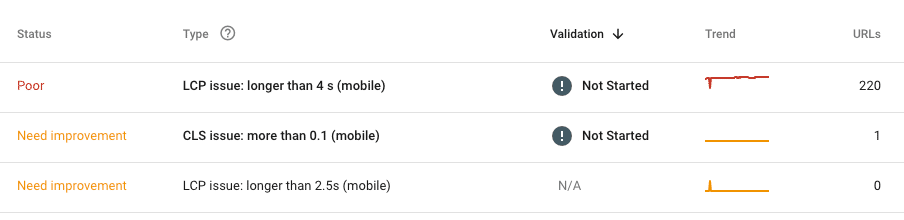

Nie da się ukryć, że szybkość ładowania strony ma znaczenie. Wystarczy powiedzieć, że sam Google nie mówi już o samej prędkości, zastępując ją „Core Web Vitals”, które zostaną włączone do podstawowego algorytmu w 2021 roku.

Obecnie kluczowymi parametrami do rozważenia są:

LCP – Largest Contentful Paint – ocena szybkości ładowania głównej treści,

FID – First Input Delay – oceniający szybkość reakcji witryny na działania użytkownika,

CLS – Cumulative Layout Shift – ocena nagłych zmian w układzie strony po załadowaniu.

Nasz zestaw narzędzi obejmuje głównie produkty Google: dane z GSC i PageSpeed Insights. Oba są niedoskonałe, muszą służyć nam jako główne źródło analizy, którą w razie potrzeby uzupełniamy wybranym narzędziem.

Ważny!

Nigdy nie oceniaj szybkości witryny tylko na podstawie strony głównej. To najgorsza rzecz, którą należy uwzględnić w audycie. Zastosuj podejście, które znasz z innych analiz – podziel witrynę na podobne sekcje, zakładając, że wykryte błędy pojawią się w całej witrynie.

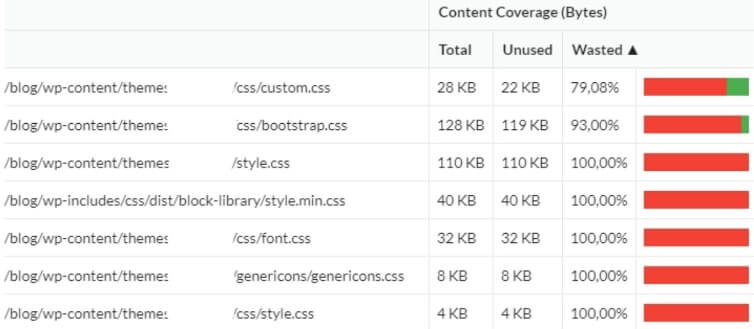

Jaki jest obecnie największy problem z szybkością strony? Na etapie rozwoju priorytetem jest jak najszybsze dostarczenie serwisu, a nie optymalizacja pod kątem szybkości. W związku z tym programiści często uciekają się do gotowych frameworków (bez większego namysłu). W rezultacie właściciel otrzymuje dziesiątki zbędnych plików, których nigdy nie użyje. Z tego powodu uzupełnij audyt SEO o analizę rzeczywistego wykorzystania kodu podczas renderowania. Często okazuje się, że nawet 3/4 kodu pozostaje niewykorzystane

Optymalizacja mobilna

W dzisiejszych czasach rzadko przeprowadzamy audyt witryn, które zupełnie nie odpowiadają. Większość witryn jest w pełni dostosowana do urządzeń mobilnych – co niekoniecznie oznacza stosowanie filozofii mobile-first.

Przez ostatnie 2 lata nie spotkałem strony, która nie odpowiadałaby od początku do końca. Diabeł tkwi jednak w szczegółach (podobnie jak w przypadku błędów związanych z szybkością), więc zwróć uwagę na pojedyncze błędy, takie jak strony, na których GSC lub crawler wykrywają problemy z optymalizacją mobilną. W większości przypadków wynikają one z błędów ludzkich (znowu, podobnie jak błędy związane z szybkością) lub z prób przypadkowego wrzucenia nowych funkcji, nie ujętych w pierwotnym planie, do głównej strony internetowej i CMS.

Analiza treści

W SEO zawartość strony obejmuje wszystkie treści poza obszarem standardowym, czyli stałymi elementami kodu źródłowego.

Powielanie

W większości przypadków treść zduplikowana wewnętrznie jest wynikiem:

Błędy w projekcie strony (funkcje i struktura)

Przykład:

Instytucja finansowa oferowała usługi dla klientów indywidualnych, przedsiębiorców oraz dużych firm. Nawigacja w oparciu o rodzaj oferty, którą klient był zainteresowany. Po dokonaniu wyboru użytkownicy byli przenoszeni do jednej z trzech dedykowanych sekcji:

https://domena.pl/klienci-indywidualni/

https://domena.pl/przedsiębiorca/

https://domena.pl/biznes/

Klient mógł przeglądać dedykowaną ofertę, ale pierwsza część adresu URL pozostała bez zmian. Niestety zawartość wszystkich trzech ofert pokrywała się w 90%. W ten sposób serwis stworzył 3 niemal wymienne struktury o tej samej treści. To jeden z błędów spowodowanych brakiem wsparcia SEO na etapie projektowania. Ze względu na wewnętrzne regulacje klienta problem okazał się praktycznie nie do naprawienia. Jedynym rozwiązaniem było uruchomienie nowej strony internetowej rok po audycie.

Błędy ludzkie lub błędy rozwojowe

Przykład:

Klient miał taką samą treść w stopce i menu głównym. Rozwiązanie, które generalnie nie powinno być problemem, sprawiło sporo kłopotów. Witryna liczyła około 20 stron, ale prosty błąd w linkowaniu wewnętrznym spowodował, że stopka mnożyła witrynę do nieskończoności. Każdy link w stopce generował dodatkowy składnik w adresie URL stopki. W efekcie klient otrzymał adresy takie jak:

https://domena.pl/historia/historia/historia/kontakt/zasady/historia/kontakt/kontakt/

Rodzaj strony internetowej

Przykład:

Niestety, wewnętrzne (i zewnętrzne) powielanie treści jest rutyną w witrynach handlu elektronicznego. Aby to sobie uświadomić, wyobraź sobie sklep oferujący podobne produkty w wielu wariantach. Na przykład smartfony w pięciu kolorach lub ubrania w kilku rozmiarach.

Nie chcemy blokować indeksacji ani używać rel=canonical dla różnych wariantów, aby nadal uzyskiwać ruch z długiego ogona. Jednak to pozostawia nam zduplikowane treści lub prawie duplikaty.

W idealnym przypadku powinniśmy rozważyć napisanie unikalnych opisów dla każdego produktu. Jednak tam, gdzie mamy wiele SKU i dużą rotację produktów, jedynym rozwiązaniem jest automatyczne generowanie różniących się opisów produktów na podstawie unikalnych cech produktów i ich kombinacji.

Wiele wersji URL i implementacja SSL

Przez lata analiza problemów z duplikacją wewnętrzną polegała na sprawdzaniu przekierowań strony głównej do wersji z(out)www i(out https. W dzisiejszych czasach to rzadki problem. Poza tym Google nauczyło się radzić sobie z tym bardzo sprawnie.

Najczęstsze błędy związane z SSL:

- W witrynach z zakodowanymi na stałe łączami menu, łącza „http” mogą pozostać w miejscach w witrynie wśród nowego „https”. W rezultacie otrzymujemy nową warstwę przekierowań na stronie.

- Migracja do SSL może nie obejmować wszystkich zasobów. W rezultacie elementy takie jak grafika czy skrypty mogą nadal ładować się z wersji „http”.

Łączenie wewnętrzne

Linki wewnętrzne wpływają na indeksowanie, indeksację i widoczność każdej strony, ponieważ linki dają wewnętrzną moc/autorytet do ich docelowych lokalizacji. Analiza linkowania wewnętrznego to zestaw oddzielnych sprawdzeń dotyczących:

Stałe elementy nawigacyjne: główne menu nawigacyjne, stopka, pasek boczny

Stałe powiązania, w szczególności główne menu nawigacyjne, należy zaplanować razem ze strategią użycia słów kluczowych. Przy tworzeniu linków głównych kluczowa jest prostota – nie przesadzaj, ponieważ czysty kod HTML zawsze działa najlepiej.

Kiedy porównamy naszą strategię z rzeczywistością i ustalimy, że menu główne zawiera wszystkie niezbędne elementy, sprawdźmy stałe, ale zbędne linki wewnętrzne w całej witrynie. Często można je znaleźć w stopce, zwykłym pojemniku na prawie wszystko. Jest to warte wysiłku, ponieważ każde nowe redundantne łącze zakłóca wewnętrzny przepływ energii.

Niektóre linki i strony, takie jak zasady i przepisy lub polityka prywatności, są koniecznością. Jednak inne są jednorazowe. Na przykład, czy jesteś pewien, że każda metoda wysyłki wymaga osobnego linku w stopce, prowadzącego do osobnej strony? Wszystkie zmieszczą się na jednym. Oprócz wymaganych linków, zorganizujmy nasze wewnętrzne linkowanie, aby uniknąć zbędnych linków do stron, które nie będą pozycjonowane dla naszych fraz kluczowych.

Automatyczne linkowanie – sugerowane posty/produkty

Automatyczne linkowanie oznacza linkowanie do sugerowanych postów (na blogach) lub sugerowanych produktów (na stronach e-commerce). Generalnie, jeśli tymi mechanizmami zarządzają gotowe rozwiązania osadzone w CMS (WordPress), wszystko powinno działać sprawnie. Jeśli linki są generowane w czystym HTML, który stanowi część kodu źródłowego, wszystko, czego możemy potrzebować, to niewielka optymalizacja. Niestety, funkcje te często wykorzystują dynamiczne rozwiązania oparte o JavaScript (Case Onely+H&M) lub, co gorsza, rozwiązania firm zewnętrznych zawarte jako skrypty z innych domen.

Indywidualne linki między stronami używane głównie w sekcjach treści

Łączenie kontekstowe między artykułami stanowi podstawę wzrostu widoczności sekcji treści. Jednak często jest to pomijane. W rezultacie jedyne linki kierujące do artykułów to te ze stron kategorii.

Analiza linkowania kontekstowego jest stosunkowo prosta. Wszystko, co musisz zrobić, to połączyć dane z indeksowania o linkach wewnętrznych z informacjami o aktualnym ruchu organicznym (GSC/Analytics). Poza tym możesz dołączyć dane dotyczące zewnętrznych linków przychodzących, aby określić, które artykuły mają największy autorytet. Dodaj dane dotyczące widoczności początkowego słowa kluczowego (Senuto), aby zobaczyć, które obszary wymagają Twojej uwagi i jak je naprawić.

Łączenie zewnętrzne

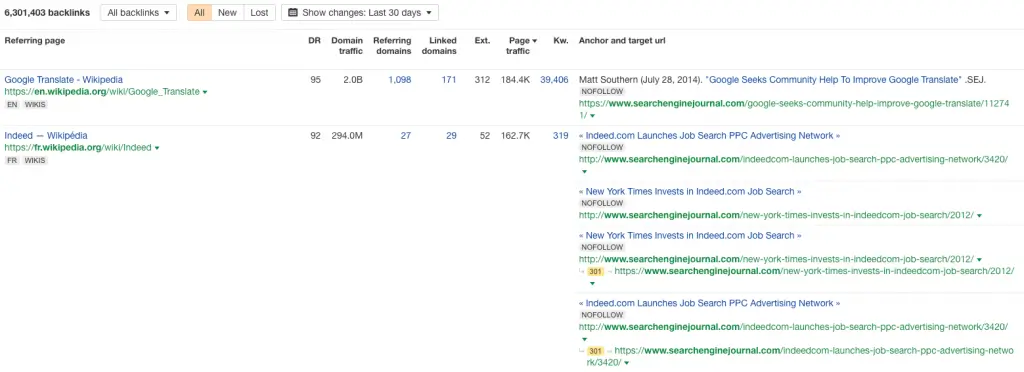

Analiza profilu linków

Na szczęście słabe profile linków są coraz rzadsze, mimo że nadal można spotkać linki utworzone za pomocą GSA, Xrummera lub innego automatycznego generatora.

W zdecydowanej większości przypadków tandetne linki to:

- pamiątka po pozycjonowaniu specjalistów sprzed kilku lat

- sygnał, że witryna została zhakowana, aby przesłać SPAM, do którego następnie haker podłączył;

- produkt skrobaków i generatorów SPAM, które pobierają zawartość strony.

Sprawdzając profil linków, zastosuj uniwersalną złotą zasadę – skup się na anomaliach.

Najłatwiej zauważyć je na wykresach wzrostu linków zwrotnych. Wszystkie nagłe skoki i spadki podlegają analizie.

Dystrybucja głębokiego linkowania

Analiza SEO dystrybucji linków na stronie głównej i innych stronach serwisu służy do oceny jakości tzw. głębokiego linkowania, a tym samym wskazania sekcji lub stron o najwyższym autorytecie zewnętrznym. To mówi nam, czy nasza dystrybucja linków jest równomierna i które strony mogą być ważnymi węzłami w strukturze i służyć jako dystrybutory mocy dla linkowania wewnętrznego.

Linki wychodzące

Często zaniedbywaną sprawą jest analiza linków wychodzących serwisu. Kiedy przeglądasz witrynę opartą na treści lub treści generowanej przez użytkowników, z pewnością zawiera ona kilkadziesiąt linków do zewnętrznych domen. Z biegiem lat wiele z nich wygasa, przechodzi z rąk do rąk lub trafia na szkodliwe strony internetowe. Powtarzaj analizę linków wychodzących – za pomocą robota indeksującego lub narzędzia zewnętrznego – przynajmniej raz w roku.

Uszkodzone i utracone linki zwrotne

Uszkodzone linki zwrotne to linki przychodzące, które wskazują na stronę błędu 404 i są ignorowane przez Google. Wraz z rozwojem witryny, uszkodzone linki zwrotne pojawiają się naturalnie – strony zmieniają lokalizację, niektóre są usuwane, a ludzie popełniają błędy podczas łączenia naszych treści. Zepsute backlinki to również standardowa konsekwencja nieudanych migracji, gdzie programiści zapomnieli o przekierowaniach, a strona nie tylko zmieniła swoją strukturę, ale również straciła wszystkie linki poza stroną główną w ciągu jednego dnia.

Wszystkie utracone linki zwrotne należy zgrupować i przekierować na powiązaną tematycznie stronę. W ostateczności możemy przekierować ich do innej lokalizacji w serwisie lub na stronie głównej. To jedyny sposób na odzyskanie autorytetu, jaki zdobyli dla naszej domeny. W tym czasie przejrzyj domeny z linkami – jeśli to możliwe, przekieruj tylko linki wysokiej jakości i niech spam wskazuje na 404.