BERT: a maior atualização do Google em anos

Publicados: 2022-12-01O BERT do Google foi lançado no final de 2019 e impactou quase 10% de todas as pesquisas. Indiscutivelmente uma das maiores atualizações de algoritmo de 2019, aqui está tudo o que os SEOs e proprietários de sites devem saber sobre o modelo avançado de processamento de linguagem natural do Google.

O que é o BERT do Google?

BERT é um algoritmo de aprendizado profundo e abreviação de representações de codificador bidirecional de transformadores. O algoritmo ajudou a encontrar resultados mais relevantes para consultas de pesquisa complicadas.

Qual foi o efeito da atualização do algoritmo BERT na pesquisa do Google?

Isto é o que o Google disse:

“Essas melhorias são orientadas para melhorar a compreensão do idioma, especialmente para consultas de linguagem/conversação mais naturais, pois o BERT pode ajudar a Pesquisa a entender melhor as nuances e o contexto das palavras nas Pesquisas e combinar melhor essas consultas com resultados úteis.

Especialmente para consultas mais longas e coloquiais ou pesquisas em que preposições como "para" e "para" importam muito para o significado, a Pesquisa poderá entender o contexto das palavras em sua consulta. Você pode pesquisar de uma maneira que pareça natural para você.”

Na verdade, de acordo com o Google, a atualização do BERT afetará 1 em cada 10 pesquisas em inglês nos EUA, ou seja, 10% das consultas de pesquisa. Esta é a atualização mais significativa do Google nos últimos 5 anos, pelo menos de acordo com eles:

Estamos fazendo uma melhoria significativa na forma como entendemos as consultas, o que representa o maior avanço nos últimos cinco anos e um dos maiores avanços na história da Pesquisa.

A introdução do BERT causou grandes flutuações de classificação na primeira semana de implantação do novo algoritmo. Os SEOs do Webmaster World têm comentado sobre as flutuações desde o início da semana, observando a maior flutuação de classificação a atingir o mundo do SEO desde o RankBrain.

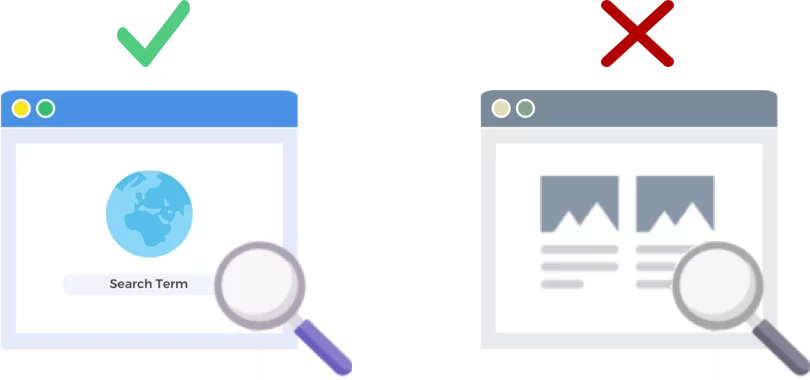

O BERT analisa as consultas de pesquisa, NÃO as páginas da Web

A versão de 24 de outubro de 2019 do algoritmo BERT melhora a forma como o gigante dos mecanismos de pesquisa analisa e entende as consultas de pesquisa (não as páginas da web).

Como funciona o BERT?

O BERT melhora a compreensão do Google sobre as consultas de pesquisa usando um modelo de contexto bidirecional (que é o B em BERT). O Google realmente falou um pouco sobre a mecânica do BERT nessa época do ano passado, quando anunciou o BERT como uma nova técnica para o pré-treinamento de Processamento de Linguagem Natural (NLP).

O que é pré-treino? O pré-treinamento é apenas ensinar uma máquina a fazer tarefas, antes de você realmente dar trabalho a ela. Tradicionalmente, os conjuntos de dados de pré-treinamento são carregados com alguns milhares a algumas centenas de milhares de exemplos rotulados por humanos.

O pré-treinamento já existe há algum tempo, mas o que torna o BERT especial é que ele é contextual (o significado de cada palavra muda com base nas palavras ao seu redor) e bidirecional - o significado de uma palavra é entendido com base nas palavras Antes dela e depois disso.

Pelo blog do Google:

Na frase “ acessei a conta bancária ”, um modelo contextual unidirecional representaria “ banco ” com base em “ acessei a ” mas não em “ conta ”. No entanto, BERT representa “ banco ” usando seu contexto anterior e seguinte — “ Eu acessei a … conta ” — começando do fundo de uma rede neural profunda, tornando-a profundamente bidirecional.

A atualização do Google BERT se baseia em avanços recentes em aprendizado de máquina e reconhecimento de entidade. Basicamente, o BERT ajuda a identificar todas as partes do discurso e o contexto das palavras antes de o Google processar uma pesquisa.

O que significa BERT para resultados de pesquisa?

De acordo com o Google, isso significa que os usuários começarão a ver resultados mais relevantes, resultados que correspondem melhor à intenção de pesquisa do usuário. Essa melhoria de algoritmo abrangerá resultados regulares e resultados de rich snippet.

O Google forneceu alguns exemplos úteis em seu blog anunciando o BERT.

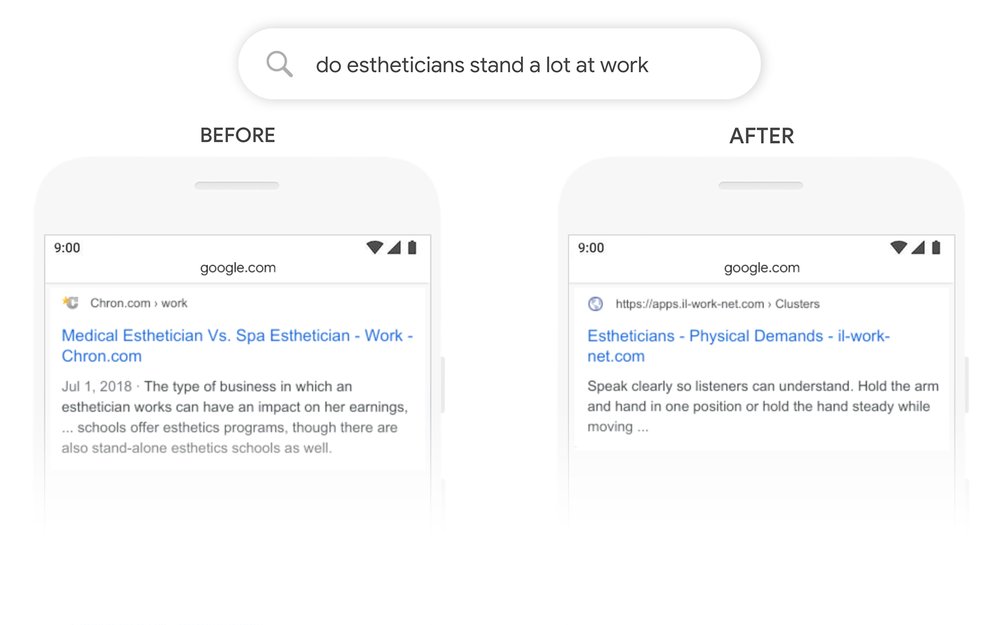

O exemplo da esteticista

Primeiro, temos um usuário tentando entender se os esteticistas passam muito tempo em pé como parte do trabalho.

Você pode ver abaixo que, antes do BERT, o Google leu a consulta “esteticistas ficam muito em pé no trabalho” e produziu um resultado comparando tipos de ambientes de trabalho para esteticistas.

Após o BERT, o Google está trazendo à tona um artigo sobre as exigências físicas de ser esteticista, muito mais de acordo com as informações que o pesquisador estava originalmente tentando trazer à tona.

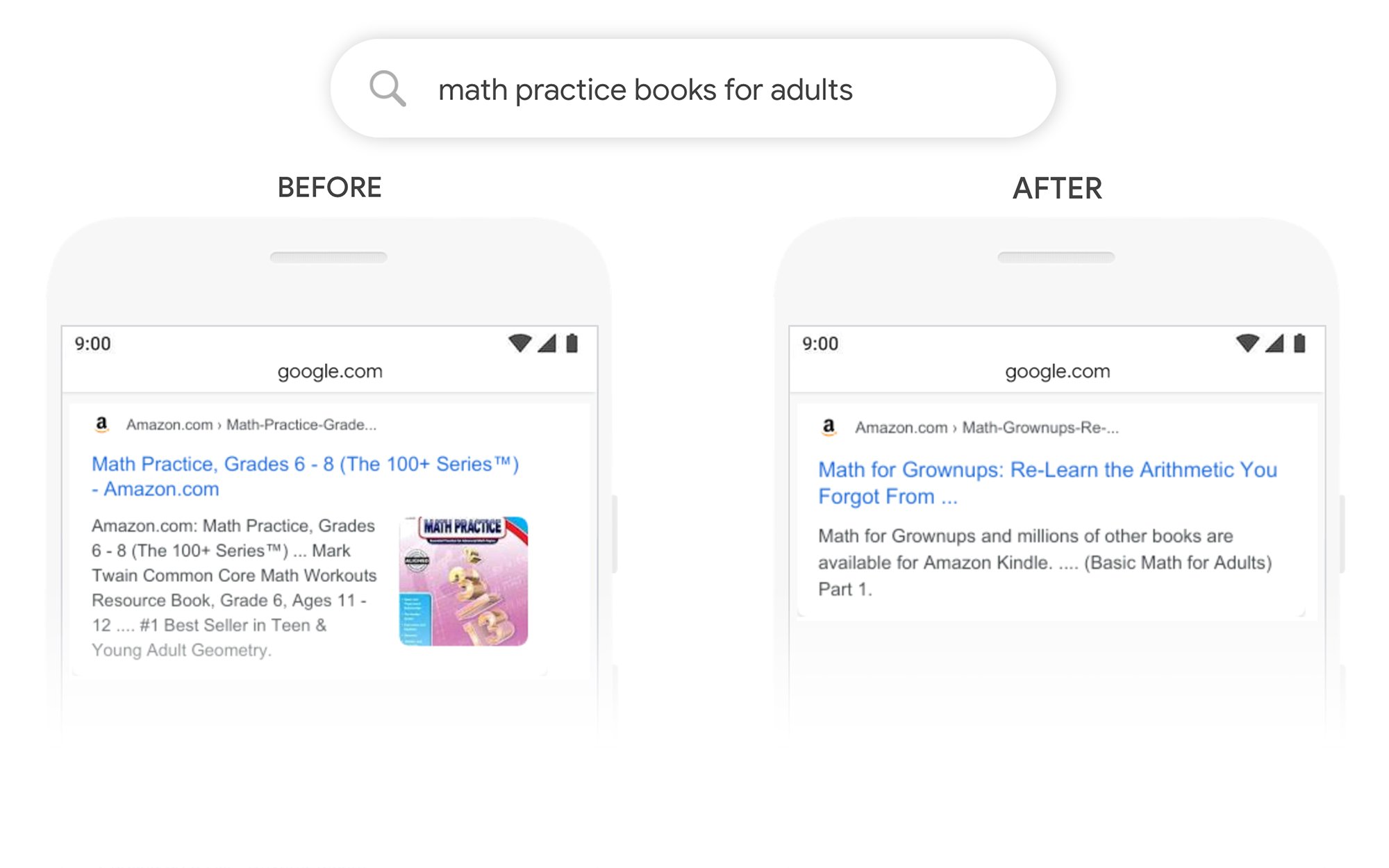

O Exemplo de Livros de Prática de Matemática

Neste exemplo, um usuário está procurando livros de prática de matemática para adultos, mas encontra livros de prática de matemática para crianças.

Depois do BERT, o Google reconhece corretamente o contexto da consulta, contabilizando melhor a segunda parte da busca “para adultos”.

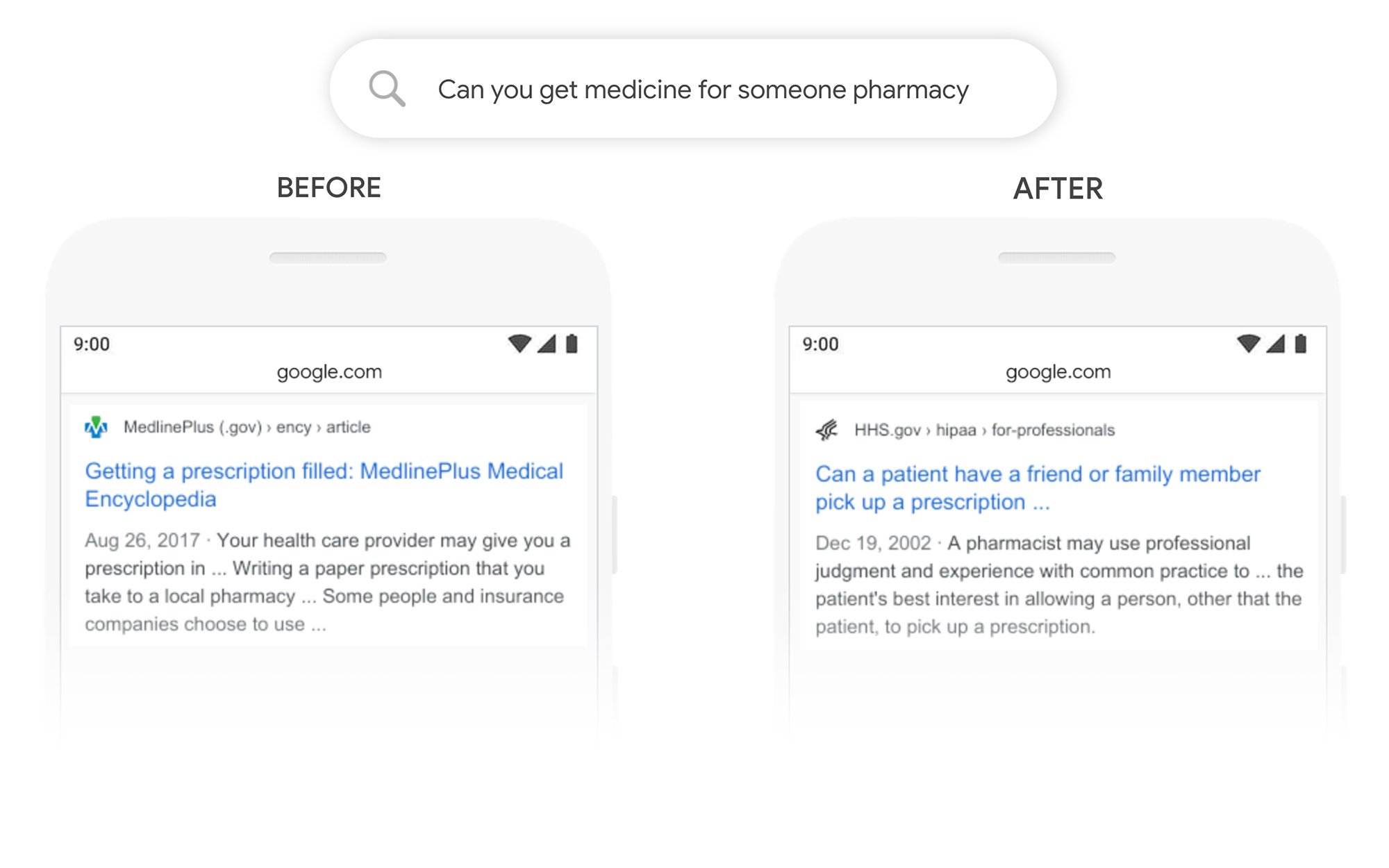

O Exemplo Você Pode Pegar Remédio Para Outra Pessoa

Neste exemplo, a consulta “você pode obter remédios para a farmácia de alguém” retorna um resultado sobre como preencher prescrições em geral, em vez de como preenchê-las para terceiros. Depois do BERT, o Google entende melhor o objetivo do usuário e mostra se um paciente pode ou não pedir a um amigo ou familiar que pegue a receita para ele.

O que posso fazer para me classificar melhor após o BERT?

Para qualquer palavra-chave em que você perde classificação, você deve dar uma olhada na página revisada de resultados de pesquisa para entender melhor como o Google está visualizando a intenção de pesquisa de seus termos-alvo. Em seguida, revise seu conteúdo de acordo para atender melhor aos objetivos do usuário.

Se você perdeu classificações no BERT, é mais provável que seja um problema relacionado a quão bem sua página corresponde à intenção de pesquisa de um usuário (ajuda o usuário a atingir seu objetivo) do que um problema de qualidade do conteúdo.

Dado que o BERT provavelmente dará mais suporte aos esforços de pesquisa por voz ao longo do tempo, também recomendamos que os sites escrevam textos claros e concisos. Não use linguagem de preenchimento, não seja vago, vá direto ao ponto.

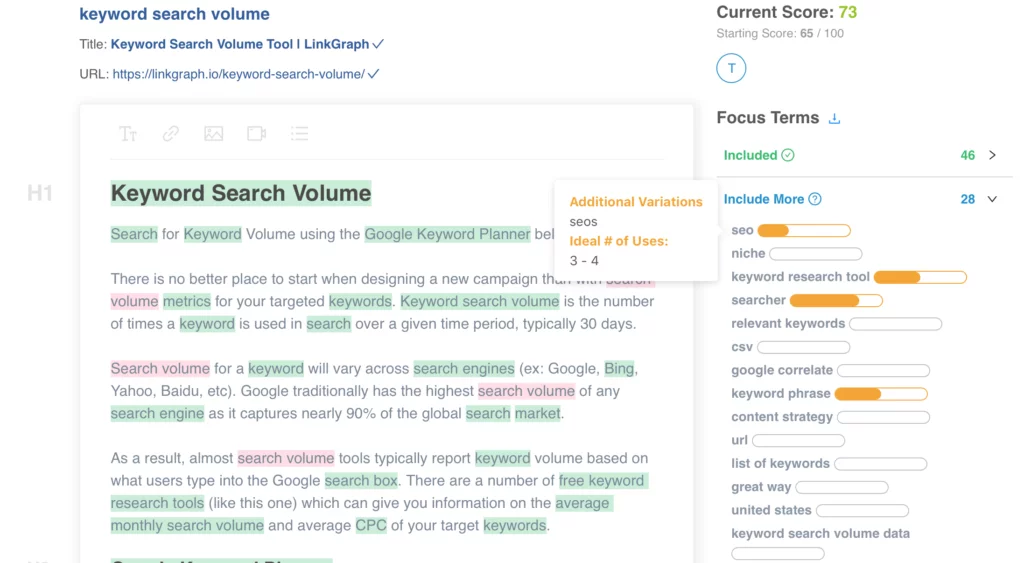

Precisa de ajuda para otimizar seu conteúdo? Confira o otimizador de conteúdo na página do LinkGraph, entre em contato com um membro de nossa equipe em [email protected] ou agende uma reunião para configurar hoje.

Onde posso aprender mais?

Dawn Anderson fez uma ótima apresentação no início deste mês na Pubcon sobre “Google BERT and Family and the Natural Language Understanding Leaderboard Race”, e você pode dar uma olhada na apresentação dela.

Obrigado por ter meu #Pubcon. Aqui está meu baralho <3 <3 https://t.co/aGYDI9pfdY

— Dawn Anderson (@dawnieando) 10 de outubro de 2019

Jeff Dean também fez recentemente uma palestra sobre IA no Google, incluindo BERT, que você pode assistir.