Cansado de ChatGPT raspando seu conteúdo? Proteja seu conteúdo AGORA

Publicados: 2023-07-06

No cenário digital de hoje, proteger seu conteúdo, dados e tráfego da Web é de extrema importância. Com o surgimento do ChatGPT e de outros modelos de linguagem de IA, há uma preocupação crescente sobre essas ferramentas extraírem conteúdo para benefício próprio. Como editor, é essencial entender como esses bots operam e os riscos potenciais que eles representam.

Neste artigo, exploraremos o mundo do scraping ChatGPT e LLM e discutiremos estratégias para enganar e proteger o tráfego do seu site.

Como sei que o ChatGPT está copiando meu conteúdo?

ChatGPT, vários plug-ins e outros modelos de linguagem ganharam status de estrela devido à sua notável capacidade de gerar texto semelhante ao humano. Essas ferramentas assumiram e demitiram funcionários de vários setores, incluindo criação de conteúdo, atendimento ao cliente e até redação criativa. Embora possam ser úteis de várias maneiras, é crucial entender que há casos em que podem ser mal utilizados para extrair conteúdo.

Scraping, no contexto da internet, refere-se ao processo de extração de informações de sites usando bots automatizados. Esses bots visitam diferentes páginas da web, coletam dados e os usam para treinar ainda mais os modelos de IA. Quando o ChatGPT ou outros LLMs extraem conteúdo, eles utilizam essencialmente os dados que coletam para aprimorar seus recursos de geração de texto.

No entanto, o principal problema surge quando esse processo de raspagem infringe os direitos de propriedade intelectual e prejudica os negócios de editores e organizações de mídia. É essencial estar ciente de como seu conteúdo pode ser raspado e suas possíveis consequências no tráfego da web.

Os problemas com a raspagem

Um dos principais problemas com a raspagem é que isso pode levar à perda de controle sobre seu conteúdo. Quando o conteúdo do seu site é copiado, ele pode ser reaproveitado e distribuído em outro lugar sem o seu consentimento. Isso prejudica sua autoridade como criador original e representa desafios para manter a precisão e a integridade de seu conteúdo.

A raspagem pode ter um impacto significativo nas classificações do mecanismo de pesquisa do seu site. Os mecanismos de pesquisa priorizam o conteúdo original e exclusivo e, quando o conteúdo copiado é publicado em outro lugar, pode diluir a visibilidade e a relevância do seu site nos resultados da pesquisa. Isso pode resultar em uma diminuição no tráfego orgânico e perda potencial de receita.

Também pode levar a uma representação distorcida de sua marca ou organização. Quando o conteúdo copiado é usado de forma inadequada ou fora do contexto, ele pode deturpar suas intenções, causando confusão ou até mesmo prejudicando sua reputação. Proteger a identidade da sua marca e garantir que seu conteúdo seja usado de forma responsável e com atribuição adequada é crucial.

Abordar a questão da raspagem requer uma abordagem multifacetada. Como criador de conteúdo ou proprietário de site, você pode tomar várias medidas para evitar que seu conteúdo seja copiado. A implementação de tecnologias como CAPTCHA, bloqueio de IP ou restrições de acesso a conteúdo pode ajudar a impedir que bots automatizados acessem e raspem seu site.

Além disso, monitorar regularmente o tráfego do seu site e analisar o comportamento do usuário pode ajudar a identificar atividades suspeitas que podem indicar raspagem. Mantendo-se vigilante e proativo, você pode tomar as medidas adequadas para mitigar o impacto do scraping em seu conteúdo e negócios.

Também é essencial para desenvolvedores de IA e organizações que utilizam LLMs como ChatGPT priorizar considerações éticas . A implementação de diretrizes e políticas estritas que desencorajam o uso indevido de scraping pode ajudar a evitar a coleta não autorizada de conteúdo. O desenvolvimento responsável da IA visa encontrar um equilíbrio entre inovação e respeito pelos direitos de propriedade intelectual.

Como o ChatGPT extrai seu conteúdo?

Compreender o processo de raspagem empregado pelos bots do ChatGPT é crucial para lidar com esse problema de maneira eficaz. Esses bots usam uma técnica conhecida como rastreamento da web, onde visitam páginas da web e seguem links para coletar informações. Essas informações são então utilizadas para treinar o modelo de IA. A extração de conteúdo pode ser prejudicial para editores e empresas de mídia por vários motivos.

Primeiro, pode levar a uma perda de receita se o conteúdo copiado for republicado sem permissão. Isso pode prejudicar a capacidade dos editores originais de monetizar seu conteúdo e resultar em perdas financeiras. Além disso, pode manchar a reputação dos editores, pois seu conteúdo pode ser deturpado ou descontextualizado quando republicado pelos bots do ChatGPT.

Em segundo lugar, o impacto na experiência do usuário é uma preocupação significativa. Quando os bots do ChatGPT inundam um site com solicitações para extrair conteúdo, ele pode sobrecarregar o servidor e diminuir a velocidade de carregamento para usuários legítimos. Isso pode frustrar os visitantes e desencorajá-los a retornar ao site, levando a uma diminuição do tráfego e possível perda de engajamento e receita de anúncios.

Por fim, o conteúdo copiado também pode afetar as classificações do mecanismo de pesquisa de um site. Os mecanismos de pesquisa priorizam conteúdo exclusivo e original , penalizando sites com conteúdo duplicado ou copiado. Se os bots do ChatGPT extraírem e republicarem o conteúdo dos editores, isso pode afetar negativamente os esforços de otimização do mecanismo de busca (SEO) dos criadores originais. Isso pode resultar em menor visibilidade e tráfego orgânico reduzido, prejudicando a presença online dos editores.

Dados esses riscos, os editores devem proteger proativamente seu conteúdo e tráfego da Web contra raspagem de ChatGPT e LLM. A implementação de medidas como CAPTCHAs , bloqueio de IP e detecção de agente do usuário pode ajudar a identificar e bloquear bots automatizados que tentam extrair conteúdo. Além disso, o monitoramento regular do tráfego da Web e a análise de padrões podem ajudar a detectar quaisquer atividades anormais de raspagem e tomar as medidas apropriadas.

Além disso, os editores podem explorar meios legais para proteger seu conteúdo. As leis de direitos autorais e os direitos de propriedade intelectual podem ser aplicados para impedir a extração e a republicação não autorizadas de seu trabalho. Buscar aconselhamento jurídico e tomar as medidas legais necessárias contra entidades infratoras pode enviar uma mensagem forte e impedir futuras tentativas de scraping.

A colaboração e a comunicação entre editores, empresas de mídia e desenvolvedores de IA também são cruciais para resolver esse problema. Estabelecer parcerias e diálogos abertos pode levar ao desenvolvimento de práticas éticas e diretrizes para treinamento em IA, garantindo que os direitos dos criadores de conteúdo sejam respeitados enquanto avança a tecnologia de IA.

Como se antecipar ao ChatGPT e proteger o tráfego do seu site?

Apresentando o guarda de trânsito: seu escudo contra raspagem não autorizada

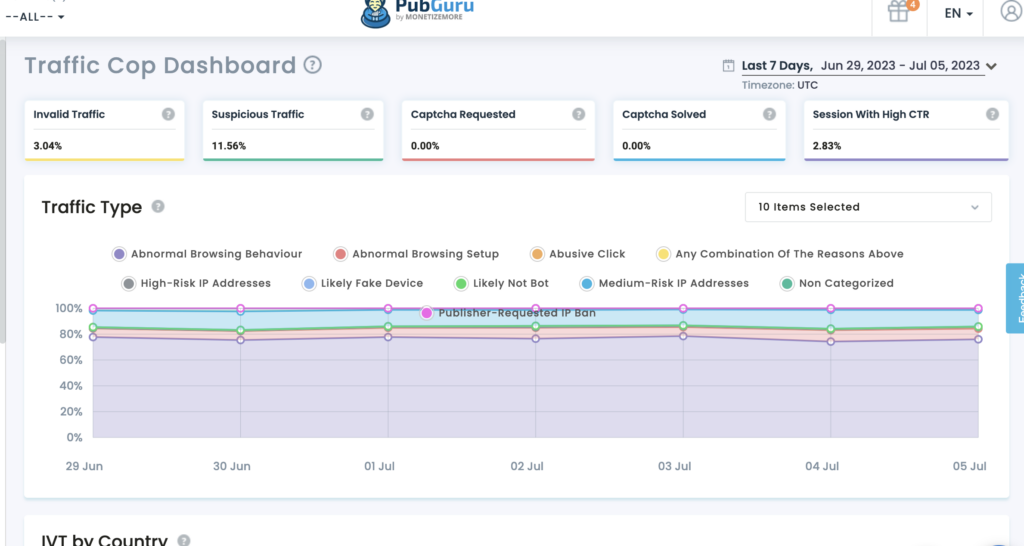

O Traffic Cop da MonetizeMore é uma solução de ponta que atua como um escudo robusto, protegendo efetivamente seus ativos digitais contra bots e acesso não autorizado.

Protegendo seu conteúdo: com o Traffic Cop, seu conteúdo valioso permanece protegido contra raspagem não autorizada. Seus algoritmos avançados de aprendizado de máquina permitem identificar e diferenciar entre tráfego legítimo de usuários e bots maliciosos. O Traffic Cop bloqueia efetivamente as tentativas de raspagem, garantindo que seu conteúdo permaneça exclusivo para seu site.

Protegendo seus dados: os dados são a força vital dos negócios online. O Traffic Cop ajuda você a manter a integridade e a confidencialidade de seus dados. A ferramenta premiada emprega algoritmos sofisticados para identificar e bloquear atividades de coleta de dados, garantindo que seus dados permaneçam protegidos.

Preservando o tráfego da Web: o tráfego da Web é essencial para o sucesso de qualquer empreendimento online. No entanto, a raspagem não autorizada pode esgotar seus recursos, afetar o desempenho do site e prejudicar seus esforços de SEO. O Traffic Cop é sua sentinela vigilante, mantendo bots maliciosos afastados e preservando seu tráfego na web. A implementação de mecanismos avançados de detecção de bots e medidas proativas garante que usuários genuínos tenham acesso ininterrupto ao seu site, aprimorando a experiência do usuário e maximizando seu potencial de conversão.

Por que escolher o guarda de trânsito?

- Proteção abrangente: o Traffic Cop oferece um escudo holístico contra tentativas de raspagem, protegendo seu conteúdo, dados e tráfego da web simultaneamente.

- Detecção avançada de bots: distingue com precisão entre usuários genuínos e bots mal-intencionados, impedindo o acesso não autorizado e as atividades de raspagem.

- Medidas de segurança proativas: essa tecnologia emprega algoritmos de ponta para identificar e bloquear tentativas de raspagem em tempo real, mantendo-se um passo à frente de possíveis ameaças.

- Experiência do usuário aprimorada: preservando o tráfego da Web e mantendo os bots maliciosos afastados, o Traffic Cop garante acesso ininterrupto para usuários genuínos, melhorando sua experiência e aumentando as taxas de conversão.

Fora isso:

Utilize a limitação de taxa: implemente medidas de limitação de taxa para restringir o número de solicitações por endereço IP ou usuário, evitando que os bots sobrecarreguem seu site com tentativas de raspagem.

A limitação de taxa é uma técnica eficaz para evitar ataques de raspagem, limitando o número de solicitações que um usuário ou endereço IP pode fazer em um período de tempo específico. Ao definir limites razoáveis, você pode garantir que usuários genuínos possam acessar seu site enquanto desencoraja bots de tentar copiar seu conteúdo. A implementação da limitação de taxa pode ajudar a manter o desempenho e a disponibilidade do seu site.

Proteja seus feeds RSS: se você fornecer feeds RSS para distribuição, certifique-se de que eles estejam protegidos contra raspagem adicionando mecanismos de autenticação ou implementando chaves de API.

Os feeds RSS podem ser uma fonte valiosa de distribuição de conteúdo, mas também podem ser alvo de bots de extração. Para proteger seus feeds RSS, é crucial implementar mecanismos de autenticação ou chaves de API. Ao exigir autenticação, você pode garantir que apenas usuários ou aplicativos autorizados possam acessar e consumir seus feeds RSS. Além disso, a implementação de chaves de API pode ajudá-lo a rastrear e controlar o acesso aos seus feeds, evitando tentativas de extração não autorizadas.

Ao implementar essas estratégias, você pode reduzir significativamente o risco de raspagem de ChatGPT e LLM, protegendo assim seu conteúdo, dados e tráfego da web.

Faça isso para acompanhar o AI-Apocalypse.

À medida que o ChatGPT e outros LLMs continuam avançando, os editores precisam considerar alguns aspectos importantes para proteger seu conteúdo e tráfego na web:

- Mantenha-se informado: mantenha-se atualizado sobre os últimos avanços em IA e tecnologias de processamento de linguagem natural. Isso o ajudará a entender os possíveis riscos e oportunidades dessas ferramentas.

- Revise seus Termos de Serviço: certifique-se de que seus Termos de Serviço proíbam explicitamente as atividades de scraping e especifique as consequências da violação desses termos.

- Explore as opções legais: se você suspeitar de uma violação de seus direitos de propriedade intelectual devido à raspagem, consulte especialistas jurídicos para explorar os recursos legais disponíveis.

- Envolva-se com a indústria: colabore com associações e organizações da indústria para enfrentar coletivamente os desafios colocados pela sucata e defender melhores medidas de proteção.

Ao considerar proativamente esses fatores, os editores podem proteger melhor seu conteúdo, dados e tráfego da Web na era do ChatGPT e das tecnologias LLM emergentes.

Além dessas considerações importantes, os editores também devem estar cientes do impacto potencial do ChatGPT e dos LLMs no envolvimento do público. Com o aumento do conteúdo gerado por IA, existe a possibilidade de os leitores se tornarem mais céticos em relação à autenticidade e confiabilidade das informações que consomem. Os editores devem tomar medidas para criar confiança com seu público, rotulando claramente o conteúdo gerado por IA e fornecendo transparência sobre a fonte da informação.

Outra consideração importante são as possíveis implicações éticas do conteúdo gerado por IA. À medida que os LLMs se tornam mais avançados, é necessário garantir que o conteúdo gerado não perpetue preconceitos ou desinformação. Os editores devem estabelecer diretrizes e revisar processos para garantir que o conteúdo gerado por IA esteja alinhado com seus padrões e valores editoriais.

Além disso, esteja atento ao cenário jurídico em evolução em torno do conteúdo gerado por IA. À medida que essas tecnologias se tornam mais prevalentes, novos regulamentos e estruturas legais podem ser implementados para reger seu uso. Acompanhar esses desenvolvimentos e consultar especialistas jurídicos pode ajudar os editores a navegar pelas complexidades legais do conteúdo gerado por IA.

Conclusão

Proteger seu conteúdo, dados e tráfego da Web contra a raspagem do ChatGPT é crucial para manter a integridade do seu negócio. Ameaça a receita e a experiência do usuário e afeta a visibilidade e a reputação online. Compreendendo o processo de extração, implementando medidas de proteção, explorando opções legais e promovendo a colaboração, os editores podem proteger seu conteúdo e mitigar os riscos associados à extração orientada por IA.

O Traffic Cop da MonetizeMore oferece uma solução abrangente para manter seu conteúdo, dados e tráfego da web seguros. Ao alavancar a detecção avançada de bots e medidas de segurança proativas, o Traffic Cop permite que você se concentre em seu negócio principal enquanto protege seus ativos digitais de forma eficaz.

Adote o Traffic Cop hoje e fique tranquilo sabendo que sua presença online está protegida contra raspagem não autorizada.

Conheça Aleesha Jacob, uma gerente experiente de conteúdo B2B e SEO com mais de 7 anos de experiência na elaboração de conteúdo orientado a dados que alimenta as conversões para empresas SAAS. Tendo trabalhado com empresas de tecnologia de anúncios e clientes como BMW e Heineken, Aleesha traz uma vasta experiência. Com suas habilidades inigualáveis na criação de conteúdo atraente, ela ajuda empresas de todos os tamanhos a gerar mais leads, aumentar a receita e aumentar sua presença online.