A importância de /robots.txt

Publicados: 2020-07-27Última atualização em 27 de julho de 2020

Em um blog anterior, discutimos os benefícios do arquivo sitemap.xml em nosso site. Neste blog, vamos discutir a importância do arquivo /robots.txt em nosso site.

Em um blog anterior, discutimos os benefícios do arquivo sitemap.xml em nosso site. Neste blog, vamos discutir a importância do arquivo /robots.txt em nosso site.

O que é /Robots.Txt?

O /robots.txt é um arquivo de texto localizado no diretório raiz do servidor web do nosso site. É um arquivo importante porque é usado para fornecer instruções sobre o conteúdo da web do nosso site aos robôs da web. Web Robots, Crawlers ou Spiders são programas usados pelos motores de busca para indexar o conteúdo da web de um site. Essas instruções fornecidas são chamadas de Protocolo de Exclusão de Robôs.

O arquivo /robots.txt é um arquivo público que pode ser acessado digitando uma URL como http://wwwmysite.com/robots.txt. Qualquer pessoa pode ver o conteúdo do arquivo e os locais que você não deseja que os robôs da Web acessem. Isso significa que o arquivo /robots.txt não deve ser usado para ocultar informações críticas em seu site.

O /robots.txt é a primeira coisa que os robôs dos motores de busca procuram quando visitam um site... Click To TweetSintaxe e conteúdo do arquivo Robot.txt

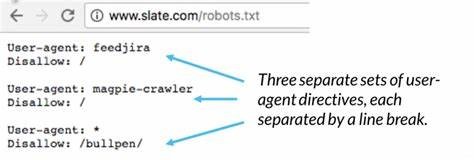

As instruções fornecidas no arquivo /robots.txt incluem a localização do mapa do site do nosso site, qual diretório queremos e não queremos que os robôs da web acessem e quais páginas queremos e não queremos que o robô da web acesse. Uma instrução de sintaxe simples do arquivo /robots.txt é:

Agente de usuário: *

Não permitir: /

A linha “User-agent: *” significa que as instruções no arquivo se aplicam a todos os robôs. O “Disallow: /” diz ao robô para não rastrear nenhuma página no site.

Outras instruções padrão no /robots.txt podem ser:

- Permitir acesso total ao conteúdo do site, mas bloquear uma pasta ou página:

Agente de usuário: *

Não permitir: /pasta/

Não permitir: /page.html

- Permitir acesso total ao conteúdo do site, mas bloquear um arquivo:

Agente de usuário: *

Não permitir: /file-name.pdf

- Permita acesso total ao conteúdo do site, mas bloqueie o rastreamento de um robô da Web específico:

Agente de usuário: *

Não permitir:

Agente do usuário: Googlebot

Não permitir: /

Para obter uma lista de alguns dos robôs da Web, visite https://www.robotstxt.org/db.html

Precisamos separar a linha “Disallow” para cada prefixo de URL que queremos excluir. Globing e expressão regular não são suportados nas linhas User-agent ou Disallow. O '*' no campo User-agent é um valor especial que significa "qualquer robô".

Correto:

Agente de usuário: *

Não permitir: /file-name.pdf

Não permitir: /pasta1/

Não permitir: /pasta2/

Erro:

Agente de usuário: *

Não permitir: /file-name.pdf

Não permitir: /pasta1/ /pasta2/

Não permitir: /folder3/*

Por que o Robots.txt é importante?

Devemos saber a importância do /robots.txt porque o uso indevido do arquivo pode prejudicar a classificação de um site . É o primeiro arquivo que o robô do mecanismo de pesquisa procura ao visitar um site.

O arquivo /robots.txt tem instruções que controlam como os robôs do mecanismo de pesquisa veem e interagem com as páginas do site. Esse arquivo, assim como os bots com os quais interage, são elementos fundamentais de como funciona um mecanismo de busca.

O /robots.txt é a primeira coisa que os robôs do mecanismo de pesquisa procuram ao visitar um site, pois desejam saber se ele tem permissão para acessar o conteúdo do site e quais pastas, páginas e arquivos podem rastrear.

Algumas das razões para ter um arquivo /robots.txt em nosso site podem incluir:

- Temos conteúdo que queremos bloquear dos mecanismos de pesquisa.

- Existem links pagos ou anúncios que precisam de instruções especiais para diferentes robôs da web.

- Queremos limitar o acesso ao nosso site de robôs respeitáveis.

- Estamos desenvolvendo um site ao vivo, mas você não deseja que os mecanismos de pesquisa o indexem ainda.

- Algumas ou todas as opções acima são verdadeiras, mas não temos acesso total ao nosso servidor web e como ele está configurado.

Outros métodos podem controlar os motivos acima, no entanto, o arquivo /robots.txt é um local central certo e direto para cuidar deles. Se não tivermos um arquivo /robots.txt em nosso site, os robôs do mecanismo de pesquisa terão acesso total ao nosso site.

Qual é o significado das palavras-chave da instrução?

“User-agent:” -> Especifique quais instruções aplicar a um robô específico. Uma declaração como “User-agent: *” significa que as diretivas se aplicam a todos os robôs. Uma declaração como "User-agent: Googlebot" significa que as instruções se aplicam apenas ao Googlebot.

“Disallow:” -> Diga aos robôs da web quais pastas eles não devem olhar. Isso significa que, se, por exemplo, você não quiser que os mecanismos de pesquisa indexem as imagens em seu site, você pode colocar essas imagens em uma pasta e excluí-las como “Disallow: /images/”.

“Permitir:” -> Diga a um robô que não há problema em ver um arquivo em uma pasta que foi “Não permitido” por outras instruções. Por exemplo:

Agente de usuário: *

Não permitir: /imagens/

Permitir: /images/myphoto.jpg

“Sitemap:” -> Diga a um robô a localização do arquivo do sitemap do site. Por exemplo:

Agente de usuário: *

Mapa do site: https://www.mysite.com/sitemap.xml

Não permitir: /imagens/

Permitir: /images/myphoto.jpg

Robôs Meta tag, é importante?

Discutimos a importância e o uso do arquivo /robots.txt em nosso site, mas há outra maneira de controlar a visita de robôs da web em nossos sites. Esta outra forma é através de uma metatag Robots.

<meta name=”ROBOTS” content=”NOINDEX, FOLLOW”>

Como qualquer tag <meta>, ela deve ser colocada na seção <head> da página HTML. Além disso, é melhor colocá-lo em todas as páginas do seu site porque um robô pode encontrar um link direto para qualquer página do seu site.

Como qualquer tag <meta>, ela deve ser colocada na seção <head> da página HTML. Além disso, é melhor colocá-lo em todas as páginas do seu site porque um robô pode encontrar um link direto para qualquer página do seu site.

O atributo “name” deve ser “ROBOTS”.

Os valores válidos para o atributo "content" são: "INDEX", "NOINDEX", "FOLLOW", "NOFOLLOW". Vários valores separados por vírgulas são permitidos, mas obviamente, apenas algumas combinações fazem sentido. Se não houver robots <meta> tag, o padrão é “INDEX, FOLLOW”, então não há necessidade de soletrar isso. Outros usos possíveis da tag robots <meta> são:

<meta name=”ROBÔS” content=”INDEX, NOFOLLOW”>

<meta name=”ROBÔS” content=”NOINDEX, NOFOLLOW”>

O uso da metatag está mais relacionado a páginas específicas que não queremos que os robôs da web rastreiem. Não é comumente usado, e é mais preciso e direto para controlar a visita robôs da web por meio do arquivo /robots.txt.

Conclusão

Vimos a importância do /robots.txt em nosso site, sua sintaxe e o que podemos fazer com ele nos benefícios do nosso site. Vimos, também, o uso da metatag robots e suas limitações.

No entanto, se o usarmos, precisamos ter certeza de que está sendo usado corretamente. Um arquivo /robots.txt incorreto pode impedir que os robôs da web indexem as páginas do nosso site ou, mais criticamente, precisamos garantir que não estamos bloqueando as páginas que os mecanismos de pesquisa precisam classificar.

—–

Escrito por Arturo S.