Alto risco, alta recompensa: como as marcas podem usar a IA de forma ética

Publicados: 2023-07-18A IA generativa já mudou o mundo, mas nem tudo que reluz é ouro. Embora o interesse do consumidor em produtos como o ChatGPT seja alto, há uma preocupação crescente entre especialistas e consumidores sobre os perigos da IA para a sociedade. Preocupações com perda de emprego, segurança de dados, desinformação e discriminação são algumas das principais áreas que causam alarme.

A IA é o medo que mais cresce nos EUA, 26% acima de apenas um trimestre atrás.

A IA sem dúvida mudará a maneira como trabalhamos, mas as empresas precisam estar cientes dos problemas que a acompanham. Neste blog, exploraremos as preocupações dos consumidores em relação à segurança do trabalho e dos dados, como as marcas podem aliviar as preocupações e proteger a si mesmas e aos consumidores de riscos potenciais.

1. Protegendo a IA generativa

O conteúdo generativo de IA, como o ChatGPT e o criador de imagens DALL-E, está rapidamente se tornando parte da vida diária, com mais da metade dos consumidores vendo conteúdo gerado por IA pelo menos uma vez por semana. Como essas ferramentas exigem grandes quantidades de dados para aprender e gerar respostas, informações confidenciais podem se infiltrar na mistura.

Com muitas partes móveis, as plataformas generativas de IA permitem que os usuários contribuam com código de várias maneiras, na esperança de melhorar os processos e o desempenho. A desvantagem é que, com muitas contribuições, as vulnerabilidades geralmente passam despercebidas e as informações pessoais podem ser expostas. Essa situação exata foi o que aconteceu com o ChatGPT no início de maio de 2023.

Com mais da metade dos consumidores dizendo que violações de dados os levariam a boicotar uma marca, a privacidade dos dados precisa ser priorizada. Enquanto estão sendo tomadas medidas para redigir leis sobre IA, as marcas precisam auto-impor regras de transparência e diretrizes de uso e torná-las conhecidas do público.

2 em cada 3 consumidores querem que as empresas que criam ferramentas de IA sejam transparentes sobre como estão sendo desenvolvidas.

Fazer isso pode criar confiança na marca, uma moeda especialmente cobiçada no momento. Além da qualidade, a segurança dos dados é o fator mais importante quando se trata de marcas de confiança. Com a fidelidade à marca cada vez mais frágil, as marcas precisam garantir aos consumidores que seus dados estão em boas mãos.

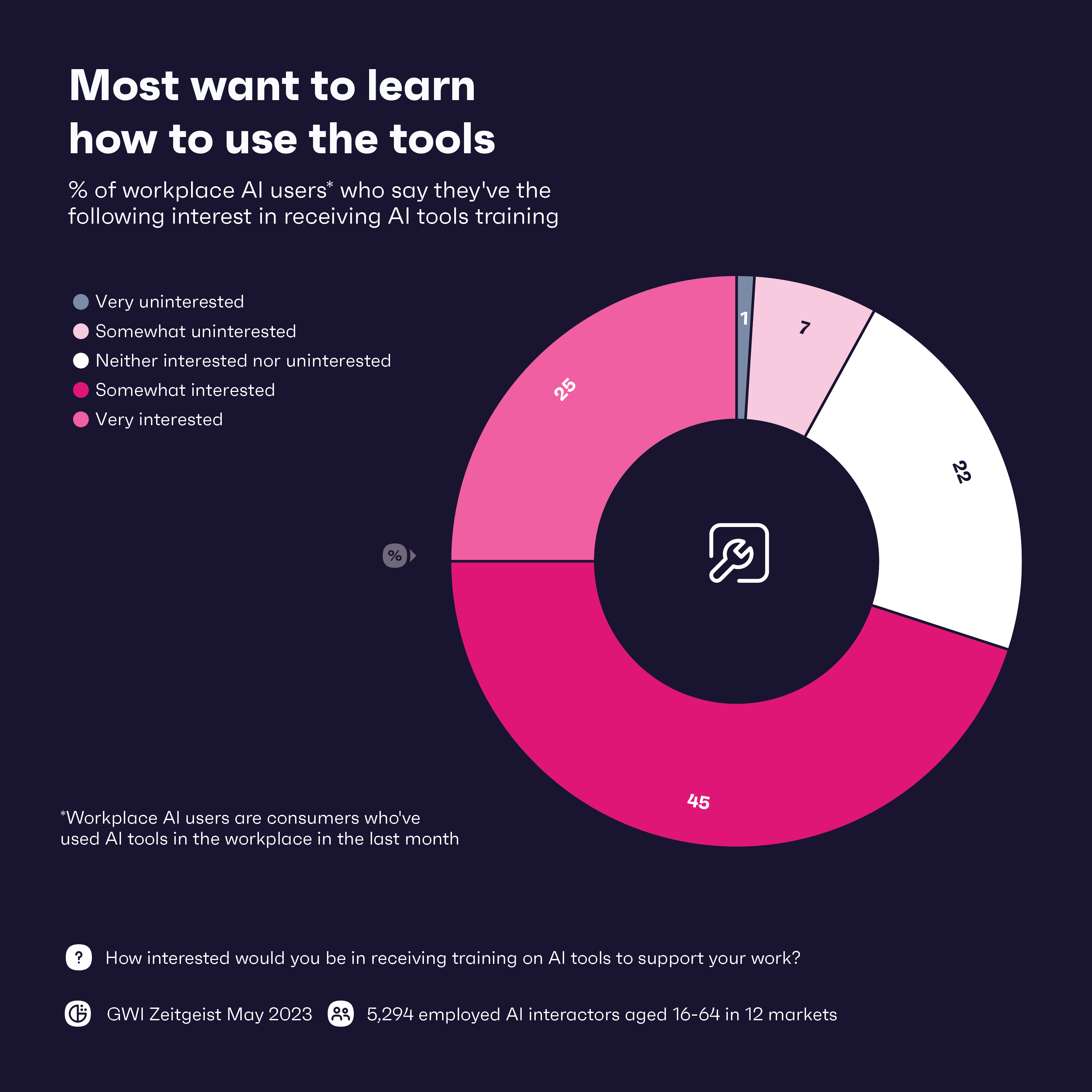

Então, qual é uma das melhores maneiras de proteger os dados na era da IA? A primeira linha de defesa é treinar a equipe em ferramentas de IA, com 71% dos trabalhadores dizendo que estariam interessados em treinamento. Combinar isso com o treinamento de proteção de dados é igualmente importante. A educação é realmente fundamental aqui – armar os trabalhadores com o conhecimento necessário para garantir que a privacidade dos dados esteja em primeiro plano será um longo caminho.

2. Mantendo a realidade em um mundo de notícias falsas

O Facebook levou 4,5 anos para atingir 100 milhões de usuários. Em comparação, o ChatGPT levou pouco mais de dois meses para atingir esse marco.

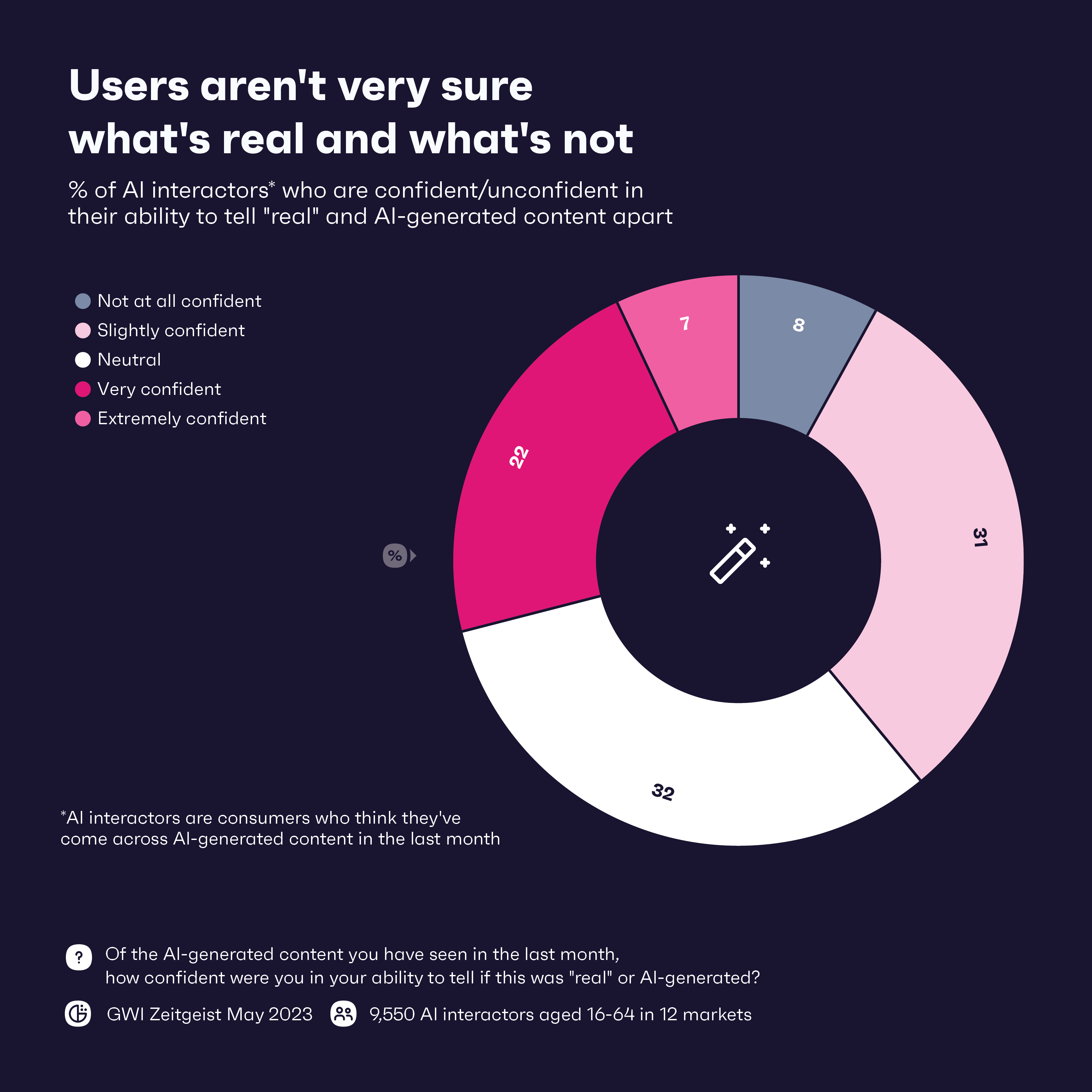

Por mais impressionante que seja a ascensão da IA generativa, ela tem sido um ímã para a criação de notícias falsas na forma de áudios e vídeos, conhecidas como deepfakes. A tecnologia já foi usada para espalhar desinformação em todo o mundo. Apenas 29% dos consumidores estão confiantes em sua capacidade de diferenciar o conteúdo gerado por IA do conteúdo “real”, o que provavelmente piorará à medida que os deepfakes se tornarem mais sofisticados.

Quase dois terços dos usuários do ChatGPT dizem que interagem com a ferramenta como se fossem uma pessoa real, o que mostra como a ferramenta pode ser potencialmente persuasiva.

Mas os consumidores previram isso; 64% dizem estar preocupados com o uso de ferramentas de IA para fins antiéticos. Com essa preocupação e pouca confiança na detecção de deepfakes, são as marcas que podem fazer a diferença na proteção dos consumidores dessa última onda de notícias falsas e na educação sobre como identificar esse conteúdo.

As marcas podem começar implementando a verificação da fonte e realizando a devida diligência em qualquer informação que desejam compartilhar ou promover. Da mesma forma, eles podem fazer parceria ou usar processos internos de verificação de fatos em quaisquer notícias que receberem. Para a maioria das marcas, essas medidas provavelmente já estarão em vigor, já que notícias falsas e desinformação são comuns há anos.

Mas, à medida que os deepfakes ficam mais inteligentes, as marcas precisam ficar por dentro disso. Para vencê-los, as marcas podem precisar recorrer à IA mais uma vez na forma de ferramentas de detecção baseadas em IA que podem identificar e sinalizar o conteúdo gerado por IA. Essas ferramentas se tornarão uma necessidade na era da IA, mas podem não ser suficientes, pois os malfeitores geralmente estão um passo à frente. Mas uma combinação de ferramentas de detecção e supervisão humana para interpretar corretamente o contexto e a credibilidade pode impedir o pior.

A transparência também é fundamental. Informar aos consumidores que você está fazendo algo para lidar com notícias falsas geradas por IA pode ganhar pontos de confiança com eles e ajudar a definir padrões do setor que podem ajudar todos a se manterem atualizados contra deepfakes.

3. Combater preconceitos inerentes

Ninguém quer um pesadelo de relações públicas, mas essa é uma possibilidade real se as marcas não estiverem checando duas vezes as informações que obtêm de suas ferramentas de IA. Lembre-se de que as ferramentas de IA aprendem com dados extraídos da Internet – dados repletos de preconceitos, erros e discriminação humanos.

Para evitar isso, as marcas devem usar conjuntos de dados diversos e representativos para treinar modelos de IA. Embora eliminar completamente o viés e a discriminação seja quase impossível, o uso de uma ampla variedade de conjuntos de dados pode ajudar a eliminar alguns deles. Mais consumidores estão preocupados com a forma como as ferramentas de IA estão sendo desenvolvidas do que não, e alguma transparência sobre o assunto pode fazer com que eles confiem um pouco mais nessas ferramentas.

Embora todas as marcas devam se preocupar com o uso de dados imparciais, certos setores precisam ser mais cuidadosos do que outros. As marcas bancárias e de saúde, em particular, precisam estar hiperconscientes de como estão usando a IA, pois esses setores têm um histórico de discriminação sistêmica. De acordo com nossos dados, o comportamento que causa danos a comunidades específicas é a principal razão pela qual os consumidores boicotam uma marca, e dentro dos terabytes de dados usados para treinar ferramentas de IA estão dados potencialmente prejudiciais.

Além de uma análise detalhada dos conjuntos de dados usados, as marcas também precisam de pessoas, de preferência com treinamento diversificado, de equidade e inclusão (DE&I), para supervisionar todo o processo. De acordo com nosso conjunto de dados GWI USA Plus, DE&I é importante para 70% dos americanos e é mais provável que eles comprem de marcas que compartilham seus valores.

4. Encontrar o equilíbrio certo com a automação no local de trabalho

Vamos abordar o elefante na sala. A IA será amiga ou inimiga dos trabalhadores? Não há dúvida de que isso mudará o trabalho como o conhecemos, mas quão grande será o impacto da IA no local de trabalho depende de para quem você pergunta.

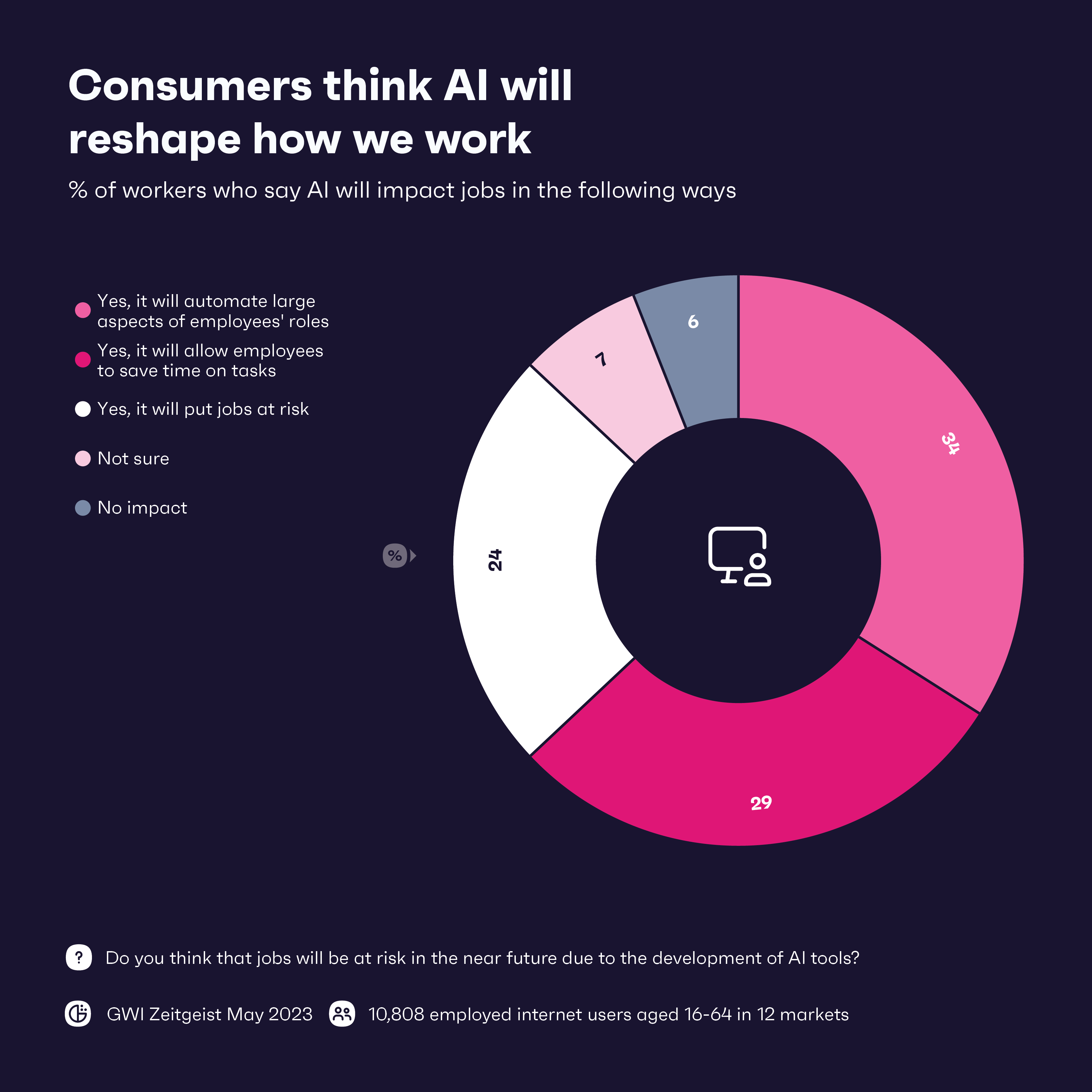

O que sabemos é que a grande maioria dos trabalhadores espera que a IA tenha algum tipo de impacto em seu trabalho. A automação de grandes aspectos das funções dos funcionários é esperada, especialmente nas indústrias de tecnologia e manufatura/logística. No geral, os trabalhadores parecem entusiasmados com a IA, com 8 dos 12 setores dizendo que a automação terá um impacto positivo.

Por outro lado, quase 25% dos trabalhadores veem a IA como uma ameaça aos empregos, e aqueles que trabalham nas indústrias de viagens e saúde e beleza estão particularmente nervosos. A IA generativa parece estar melhorando exponencialmente a cada mês, então a questão é: se a IA pode cuidar de tarefas mundanas agora, o que vem a seguir?

Mesmo que a IA ocupe cerca de 80 milhões de empregos em todo o mundo, os trabalhadores podem encontrar maneiras de usar a IA de forma eficaz para aprimorar suas próprias habilidades, mesmo em setores vulneráveis. O atendimento ao cliente deve passar por grandes atualizações com IA, mas isso não pode acontecer sem humanos. A IA generativa pode lidar com a maioria das consultas, mas os humanos precisam estar presentes para lidar com informações confidenciais e fornecer um toque empático. Os humanos também podem trabalhar com IA para fornecer soluções e recomendações mais personalizadas, o que é especialmente importante nas indústrias de viagens e beleza.

A IA que automatiza algumas tarefas pode liberar os trabalhadores para contribuir de outras maneiras. Eles podem dedicar mais tempo ao pensamento estratégico e à criação de soluções inovadoras, possivelmente resultando em novos produtos e serviços. Será diferente para cada empresa e setor, mas aqueles que conseguirem encontrar o equilíbrio certo entre IA e trabalhadores humanos devem prosperar na era da IA.

O prompt final: o que você precisa saber

A IA pode ser poderosa, mas as marcas precisam estar cientes dos riscos. Eles precisarão proteger os dados do consumidor e estar atentos às notícias falsas. A transparência será fundamental. Os consumidores estão nervosos com o futuro da IA, e as marcas que mostram a eles que estão se comportando de forma ética e responsável irão percorrer um longo caminho.

A tecnologia é empolgante e provavelmente terá um impacto positivo no local de trabalho em geral. Mas as marcas devem proceder com cautela e tentar encontrar o equilíbrio certo entre tecnologia e capital humano. Os funcionários precisarão de treinamento extensivo sobre ética, segurança e aplicação correta, e isso aumentará suas habilidades. Ao integrar ferramentas de IA para trabalhar ao lado das pessoas, em vez de substituí-las completamente, as marcas podem encontrar um equilíbrio que as preparará para o futuro aprimorado pela IA.