BERT: Cea mai mare actualizare Google din ultimii ani

Publicat: 2022-12-01BERT de la Google a intrat în funcțiune la sfârșitul anului 2019 și a afectat aproape 10% din toate căutările. Probabil una dintre cele mai mari actualizări de algoritm din 2019, iată tot ce ar trebui să știe SEO și proprietarii de site-uri despre modelul avansat de procesare a limbajului natural de la Google.

Ce este BERT de la Google?

BERT este un algoritm de învățare profundă și prescurtare pentru Reprezentările codificatorului bidirecțional de la Transformers. Algoritmul a ajutat la evidențierea rezultatelor mai relevante pentru interogări de căutare complicate.

Care a fost efectul actualizării algoritmului BERT asupra căutării Google?

Iată ce a spus Google:

„Aceste îmbunătățiri sunt orientate spre îmbunătățirea înțelegerii limbii, în special pentru interogări mai naturale/conversaționale, deoarece BERT este capabil să ajute Căutarea să înțeleagă mai bine nuanța și contextul cuvintelor din Căutări și să potrivească mai bine acele interogări cu rezultate utile.

În special pentru interogări mai lungi, mai conversaționale, sau căutări în care prepoziții precum „pentru” și „pentru” contează foarte mult pentru semnificație, Căutarea va putea înțelege contextul cuvintelor din interogarea dvs. Puteți căuta într-un mod care vi se pare natural.”

De fapt, potrivit Google, actualizarea BERT va afecta 1 din 10 căutări în limba engleză în SUA, adică 10% dintre interogările de căutare. Aceasta este cea mai semnificativă actualizare a Google din ultimii 5 ani, cel puțin conform acestora:

Facem o îmbunătățire semnificativă a modului în care înțelegem interogările, reprezentând cel mai mare salt înainte din ultimii cinci ani și unul dintre cele mai mari progrese din istoria Căutării.

Introducerea BERT a provocat fluctuații majore în clasament în prima săptămână de implementare a noului algoritm. SEO de la Webmaster World au comentat fluctuațiile de la începutul săptămânii, observând cea mai mare fluctuație a clasamentului care a lovit lumea SEO de la RankBrain.

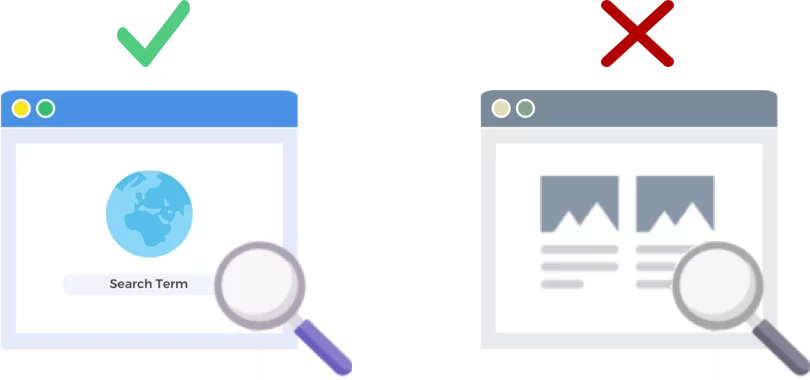

BERT analizează interogările de căutare NU paginile web

Lansarea din 24 octombrie 2019 a algoritmului BERT îmbunătățește modul în care gigantul motorului de căutare analizează și înțelege interogările de căutare (nu paginile web).

Cum funcționează BERT?

BERT îmbunătățește înțelegerea de către Google a interogărilor de căutare folosind un model de context bidirecțional (adică B în BERT). De fapt, Google a vorbit puțin despre mecanica BERT în această perioadă, anul trecut, când a anunțat BERT ca o nouă tehnică pentru pre-instruirea procesării limbajului natural (NLP).

Ce este pre-antrenamentul? Pre-instruirea înseamnă doar să înveți o mașină cum să facă sarcini, înainte de a-i da de fapt de lucru. În mod tradițional, seturile de date pre-instruire sunt încărcate cu câteva mii până la câteva sute de mii de exemple etichetate umane.

Pre-antrenamentul a existat de ceva vreme, dar ceea ce face ca BERT să fie special este că este atât contextual (sensul fiecărui cuvânt se schimbă în funcție de cuvintele din jurul său), cât și bidirecțional – sensul unui cuvânt este înțeles pe baza cuvintelor atât înainte de el, cât și după.

Conform blogului Google:

În propoziția „ Am accesat contul bancar ”, un model contextual unidirecțional ar reprezenta „ bancă ” bazată pe „ Am accesat contul ”, dar nu pe „ contul ”. Cu toate acestea, BERT reprezintă „ bancă ” folosind atât contextul anterior, cât și următorul – „ Am accesat … contul ” – începând chiar de la baza unei rețele neuronale profunde, făcând-o profund bidirecțională.

Actualizarea Google BERT se bazează pe progresele recente în învățarea automată și recunoașterea entităților. Practic, BERT ajută la identificarea tuturor părților de vorbire și a contextului cuvintelor înainte ca Google să proceseze o căutare.

Ce înseamnă BERT pentru rezultatele căutării?

Potrivit Google, înseamnă că utilizatorii vor începe să vadă rezultate mai relevante, rezultate care se potrivesc mai bine cu intenția căutării unui utilizator. Această îmbunătățire a algoritmului va cuprinde rezultate obișnuite și rezultate de fragmente bogate.

Google a oferit câteva exemple utile în articolul său de blog care anunță BERT.

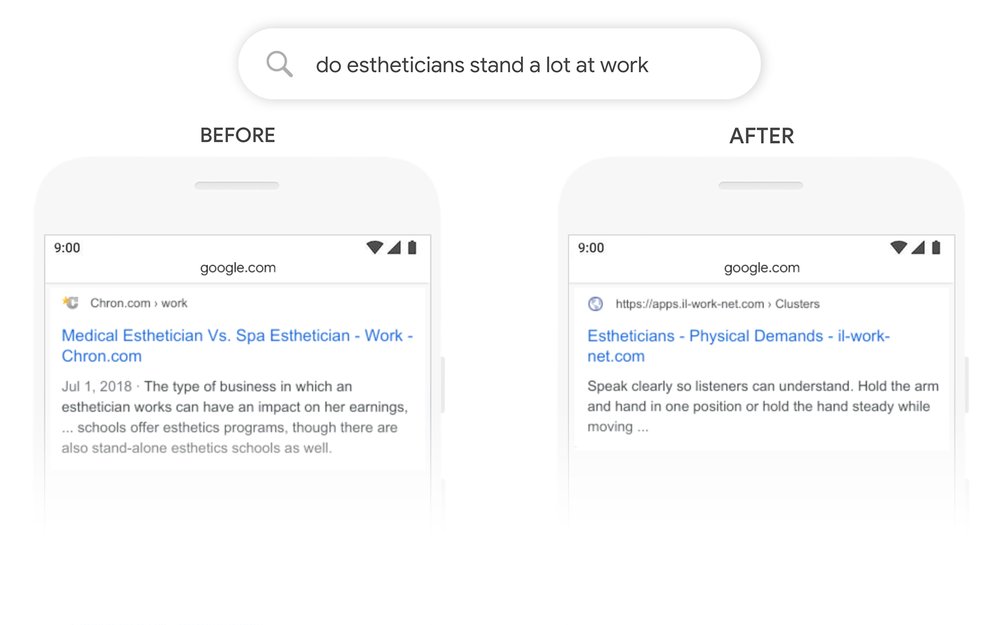

Exemplul de estetician

În primul rând, avem un utilizator care încearcă să înțeleagă dacă esteticienii petrec mult timp pe picioare ca parte a jobului.

Puteți vedea mai jos că înainte ca BERT Google să citească interogarea „Esteticienii stau mult la muncă” și a produs un rezultat care compară tipurile de medii de lucru pentru esteticieni.

După ce BERT Google scoate la suprafață un articol despre cerințele fizice de a fi un estetician, mult mai în concordanță cu informațiile pe care a încercat inițial să le scoată la suprafață.

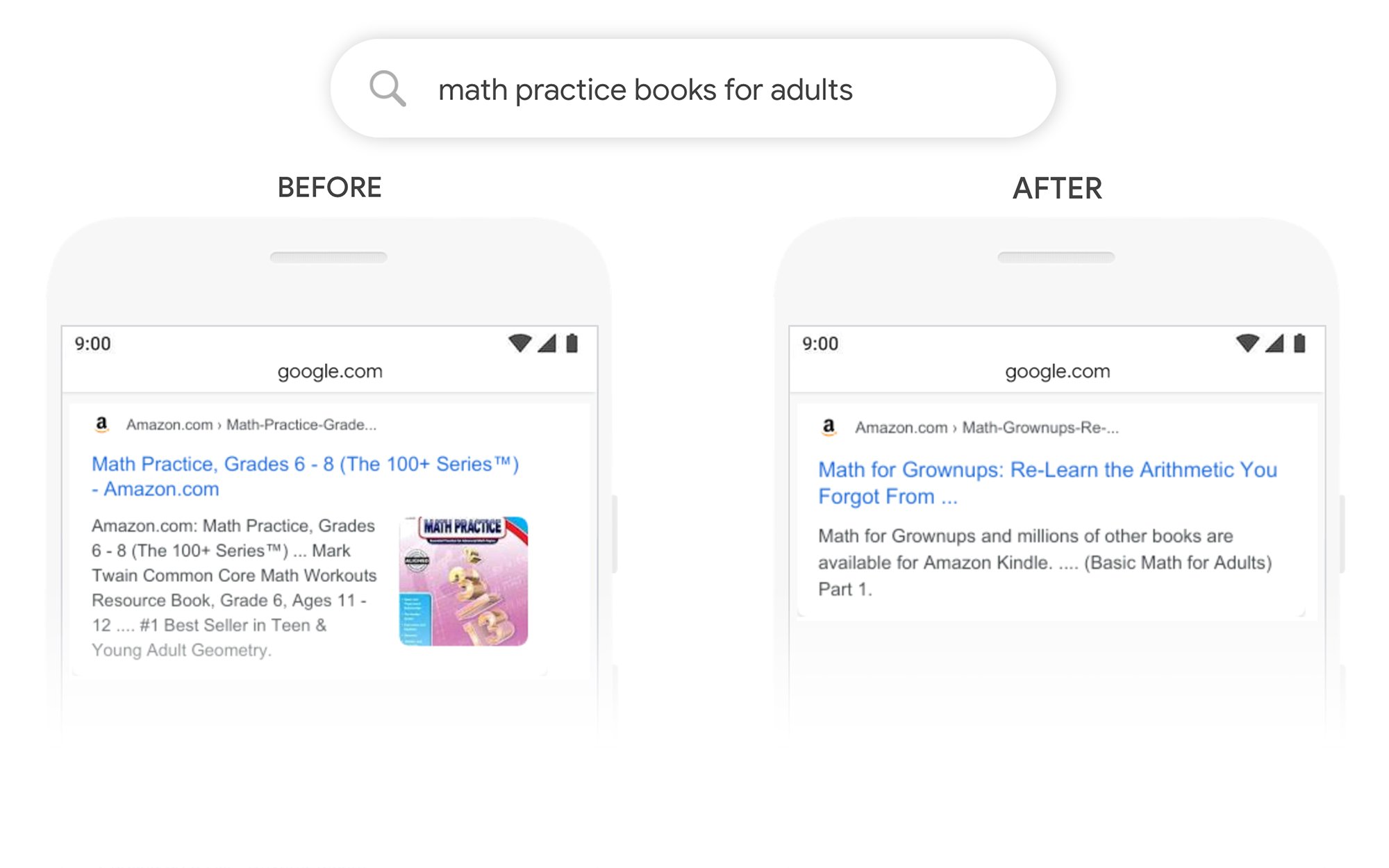

Exemplul cărților de practică de matematică

În acest exemplu, un utilizator caută cărți de practică de matematică pentru adulți, dar apare cărți de practică de matematică pentru copii.

După BERT, Google recunoaște corect contextul interogării, ținând cont mai bine de a doua parte a căutării „pentru adulți”.

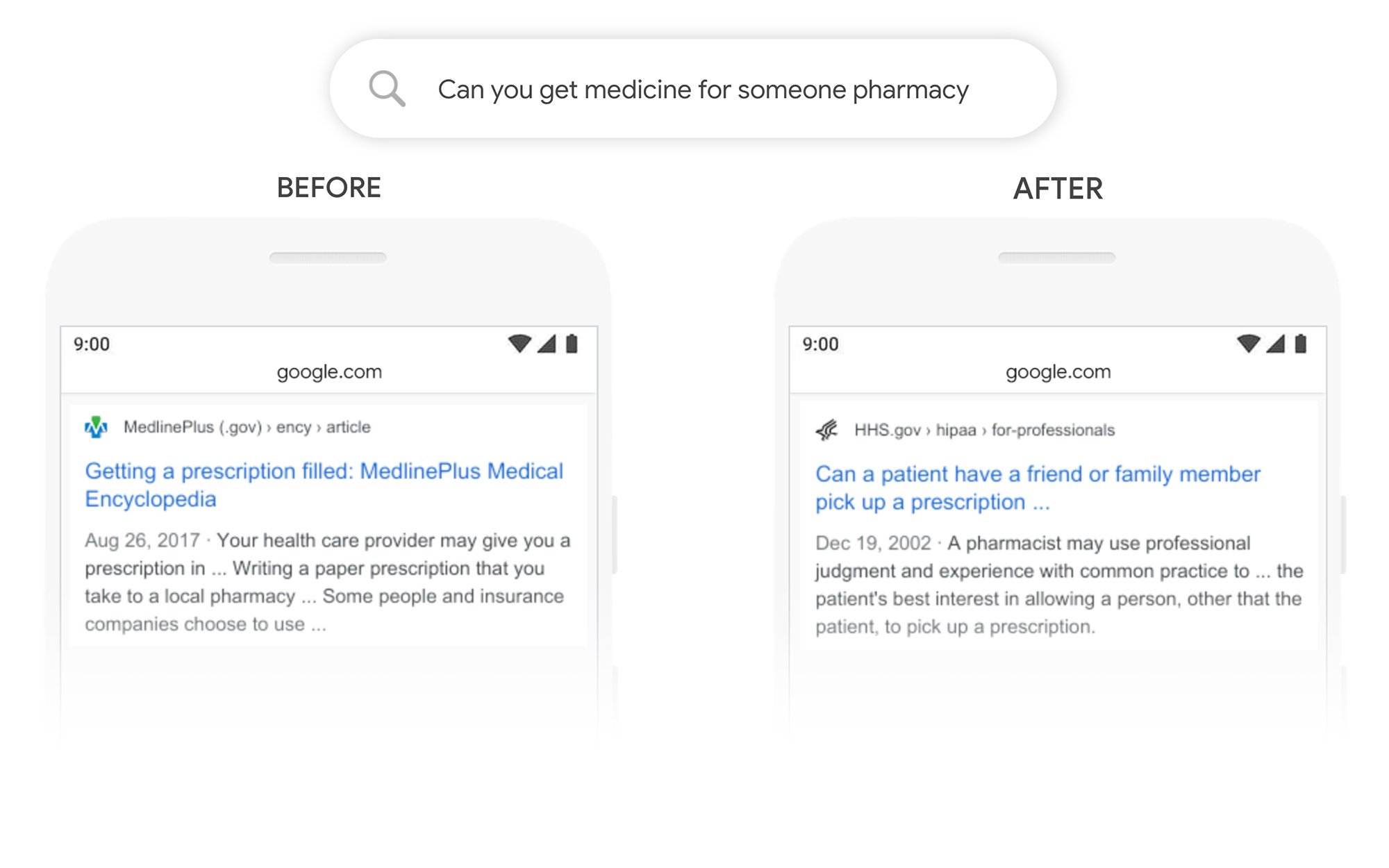

Exemplul Puteți ridica medicamente pentru altcineva

În acest exemplu, interogarea „poți obține medicamente pentru cineva din farmacie” returnează un rezultat despre cum să completezi rețetele în general, mai degrabă decât despre cum să le completezi pentru o terță parte. După BERT, Google înțelege mai bine scopul utilizatorului și scoate la suprafață o bucată despre dacă un pacient poate sau nu ca un prieten sau un membru al familiei să-și ridice rețeta pentru el.

Ce pot face pentru a mă clasa mai bine după BERT?

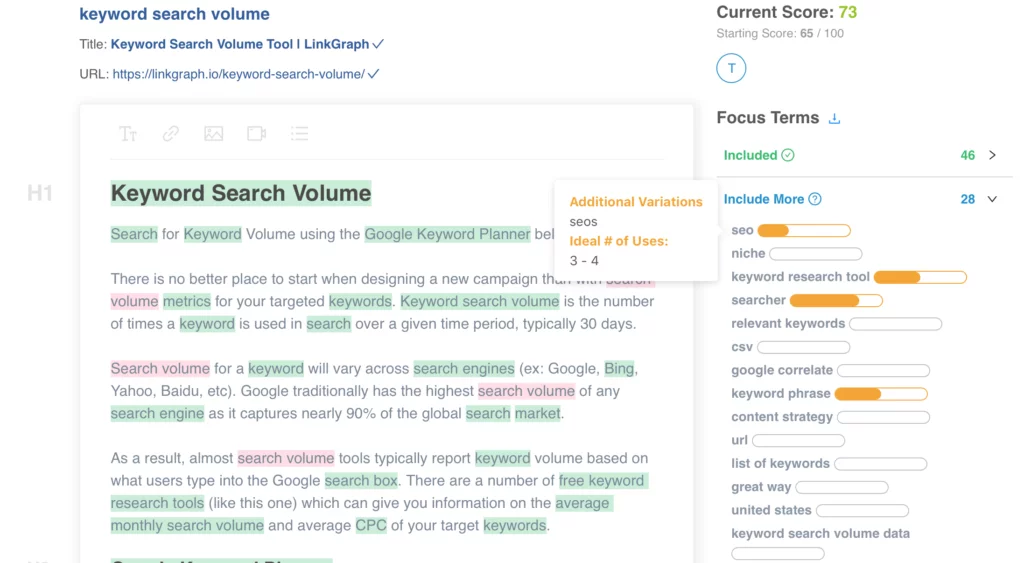

Pentru orice cuvinte cheie în care pierdeți clasamente, ar trebui să aruncați o privire la pagina revizuită cu rezultatele căutării pentru a înțelege mai bine cum vede Google intenția de căutare a termenilor dvs. țintă. Apoi revizuiți-vă conținutul în consecință pentru a îndeplini mai bine obiectivele utilizatorului.

Dacă ați pierdut clasamentele conform BERT, este mai probabil să fie o problemă legată de cât de bine pagina dvs. se potrivește intenției de căutare a unui utilizator (ajută utilizatorul să-și atingă obiectivul) decât să fie o problemă de calitate a conținutului.

Având în vedere că BERT este probabil să susțină și mai mult eforturile de căutare vocală în timp, recomandăm, de asemenea, site-urilor web să scrie o copie clară și concisă. Nu folosiți limbajul de umplere, nu fiți vagi, treceți direct la obiect.

Aveți nevoie de ajutor pentru optimizarea conținutului dvs.? Consultați Optimizatorul de conținut pe pagină al LinkGraph, contactați un membru al echipei noastre la [email protected] sau programați o întâlnire pentru a vă configura astăzi.

Unde pot afla mai multe?

Dawn Anderson a făcut o prezentare grozavă la începutul acestei luni la Pubcon despre „Google BERT și familia și cursa de clasament pentru înțelegerea limbajului natural” și puteți arunca o privire la prezentarea ei.

Mulțumesc că ai #Pubcon-ul meu. Aici este pachetul meu <3 <3 https://t.co/aGYDI9pfdY

— Dawn Anderson (@dawnieando) 10 octombrie 2019

De asemenea, Jeff Dean a susținut recent o conferință la AI la Google, inclusiv BERT, pe care o puteți viziona.