V-ați săturat ca ChatGPT să vă răpească conținutul? Protejați-vă conținutul ACUM

Publicat: 2023-07-06

În peisajul digital de astăzi, protejarea conținutului, a datelor și a traficului web este de cea mai mare importanță. Odată cu apariția ChatGPT și a altor modele de limbaj AI, există o preocupare din ce în ce mai mare cu privire la aceste instrumente care elimină conținut pentru propriul beneficiu. În calitate de editor, este esențial să înțelegeți cum funcționează acești roboți și riscurile potențiale pe care le prezintă.

În acest articol, vom explora lumea ChatGPT și LLM scraping și vom discuta strategii pentru a depăși inteligent și a proteja traficul site-ului dvs.

De unde știu că ChatGPT îmi șterge conținutul?

ChatGPT, diverse plugin-uri și alte modele de limbă au câștigat statutul de vedetă datorită capacității lor remarcabile de a genera text asemănător omului. Aceste instrumente au preluat și au concediat angajați din diverse industrii, inclusiv crearea de conținut, serviciul pentru clienți și chiar scrierea creativă. Deși pot fi de ajutor în multe feluri, este esențial să înțelegem că există cazuri în care pot fi utilizate greșit pentru a răzui conținut.

Scraping, în contextul internetului, se referă la procesul de extragere a informațiilor de pe site-uri web folosind roboți automati. Acești roboți vizitează diferite pagini web, colectează date și le folosesc pentru a instrui modele AI în continuare. Când ChatGPT sau alte LLM-uri răzuiesc conținut, ele folosesc în esență datele pe care le adună pentru a-și îmbunătăți capacitățile de generare de text.

Cu toate acestea, principala problemă apare atunci când acest proces de scraping încalcă drepturile de proprietate intelectuală și dăunează afacerilor editorilor și organizațiilor media. Este esențial să fii conștient de modul în care conținutul tău poate fi răzuit și de consecințele sale potențiale asupra traficului tău web.

Problemele cu răzuirea

Una dintre problemele principale legate de scraping este că poate duce la pierderea controlului asupra conținutului dvs. Când conținutul site-ului dvs. este răzuit, acesta poate fi reutilizat și distribuit în altă parte fără consimțământul dvs. Acest lucru vă subminează autoritatea ca creator original și pune provocări în menținerea acurateții și integrității conținutului dvs.

Scrapingul poate avea un impact semnificativ asupra clasamentului site-ului dvs. în motoarele de căutare. Motoarele de căutare acordă prioritate conținutului original și unic, iar atunci când conținutul răzuit este publicat în altă parte, poate dilua vizibilitatea și relevanța site-ului dvs. în rezultatele căutării. Acest lucru poate duce la o scădere a traficului organic și la o potențială pierdere de venituri.

De asemenea, poate duce la o reprezentare distorsionată a mărcii sau organizației dvs. Atunci când conținutul răzuit este utilizat în mod necorespunzător sau în afara contextului, acesta vă poate reprezenta greșit intențiile, ceea ce duce la confuzie sau chiar la deteriorarea reputației dvs. Protejarea identității mărcii dvs. și asigurarea faptului că conținutul dvs. este utilizat în mod responsabil și cu o atribuire adecvată este esențială.

Abordarea problemei răzuirii necesită o abordare cu mai multe fațete. În calitate de creator de conținut sau proprietar de site-uri web, puteți lua mai multe măsuri pentru a vă proteja conținutul de a fi răzuit. Implementarea tehnologiilor cum ar fi CAPTCHA, blocarea IP sau restricțiile de acces la conținut poate ajuta la descurajarea roboților automatizați să acceseze și să răpească site-ul dvs.

În plus, monitorizarea regulată a traficului site-ului dvs. și analizarea comportamentului utilizatorilor pot ajuta la identificarea activităților suspecte care pot indica scraping. Fiind vigilent și proactiv, puteți lua măsurile adecvate pentru a atenua impactul scraping-ului asupra conținutului și afacerii dvs.

De asemenea, este esențial pentru dezvoltatorii și organizațiile AI care utilizează LLM-uri precum ChatGPT să prioritizeze considerentele etice . Implementarea unor linii directoare și politici stricte care descurajează utilizarea abuzivă a scrapingului poate ajuta la prevenirea colectării neautorizate de conținut. Dezvoltarea responsabilă a inteligenței artificiale își propune să atingă un echilibru între inovare și respectarea drepturilor de proprietate intelectuală.

Cum vă răzuiește ChatGPT conținutul?

Înțelegerea procesului de scraping folosit de roboții ChatGPT este crucială pentru a trata eficient această problemă. Acești roboți folosesc o tehnică cunoscută sub numele de accesare cu crawlere pe web, în care vizitează pagini web și urmăresc linkuri pentru a colecta informații. Aceste informații sunt apoi utilizate pentru a antrena modelul AI. Scrapingul conținutului poate fi dăunător editorilor și companiilor media din mai multe motive.

În primul rând, poate duce la o pierdere de venituri dacă conținutul răzuit este republicat fără permisiune. Acest lucru poate submina capacitatea editorilor originali de a-și monetiza conținutul și poate duce la pierderi financiare. În plus, poate păta reputația editorilor, deoarece conținutul acestora poate fi denaturat sau scos din context atunci când este republicat de roboții ChatGPT.

În al doilea rând, impactul asupra experienței utilizatorului este o preocupare semnificativă. Când roboții ChatGPT inundă un site web cu solicitări de a răzui conținut, acesta poate supraîncărca serverul și poate încetini viteza de încărcare pentru utilizatorii legitimi. Acest lucru îi poate frustra pe vizitatori și îi poate descuraja să se întoarcă pe site-ul web, ceea ce duce la o scădere a traficului și la pierderea potențială a angajamentului și a veniturilor publicitare.

În cele din urmă, conținutul răzuit poate afecta, de asemenea, clasamentul unui site în motoarele de căutare. Motoarele de căutare acordă prioritate conținutului unic și original , penalizând site-urile web cu conținut duplicat sau răzuit. Dacă robotii ChatGPT răzuiesc și republică conținutul de la editori, acesta poate avea un impact negativ asupra eforturilor de optimizare pentru motoarele de căutare (SEO) ale creatorilor inițiali. Acest lucru poate duce la o vizibilitate mai scăzută și un trafic organic redus, dăunând prezenței online a editorilor.

Având în vedere aceste riscuri, editorii trebuie să își protejeze în mod proactiv conținutul și traficul web de chatGPT și LLM scraping. Implementarea măsurilor, cum ar fi CAPTCHA-urile , blocarea IP și detectarea agenților de utilizator poate ajuta la identificarea și blocarea roboților automatizați care încearcă să curețe conținut. În plus, monitorizarea regulată a traficului web și analiza modelelor poate ajuta la detectarea oricăror activități anormale de scraping și la luarea măsurilor corespunzătoare.

În plus, editorii pot explora căi legale pentru a-și proteja conținutul. Legile privind drepturile de autor și drepturile de proprietate intelectuală pot fi aplicate pentru a preveni răzuirea și republicarea neautorizată a lucrărilor lor. Căutarea de consiliere juridică și luarea acțiunilor legale necesare împotriva entităților care încalcă drepturile de autor pot transmite un mesaj puternic și pot descuraja viitoarele încercări de scraping.

Colaborarea și comunicarea între editori, companiile media și dezvoltatorii AI sunt, de asemenea, cruciale în abordarea acestei probleme. Stabilirea de parteneriate și dialoguri deschise poate duce la dezvoltarea practicilor etice și a liniilor directoare pentru instruirea AI, asigurându-se că drepturile creatorilor de conținut sunt respectate în timp ce avansează tehnologia AI.

Cum să treceți înaintea ChatGPT și să vă protejați traficul site-ului?

Vă prezentăm Traffic Police: scutul dvs. împotriva răzuirii neautorizate

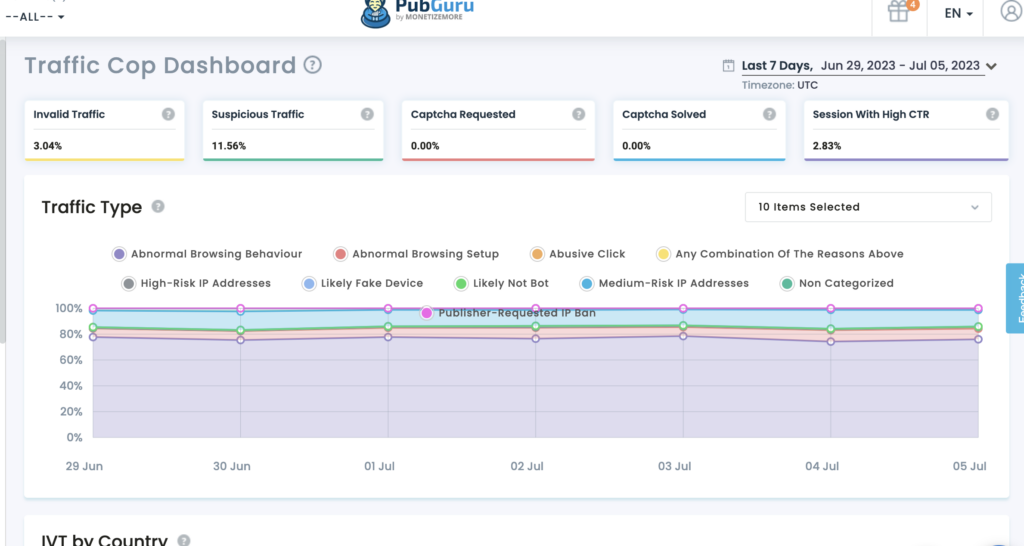

Traffic Cop de la MonetizeMore este o soluție de ultimă oră care acționează ca un scut robust, protejându-vă în mod eficient activele digitale împotriva roboților și accesului neautorizat.

Protejarea conținutului dvs.: cu Traffic Cop, conținutul dvs. valoros rămâne în siguranță împotriva răzuirii neautorizate. Algoritmii săi avansati de învățare automată îi permit să identifice și să diferențieze între traficul legitim al utilizatorilor și roboții rău intenționați. Traffic Cop blochează efectiv încercările de scraping, asigurându-vă că conținutul rămâne exclusiv pentru site-ul dvs.

Securizarea datelor dvs.: Datele sunt forța vitală a afacerilor online. Traffic Cop vă ajută să mențineți integritatea și confidențialitatea datelor dvs. Instrumentul premiat folosește algoritmi sofisticați pentru a identifica și bloca activitățile de colectare a datelor, asigurându-vă că datele dumneavoastră rămân protejate.

Păstrarea traficului web: traficul web este esențial pentru succesul oricărei întreprinderi online. Cu toate acestea, răzuirea neautorizată vă poate epuiza resursele, vă poate afecta performanța site-ului și vă poate submina eforturile SEO. Traffic Cop este sentinelul tău vigilent, ținând la distanță roboții rău intenționați și păstrându-ți traficul web. Implementarea mecanismelor avansate de detectare a botilor și a măsurilor proactive asigură că utilizatorii autentici au acces neîntrerupt la site-ul dvs. web, îmbunătățind experiența utilizatorului și maximizând potențialul dvs. de conversie.

De ce să alegi Traffic Police?

- Protecție cuprinzătoare: Traffic Cop oferă un scut holistic împotriva încercărilor de scraping, protejând simultan conținutul, datele și traficul web.

- Detectare avansată a botului: face distincția cu precizie între utilizatorii autentici și roboții rău intenționați, prevenind accesul neautorizat și activitățile de scraping.

- Măsuri de securitate proactive: Această tehnologie folosește algoritmi de ultimă oră pentru a identifica și bloca încercările de scraping în timp real, rămânând cu un pas înaintea potențialelor amenințări.

- Experiență îmbunătățită a utilizatorului: Păstrând traficul dvs. web și ținând la distanță roboții rău intenționați, Traffic Cop asigură acces neîntrerupt pentru utilizatorii autentici, îmbunătățindu-le experiența și sporind ratele de conversie.

În afară de asta:

Utilizați limitarea ratei: implementați măsuri de limitare a ratei pentru a restricționa numărul de solicitări per adresă IP sau utilizator, împiedicând roboții să vă copleșească site-ul cu încercări de scraping.

Limitarea ratei este o tehnică eficientă pentru a preveni atacurile scraping prin limitarea numărului de solicitări pe care un utilizator sau o adresă IP le poate face într-un interval de timp specific. Prin stabilirea unor limite rezonabile, vă puteți asigura că utilizatorii autentici vă pot accesa site-ul web, în timp ce descurajați roboții să încerce să vă curățeze conținutul. Implementarea limitării ratei poate ajuta la menținerea performanței și a disponibilității site-ului dvs. web.

Protejați-vă fluxurile RSS: dacă furnizați fluxuri RSS pentru sindicare, asigurați-vă că acestea sunt protejate împotriva scraping-ului prin adăugarea de mecanisme de autentificare sau implementarea cheilor API.

Fluxurile RSS pot fi o sursă valoroasă de sindicare a conținutului, dar pot fi vizate și de roboții de scraping. Pentru a vă proteja fluxurile RSS, este esențial să implementați mecanisme de autentificare sau chei API. Solicitând autentificare, vă puteți asigura că numai utilizatorii sau aplicațiile autorizate pot accesa și consuma fluxurile dvs. RSS. În plus, implementarea cheilor API vă poate ajuta să urmăriți și să controlați accesul la fluxurile dvs., prevenind încercările de scraping neautorizate.

Prin implementarea acestor strategii, puteți reduce semnificativ riscul chatGPT și LLM scraping, protejând astfel conținutul, datele și traficul web.

Fă acest lucru pentru a ține pasul cu AI-Apocalypse.

Pe măsură ce ChatGPT și alte LLM-uri continuă să avanseze, editorii trebuie să ia în considerare anumite aspecte cheie pentru a-și proteja conținutul și traficul web:

- Rămâneți informat: țineți-vă la curent cu cele mai recente progrese în AI și tehnologiile de procesare a limbajului natural. Acest lucru vă va ajuta să înțelegeți potențialele riscuri și oportunități ale acestor instrumente.

- Consultați Termenii și condițiile: asigurați-vă că Termenii și condițiile interzic în mod explicit activitățile de scraping și specificați consecințele încălcării acestor termeni.

- Explorați opțiunile legale: dacă suspectați o încălcare a drepturilor de proprietate intelectuală din cauza răzuirii, consultați experții juridici pentru a explora căile de atac disponibile.

- Implicați-vă cu industria: colaborați cu asociațiile și organizațiile din industrie pentru a aborda în mod colectiv provocările generate de scraping și pentru a susține măsuri de protecție mai bune.

Luând în considerare în mod proactiv acești factori, editorii își pot proteja mai bine conținutul, datele și traficul web în era ChatGPT și tehnologiile emergente LLM.

Pe lângă aceste considerente cheie, editorii ar trebui să fie, de asemenea, conștienți de impactul potențial al ChatGPT și LLM-urilor asupra angajamentului publicului lor. Odată cu creșterea conținutului generat de AI, există posibilitatea ca cititorii să devină mai sceptici cu privire la autenticitatea și fiabilitatea informațiilor pe care le consumă. Editorii ar trebui să ia măsuri pentru a construi încrederea cu publicul lor, etichetând în mod clar conținutul generat de IA și oferind transparență cu privire la sursa informațiilor.

Un alt aspect important este potențialele implicații etice ale conținutului generat de AI. Pe măsură ce LLM-urile devin mai avansate, este nevoie să ne asigurăm că conținutul generat nu perpetuează părtiniri sau dezinformare. Editorii ar trebui să stabilească orientări și procese de revizuire pentru a se asigura că conținutul generat de inteligență artificială se aliniază cu standardele și valorile lor editoriale.

Mai mult, fiți atenți la peisajul juridic în evoluție din jurul conținutului generat de AI. Pe măsură ce aceste tehnologii devin din ce în ce mai răspândite, pot fi instituite noi reglementări și cadre legale pentru a reglementa utilizarea lor. Fiind la curent cu aceste evoluții și consultarea experților juridici pot ajuta editorii să navigheze în complexitățile juridice ale conținutului generat de inteligență artificială.

Concluzie

Protejarea conținutului, a datelor și a traficului web împotriva scrapingului ChatGPT este crucială pentru menținerea integrității afacerii dvs. Le amenință veniturile și experiența utilizatorului și le afectează vizibilitatea și reputația online. Înțelegând procesul de scraping, implementând măsuri de protecție, explorând opțiunile legale și încurajând colaborarea, editorii își pot proteja conținutul și pot atenua riscurile asociate cu scraping-ul bazat pe inteligență artificială.

Traffic Cop de la MonetizeMore oferă o soluție cuprinzătoare pentru a vă păstra conținutul, datele și traficul web în siguranță. Utilizând detectarea robotilor avansate și măsurile de securitate proactive, Traffic Cop vă permite să vă concentrați asupra activității dvs. de bază, protejând în același timp activele digitale în mod eficient.

Îmbrățișați Traffic Cop astăzi și bucurați-vă de liniște sufletească știind că prezența dvs. online este protejată de răzuirea neautorizată.

Faceți cunoștință cu Aleesha Jacob, un manager experimentat de conținut B2B și SEO, cu peste 7 ani de experiență în crearea de conținut bazat pe date, care alimentează conversiile pentru afacerile SAAS. După ce a lucrat cu companii de tehnologie publicitară și clienți precum BMW și Heineken, Aleesha aduce o experiență bogată. Cu abilitățile ei de neegalat în crearea de conținut convingător, ea ajută companiile de toate dimensiunile să atragă mai mulți clienți potențiali, să mărească veniturile și să-și dezvolte prezența online.