Ce este bugetul de accesare cu crawlere și cum să îl optimizați

Publicat: 2022-11-25

Un buget de accesare cu crawlere poate părea un concept străin atunci când învățați pentru prima dată despre cum funcționează roboții motoarelor de căutare. Deși nu este cel mai ușor concept SEO, sunt mai puțin complicate decât ar putea părea. Odată ce începeți să înțelegeți ce este un buget de accesare cu crawlere și cum funcționează accesarea cu crawlere în motoarele de căutare, puteți începe să optimizați site-ul dvs. web pentru a optimiza accesul cu crawlere. Acest proces va ajuta site-ul dvs. să atingă cel mai înalt potențial de clasare în rezultatele căutării Google.

Ce este un buget de crawl?

Un buget de accesare cu crawlere este numărul de adrese URL de pe un site web pe care roboții motoarelor de căutare le pot indexa într-o sesiune de indexare. „Bugetul” unei sesiuni de accesare cu crawlere diferă de la un site la altul, în funcție de dimensiunea fiecărui site, de valorile de trafic și de viteza de încărcare a paginii.

Dacă ați ajuns până aici și termenii SEO nu vă sunt familiarizați, utilizați glosarul nostru SEO pentru a vă familiariza mai bine cu definițiile .

Ce factori afectează bugetul de accesare cu crawlere al unui site web?

Google nu dedică același timp sau același număr de accesări cu crawlere fiecărui site de pe internet. Webcrawlerele determină, de asemenea, ce pagini accesează cu crawlere și cât de des, pe baza mai multor factori. Acestea determină cât de des și pentru cât timp trebuie accesat cu crawlere fiecare site pe baza:

Google nu dedică același timp sau același număr de accesări cu crawlere fiecărui site de pe internet. Webcrawlerele determină, de asemenea, ce pagini accesează cu crawlere și cât de des, pe baza mai multor factori. Acestea determină cât de des și pentru cât timp trebuie accesat cu crawlere fiecare site pe baza:

- Popularitate: cu cât un site sau o pagină este vizitată mai mult, cu atât mai des ar trebui să fie analizată pentru actualizări. În plus, paginile mai populare vor acumula mai multe link-uri de intrare mai rapid.

- Dimensiune: site-urile web mari și paginile cu elemente mai intense de date durează mai mult pentru accesarea cu crawlere.

- Sănătate/Probleme: atunci când un webcrawler ajunge într-un punct mort prin link-uri interne, este nevoie de timp pentru ca acesta să găsească un nou punct de plecare sau abandonează accesarea cu crawlere. Erorile 404, redirecționările și timpii de încărcare lenți încetinesc și împiedică crawlerele web.

Cum afectează bugetul dvs. de crawl SEO?

Procesul de indexare webcrawler face posibilă căutarea. Dacă conținutul dvs. nu poate fi găsit, apoi indexat de către webcrawlerele Google, paginile dvs. web și site-ul web nu vor fi descoperite de către cei care caută. Acest lucru ar duce la pierderea site-ului dvs. de mult trafic de căutare.

De ce accesează Google cu crawlere site-urile?

Googlebots parcurg în mod sistematic paginile unui site web pentru a determina despre ce este pagina și site-ul general. Webcrawlerele procesează, clasifică și organizează datele de pe site-ul respectiv, pagină cu pagină, pentru a crea o memorie cache de adrese URL împreună cu conținutul acestora, astfel încât Google să poată determina ce rezultate de căutare ar trebui să apară ca răspuns la o interogare de căutare.

În plus, Google utilizează aceste informații pentru a determina care rezultate de căutare se potrivesc cel mai bine interogării de căutare, pentru a determina unde ar trebui să apară fiecare rezultat al căutării în lista ierarhică de rezultate de căutare.

Ce se întâmplă în timpul unui crawl?

Google alocă o anumită perioadă de timp unui robot Google pentru a procesa un site web. Din cauza acestei limitări, botul probabil nu va accesa cu crawlere un întreg site în timpul unei sesiuni de accesare cu crawlere. În schimb, își va parcurge toate paginile site-ului pe baza fișierului robots.txt și a altor factori (cum ar fi popularitatea unei pagini).

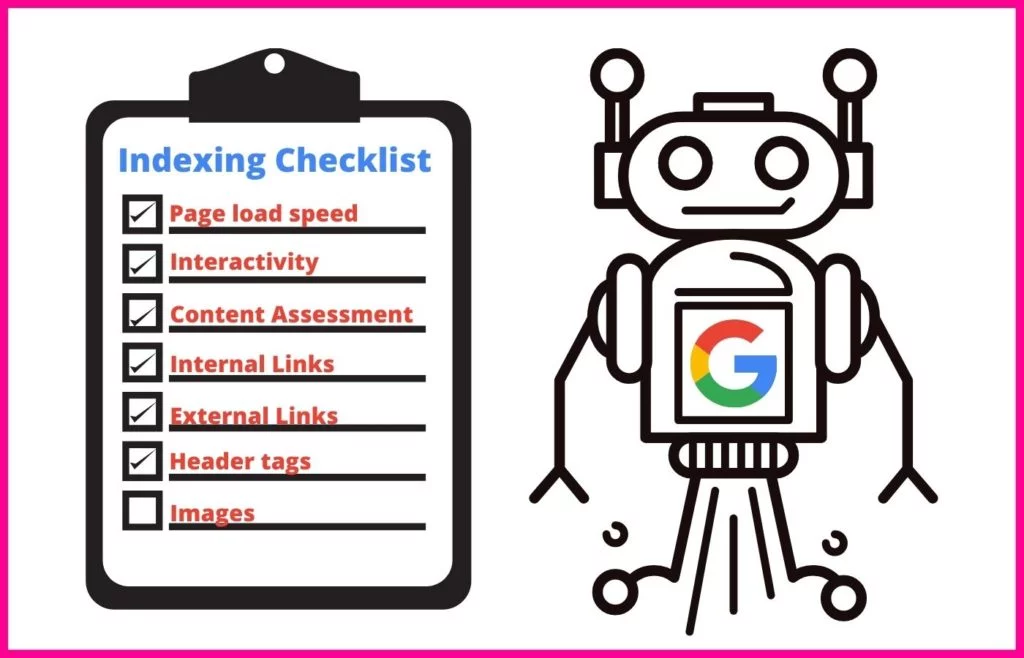

În timpul sesiunii de accesare cu crawlere, un robot Google va folosi o abordare sistematică pentru a înțelege conținutul fiecărei pagini pe care o prelucrează.

Aceasta include indexarea unor atribute specifice, cum ar fi:

- Meta-etichete și utilizarea NLP pentru a le determina semnificația

- Legături și text de ancorare

- Fișiere rich media pentru căutări de imagini și videoclipuri

- Markup schema

- Marcaj HTML

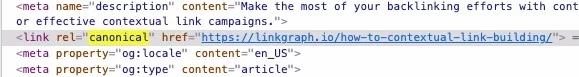

De asemenea, crawler-ul web va efectua o verificare pentru a determina dacă conținutul de pe pagină este o copie a unui canonic. Dacă da, Google va muta adresa URL la o accesare cu prioritate redusă, astfel încât să nu piardă timpul accesând pagina la fel de des.

Ce sunt rata de accesare cu crawlere și cererea de accesare cu crawlere?

Crawlerele web Google atribuie o anumită perioadă de timp fiecărei accesări cu crawlere pe care o efectuează. În calitate de proprietar al site-ului web, nu aveți control asupra acestei perioade de timp. Cu toate acestea, puteți modifica cât de repede accesează cu crawlere paginile individuale de pe site-ul dvs. în timp ce sunt pe site. Acest număr se numește rata de accesare cu crawlere .

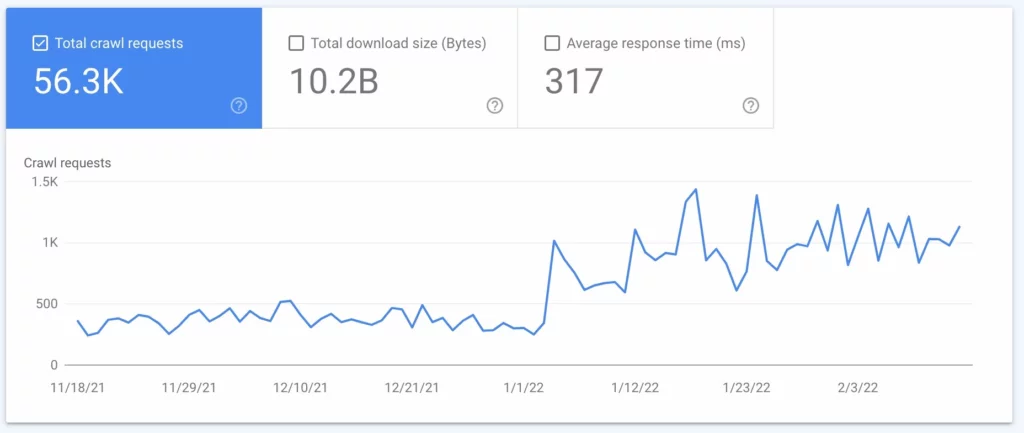

Cererea de accesare cu crawlere este frecvența cu care Google accesează cu crawlere site-ul dvs. Această frecvență se bazează pe cererea site-ului dvs. de către utilizatorii de internet și pe cât de des trebuie actualizat conținutul site-ului dvs. la căutare. Puteți descoperi cât de des Google accesează cu crawlere site-ul dvs. folosind o analiză a fișierului jurnal (vezi numărul 2 de mai jos).

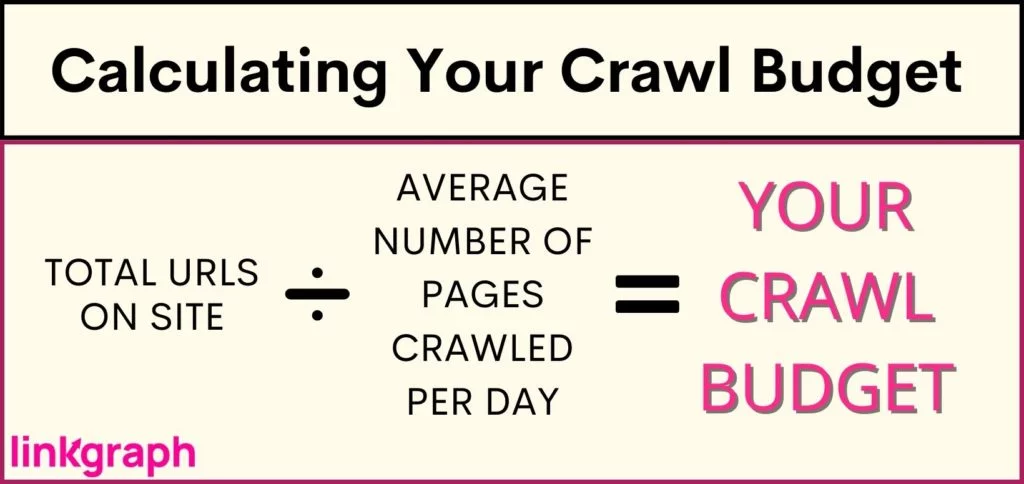

Cum pot determina bugetul de accesare cu crawlere al site-ului meu?

Deoarece Google limitează numărul de accesări cu crawlere pe site-ul dvs. și pentru cât timp, doriți să aflați care este bugetul dvs. de accesare cu crawlere. Cu toate acestea, Google nu furnizează proprietarilor de site-uri aceste date, mai ales dacă bugetul dvs. este atât de restrâns încât conținutul nou nu va atinge SERP-urile în timp util. Acest lucru poate fi dezastruos pentru conținut important și pagini noi, cum ar fi paginile de produse, care ar putea să vă facă bani.

Pentru a înțelege dacă site-ul dvs. se confruntă cu limitări ale bugetului de accesare cu crawlere (sau pentru a confirma că site-ul dvs. este A-OK), veți dori să: Obțineți un inventar al câte adrese URL sunt pe site-ul dvs. Dacă utilizați Yoast, totalul dvs. va fi afișat în partea de sus a adresei URL a sitemapului dvs. .

Cum puteți optimiza pentru un buget de accesare cu crawlere?

Când va veni momentul în care site-ul dvs. a devenit prea mare pentru bugetul de accesare cu crawlere, va trebui să vă aprofundați în optimizarea bugetului de accesare cu crawlere. Deoarece nu puteți spune Google să acceseze cu crawlere site-ul dvs. mai des sau pentru o perioadă mai lungă de timp, trebuie să vă concentrați pe ceea ce puteți controla.

Optimizarea bugetului de accesare cu crawlere necesită o abordare cu mai multe fațete și o înțelegere a celor mai bune practici Google . De unde ar trebui să începi când vine vorba de a profita la maximum de rata de accesare cu crawlere? Această listă cuprinzătoare este scrisă în ordine ierarhică, așa că începeți de sus.

1. Luați în considerare creșterea limitei ratei de accesare cu crawlere a site-ului dvs

Google trimite solicitări simultan către mai multe pagini de pe site-ul dvs. Cu toate acestea, Google încearcă să fie politicos și să nu blocheze serverul, ceea ce duce la un timp de încărcare mai lent pentru vizitatorii site-ului. Dacă observați că site-ul dvs. rămâne în urmă de nicăieri, aceasta poate fi problema.

Pentru a combate afectarea experienței utilizatorilor, Google vă permite să reduceți rata de accesare cu crawlere. Procedând astfel, se va limita câte pagini Google poate indexa simultan.

Destul de interesant, totuși, Google vă permite, de asemenea, să creșteți limita ratei de accesare cu crawlere – efectul fiind că pot extrage mai multe pagini simultan, rezultând că mai multe adrese URL sunt accesate cu crawlere simultan. Deși, toate rapoartele sugerează că Google răspunde lent la o creștere a limitei ratei de accesare cu crawlere și nu garantează că Google va accesa cu crawlere mai multe site-uri simultan.

Cum să creșteți limita ratei de accesare cu crawlere:

- În Search Console, accesați „Setări”.

- De acolo, puteți vedea dacă rata de accesare cu crawlere este optimă sau nu.

- Apoi puteți crește limita la o rată de accesare cu crawlere mai rapidă timp de 90 de zile.

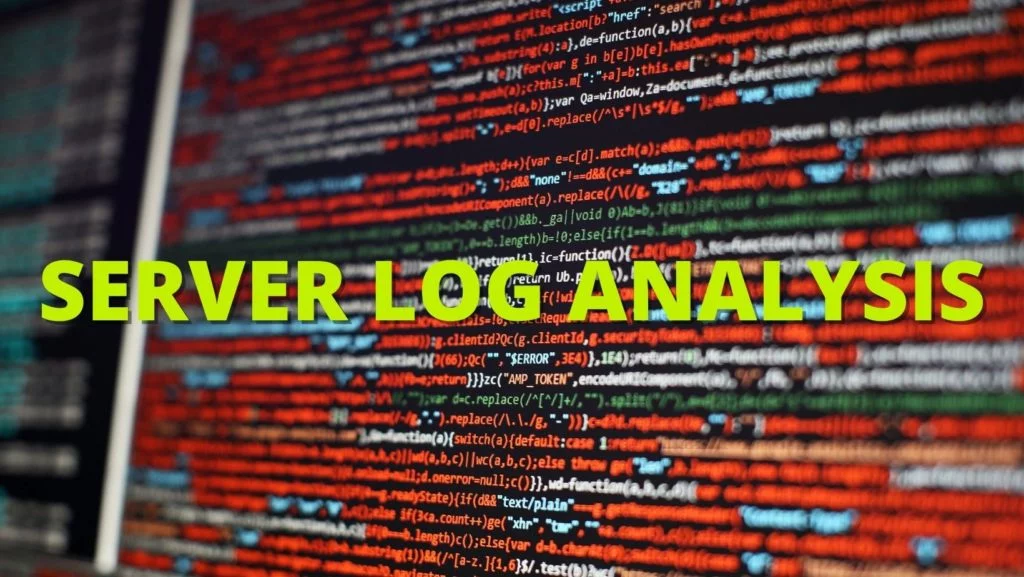

2. Efectuați o analiză a fișierului jurnal

O analiză a fișierului jurnal este un raport de la server care reflectă fiecare cerere trimisă către server. Acest raport vă va spune exact ce fac Googlebots pe site-ul dvs. Deși acest proces este adesea efectuat de SEO tehnici, puteți discuta cu administratorul serverului pentru a obține unul.

Utilizând analiza fișierului jurnal sau fișierul jurnal al serverului, veți învăța:

- Cât de des accesează Google cu crawlere site-ul dvs

- Ce pagini sunt accesate cel mai mult cu crawlere

- Ce pagini au un cod de server care nu răspunde sau lipsește

Odată ce aveți aceste informații, le puteți folosi pentru a efectua de la #3 la #7.

3. Păstrați sitemap-ul XML și Robots.txt actualizate

Dacă fișierul dvs. jurnal arată că Google petrece prea mult timp accesând cu crawlere pagini pe care nu doriți să apară în SERP-uri, puteți solicita ca crawlerele Google să omite aceste pagini. Acest lucru eliberează o parte din bugetul de accesare cu crawlere pentru pagini mai importante.

Harta site- ului dvs. (pe care o puteți obține din Google Search Console sau SearchAtlas ) oferă Googlebots o listă cu toate paginile de pe site-ul dvs. pe care doriți să le indexeze Google, astfel încât să poată apărea în rezultatele căutării. Menținerea sitemap-ului dvs. actualizată cu toate paginile web pe care doriți să le găsească motoarele de căutare și omiterea celor pe care nu doriți să le găsească poate maximiza modul în care webcrawlerele își petrec timpul pe site-ul dvs.

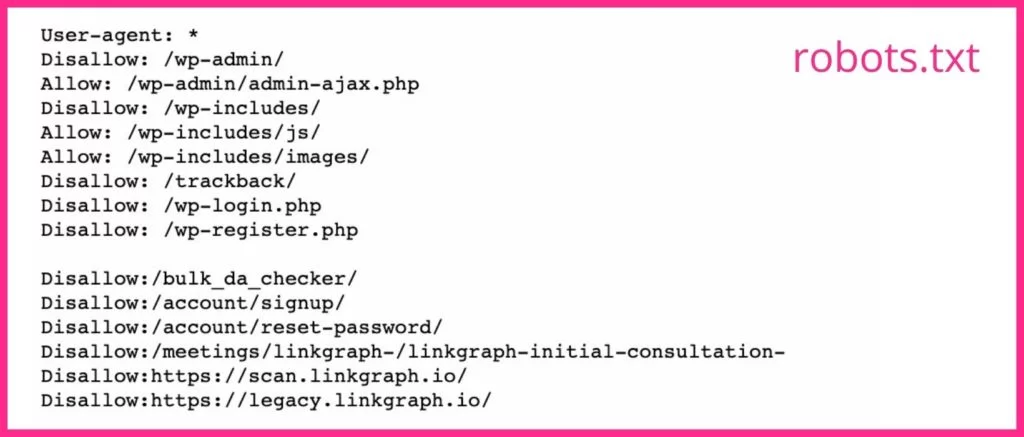

Fișierul dvs. robots.txt le spune crawlerilor motoarelor de căutare ce pagini doriți și nu doriți să fie accesate cu crawlere. Dacă aveți pagini care nu fac pagini de destinație bune sau pagini care au blocare, ar trebui să utilizați eticheta noindex pentru adresele URL ale acestora din fișierul robots.txt. Googlebots va omite probabil orice pagină web cu eticheta noindex.

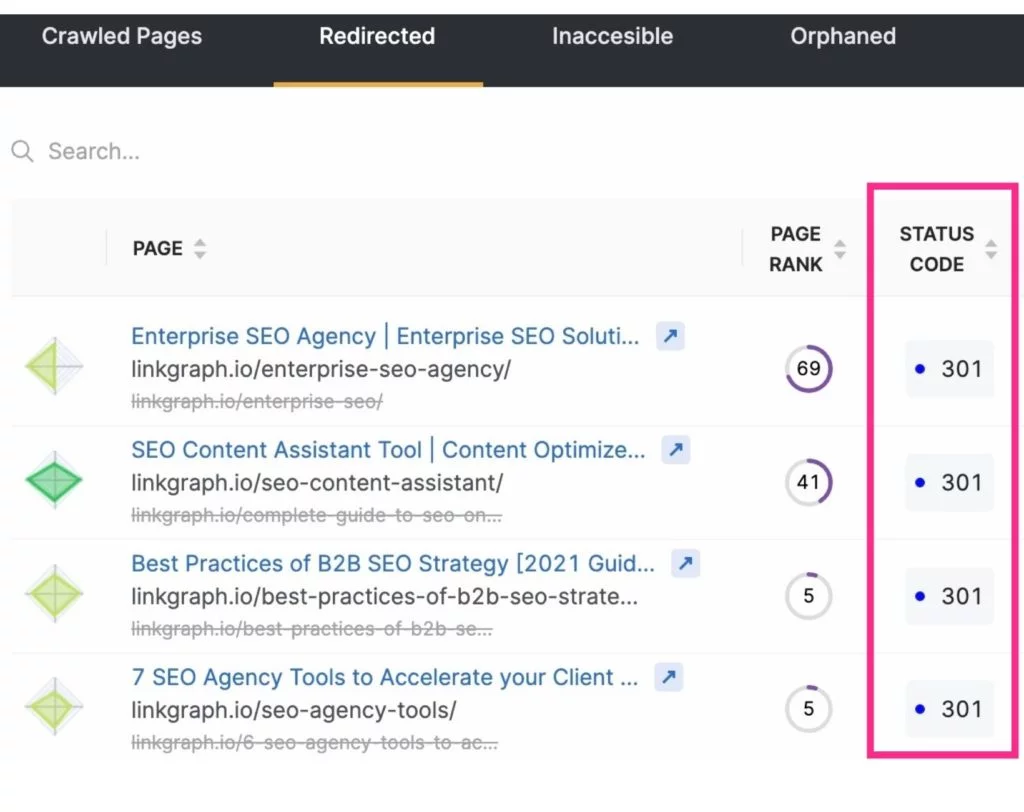

4. Reduceți redirecționările și lanțurile de redirecționare

Pe lângă eliberarea bugetului de accesare cu crawlere prin excluderea paginilor inutile din accesările cu crawlere la motoarele de căutare, puteți, de asemenea, să maximizați accesările cu crawlere prin reducerea sau eliminarea redirecționărilor. Acestea vor fi orice URL-uri care au ca rezultat un cod de stare 3xx.

Adresele URL redirecționate durează mai mult pentru ca un robot Google să recupereze, deoarece serverul trebuie să răspundă cu redirecționarea, apoi să preia noua pagină. În timp ce o redirecționare durează doar câteva milisecunde, acestea se pot adăuga. Și acest lucru poate face ca accesarea cu crawlere a site-ului dvs. să dureze în general mai mult. Această perioadă de timp se înmulțește atunci când un robot Google intră într-un lanț de redirecționări URL.

Pentru a reduce redirecționările și lanțurile de redirecționare, fiți atenți la strategia dvs. de creare de conținut și selectați cu atenție textul pentru slug-urile dvs.

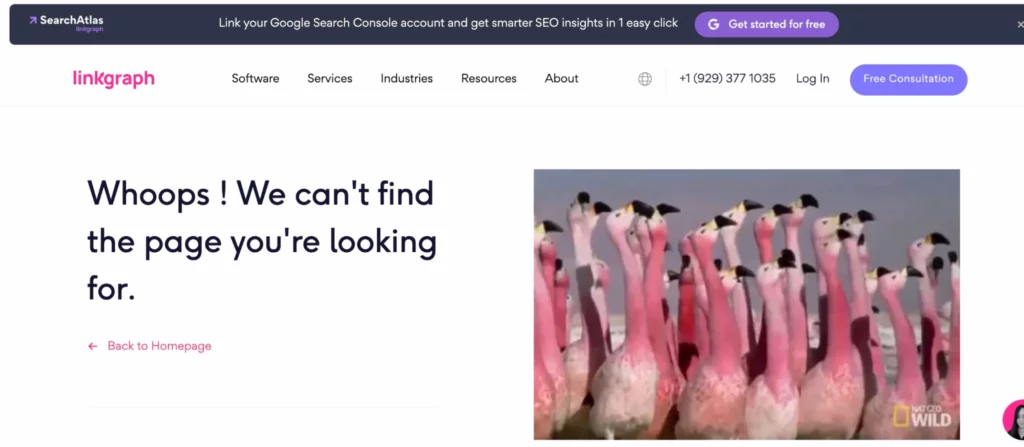

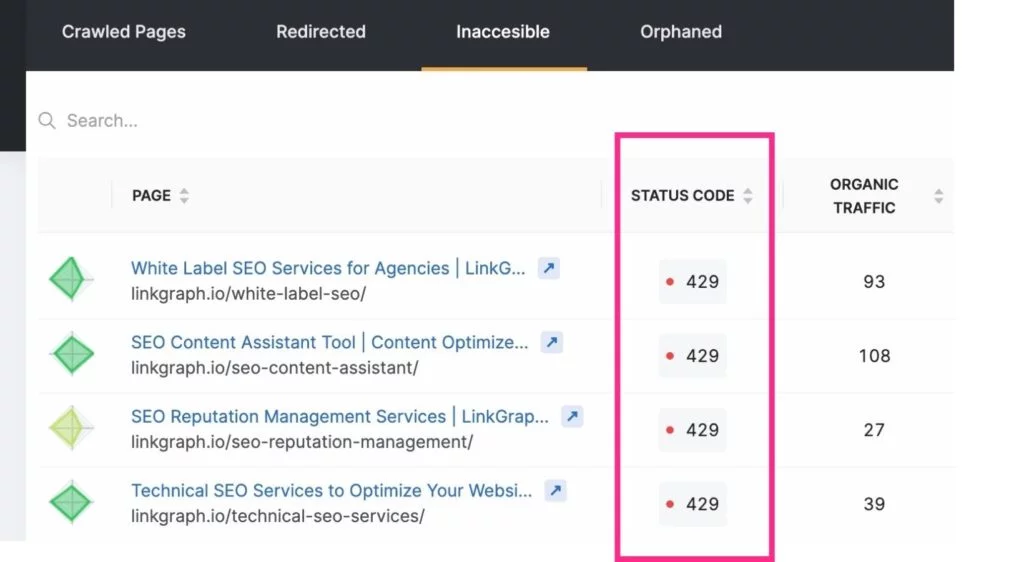

5. Remediați legăturile rupte

Modul în care Google explorează adesea un site este prin navigarea prin structura internă a linkurilor. Pe măsură ce își parcurge paginile dvs., va observa dacă un link duce la o pagină inexistentă (aceasta este adesea denumită o eroare 404 soft). Apoi va merge mai departe, nedorind să piardă timpul indexând pagina respectivă.

Linkurile către aceste pagini trebuie actualizate pentru a trimite utilizatorul sau Googlebot la o pagină reală. SAU (deși este greu de crezut) este posibil ca Googlebot să fi identificat greșit o pagină ca o eroare 4xx sau 404 atunci când pagina există de fapt. Când se întâmplă acest lucru, verificați dacă adresa URL nu are greșeli de scriere, apoi trimiteți o solicitare de accesare cu crawlere pentru acea adresă URL prin contul dvs. Google Search Console.

Pentru a fi la curent cu aceste erori de accesare cu crawlere, puteți utiliza Indexul > Raportul de acoperire din contul dvs. Google Search Console. Sau utilizați instrumentul de audit al site-ului SearchAtlas pentru a găsi raportul de eroare a site-ului dvs. pe care să îl transmiteți dezvoltatorului dvs. web.

Notă: este posibil ca URL-urile noi să nu apară imediat în analiza fișierului jurnal. Acordați-i lui Google ceva timp pentru a le găsi înainte de a solicita accesarea cu crawlere.

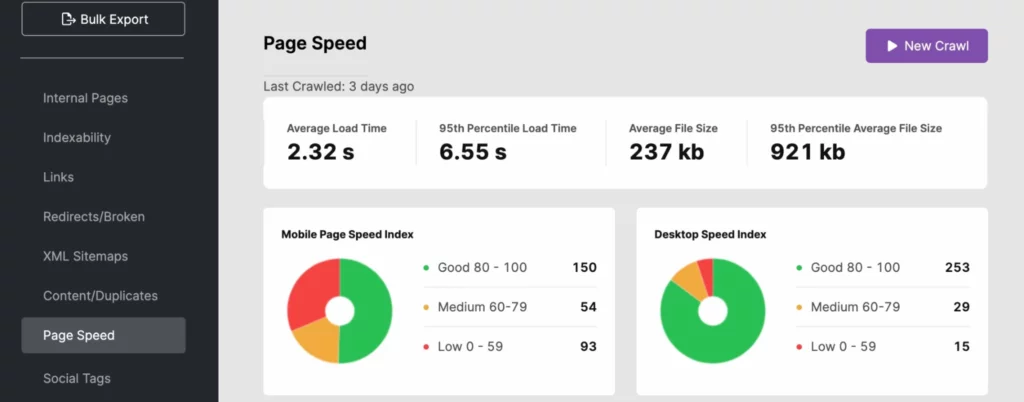

6. Lucrați la îmbunătățirea vitezei de încărcare a paginii

Boții motoarelor de căutare se pot deplasa printr-un site într-un ritm rapid. Cu toate acestea, dacă viteza site-ului dvs. nu este la egalitate, poate avea o taxă majoră asupra bugetului de accesare cu crawlere. Utilizați analiza fișierului jurnal, SearchAtlas sau PageSpeedInsights pentru a determina dacă timpul de încărcare a site-ului dvs. afectează negativ vizibilitatea căutării.

Pentru a îmbunătăți timpul de răspuns al site-ului dvs., utilizați adrese URL dinamice și urmați cele mai bune practici Google Core Web Vitals . Aceasta poate include optimizarea imaginii pentru media de deasupra pliului.

Dacă problema vitezei site-ului este de partea serverului, poate doriți să investiți în alte resurse de server, cum ar fi:

- Un server dedicat (mai ales pentru site-uri mari)

- Actualizarea la hardware server mai nou

- Creșterea memoriei RAM

Aceste îmbunătățiri vor oferi, de asemenea, un impuls experienței dvs. de utilizator, ceea ce vă poate ajuta site-ul dvs. să performeze mai bine în căutarea Google, deoarece viteza site-ului este un semnal pentru PageRank.

7. Nu uitați să utilizați etichete canonice

Conținutul duplicat este descurajat de Google, cel puțin atunci când nu recunoașteți că conținutul duplicat are o pagină sursă. De ce? Googlebot accesează cu crawlere fiecare pagină, cu excepția cazului în care este inevitabil, dacă nu i se spune să facă altfel. Cu toate acestea, atunci când găsește o pagină duplicată sau o copie a ceva cu care este familiarizat (pe pagina dvs. sau în afara site-ului), va înceta accesarea cu crawlere a paginii respective. Și, deși acest lucru economisește timp, ar trebui să economisiți și mai mult timp crawler-ului utilizând o etichetă canonică care identifică adresa URL canonică.

Canonicals îi spune robotului Google să nu se deranjeze să folosească perioada de accesare cu crawlere pentru a indexa acel conținut. Acest lucru oferă robotului motorului de căutare mai mult timp pentru a vă examina celelalte pagini.

8. Concentrați-vă pe structura dvs. internă de legătură

Având o practică de conectare bine structurată în cadrul site-ului dvs., poate crește eficiența unui acces cu crawlere Google. Link-urile interne îi spun Google care pagini de pe site-ul dvs. sunt cele mai importante, iar aceste link-uri ajută crawlerele să găsească pagini mai ușor.

Cele mai bune structuri de conectare conectează utilizatorii și Googlebots la conținutul de pe site-ul dvs. Utilizați întotdeauna un text de ancorare relevant și plasați link-urile în mod natural în conținutul dvs.

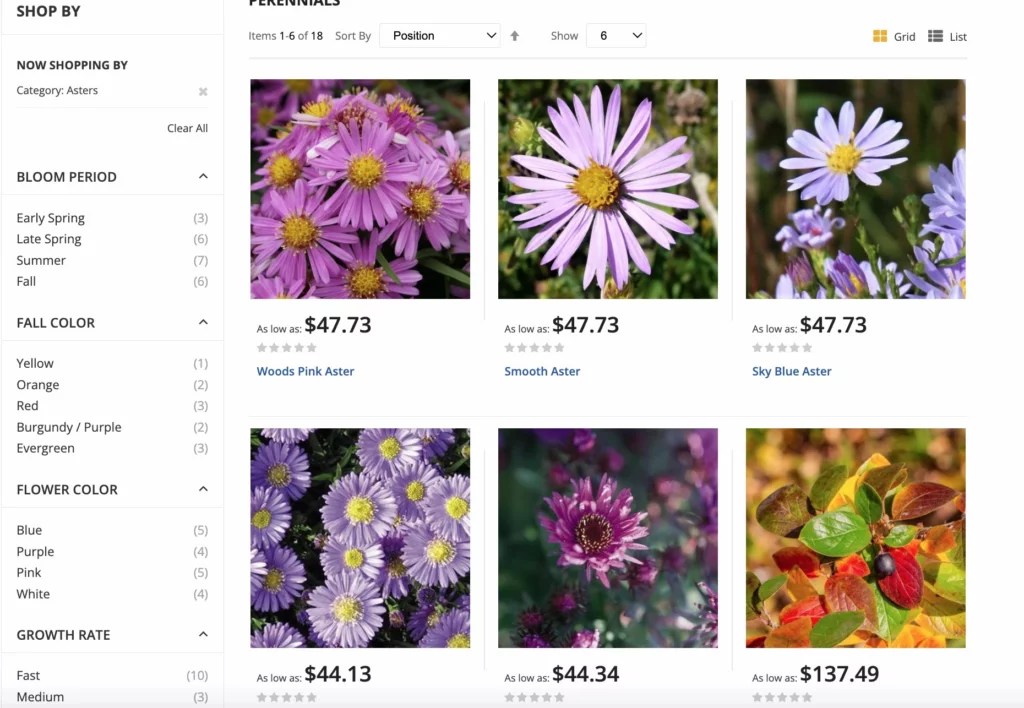

Pentru site-urile de comerț electronic, Google are cele mai bune practici pentru opțiunile de navigare fațete pentru a maximiza accesările cu crawlere. Navigarea cu fațete permite utilizatorilor site-ului să filtreze produsele după atribute, făcând cumpărăturile o experiență mai bună. Această actualizare ajută la evitarea confuziei canonice și a problemelor duplicate, pe lângă accesările cu crawlere în exces ale adreselor URL.

9. Eliminați conținutul inutil

Googlebots se pot mișca atât de rapid și indexează atât de multe pagini de fiecare dată când accesează cu crawlere un site. Dacă aveți un număr mare de pagini care nu primesc trafic sau au conținut învechit sau de calitate scăzută, tăiați-le! Procesul de tăiere vă permite să eliminați excesul de bagaj al site-ului dvs., care îl poate îngreuna.

Dacă aveți pagini în exces pe site-ul dvs., Googlebots poate devia către pagini neimportante, ignorând paginile.

Nu uitați să redirecționați orice link către aceste pagini, astfel încât să nu ajungeți cu erori de accesare cu crawlere.

10. Acumulați mai multe backlink-uri

Așa cum Googlebots ajung pe site-ul dvs., apoi încep să indexeze paginile pe baza linkurilor interne, ei folosesc și linkuri externe în procesul de indexare. Dacă alte site-uri leagă la al dvs., Googlebot va călători pe site-ul dvs. și va indexa paginile pentru a înțelege mai bine conținutul de la care se leagă.

În plus, backlink -urile oferă site-ului dvs. puțin mai multă popularitate și recentitate, pe care Google le folosește pentru a determina cât de des trebuie să fie indexat site-ul dvs.

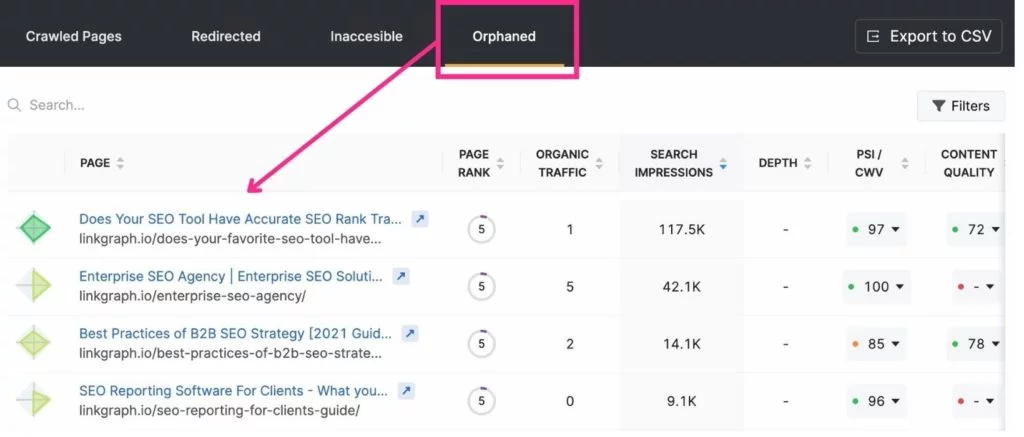

11. Eliminați paginile orfane

Deoarece crawler-ul Google trece de la o pagină la alta prin link-uri interne, poate găsi pagini la care sunt conectate fără efort. Cu toate acestea, paginile care nu sunt legate de undeva pe site-ul dvs. trec adesea neobservate de Google. Acestea sunt denumite „pagini orfane”.

Când este o pagină orfană potrivită? Dacă este o pagină de destinație care are un scop sau un public foarte specific. De exemplu, dacă trimiteți un e-mail jucătorilor de golf care locuiesc în Miami cu o pagină de destinație care se aplică numai acestora, este posibil să nu doriți să creați un link către pagina de la o altă pagină.

Cele mai bune instrumente pentru optimizarea bugetului cu crawlere

Search Console și Google Analytics pot fi destul de utile atunci când vine vorba de optimizarea bugetului de accesare cu crawlere. Search Console vă permite să solicitați unui crawler să indexeze paginile și să vă urmărească statisticile de accesare cu crawlere. Google Analytics vă ajută să urmăriți călătoria dvs. internă de conectare.

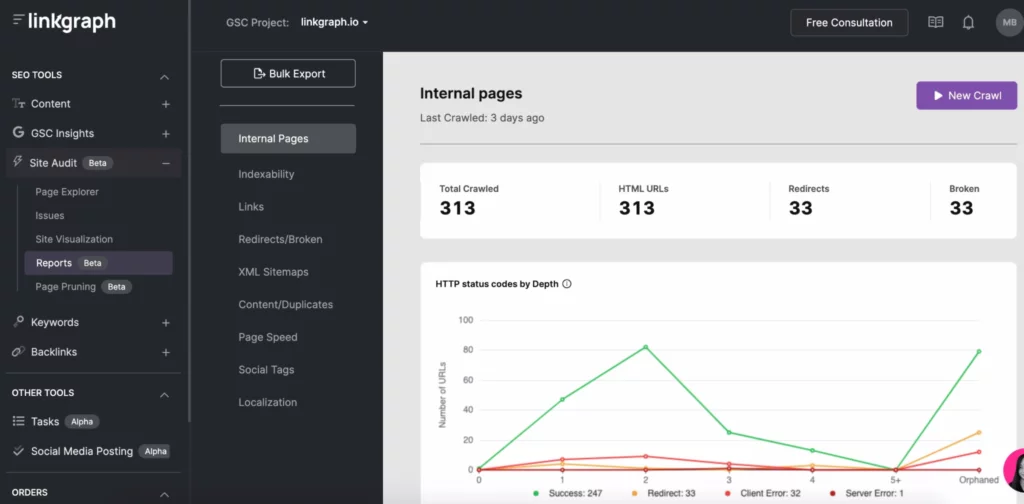

Alte instrumente SEO, cum ar fi SearchAtlas, vă permit să găsiți cu ușurință probleme de accesare cu crawlere prin instrumentele de auditare a site-ului. Cu un singur raport, puteți vedea site-ul dvs.:

- Raport de accesare cu crawlere la indexabilitate

- Adâncimea indexului

- Viteza paginii

- Conținut duplicat

- Harta site XML

- Legături

Optimizați-vă bugetul de accesare cu crawlere și deveniți un motor de căutare cu cele mai bune performanțe

Deși nu puteți controla cât de des motoarele de căutare indexează site-ul dvs. sau pentru cât timp, vă puteți optimiza site-ul pentru a profita la maximum de fiecare accesare cu crawlere la motoarele dvs. de căutare. Începeți cu jurnalele de server și aruncați o privire mai atentă la raportul de accesare cu crawlere din Search Console. Apoi aruncați-vă în remedierea eventualelor erori de accesare cu crawlere, a structurii linkurilor și a problemelor legate de viteza paginii.

Pe măsură ce lucrați prin activitatea de accesare cu crawlere GSC, concentrați-vă pe restul strategiei dvs. SEO, inclusiv crearea de linkuri și adăugarea de conținut de calitate . De-a lungul timpului, veți descoperi că paginile dvs. de destinație urcă pe paginile cu rezultate ale motorului de căutare.