Cum să vă optimizați bugetul de accesare cu crawlere și să creșteți clasamentele?

Publicat: 2017-01-14Cuprins

- 1 Ce este Bugetul Crawl?

- 2 De ce contează bugetul de accesare cu crawlere?

- 3 Când este Bugetul Crawl O problemă?

- 4 Cum să vă optimizați bugetul de accesare cu crawlere

- 5 1. Îmbunătățiți structura site-ului

- 6 2.Rezolvați linkurile întrerupte

- 7 3. Utilizați cu atenție conținutul rich media

- 8 4.Curăţaţi Harta site-ului

- 9 5.Construiți legături externe

- 10 6.Organizați legăturile interne

- 11 7.Folosiți fluxurile

- 12 8.Eliminați lanțurile de redirecționare

- 13 9. Asigurați-vă că paginile dvs. pot fi accesate cu crawlere

Toată lumea știe ce este optimizarea pentru motoarele de căutare și importanța unui site bine structurat, cuvinte cheie relevante, conținut de calitate, etichetare adecvată, harta site-ului curată și alte standarde tehnice. Dar există șanse, nu te-ai gândit la Optimizarea cu crawlere.

Optimizarea bugetului cu crawlere este ceva mai profund decât optimizarea pentru motoarele de căutare. În timp ce optimizarea motoarelor de căutare se concentrează mai mult pe procesul de optimizare pentru interogările utilizatorilor, optimizarea cu crawlere se concentrează pe modul în care roboții motoarelor de căutare (păianjenii web) accesează site-ul dvs.

În acest articol, vom prezenta mecanismele care stau la baza modului în care motoarele de căutare atribuie bugete de accesare cu crawlere site-urilor web și sfaturi pentru a vă ajuta să profitați la maximum de bugetul de accesare cu crawlere pentru a maximiza clasamentele, traficul organic și, cel mai important, indexarea.

Ce este Bugetul Crawl?

Bugetul de accesare cu crawlere este pur și simplu cantitatea de pagini pe care spiderul motorului de căutare le va accesa cu crawlere site-ul dvs. într-o anumită perioadă de timp. Bugetul de accesare cu crawlere este determinat, în general, de dimensiunea și starea de sănătate a site-ului dvs. și de numărul de link-uri care indică site-ul dvs.

Bugetul crawl este un factor SEO important căruia nu i se acordă suficientă atenție. Motoarele de căutare folosesc roboti spider pentru a accesa cu crawlere paginile web, pentru a aduna informații și pentru a le adăuga la indexul lor. În plus, ei indică, de asemenea, link-uri pe paginile pe care le vizitează și încearcă să acceseze cu crawlere acele pagini noi.

De exemplu, Googlebot este păianjenul web care descoperă pagini noi și le adaugă la indexul Google. Cele mai multe dintre serviciile web și instrumentele SEO au încredere în acești păianjeni web pentru a aduna informații utile.

De ce contează bugetul de accesare cu crawlere?

Capacitatea de accesare cu crawlere a unui site web este un pas principal și crucial pentru a asigura posibilitatea de căutare. Dacă vă întrebați dacă optimizarea bugetului de accesare cu crawlere este sau nu importantă pentru site-ul dvs., răspunsul este, desigur, DA. Eforturile tale SEO și optimizarea crawlei vor merge probabil mână în mână.

Pe cât de simplu este, este destul de logic că ar trebui să vă îngrijorați bugetul de accesare cu crawlere, deoarece face ca Google să vă descopere și să indexeze site-ul web mai ușor. Dacă există mai multe accesări cu crawlere pe site-ul dvs. web, înseamnă că veți avea actualizări mai rapide atunci când publicați conținut nou. Deci, cu cât bugetul de accesare cu crawlere este mai mare, cu atât se va întâmpla mai repede.

Acest lucru vă va ajuta, de asemenea, să îmbunătățiți experiența generală a utilizatorului pentru site-ul dvs., ceea ce îmbunătățește vizibilitatea și, în cele din urmă, are ca rezultat o clasare mai bună a SERP-urilor. Faptul este că paginile care au fost accesate cu crawlere recent capătă mai multă vizibilitate în SERP-uri și dacă o pagină nu a fost accesată cu crawlere de ceva timp, aceasta nu se va clasa bine.

Când este Bugetul Crawl O problemă?

Nu înseamnă că bugetul Crawl va crea adesea o problemă. Dacă ați alocat accesări proporționale cu crawlere pentru adresele URL ale site-ului dvs., nu este o problemă. Dar să presupunem că site-ul dvs. are 200.000 de adrese URL și Google accesează cu crawlere doar 2.000 de pagini pe zi pe site-ul dvs., apoi ar putea dura 100 de zile pentru ca Google să identifice sau să actualizeze adresele URL - acum aceasta este o problemă.

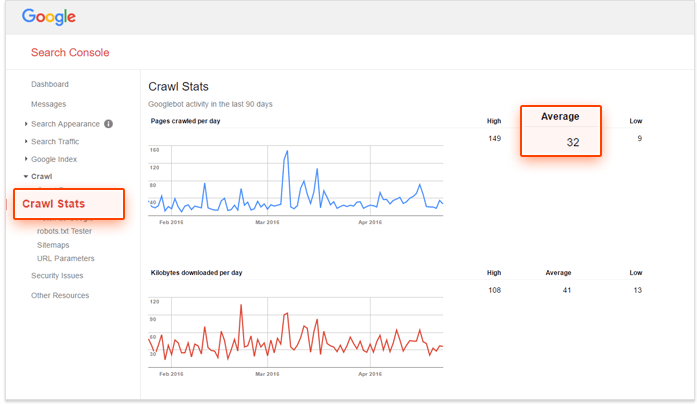

Dacă căutați o soluție și doriți să verificați dacă bugetul de accesare cu crawlere necesită optimizare, utilizați Google Search Console și numărul de adrese URL de pe site-ul dvs. pentru a calcula „numărul de accesare cu crawlere” al site-ului. Cum să facă acest lucru?

– În primul rând, trebuie să evaluați câte pagini există pe site-ul dvs., puteți face acest lucru făcând un site: căutați pe Google,

– În al doilea rând, accesați contul dvs. Google Search Console și accesați Crawl, apoi Statistici de accesare cu crawlere. Dacă contul dvs. nu este configurat corect, nu veți primi aceste date.

– Al treilea pas este împărțirea numărului total de pagini de pe site-ul dvs. la numărul mediu de pagini accesate cu crawlere pe zi pe site-ul dvs.

Dacă acest număr este mai mare de 10, trebuie să vă uitați la optimizarea bugetului de accesare cu crawlere. Daca este mai putin de 5, bravo! Nu trebuie să citiți mai departe.

Cum să vă optimizați bugetul de accesare cu crawlere

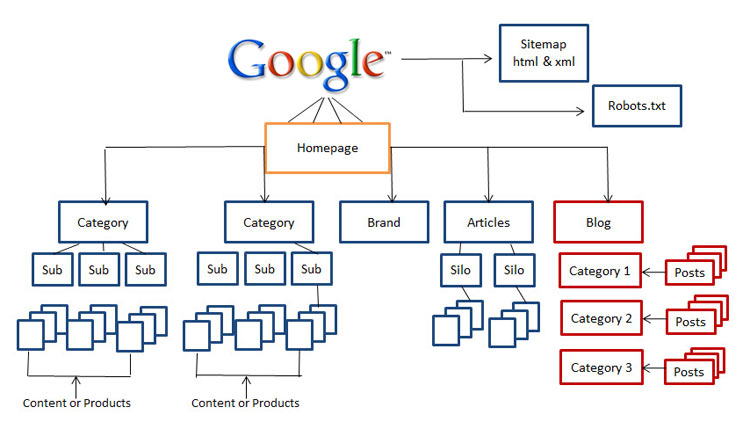

1. Îmbunătățiți structura site-ului

Astăzi, importanța structurii site-ului este un factor crucial. Maeștrii SEO precum Rand Fishkin sfătuiesc să se asigure că utilizatorii site-ului dvs. nu sunt la mai mult de trei clicuri distanță de pagina de pornire în timpul vizitei lor. Este într-adevăr un sfat grozav pentru SEO în ceea ce privește utilizarea, deoarece vizitatorii dvs. nu sunt susceptibili să sape mai adânc în site-ul dvs.

Deci, dacă nu aveți un site curat, ușor de navigat și prietenos cu motoarele de căutare, acum este timpul să începeți să vă restructurați site-ul.

2.Rezolvați linkurile întrerupte

Aceasta este una dintre diferențele de bază dintre optimizarea pentru motoarele de căutare și optimizarea accesării cu crawlere, nu numai că linkurile rupte joacă un rol substanțial în scăderea clasamentului dvs., ci și împiedică în mare măsură capacitatea Googlebot de a indexa și clasa site-ul dvs.

Algoritmul Google s-a îmbunătățit substanțial de-a lungul anilor și orice lucru care afectează experiența utilizatorului este probabil să afecteze SERP-urile. Google a încercat întotdeauna să copieze comportamentul utilizatorului și să actualizeze algoritmii. Prin urmare, ar trebui să luăm în considerare întotdeauna experiența utilizatorului atunci când optimizăm site-uri web pentru motoarele de căutare.

3. Utilizați cu atenție conținutul rich media

Astăzi, Google se străduiește să acceseze cu crawlere Silverlight și doar câteva alte fișiere, dar au existat momente în care Google nu a putut accesa cu crawlere conținutul rich media, cum ar fi flash, javascript și HTML.

Cu toate acestea, deși Google poate citi majoritatea fișierelor dvs. media îmbogățite, există și alte motoare de căutare care ar putea să nu le poată face. Aceasta înseamnă că ar trebui să utilizați aceste fișiere cu înțelepciune și, uneori, poate doriți să le evitați în întregime în paginile pe care doriți să le clasați.

4. Curățați Sitemap

Faceți câteva eforturi pentru a vă curăța harta site-ului și a o menține la zi, pentru a vă proteja de aglomerațiile care pot dăuna utilizării site-ului dvs., inclusiv pagini blocate, pagini non-canonice, redirecționări inutile și pagini de nivel 400. Utilizarea sitemap-urilor XML este cea mai bună modalitate de a vă ajuta utilizatorii, precum și roboții spider.

Există diverse instrumente pe piață pentru a vă curăța harta site-ului. Puteți utiliza generatorul de hărți de site XML pentru a crea un hartă de site curată, care exclude toate paginile blocate de la indexare, găsiți și remediați lucruri precum redirecționările 301 și 302 și paginile non-canonice.

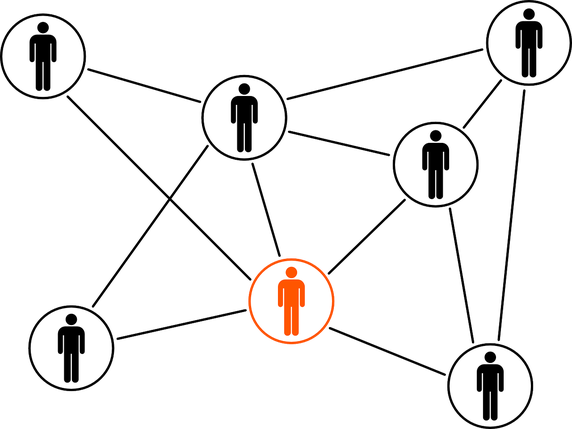

5.Construiți legături externe

Crearea de legături este un subiect fierbinte din toate timpurile și nu va dispărea în viitorul apropiat. Descoperirea de noi comunități, stabilirea de relații online și construirea valorii mărcii sunt câteva dintre avantajele pe care ar trebui să le aveți deja în procesul de construire a linkurilor.

Când se face prin cele mai bune practici, link-urile externe sunt link-urile care indică un domeniu extern și cea mai importantă sursă de a obține clasamente mai înalte. Deși linkurile externe sunt cele mai greu de manipulat, ele reprezintă o modalitate excelentă pentru motoarele de căutare de a cunoaște popularitatea și relevanța unei pagini web.

6.Organizați legăturile interne

Deși construirea de link-uri interne nu are mare legătură cu optimizarea bugetului de accesare cu crawlere, acest lucru nu înseamnă că o puteți ignora. O structură bine organizată și întreținută a site-ului vă ajută conținutul să fie ușor vizibil pentru utilizatori, precum și pentru roboții păianjen, fără a cheltui suficient buget de accesare cu crawlere.

Un sistem de conectare internă bine structurat îmbunătățește, de asemenea, experiența utilizatorului. Ajutați utilizatorii să ajungă în orice zonă cu câteva clicuri și faceți lucrurile ușor accesibile, în general, îi va face pe vizitatori să rămână mai mult timp pe site-ul dvs., ceea ce vă va îmbunătăți clasamentul SERP.

7.Folosiți fluxuri

Diverse fluxuri, cum ar fi RSS, Atom și XML, vă ajută site-ul web să livreze conținut utilizatorilor chiar și atunci când aceștia nu vă navighează pe site. Acesta este cel mai bun mod pentru utilizatori de a se abona la cele mai favorabile site-uri și de a primi actualizări regulate ori de câte ori este publicat conținut nou.

De mult timp, fluxurile RSS s-au dovedit a fi o modalitate bună de a crește numărul de cititori și implicarea site-ului dvs. În plus, se numără și printre cele mai vizitate site-uri de către păianjenii web ai Google. Când site-ul dvs. are o actualizare, o puteți trimite la Google Feed Burner, astfel încât să fiți sigur că este indexat corect.

8.Eliminați lanțurile de redirecționare

Fiecare adresă URL către care redirecționați va pierde o parte din bugetul de accesare cu crawlere. Atunci când site-ul dvs. are lanțuri lungi de redirecționare, ceea ce înseamnă că aveți un număr mare de redirecționări 301 și 302 la rând, atunci păianjenii web se pot opri înainte de a ajunge la pagina dvs. de destinație, în cele din urmă pagina dvs. nu va fi indexată. Dacă căutați cea mai bună practică cu redirecționări, este mai bine să aveți cât mai puține redirecționări posibil pe site-ul dvs. web și nu mai mult de două la rând.

9. Asigurați-vă că paginile dvs. pot fi accesate cu crawlere

Dacă roboții spider motoarele de căutare sunt capabili să găsească paginile dvs. web, să găsească și să urmeze linkuri din site-ul dvs., atunci aceștia pot fi accesați cu crawlere. Deci, trebuie să configurați fișierele robots.txt și .htaccess astfel încât acestea să nu blocheze paginile critice ale site-ului dvs.

De asemenea, poate fi necesar să furnizați fișierele text ale paginilor care se află pe conținut media bogat, cum ar fi flash, silverlight etc.

Numai prin interzicerea în robots.txt, nu puteți garanta că opriți deindexarea unei pagini. Dacă există lucruri externe, cum ar fi link-uri de intrare, care continuă să direcționeze traficul către pagina pe care ați interzis-o, Google poate considera că pagina este încă relevantă. În acest caz, va trebui să blocați manual pagina de a fi indexată. Puteți face acest lucru cu ușurință folosind antetul HTTP X-Robots-Tag sau metaeticheta noindex robots.

Rețineți că, dacă utilizați metaetichetă noindex sau X-Robots-Tag, nu ar trebui să interziceți pagina în robots.txt. Pagina trebuie accesată cu crawlere înainte ca eticheta să fie văzută și respectată.

Concluzie: optimizarea bugetului cu crawlere nu este o sarcină ușoară și, cu siguranță, nu este un „câștig rapid”. Dacă aveți un site web de dimensiuni mici sau mijlocii, care este bine întreținut, probabil că sunteți bine. Dar dacă aveți o structură de site complexă și neorganizată, cu mii de adrese URL și fișierele jurnal ale serverului vă trec peste cap - poate fi momentul să sunați profesioniști sau experți pentru a vă ajuta.