BERT: крупнейшее обновление Google за последние годы

Опубликовано: 2022-12-01BERT от Google был запущен в конце 2019 года и затронул почти 10% всех поисковых запросов. Возможно, это одно из крупнейших обновлений алгоритма за 2019 год. Вот все, что оптимизаторы и владельцы сайтов должны знать о усовершенствованной модели обработки естественного языка Google.

Что такое BERT от Google?

BERT — это алгоритм глубокого обучения, сокращение от двунаправленных представлений кодировщика от трансформаторов. Алгоритм помог получить более релевантные результаты для сложных поисковых запросов.

Как повлияло обновление алгоритма BERT на поиск Google?

Вот что сказал Google:

«Эти улучшения направлены на улучшение понимания языка, особенно для более естественных языковых / разговорных запросов, поскольку BERT может помочь поиску лучше понять нюансы и контекст слов в поиске и лучше сопоставлять эти запросы с полезными результатами.

В частности, для более длинных, более разговорных запросов или запросов, в которых предлоги, такие как «для» и «к», имеют большое значение для смысла, Поиск сможет понять контекст слов в вашем запросе. Вы можете искать так, как вам удобно».

Фактически, по данным Google, обновление BERT повлияет на 1 из 10 поисковых запросов на английском языке в США, что составляет 10% поисковых запросов. Это самое значительное обновление Google за последние 5 лет, по крайней мере, по их словам:

Мы значительно улучшаем понимание запросов, что представляет собой самый большой скачок вперед за последние пять лет и один из самых больших скачков вперед в истории поиска.

Внедрение BERT вызвало серьезные колебания рейтинга в первую неделю развертывания нового алгоритма. SEO-специалисты Webmaster World комментируют колебания с начала недели, отмечая самые большие колебания рейтинга в мире SEO со времен RankBrain.

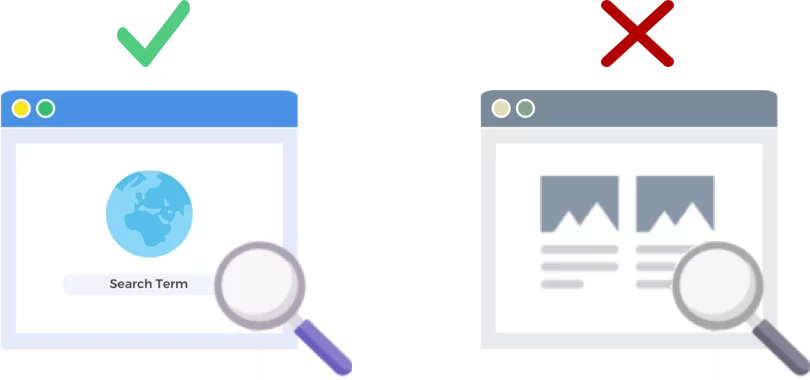

BERT анализирует поисковые запросы, а не веб-страницы

Выпуск алгоритма BERT от 24 октября 2019 г. улучшает то, как гигант поисковых систем анализирует и понимает поисковые запросы (не веб-страницы).

Как работает БЕРТ?

BERT улучшает понимание Google поисковых запросов, используя двунаправленную контекстную модель (это B в BERT). Google фактически немного рассказал о механике BERT примерно в это же время в прошлом году, когда они объявили BERT как новую технику для предварительного обучения обработке естественного языка (NLP).

Что такое предварительная подготовка? Предварительное обучение — это просто обучение машины тому, как выполнять задачи, прежде чем вы действительно дадите ей работу. Традиционно наборы данных для предварительной подготовки содержат от нескольких тысяч до нескольких сотен тысяч примеров, помеченных человеком.

Предварительное обучение существует уже давно, но что делает BERT особенным, так это то, что оно является одновременно контекстуальным (значение каждого слова меняется в зависимости от слов вокруг него) и двунаправленным — значение слова понимается на основе слов как до него, так и после этого.

Согласно блогу Google:

В предложении « Я получил доступ к банковскому счету » однонаправленная контекстуальная модель будет представлять « банк » на основе « Я получил доступ к », но не « счет ». Однако BERT представляет « банк », используя как предыдущий, так и следующий контекст — « Я получил доступ к … учетной записи » — начиная с самого низа глубокой нейронной сети, делая ее глубоко двунаправленной.

Обновление Google BERT основано на последних достижениях в области машинного обучения и распознавания объектов. По сути, BERT помогает идентифицировать все части речи и контекст слов до того, как Google обработает поиск.

Что означает BERT для результатов поиска?

Согласно Google, это означает, что пользователи начнут видеть более релевантные результаты, результаты, которые лучше соответствуют цели поиска пользователя. Это улучшение алгоритма будет охватывать обычные результаты и расширенные результаты фрагментов.

Google предоставил несколько полезных примеров в записи своего блога, анонсирующей BERT.

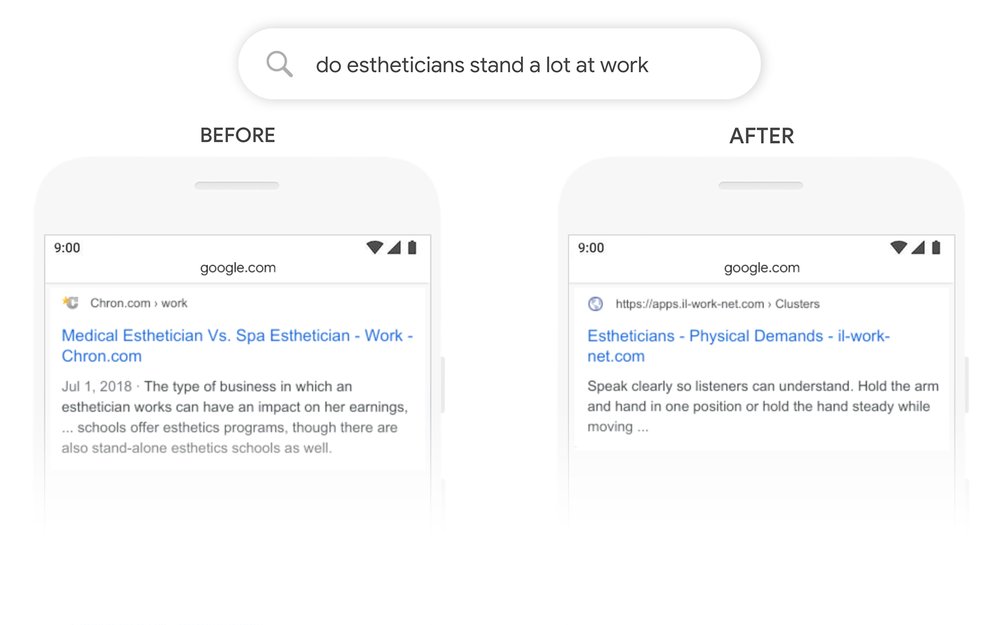

Пример эстетика

Во-первых, у нас есть пользователь, пытающийся понять, проводят ли косметологи много времени на ногах в рамках своей работы.

Ниже вы можете видеть, что до BERT Google прочитал запрос «много ли стоят на работе косметологи» и выдал результат, сравнивая типы рабочей среды для косметологов.

После BERT Google выдает статью о физических требованиях к косметологу, что гораздо больше соответствует информации, которую поисковик изначально пытался найти.

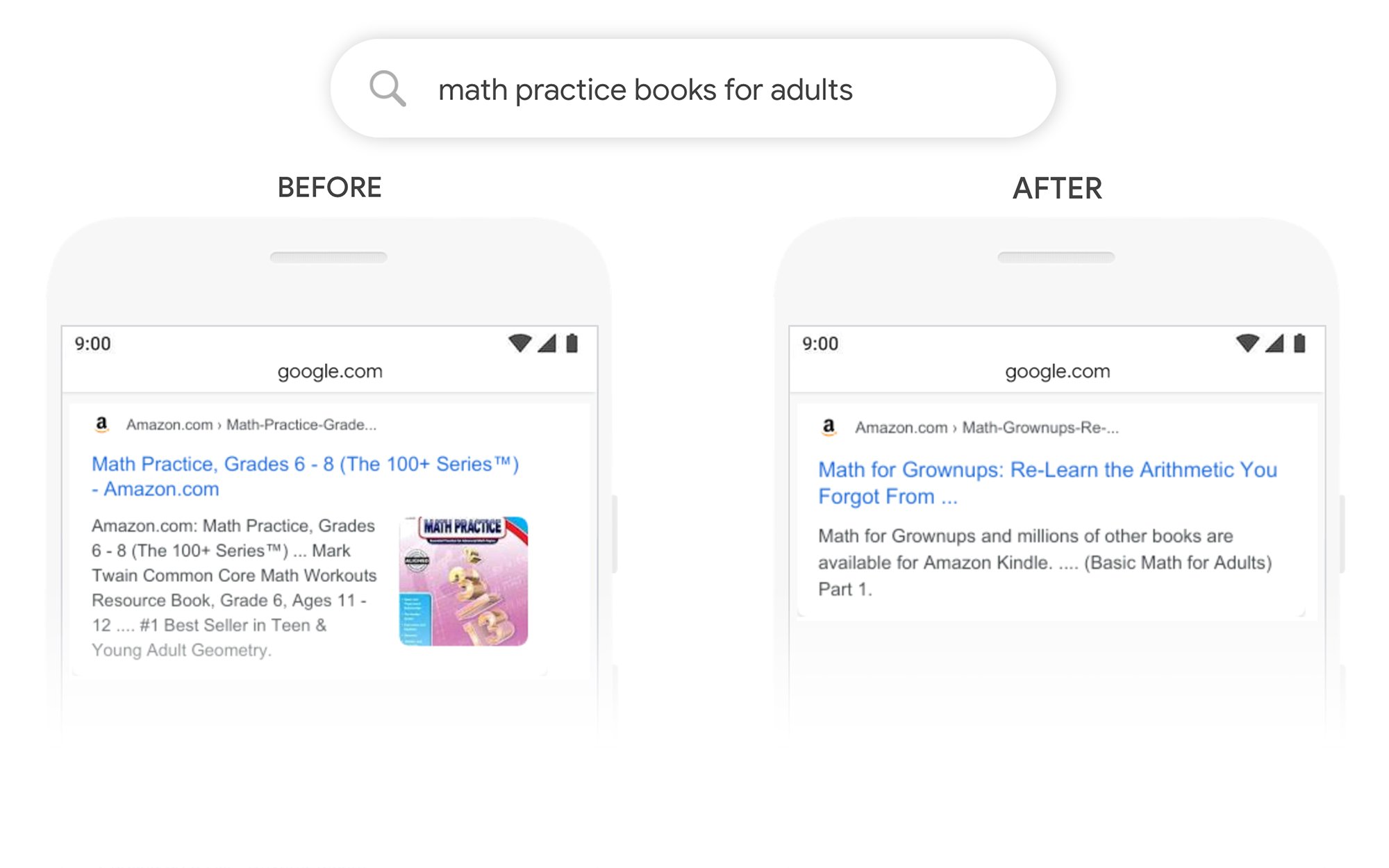

Пример учебников по математике

В этом примере пользователь ищет учебники по математике для взрослых, но находит учебники по математике для детей.

После BERT Google правильно распознает контекст запроса, лучше учитывая вторую часть поиска «для взрослых».

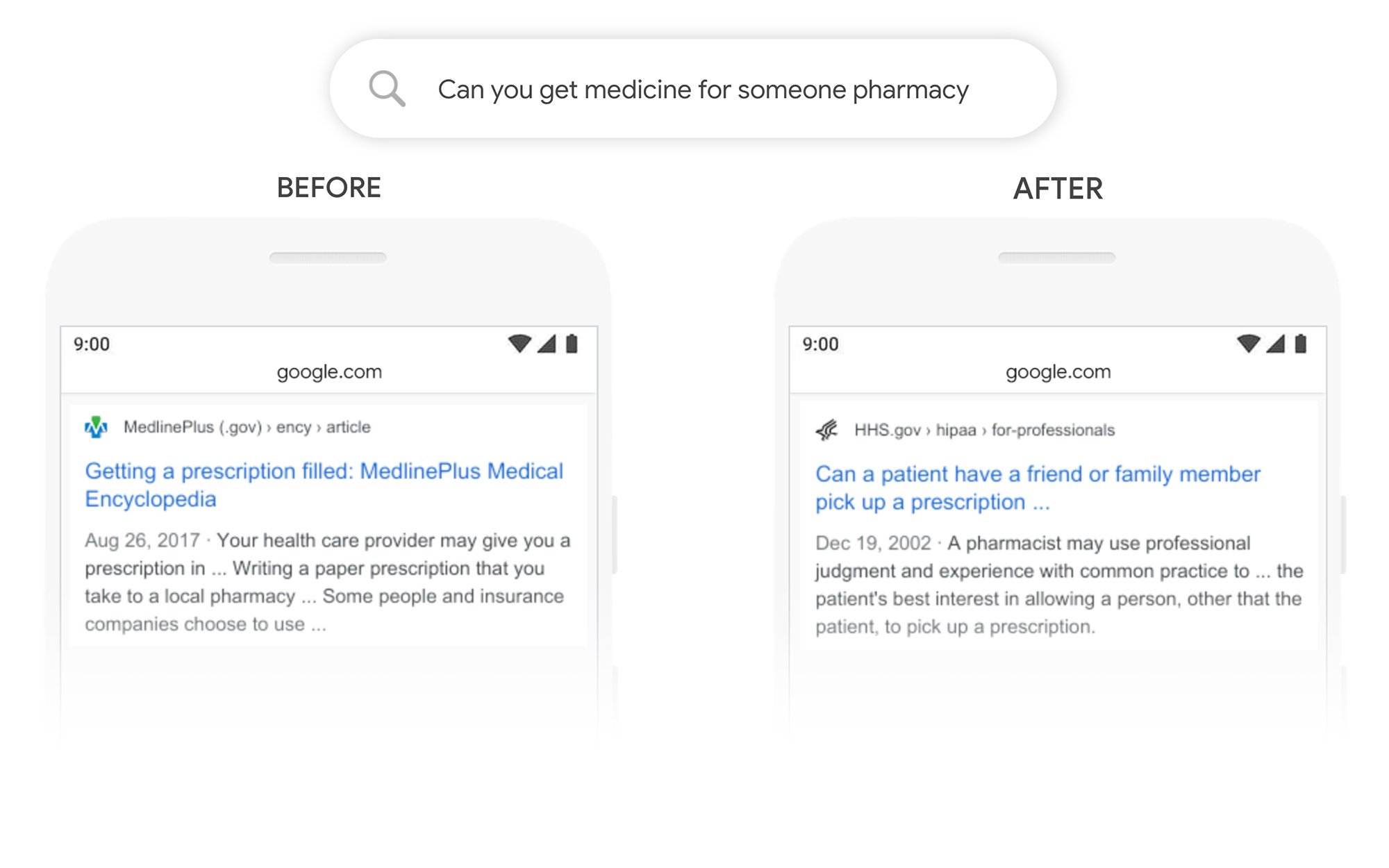

Пример «Можете ли вы подобрать лекарство для кого-то другого»

В этом примере запрос «можете ли вы получить лекарство для чьей-то аптеки» возвращает результат о том, как выписывать рецепты в целом, а не о том, как выписывать их для третьей стороны. После BERT Google лучше понимает цель пользователя и предлагает информацию о том, может ли пациент попросить друга или члена семьи забрать рецепт за него.

Что я могу сделать, чтобы получить более высокий рейтинг после BERT?

Для любых ключевых слов, по которым вы теряете рейтинг, вам следует взглянуть на пересмотренную страницу результатов поиска, чтобы лучше понять, как Google рассматривает намерение поиска ваших целевых терминов. Затем соответствующим образом измените свой контент, чтобы он лучше соответствовал целям пользователя.

Если вы потеряли рейтинг из-за BERT, скорее всего, проблема связана с тем, насколько хорошо ваша страница соответствует поисковому запросу пользователя (помогает пользователю достичь своей цели), а не с качеством контента.

Учитывая, что BERT, вероятно, со временем будет и дальше поддерживать усилия по голосовому поиску, мы также рекомендуем веб-сайтам писать четкие и краткие тексты. Не используйте язык-паразит, не говорите расплывчато, переходите прямо к делу.

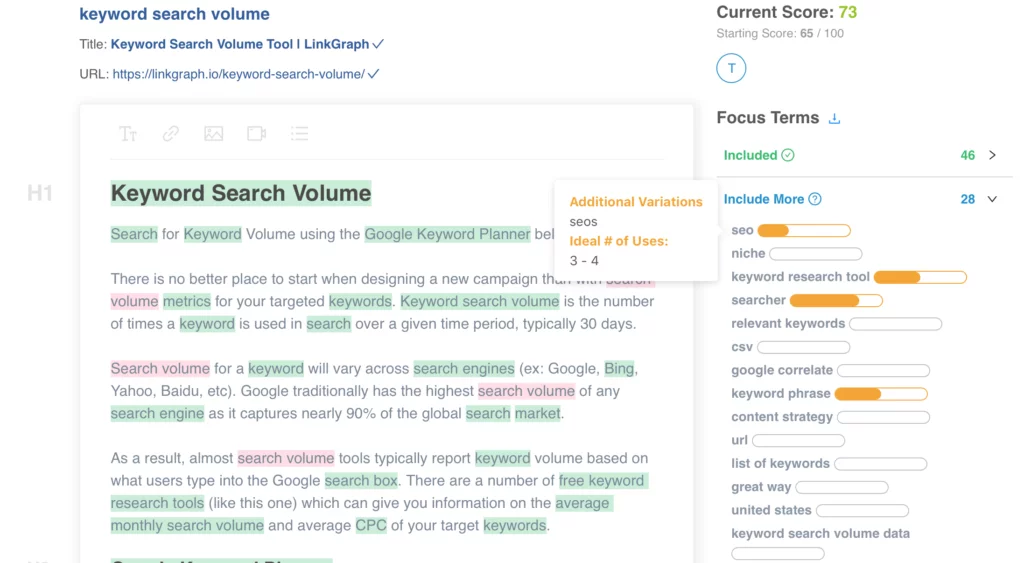

Нужна помощь в оптимизации вашего контента? Воспользуйтесь Оптимизатором содержимого страницы LinkGraph, свяжитесь с членом нашей команды по адресу [email protected] или запланируйте встречу, чтобы получить настройку уже сегодня.

Где я могу узнать больше?

Ранее в этом месяце в Pubcon Дон Андерсон провела отличную презентацию на тему «Google BERT, семья и гонка за лидерами в понимании естественного языка», и вы можете взглянуть на ее презентацию.

Спасибо за мой #Pubcon. Вот моя колода <3 <3 https://t.co/aGYDI9pfdY

— Дон Андерсон (@dawnieando) 10 октября 2019 г.

Джефф Дин также недавно выступил с основным докладом об искусственном интеллекте в Google, включая BERT, который вы можете посмотреть.