Что такое краулинговый бюджет и как его оптимизировать

Опубликовано: 2022-11-25

Краулинговый бюджет может показаться иностранной концепцией, когда вы впервые узнаете о том, как работают боты поисковых систем. Хотя это и не самая простая концепция SEO, они менее сложны, чем могут показаться. Как только вы начнете понимать, что такое краулинговый бюджет и как работает сканирование в поисковых системах, вы можете приступить к оптимизации своего веб-сайта, чтобы оптимизировать его для сканирования. Этот процесс поможет вашему сайту достичь максимального рейтинга в результатах поиска Google.

Что такое краулинговый бюджет?

Бюджет сканирования — это количество URL-адресов с одного веб-сайта, которые роботы поисковых систем могут проиндексировать за один сеанс индексации. «Бюджет» сеанса сканирования отличается от веб-сайта к веб-сайту в зависимости от размера каждого отдельного сайта, показателей трафика и скорости загрузки страницы.

Если вы зашли так далеко и термины SEO вам незнакомы, воспользуйтесь нашим глоссарием SEO, чтобы лучше ознакомиться с определениями .

Какие факторы влияют на бюджет сканирования веб-сайта?

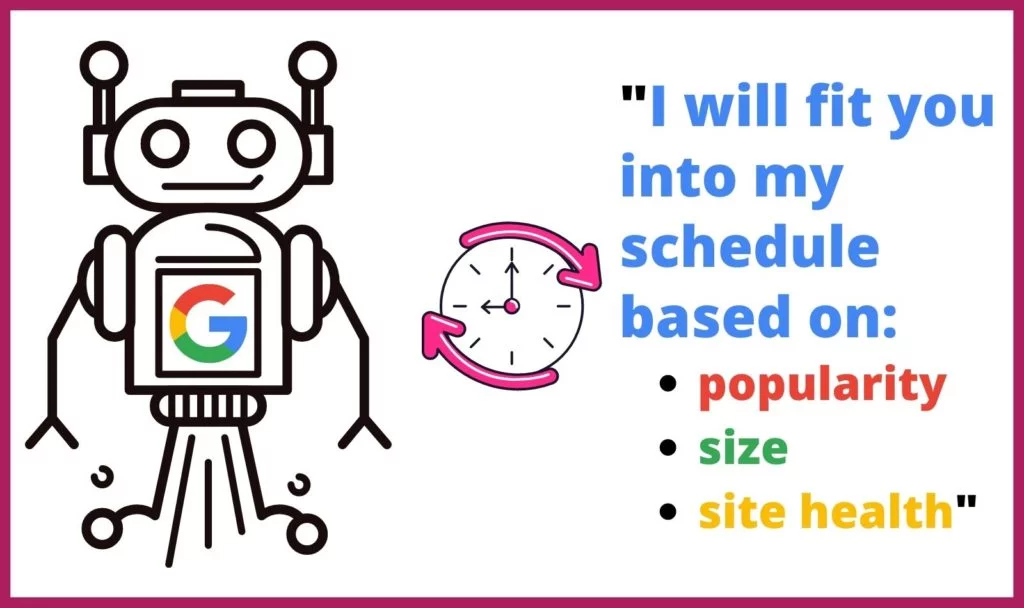

Google не уделяет одинаковое количество времени или количество сканирований каждому веб-сайту в Интернете. Веб-сканеры также определяют, какие страницы они сканируют и как часто, на основе нескольких факторов. Они определяют, как часто и как долго следует сканировать каждый сайт на основе:

Google не уделяет одинаковое количество времени или количество сканирований каждому веб-сайту в Интернете. Веб-сканеры также определяют, какие страницы они сканируют и как часто, на основе нескольких факторов. Они определяют, как часто и как долго следует сканировать каждый сайт на основе:

- Популярность: чем больше посещается сайт или страница, тем чаще ее следует анализировать на наличие обновлений. Кроме того, более популярные страницы будут быстрее накапливать больше внешних ссылок.

- Размер. Для сканирования больших веб-сайтов и страниц с большим объемом данных требуется больше времени.

- Состояние /проблемы: когда веб-краулер заходит в тупик через внутренние ссылки, ему требуется время, чтобы найти новую отправную точку, или он прекращает сканирование. Ошибки 404, редиректы и медленное время загрузки замедляют работу поисковых роботов и ставят их в тупик.

Как ваш краулинговый бюджет влияет на SEO?

Процесс индексации webcrawler делает возможным поиск. Если ваш контент не может быть найден, то поисковые роботы Google проиндексируют ваши веб-страницы и веб-сайт. Это приведет к тому, что ваш сайт потеряет много поискового трафика.

Почему Google сканирует веб-сайты?

Роботы Google систематически просматривают страницы веб-сайта, чтобы определить, о чем эта страница и весь веб-сайт. Веб-краулеры обрабатывают, классифицируют и систематизируют данные с этого веб-сайта постранично, чтобы создать кеш URL-адресов вместе с их содержимым, чтобы Google мог определить, какие результаты поиска должны отображаться в ответ на поисковый запрос.

Кроме того, Google использует эту информацию, чтобы определить, какие результаты поиска лучше всего соответствуют поисковому запросу, чтобы определить, где каждый результат поиска должен отображаться в иерархическом списке результатов поиска.

Что происходит во время сканирования?

Google отводит роботу Googlebot определенное время на обработку веб-сайта. Из-за этого ограничения бот, скорее всего, не будет сканировать весь сайт за один сеанс сканирования. Вместо этого он будет проходить через все страницы сайта на основе файла robots.txt и других факторов (таких как популярность страницы).

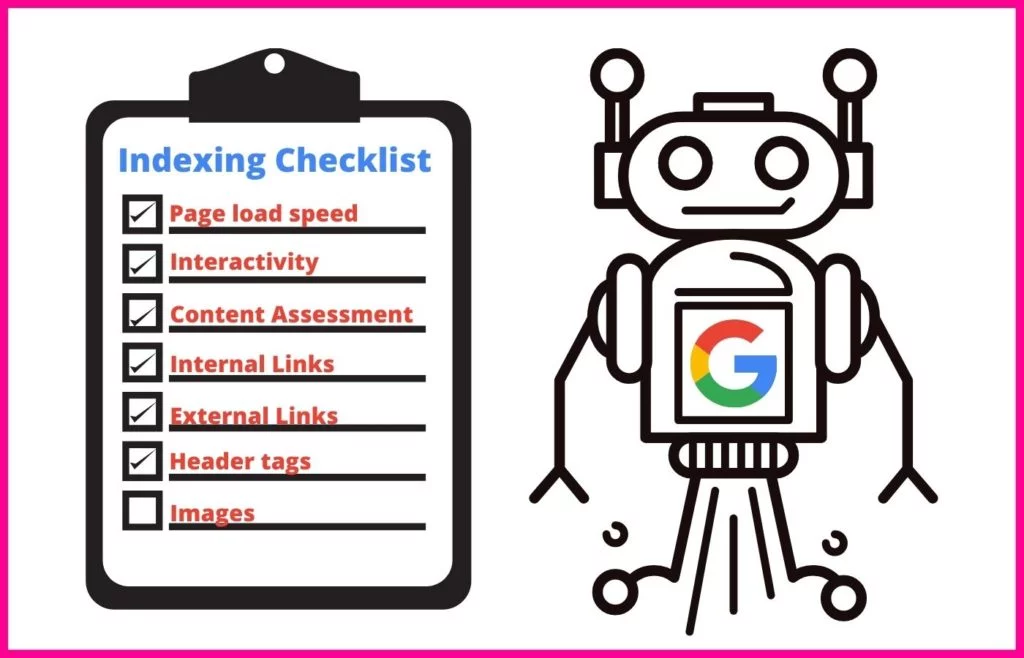

Во время сеанса сканирования робот Googlebot будет использовать систематический подход к пониманию содержания каждой страницы, которую он обрабатывает.

Это включает в себя индексирование определенных атрибутов, таких как:

- Метатеги и использование НЛП для определения их значения

- Ссылки и анкорный текст

- Мультимедийные файлы для поиска изображений и видео

- Разметка схемы

- HTML-разметка

Поисковый робот также выполнит проверку, чтобы определить, является ли содержимое страницы дубликатом канонического. Если это так, Google переместит URL-адрес в режим сканирования с низким приоритетом, чтобы не тратить время на сканирование страницы так часто.

Что такое скорость сканирования и спрос на сканирование?

Поисковые роботы Google выделяют определенное время для каждого сканирования, которое они выполняют. Как владелец веб-сайта, вы не можете контролировать это количество времени. Однако вы можете изменить скорость сканирования отдельных страниц вашего сайта, пока они находятся на вашем сайте. Это число называется скоростью сканирования .

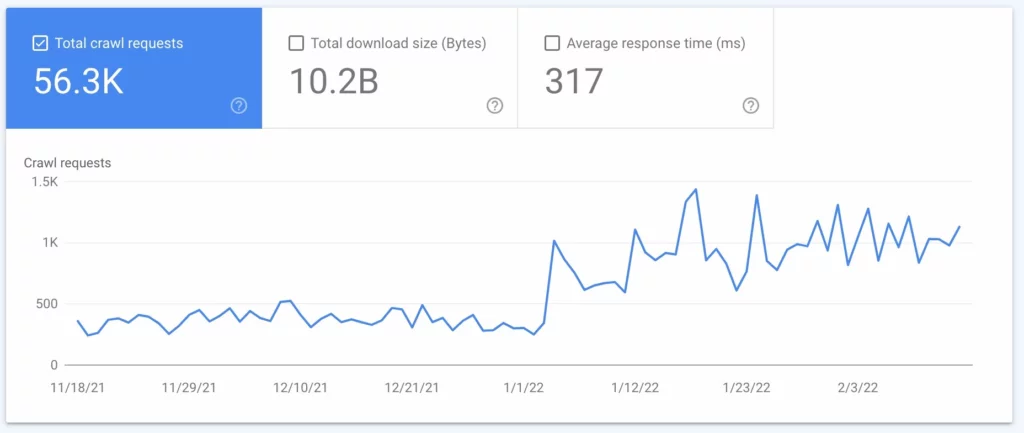

Спрос на сканирование — это частота сканирования вашего сайта Google. Эта частота основана на спросе на ваш сайт со стороны пользователей Интернета и на том, как часто контент вашего сайта должен обновляться при поиске. Вы можете узнать, как часто Google сканирует ваш сайт, используя анализ файла журнала (см. № 2 ниже).

Как определить бюджет сканирования моего сайта?

Поскольку Google ограничивает количество обходов вашего сайта и продолжительность сканирования, вы хотите знать, каков ваш краулинговый бюджет. Однако Google не предоставляет владельцам сайтов эти данные, особенно если ваш бюджет настолько мал, что новый контент не попадает в поисковую выдачу своевременно. Это может иметь катастрофические последствия для важного контента и новых страниц, таких как страницы продуктов, которые могут принести вам деньги.

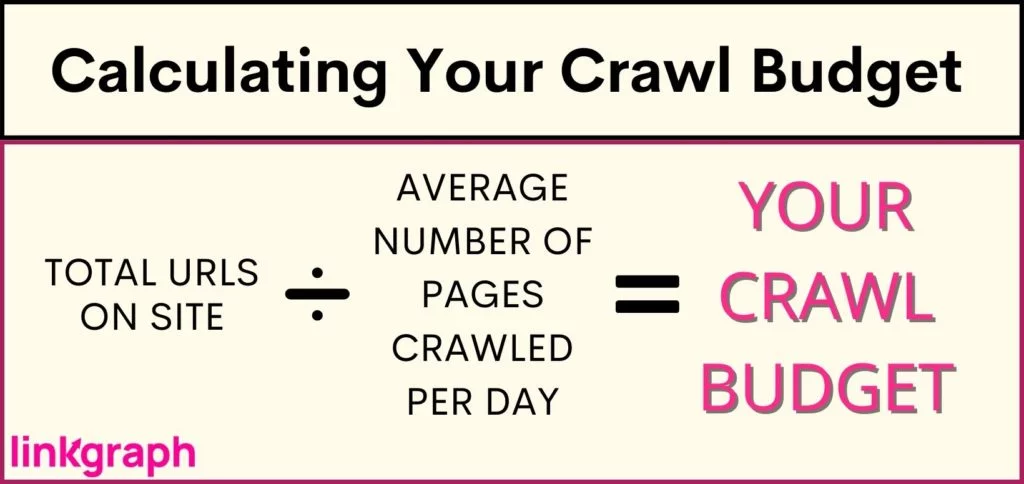

Чтобы понять, сталкивается ли ваш сайт с ограничениями краулингового бюджета (или убедиться, что с вашим сайтом все в порядке), вам необходимо: Проведите инвентаризацию количества URL-адресов на вашем сайте. Если вы используете Yoast, общая сумма будет указана в верхней части URL-адреса вашей карты сайта .

Как вы можете оптимизировать свой краулинговый бюджет?

Когда придет время, когда ваш сайт станет слишком большим для краулингового бюджета, вам нужно погрузиться в оптимизацию краулингового бюджета. Поскольку вы не можете заставить Google сканировать ваш сайт чаще или дольше, вы должны сосредоточиться на том, что вы можете контролировать.

Оптимизация краулингового бюджета требует комплексного подхода и понимания лучших практик Google . С чего начать, чтобы максимально эффективно использовать скорость сканирования? Этот исчерпывающий список написан в иерархическом порядке, поэтому начните сверху.

1. Подумайте об увеличении лимита скорости сканирования вашего сайта

Google отправляет запросы одновременно на несколько страниц вашего сайта. Тем не менее, Google старается быть вежливым и не перегружать ваш сервер, что приводит к замедлению загрузки вашего сайта посетителями. Если вы заметили, что ваш сайт зависает из ниоткуда, это может быть проблемой.

Чтобы не влиять на работу ваших пользователей, Google позволяет снизить скорость сканирования. Это ограничит количество страниц, которые Google может индексировать одновременно.

Интересно, однако, что Google также позволяет вам увеличить ограничение скорости сканирования — в результате они могут открывать больше страниц одновременно, что приводит к одновременному сканированию большего количества URL-адресов. Тем не менее, все отчеты показывают, что Google медленно реагирует на увеличение лимита скорости сканирования, и это не гарантирует, что Google будет сканировать больше сайтов одновременно.

Как увеличить предел скорости сканирования:

- В Search Console перейдите в «Настройки».

- Оттуда вы можете увидеть, является ли ваша скорость сканирования оптимальной или нет.

- Затем вы можете увеличить лимит до более быстрого сканирования на 90 дней.

2. Выполните анализ файла журнала

Анализ файла журнала — это отчет с сервера, отражающий каждый запрос, отправленный на сервер. Этот отчет расскажет вам, что именно роботы Google делают на вашем сайте. Хотя этот процесс часто выполняется техническими SEO-специалистами, вы можете поговорить с администратором своего сервера, чтобы получить его.

Используя анализ файла журнала или файл журнала сервера, вы узнаете:

- Как часто Google сканирует ваш сайт

- Какие страницы сканируются чаще всего

- Какие страницы имеют не отвечающий или отсутствующий код сервера

Получив эту информацию, вы можете использовать ее для выполнения пунктов с 3 по 7.

3. Обновляйте свою XML-карту сайта и файл robots.txt

Если ваш файл журнала показывает, что Google тратит слишком много времени на сканирование страниц, которые вы не хотите отображать в поисковой выдаче, вы можете потребовать, чтобы сканеры Google пропустили эти страницы. Это высвобождает часть краулингового бюджета для более важных страниц.

Ваша карта сайта (которую вы можете получить из Google Search Console или SearchAtlas ) предоставляет роботам Googlebot список всех страниц вашего сайта, которые вы хотите проиндексировать в Google, чтобы они могли отображаться в результатах поиска. Обновление вашей карты сайта со всеми веб-страницами, которые вы хотите, чтобы поисковые системы находили, и исключение тех, которые вы не хотите, чтобы они находили, может максимизировать то, как веб-сканеры проводят свое время на вашем сайте.

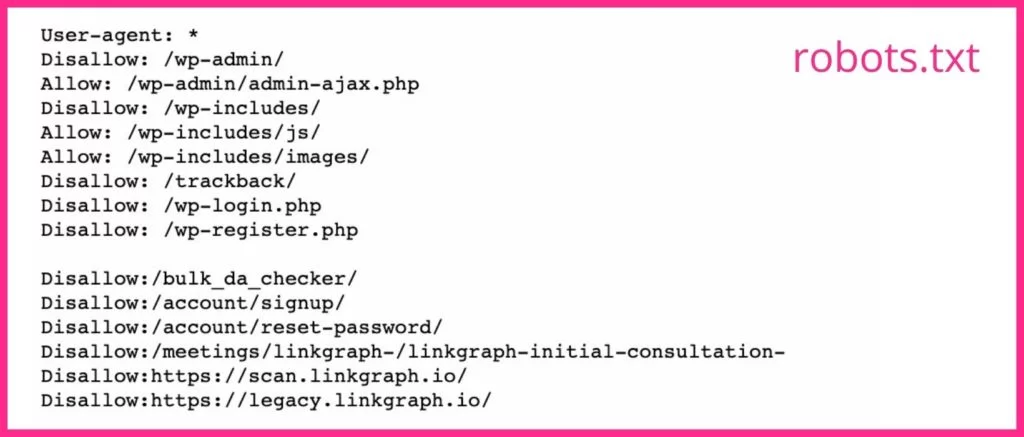

Ваш файл robots.txt сообщает поисковым роботам, какие страницы вы хотите и не хотите, чтобы они сканировали. Если у вас есть страницы, которые не являются хорошими целевыми страницами, или страницы с закрытыми страницами, вам следует использовать тег noindex для их URL-адресов в файле robots.txt. Googlebot, скорее всего, пропустит любую веб-страницу с тегом noindex.

4. Уменьшите количество перенаправлений и цепочек перенаправлений

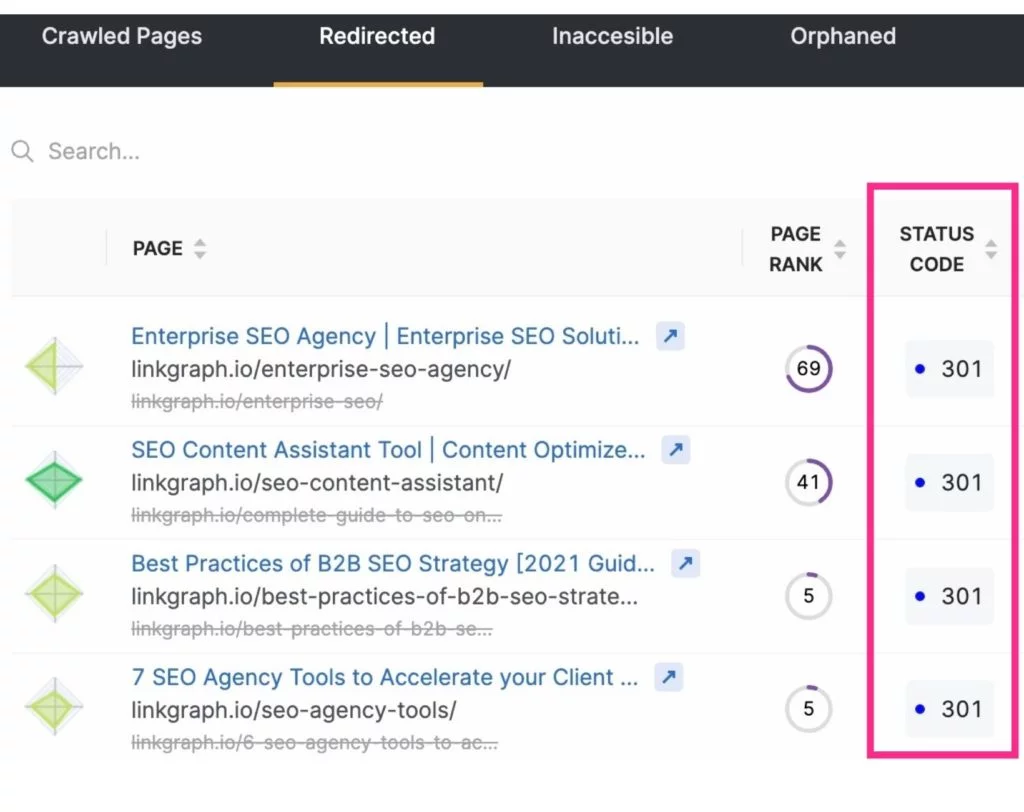

Помимо высвобождения краулингового бюджета за счет исключения ненужных страниц из сканирования поисковыми системами, вы также можете максимизировать сканирование, уменьшив или устранив перенаправления. Это будут любые URL-адреса, которые приводят к коду состояния 3xx.

Для извлечения перенаправленных URL-адресов роботу Googlebot требуется больше времени, поскольку сервер должен ответить перенаправлением, а затем получить новую страницу. Хотя одно перенаправление занимает всего несколько миллисекунд, они могут складываться. И это может увеличить общее время сканирования вашего сайта. Это время умножается, когда робот Googlebot сталкивается с цепочкой переадресаций URL.

Чтобы уменьшить количество редиректов и цепочек редиректов, помните о своей стратегии создания контента и тщательно выбирайте текст для своих слагов.

5. Исправьте неработающие ссылки

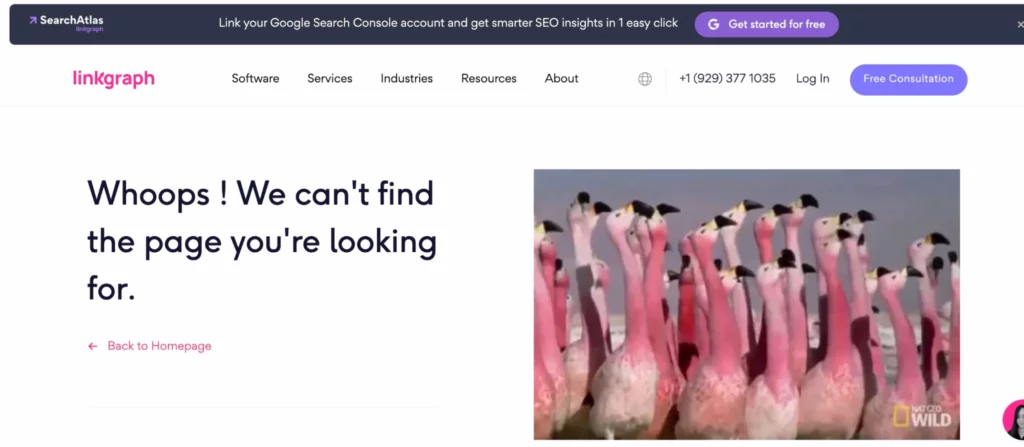

Google часто исследует сайт, перемещаясь по вашей внутренней структуре ссылок. Проходя через ваши страницы, он заметит, ведет ли ссылка на несуществующую страницу (это часто называют программной ошибкой 404). Затем он будет двигаться дальше, не желая тратить время на индексацию указанной страницы.

Ссылки на эти страницы необходимо обновить, чтобы пользователь или робот Googlebot перешли на настоящую страницу. ИЛИ (хотя в это трудно поверить), робот Googlebot мог ошибочно идентифицировать страницу как ошибку 4xx или 404, хотя страница действительно существует. Когда это произойдет, убедитесь, что в URL-адресе нет опечаток, а затем отправьте запрос на сканирование этого URL-адреса через свою учетную запись Google Search Console.

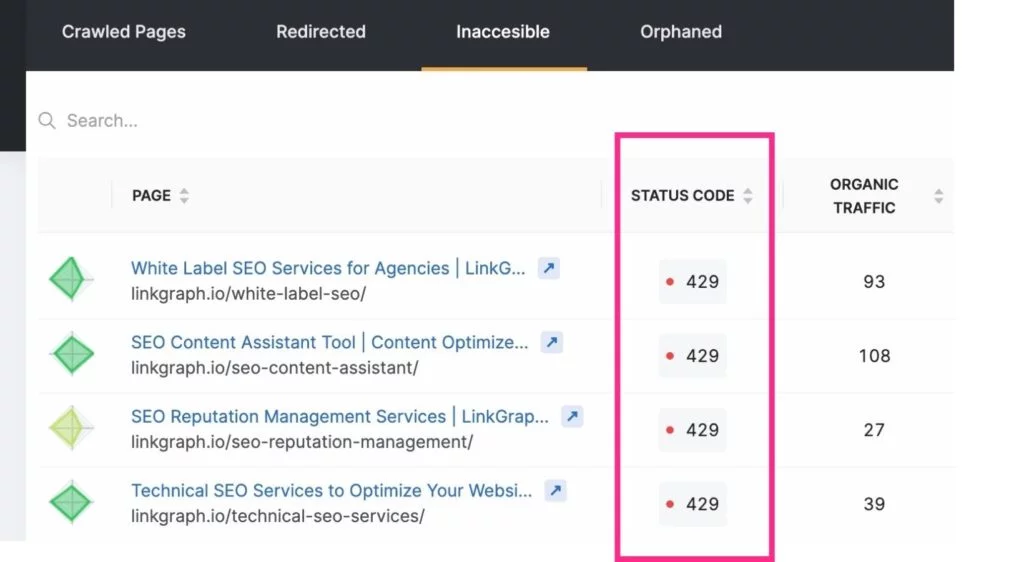

Чтобы быть в курсе этих ошибок сканирования, вы можете использовать отчет Index > Coverage вашей учетной записи Google Search Console. Или используйте инструмент аудита сайта SearchAtlas , чтобы найти отчет об ошибках сайта и передать его веб-разработчику.

Примечание. Новые URL-адреса могут не сразу появиться в анализе файла журнала. Дайте Google некоторое время, чтобы найти их, прежде чем запрашивать сканирование.

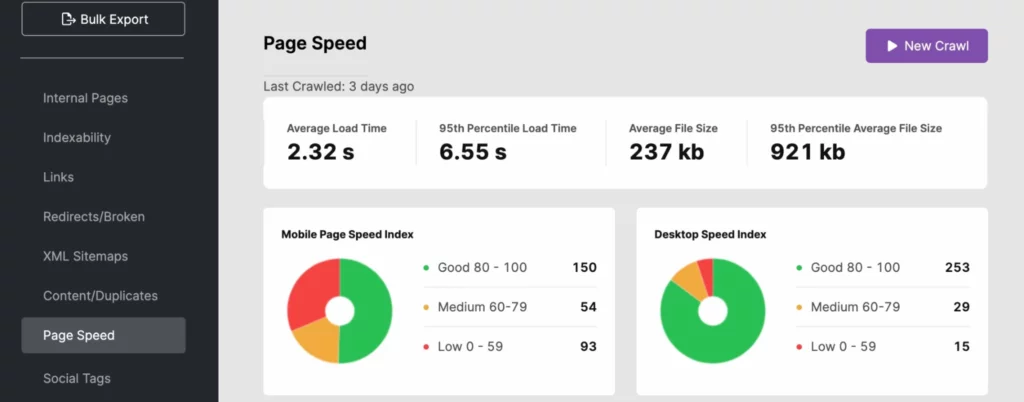

6. Работайте над улучшением скорости загрузки страниц

Боты поисковых систем могут быстро перемещаться по сайту. Однако, если скорость вашего сайта не на должном уровне, это может серьезно сказаться на вашем краулинговом бюджете. Используйте Анализ файла журнала, SearchAtlas или PageSpeedInsights, чтобы определить, влияет ли время загрузки вашего сайта на видимость вашего сайта в поиске.

Чтобы сократить время отклика вашего сайта, используйте динамические URL-адреса и следуйте рекомендациям Google Core Web Vitals . Это может включать оптимизацию изображения для медиа в верхней части сгиба.

Если проблема со скоростью сайта возникает на стороне сервера, вы можете инвестировать в другие ресурсы сервера, такие как:

- Выделенный сервер (особенно для крупных сайтов)

- Переход на более новое серверное оборудование

- Увеличение оперативной памяти

Эти улучшения также повысят удобство работы пользователей, что может помочь вашему сайту работать лучше в поиске Google, поскольку скорость сайта является сигналом для PageRank.

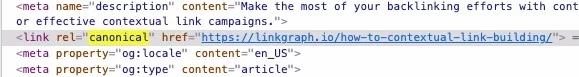

7. Не забывайте использовать канонические теги

Дублированный контент не одобряется Google — по крайней мере, если вы не признаете, что дублированный контент имеет исходную страницу. Почему? Робот Googlebot сканирует каждую страницу, за исключением случаев, когда это неизбежно, если не указано иное. Однако, когда он сталкивается с дубликатом страницы или копией чего-то знакомого (на вашей странице или за пределами сайта), он прекращает сканирование этой страницы. И хотя это экономит время, вы должны сэкономить время сканеру еще больше, используя канонический тег, который идентифицирует канонический URL-адрес.

Canonicals сообщают роботу Googlebot, что не нужно использовать период сканирования для индексации этого контента. Это дает роботу поисковой системы больше времени для изучения других ваших страниц.

8. Сосредоточьтесь на внутренней структуре ссылок

Наличие хорошо структурированной практики ссылок на вашем сайте может повысить эффективность сканирования Google. Внутренние ссылки сообщают Google, какие страницы на вашем сайте являются наиболее важными, и эти ссылки помогают поисковым роботам легче находить страницы.

Лучшие структуры ссылок связывают пользователей и роботов Google с контентом на вашем веб-сайте. Всегда используйте релевантный анкорный текст и естественным образом размещайте ссылки в своем контенте.

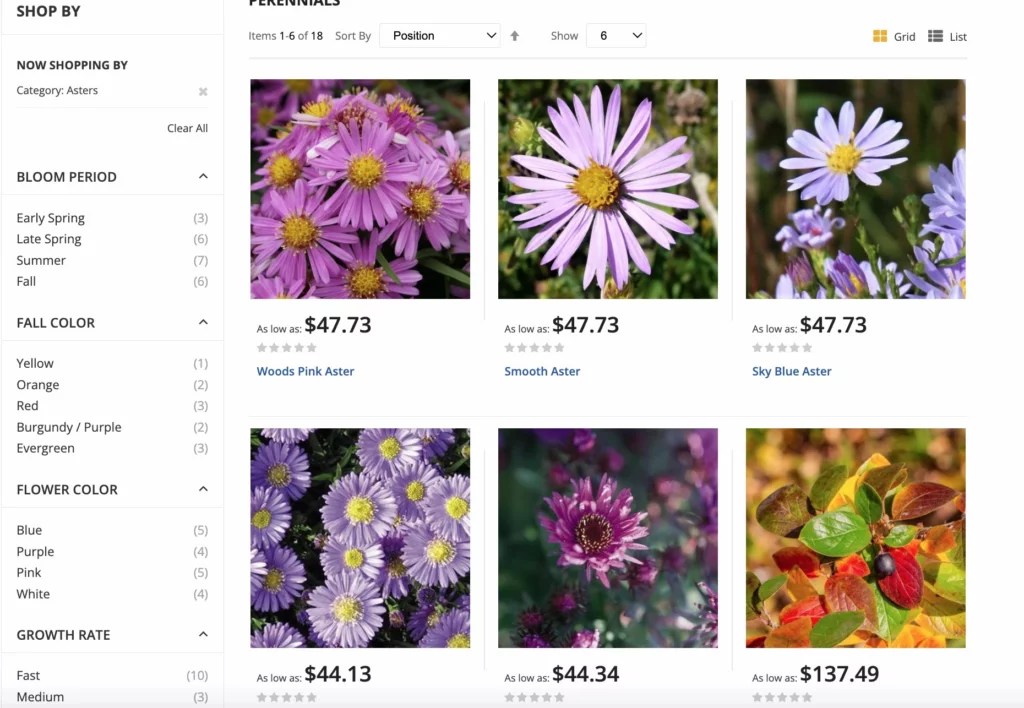

Для сайтов электронной коммерции у Google есть передовые методы многогранной навигации для максимального сканирования. Многогранная навигация позволяет пользователям сайта фильтровать товары по атрибутам, делая покупки более удобными. Это обновление помогает избежать канонической путаницы и проблем с дублированием в дополнение к избыточному сканированию URL-адресов.

9. Сократите ненужный контент

Роботы Google могут перемещаться с определенной скоростью и индексировать определенное количество страниц каждый раз, когда они сканируют сайт. Если у вас большое количество страниц, которые не получают трафика или имеют устаревший или некачественный контент – сократите их! Процесс обрезки позволяет вам избавиться от лишнего багажа вашего сайта, который может отягощать его.

Наличие избыточных страниц на вашем сайте может перенаправить роботов Googlebot на второстепенные страницы, игнорируя при этом страницы.

Просто не забудьте перенаправить любые ссылки на эти страницы, чтобы не столкнуться с ошибками сканирования.

10. Получите больше обратных ссылок

Как только роботы Googlebot прибывают на ваш сайт и начинают индексировать страницы на основе внутренних ссылок, они также используют внешние ссылки в процессе индексации. Если другие сайты ссылаются на ваш, робот Googlebot перейдет на ваш сайт и проиндексирует страницы, чтобы лучше понять содержание, на которое ссылаются.

Кроме того, обратные ссылки придают вашему сайту немного большую популярность и новизну, что Google использует для определения того, как часто ваш сайт должен быть проиндексирован.

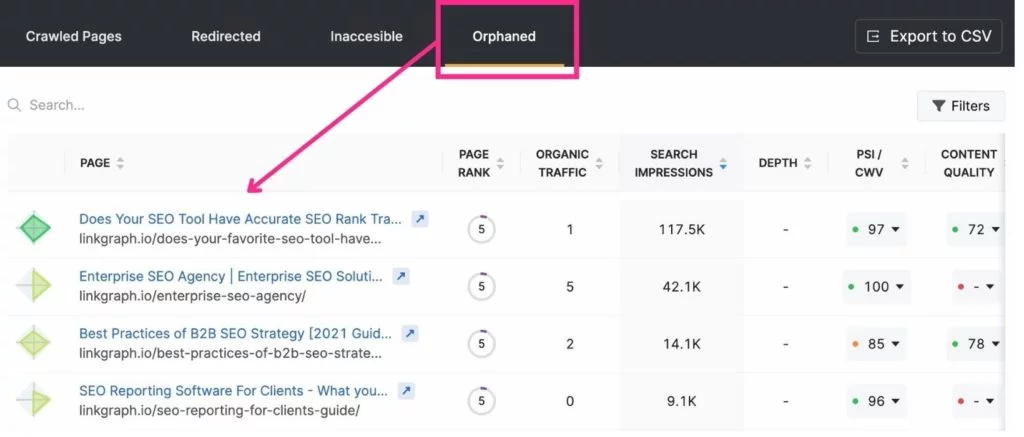

11. Удалите страницы-сироты

Поскольку поисковый робот Google переходит со страницы на страницу по внутренним ссылкам, он может легко найти страницы, на которые есть ссылки. Однако страницы, на которые нет ссылок где-либо на вашем сайте, часто остаются незамеченными Google. Их называют «страницами-сиротами».

Когда это страница-сирота уместна? Если это целевая страница, которая имеет очень конкретную цель или аудиторию. Например, если вы отправляете электронное письмо игрокам в гольф, которые живут в Майами, с целевой страницей, которая относится только к ним, вы можете не захотеть ссылаться на другую страницу.

Лучшие инструменты для оптимизации краулингового бюджета

Search Console и Google Analytics могут оказаться весьма полезными, когда дело доходит до оптимизации краулингового бюджета. Search Console позволяет запрашивать у сканера индексацию страниц и отслеживать статистику сканирования. Google Analytics помогает отслеживать путь внутренних ссылок.

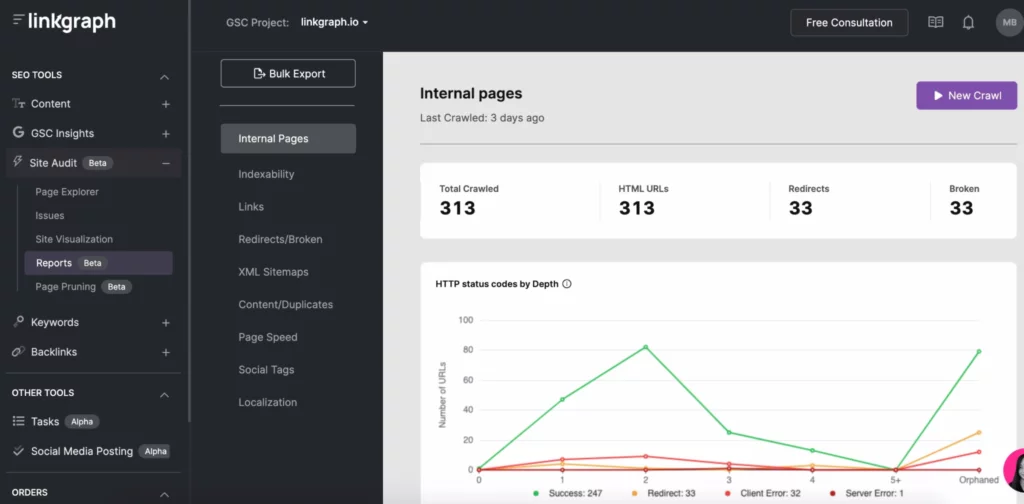

Другие инструменты SEO, такие как SearchAtlas, позволяют легко находить проблемы со сканированием с помощью инструментов аудита сайта. С помощью одного отчета вы можете увидеть:

- Отчет о сканировании индексируемости

- Глубина индекса

- Скорость страницы

- Дублированный контент

- XML-карта сайта

- Ссылки

Оптимизируйте свой краулинговый бюджет и станьте лидером поисковой системы

Хотя вы не можете контролировать, как часто поисковые системы индексируют ваш сайт и как долго, вы можете оптимизировать свой сайт, чтобы максимально эффективно использовать каждое сканирование поисковыми системами. Начните с журналов вашего сервера и внимательно изучите отчет о сканировании в Search Console. Затем погрузитесь в исправление любых ошибок сканирования, вашей структуры ссылок и проблем со скоростью страницы.

Работая со сканированием GSC, сосредоточьтесь на остальной части своей стратегии SEO, включая построение ссылок и добавление качественного контента . Со временем вы обнаружите, что ваши целевые страницы поднимаются на страницы результатов поисковой системы.