Как оптимизировать бюджет сканирования и повысить рейтинг?

Опубликовано: 2017-01-14Оглавление

- 1 Что такое краулинговый бюджет?

- 2 Почему краулинговый бюджет имеет значение?

- 3 Когда краулинговый бюджет становится проблемой?

- 4 Как оптимизировать бюджет сканирования

- 5 1. Улучшить структуру сайта

- 6 2. Устранение неработающих ссылок

- 7 3. Аккуратно используйте мультимедийный контент

- 8 4.Очистить карту сайта

- 9 5. Создавайте внешние ссылки

- 10 6. Организуйте внутреннюю перелинковку

- 11 7. Используйте фиды

- 12 8. Удалить цепочки перенаправления

- 13 9. Убедитесь, что ваши страницы доступны для сканирования

Все знают, что такое поисковая оптимизация и важность хорошо структурированного сайта, релевантных ключевых слов, качественного контента, правильных тегов, чистой карты сайта и других технических стандартов. Но есть вероятность, что вы не подумали об оптимизации сканирования.

Оптимизация краулингового бюджета — это нечто более глубокое, чем поисковая оптимизация. В то время как поисковая оптимизация больше сосредоточена на процессе оптимизации пользовательских запросов, оптимизация сканирования сосредоточена на том, как боты поисковых систем (веб-пауки) получают доступ к вашему сайту.

В этой статье мы рассмотрим механизмы, лежащие в основе того, как поисковые системы назначают краулинговые бюджеты для веб-сайтов, а также советы, которые помогут вам максимально эффективно использовать краулинговый бюджет для максимизации рейтинга, органического трафика и, что наиболее важно, индексации.

Что такое краулинговый бюджет?

Бюджет сканирования — это просто количество страниц, которые поисковый робот просканирует ваш сайт за определенный период времени. Бюджет сканирования обычно определяется размером и состоянием вашего сайта, а также количеством ссылок, указывающих на ваш сайт.

Краулинговый бюджет — важный фактор SEO, которому часто не уделяется должного внимания. Поисковые системы используют роботов-пауков для сканирования веб-страниц, сбора информации и добавления их в свой индекс. Кроме того, они также указывают ссылки на посещаемых ими страницах и пытаются сканировать и эти новые страницы.

Например, Googlebot — это веб-паук, который обнаруживает новые страницы и добавляет их в индекс Google. Большинство веб-сервисов и инструментов SEO доверяют этим веб-паукам сбор полезной информации.

Почему краулинговый бюджет имеет значение?

Сканируемость веб-сайта является основным и важным шагом для обеспечения его доступности для поиска. Если вам интересно, важна ли оптимизация краулингового бюджета для вашего веб-сайта, ответ, конечно же, ДА. Ваши усилия по SEO и оптимизации сканирования, вероятно, будут идти рука об руку.

Как бы это ни было просто, вполне логично, что вы должны беспокоиться о краулинговом бюджете, потому что Google облегчает поиск и индексацию вашего веб-сайта. Если на вашем веб-сайте больше обходов, это означает, что вы будете получать более быстрые обновления при публикации нового контента. Таким образом, чем больше ваш краулинговый бюджет, тем быстрее это произойдет.

Это также поможет вам улучшить общее взаимодействие с пользователем на вашем веб-сайте, что улучшит видимость и, в конечном итоге, приведет к повышению рейтинга в поисковой выдаче. Дело в том, что страницы, которые недавно сканировались, становятся более заметными в поисковой выдаче, и если страница не сканировалась какое-то время, она не будет хорошо ранжироваться.

Когда краулинговый бюджет является проблемой?

Дело не в том, что краулинговый бюджет часто создает проблемы. Если вы выделили пропорциональное сканирование для URL-адресов вашего веб-сайта, это не проблема. Но допустим, ваш веб-сайт имеет 200 000 URL-адресов, а Google сканирует только 2000 страниц в день на вашем сайте, тогда Google может потребоваться 100 дней, чтобы определить или обновить URL-адреса — теперь это проблема.

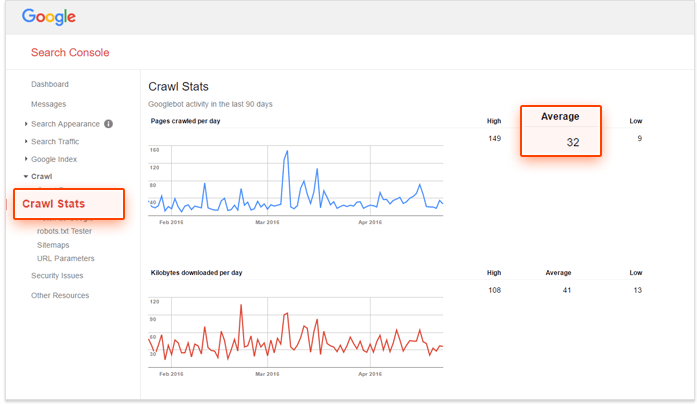

Если вы ищете решение и хотите проверить, нуждается ли ваш краулинговый бюджет в оптимизации, используйте консоль поиска Google и количество URL-адресов на вашем сайте, чтобы рассчитать «число сканирования» вашего веб-сайта. Как это сделать?

— Во-первых, вам нужно оценить, сколько страниц на вашем сайте, вы можете сделать это, выполнив сайт: поиск в Google,

– Во-вторых, перейдите в свою учетную запись Google Search Console и выберите «Сканирование», а затем «Статистика сканирования». Если ваша учетная запись настроена неправильно, вы не получите эти данные.

— Третий шаг — разделить общее количество страниц на вашем сайте на среднее количество сканируемых страниц в день на вашем сайте.

Если это число больше 10, вам нужно подумать об оптимизации краулингового бюджета. Если меньше 5, браво! Вам не нужно читать дальше.

Как оптимизировать краулинговый бюджет

1. Улучшить структуру сайта

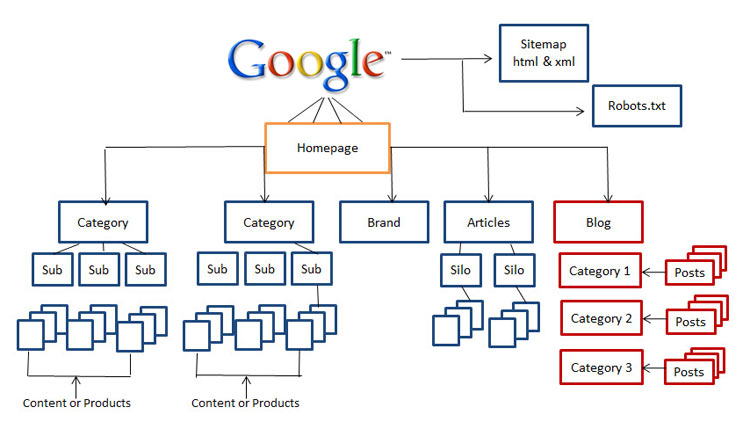

Сегодня важность структуры сайта является решающим фактором. Мастера SEO, такие как Рэнд Фишкин, советуют следить за тем, чтобы пользователи вашего сайта находились не более чем в трех кликах от главной страницы во время их посещения. Это действительно отличный совет для SEO-специалистов с точки зрения удобства использования, поскольку ваши посетители вряд ли будут углубляться в ваш сайт.

Итак, если у вас нет чистого, удобного для навигации и удобного для поисковых систем веб-сайта, пришло время начать реструктуризацию вашего веб-сайта.

2. Устранение неработающих ссылок

Это одно из основных различий между поисковой оптимизацией и оптимизацией сканирования. Неработающие ссылки не только играют существенную роль в снижении вашего рейтинга, но и сильно мешают роботу Googlebot индексировать и ранжировать ваш веб-сайт.

Алгоритм Google значительно улучшился за эти годы, и все, что влияет на пользовательский опыт, может повлиять на поисковую выдачу. Google всегда пытался копировать поведение пользователей и обновлять алгоритмы. Поэтому мы всегда должны учитывать пользовательский опыт, когда оптимизируем веб-сайты для поисковых систем.

3. Аккуратно используйте мультимедийный контент

Сегодня Google изо всех сил пытается сканировать Silverlight и только некоторые другие файлы, но были времена, когда Google не мог сканировать мультимедийный контент, такой как flash, javascript и HTML.

Однако, хотя Google может читать большинство ваших мультимедийных файлов, есть и другие поисковые системы, которые не могут этого сделать. Это означает, что вы должны использовать эти файлы с умом, а иногда вы можете полностью избегать их на страницах, которые вы хотите ранжировать.

4. Очистить карту сайта

Приложите некоторые усилия, чтобы очистить свою карту сайта и поддерживать ее в актуальном состоянии, чтобы защититься от беспорядка, который может повредить удобству использования вашего веб-сайта, включая заблокированные страницы, неканонические страницы, ненужные перенаправления и страницы уровня 400. Использование XML-карт сайта — лучший способ помочь вашим пользователям, а также роботам-паукам.

На рынке есть различные инструменты для очистки вашей карты сайта. Вы можете использовать генератор XML-карты сайта, чтобы создать чистую карту сайта, которая исключает все страницы, заблокированные из индексации, находить и исправлять такие вещи, как перенаправления 301 и 302 и неканонические страницы.

5. Создавайте внешние ссылки

Линкбилдинг — актуальная тема, которая не исчезнет в ближайшем будущем. Открытие новых сообществ, установление отношений в Интернете и повышение ценности бренда — вот некоторые из преимуществ, которые вы уже должны иметь в процессе построения ссылок.

Когда это делается с использованием лучших практик, внешние ссылки — это ссылки, которые указывают на внешний домен и являются наиболее важным источником получения более высокого рейтинга. Хотя внешние ссылки являются самыми сложными для манипулирования показателями, они являются отличным способом для поисковых систем узнать популярность и релевантность веб-страницы.

6. Организуйте внутреннюю перелинковку

Хотя построение внутренних ссылок не имеет ничего общего с оптимизацией краулингового бюджета, это не значит, что вы можете его игнорировать. Хорошо организованная и поддерживаемая структура сайта помогает вашему контенту легко просматриваться пользователями, а также роботами-пауками, не тратя при этом достаточного бюджета сканирования.

Хорошо структурированная система внутренних ссылок также повышает удобство работы пользователей. Помогая пользователям добраться до любой области с помощью нескольких кликов и делая вещи легкодоступными, как правило, посетители дольше остаются на вашем веб-сайте, что улучшит ваш рейтинг в поисковой выдаче.

7. Используйте фиды

Различные каналы, такие как RSS, Atom и XML, помогают вашему сайту доставлять контент пользователям, даже когда они не просматривают ваш сайт. Это лучший способ для пользователей подписаться на самые популярные сайты и получать регулярные обновления всякий раз, когда публикуется новый контент.

Уже давно доказано, что RSS-каналы являются хорошим способом повысить читательскую аудиторию и вовлеченность вашего веб-сайта. Кроме того, они также являются одними из самых посещаемых сайтов веб-пауками Google. Когда на вашем веб-сайте появится обновление, вы можете отправить его в Google Feed Burner, чтобы убедиться, что оно правильно проиндексировано.

8. Удалить цепочки переадресации

Каждый URL-адрес, на который вы перенаправляетесь, будет тратить немного вашего краулингового бюджета. Когда на вашем веб-сайте используются длинные цепочки перенаправлений, что означает наличие большого количества переадресаций 301 и 302 подряд, веб-пауки могут отключиться, прежде чем они достигнут целевой страницы, и в конечном итоге ваша страница не будет проиндексирована. Если вы ищете лучший способ перенаправления, лучше иметь как можно меньше перенаправлений на вашем веб-сайте и не более двух подряд.

9. Убедитесь, что ваши страницы доступны для сканирования

Если роботы-пауки поисковых систем могут находить ваши веб-страницы, находить и переходить по ссылкам на вашем веб-сайте, то они доступны для сканирования. Итак, вам нужно настроить файлы robots.txt и .htaccess так, чтобы они не блокировали важные страницы вашего сайта.

Вам также может потребоваться предоставить текстовые файлы страниц, которые содержат мультимедийный контент, такой как flash, silverlight и т. д.

Только запрещая в robots.txt, вы не можете гарантировать, что страница не будет деиндексирована. Если есть внешние факторы, такие как входящие ссылки, которые продолжают направлять трафик на запрещенную вами страницу, Google может счесть, что страница по-прежнему актуальна. В этом случае вам нужно будет вручную заблокировать страницу от индексации. Вы можете легко сделать это, используя HTTP-заголовок X-Robots-Tag или метатег noindex robots.

Обратите внимание, что если вы используете метатег noindex или X-Robots-Tag, вы не должны запрещать страницу в robots.txt. Страница должна быть просканирована до того, как тег будет замечен и выполнен.

Вывод: оптимизация краулингового бюджета — непростая задача, и уж точно не «быстрая победа». Если у вас есть веб-сайт небольшого или среднего размера, который поддерживается в хорошем состоянии, у вас, вероятно, все в порядке. Но если у вас сложная и неорганизованная структура сайта с тысячами URL-адресов, а файлы журналов сервера не укладываются в голове, возможно, пришло время обратиться за помощью к профессионалам или экспертам.