7 สุดยอดเครื่องมือขูดเว็บออนไลน์ในปี 2023

เผยแพร่แล้ว: 2023-11-17สรุป: เครื่องมือขูดเว็บปรับปรุงขั้นตอนการดึงข้อมูลจากเว็บไซต์เพื่อการตัดสินใจที่ขับเคลื่อนด้วยข้อมูล เรามาสำรวจเครื่องมือขูดที่ดีที่สุดที่คุณสามารถใช้เพื่อจุดประสงค์นี้กันดีกว่า

เครื่องมือขูดเว็บไซต์เป็นเครื่องมือในการดึงข้อมูลจากเว็บไซต์ ช่วยให้ผู้ใช้สามารถรวบรวม วิเคราะห์ และจัดระเบียบข้อมูลเพื่อวัตถุประสงค์ต่างๆ รวมถึงการวิจัย การวิเคราะห์ และข้อมูลเชิงลึกด้านการแข่งขัน พวกเขาสามารถทำให้กระบวนการดึงข้อมูลทั้งหมดเป็นไปโดยอัตโนมัติ และมีส่วนสำคัญต่อการตัดสินใจที่ขับเคลื่อนด้วยข้อมูลในสาขาต่างๆ

ในบทความนี้ เราจะเรียนรู้เกี่ยวกับเครื่องมือแยกเว็บชั้นนำที่มีประโยชน์ขณะส่งออกข้อมูล แต่ก่อนอื่น มาเรียนรู้ว่า web scraping คืออะไรกันแน่

สารบัญ

การขูดเว็บคืออะไร?

การขูดเว็บเป็นวิธีอัตโนมัติในการรวบรวมข้อมูลจำนวนมากจากเว็บไซต์ต่างๆ ข้อมูลที่แยกออกมาเป็นข้อมูลที่ไม่มีโครงสร้างในรูปแบบ HTML ที่ถูกแปลงเป็นข้อมูลที่มีโครงสร้าง เช่น สเปรดชีตและฐานข้อมูล

มีหลายวิธีในการดึงข้อมูลจากเว็บไซต์ เช่น การใช้ API ซอฟต์แวร์ และการสร้างโค้ดเฉพาะของคุณเองสำหรับสิ่งเดียวกัน ตัวอย่างซอฟต์แวร์จำนวนมากมีบอตการขูดในตัวหรืออนุญาตให้คุณสร้างบอตการขูดของคุณเองสำหรับการขูดเว็บ

รายชื่อเครื่องมือขูดเว็บ 7 รายการในปี 2023 ในอินเดียสำหรับผู้เริ่มต้น

- ออคโตพาร์ส

- ParseHub

- ขูดบอท

- ขูด

- แอพิฟาย

- เซนสเครป

- เครื่องมือขูดเว็บ

นี่คือการแจงนับโดยละเอียดของเครื่องมือขูดเว็บที่ดีที่สุด โดยพิจารณาจากคุณสมบัติ ราคา ข้อดีและข้อเสีย ฯลฯ เพื่อช่วยคุณเลือกซอฟต์แวร์ที่ดีที่สุด

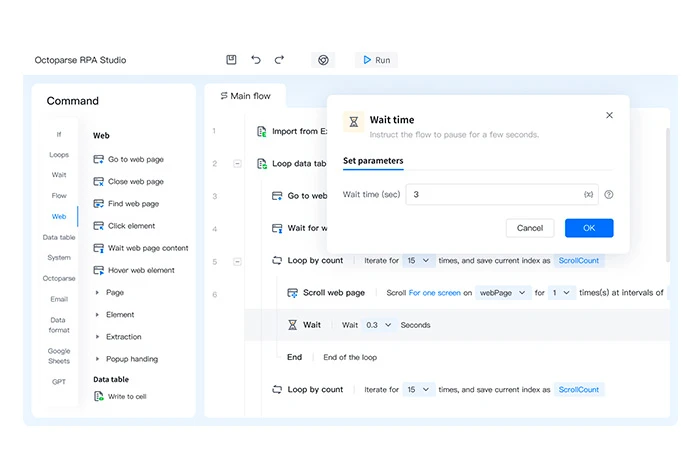

ออคโตพาร์ส

Octoparse เป็นเครื่องมือกำจัดเว็บที่ช่วยให้คุณเปลี่ยนหน้าเว็บของคุณให้เป็นข้อมูลที่มีโครงสร้างได้ภายในไม่กี่วินาที เป็นซอฟต์แวร์ที่ไม่มีโค้ดซึ่งสามารถดึงข้อมูลที่เกี่ยวข้องจากเว็บไซต์หรือหน้าเว็บประเภทต่างๆ

ข้อมูลที่ไม่มีโครงสร้างที่ดึงมาจากเว็บไซต์ใดๆ จะถูกบันทึกในรูปแบบไฟล์ที่มีโครงสร้าง เช่น HTML, ข้อความธรรมดา, Excel และอื่นๆ

คุณสมบัติของออคโตพาร์ส

- ส่งออกข้อมูลเป็นหลายรูปแบบ เช่น Excel, CSV และ JSON

- กำหนดเวลาการส่งออกข้อมูลไปยังฐานข้อมูล

- มีเทมเพลตหลายแบบสำหรับการคัดลอกข้อมูล

- สร้างเครื่องขูดเว็บโค้ดไม่มี

- สร้างงาน 750 งานสำหรับการขูดเว็บ

ข้อดีและข้อเสียของ Octoparse

- รองรับการหมุนเวียน IP อัตโนมัติเมื่อดึงข้อมูลจากเว็บไซต์เพื่อลดโอกาสที่จะถูกติดตาม

- คุณยังสามารถดึงข้อมูลจากหลาย ๆ คลาวด์ผ่านเซิร์ฟเวอร์คลาวด์

- มีตัวเลือกที่จำกัดในการปรับแต่งซอฟต์แวร์

ราคาของ Octoparse: มีแผนฟรี | แผนการชำระเงินเริ่มต้นที่ INR 6,241.54/เดือน

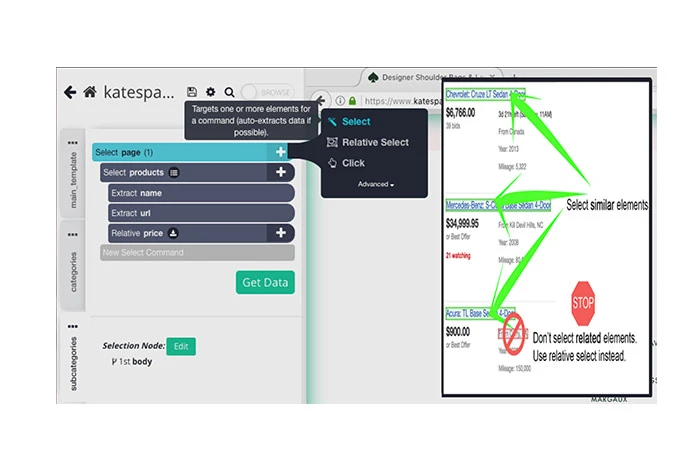

ParseHub

เครื่องมือกำจัดเศษฟรีของ ParseHub สามารถใช้สำหรับเศษข้อมูลจากเว็บไซต์ต่างๆ สิ่งที่คุณต้องทำคือเลือกเว็บไซต์สำหรับการแยกข้อมูล เลือกข้อมูลสำหรับการแยกข้อมูล และส่งออกข้อมูลที่คัดลอกเป็นรูปแบบต่างๆ

สามารถใช้สำหรับการจัดเก็บข้อมูลจากเซิร์ฟเวอร์ต่างๆ การเรนเดอร์ JavaScript การแก้ CAPTCHA ฯลฯ ด้วยคุณสมบัติการกำหนดเวลา คุณยังสามารถกำหนดเวลาการแยกข้อมูลบนเว็บไซต์ต่างๆ ได้

คุณสมบัติ ParseHub

- หมุนที่อยู่ IP อัตโนมัติเพื่อรวบรวมข้อมูลเว็บไซต์

- นำเข้าข้อมูลที่คัดลอกมาเป็นรูปแบบต่างๆ เช่น JSON และ Excel

- โอกาสในการขายเศษจากไดเร็กทอรี ชุมชน โซเชียลมีเดีย ฯลฯ

- เสนอ API หลายตัวเพื่อรวบรวมข้อมูลจากแหล่งต่างๆ

- แยกข้อมูลจากตาราง แผนที่ และแผนภูมิ

ข้อดีข้อเสียของ ParseHub

- มีการบูรณาการกับ Dropbox เพื่อบันทึกข้อมูลที่แยกออกมา

- คุณสามารถใช้มันเพื่อแยกรูปภาพ ข้อความ คุณลักษณะ ฯลฯ จากเว็บไซต์

- ผู้ใช้ที่มีความรู้ด้านเทคนิคเพียงเล็กน้อยอาจพบว่าการใช้ซอฟต์แวร์นี้ทำได้ยาก

ราคาของ ParseHub: มีแผนฟรี | แผนการชำระเงินเริ่มต้นที่ INR 15,736.69/เดือน

ขูดบอท

Scraping Bot มี Web Scraping API สำหรับดึงข้อมูล HTML จากแหล่งต่างๆ โดยไม่ถูกบล็อก มี API หลายตัวที่จัดไว้สำหรับภาคส่วนเฉพาะเพื่อดึงข้อมูลที่เกี่ยวข้องมากที่สุด เมื่อแยกวิเคราะห์ข้อมูลแล้ว ระบบจะนำเข้าข้อมูลในรูปแบบ JSON โดยอัตโนมัติเพื่อรวมเข้ากับเวิร์กโฟลว์ที่มีอยู่

คุณสมบัติการขูดบอท

- รองรับการร้องขอเซิร์ฟเวอร์พร้อมกัน

- ดำเนินการขั้นตอนการรวบรวมข้อมูลโดยอัตโนมัติ

- แยกรายละเอียดลูกค้าเพื่อค้นหาโอกาสในการขาย

- เสนอการวิเคราะห์ทางอารมณ์

- คัดสรรเนื้อหาจากแหล่งต่างๆ เพื่อปรับปรุงกลยุทธ์เนื้อหา

ข้อดีข้อเสียของ Scraping Bot

- นอกจากนี้ยังรองรับการเรนเดอร์ JavaScript

- ให้การกำหนดเป้าหมายตามภูมิศาสตร์เพื่อกรองเว็บไซต์ตามตำแหน่งทางภูมิศาสตร์ของคุณ

- ใช้หน่วยความจำระบบและ RAM จำนวนมาก

ราคา Scraping Bot: มีแผนฟรี | แผนการชำระเงินเริ่มต้นที่ INR 3,476.21/เดือน

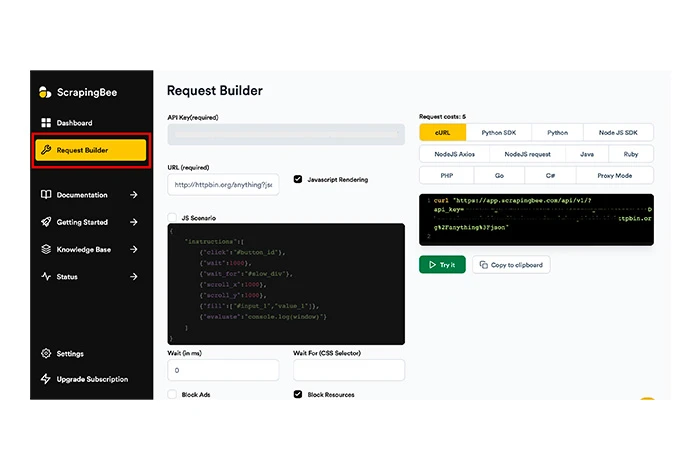

ขูด

Scrapingbee เป็นอีกหนึ่งเครื่องมือขูดเว็บไซต์ที่สามารถช่วยคุณในการขูดเว็บทั่วไป การขูดตามหน้าผลลัพธ์ของเครื่องมือค้นหา (SERP) และการแฮ็กการเติบโต

เครื่องมือนี้สามารถรัน JavaScript บนเพจต่างๆ และหมุนพรอกซีทั้งหมดสำหรับทุกคำขอเพื่อทำให้เพจ HTML แบบ Raw พร้อมใช้งานสำหรับคุณโดยไม่มีโอกาสที่จะถูกบล็อก ScrapingBee จัดการ CAPTCHA พร็อกซี และเบราว์เซอร์ เพื่อให้คุณสามารถดึงข้อมูลจากไซต์ที่คุณต้องการได้อย่างง่ายดาย

คุณสมบัติของสแครปปิ้งบี

- รองรับการหมุนเวียน IP สำหรับการขูดเว็บ

- ให้การหมุนเวียนพร็อกซีอัตโนมัติ

- เสนอการขูดเว็บทั่วไป

- แยกเว็บไซต์ HTML, JSON ฯลฯ

- สร้างเอ็นจิ้นการขูดเว็บแบบกำหนดเองโดยไม่ต้องมีโค้ด

ข้อดีและข้อเสียของ Scrapingbee

- รองรับการขูดข้อมูลที่กำหนดเป้าหมายตามภูมิศาสตร์

- จัดทำ API แยกต่างหากสำหรับการคัดลอกการค้นหาของ Google

- ข้อผิดพลาดเซิร์ฟเวอร์ภายในเกิดขึ้นบ่อยมาก

ราคา Scrapingbee: ไม่มีแผนฟรี | แผนการชำระเงินเริ่มต้นที่ INR 4,077.57/เดือน

แอพิฟาย

Apify เป็นซอฟต์แวร์ขูดเว็บที่คุณสามารถสร้าง ปรับใช้ และดูแลเครื่องมือขูดเว็บต่างๆ ช่วยให้คุณสร้าง API ต่างๆ สำหรับการขูดเว็บไซต์และเพิ่มประสิทธิภาพพร็อกซีของศูนย์ข้อมูลสำหรับการดึงข้อมูล

Apify ยังมีร้านค้าที่ให้บริการเครื่องมือขูดที่สร้างไว้ล่วงหน้าสำหรับการคัดลอกเว็บไซต์เช่น Instagram, Twitter, Google Maps และอื่น ๆ มันมาพร้อมกับคุณสมบัติหลายอย่างสำหรับการขูดเว็บ ระบบเวิร์กโฟลว์อัตโนมัติ และการดึงข้อมูล

คุณสมบัติของ Apify

- รันงานได้ไม่จำกัดพร้อมกัน

- จัดการพรอกซีสำหรับศูนย์ข้อมูลและ SERP

- แยกข้อมูลจาก Amazon, schema.org, เว็บเพจ ฯลฯ

- รองรับการหมุนเวียนที่อยู่ IP ในขณะที่ขูดข้อมูล

- เสนอการแก้ไข CAPTCHA และการแสดงผล JavaScript

- ส่งออกข้อมูลในรูปแบบเช่น CSV, JSON, Excel เป็นต้น

ข้อดีและข้อเสียของ Apify

- เสนอการหมุนเวียนพร็อกซีเป็นคุณสมบัติในตัว

- สามารถเข้าถึงข้อมูลได้หลายรูปแบบผ่าน API

- ปัญหาความเข้ากันได้ของซอฟต์แวร์อาจเกิดขึ้น

ราคา Apify: มีแผนฟรี | แผนการชำระเงินเริ่มต้นที่ INR 4,077.64/เดือน

เซนสเครป

Zenscrape เป็น API ที่จัดการปัญหาการขูดเว็บทั้งหมด และรองรับการแยกข้อมูล HTML คุณภาพสูง เครื่องมือนี้แสดงผลคำขอผ่านเบราว์เซอร์ Chrome ที่ทันสมัยเพื่อการรวบรวมข้อมูลที่แม่นยำและแม่นยำ

ข้อมูลที่ดึงมาจากเว็บไซต์จะถูกส่งออกไปยังหลายรูปแบบ เช่น Excel และ JSON นอกจากนี้ ด้วยคุณสมบัติการระบุตำแหน่งทางภูมิศาสตร์ คุณสามารถเลือกตำแหน่งพร็อกซีเพื่อดูเนื้อหาเว็บไซต์ที่กำหนดเป้าหมายตามภูมิศาสตร์ได้

คุณสมบัติ Zenscrape

- รองรับการรวบรวมข้อมูลเว็บ

- ดำเนินการขูดข้อมูลราคา

- เศษข้อมูลผู้ติดต่อจากเว็บไซต์โดยอัตโนมัติ

- จัดการพร็อกซีเว็บไซต์มาตรฐานและพรีเมียม

- รองรับการหมุน IP และการแก้ไข CAPTCHA

ข้อดีและข้อเสียของ Zenscrape

- นอกจากนี้ยังรองรับการดึงข้อมูล HTML จากเว็บไซต์

- เวลาตอบสนองของเว็บไซต์นั้นรวดเร็วมากใน Zenscrape

- คุณต้องใช้เครื่องมือของบริษัทอื่นเพื่อแปลงข้อมูลที่ดึงมาเป็นรูปแบบไฟล์ต่างๆ

ราคาของ Zenscrape: มีแผนฟรี | แผนการชำระเงินเริ่มต้นที่ INR 2,496.26/เดือน

เครื่องมือขูดเว็บ

Web Scraper เป็นเครื่องมือขูดข้อมูลออนไลน์ที่คุณสามารถใช้เพื่อดึงข้อมูลแบบปกติและแบบกำหนดเวลาได้ สามารถรวมเข้ากับระบบอื่นเพื่อใช้ข้อมูลที่แยกออกมาได้ ด้วยเครื่องมือขูดนี้ คุณสามารถแยกข้อมูลเป็นกลุ่มและรันงานขูดของเว็บไซต์หลายแห่งพร้อมกันได้

คุณสมบัติของ Web Scraper

- ดำเนินการขั้นตอนการแยกข้อมูลโดยอัตโนมัติอย่างรวดเร็ว

- กำหนดค่าเครื่องขูดโดยไม่ต้องเข้ารหัส

- แยกข้อมูลไซต์ด้วยการสนับสนุนการนำทางหลายระดับ

- ใช้แผนผังเว็บไซต์สำหรับการปรับแต่งข้อมูลเว็บไซต์

- ส่งออกข้อมูลในรูปแบบ CSV, XLSX, JSON และรูปแบบอื่นๆ

ข้อดีข้อเสียของ Web Scraper

- คุณยังสามารถกำหนดเวลาการแยกเว็บไซต์ตามสัปดาห์ วัน ชั่วโมง ฯลฯ ได้อีกด้วย

- มันสามารถหมุน IP ด้วยที่อยู่ IP หลายรายการ

- ต้องใช้เวลามากในการตั้งค่า

- ข้อมูลที่ดึงมาจะถูกเก็บไว้สูงสุด 60 วันเท่านั้น

ราคา Web Scraper: มีแผนฟรี | แผนการชำระเงินเริ่มต้นที่ INR 4,162.90/เดือน

จะเลือก Web Scraper ได้อย่างไร?

ในการเลือกเครื่องขูดแผ่นใยที่เหมาะสม คุณต้องพิจารณาปัจจัยต่อไปนี้:

- ระบบปฏิบัติการที่รองรับ: เว็บสแครปเปอร์ที่คุณวางแผนจะซื้อจะต้องรองรับระบบปฏิบัติการที่คุณใช้อยู่

- การสนับสนุนระบบคลาวด์: ด้วยการสนับสนุนนี้ คุณจะสามารถบันทึกข้อมูลที่มีโครงสร้างบนระบบคลาวด์ได้

- บูรณาการ: การบูรณาการกับแพลตฟอร์มอื่นช่วยให้คุณสามารถถ่ายโอนข้อมูลที่ดึงมาไปยังแพลตฟอร์มอื่นได้อย่างง่ายดาย

- การฝึกอบรม: เนื่องจากการใช้เครื่องมือทำลายเว็บต้องอาศัยความรู้ด้านการเขียนโปรแกรม คุณต้องเลือกเครื่องมือที่มีสื่อการฝึกอบรมเพียงพอ

- ราคา: พิจารณาราคาของซอฟต์แวร์และตรวจสอบให้แน่ใจว่าอยู่ภายในงบประมาณของคุณ

Web Scraping ทำงานอย่างไร?

การขูดเว็บทำได้ในสามขั้นตอนง่ายๆ ขั้นแรก บอตการขูดจะจำลองการเรียกดูโดยมนุษย์และทำลายไซต์ ประการที่สอง จะแยกวิเคราะห์ข้อมูลจากโหนดข้อมูล สุดท้ายจะดาวน์โหลดและแปลงข้อมูลที่แยกวิเคราะห์ นี่คือการแจงนับโดยละเอียดของแต่ละขั้นตอนโดยละเอียด

ขั้นตอนที่ 1: บอทขูดเว็บจำลองมนุษย์ในขณะที่เรียกดูเว็บไซต์ที่กำหนด หลังจากนั้นจะเข้าสู่ URL เป้าหมายและส่งคำขอไปยังเซิร์ฟเวอร์ เมื่อเสร็จแล้ว เซิร์ฟเวอร์จะให้ข้อมูลกลับไปยังไฟล์ HTML

ขั้นตอนที่ 2: ด้วยโค้ด HTML บอทจะเข้าถึงโหนดข้อมูลและแยกวิเคราะห์ข้อมูลตามคำสั่งของโค้ดขูด

ขั้นตอนที่ 3: ตามการกำหนดค่าบ็อต ข้อมูลที่คัดลอกจะถูกล้างและแปลงเป็นรูปแบบข้อมูลที่มีโครงสร้าง เช่น JSON หลังจากนั้นข้อมูลก็พร้อมสำหรับการนำเข้าหรือขนส่งไปยังฐานข้อมูลต่างๆ

การเปรียบเทียบเครื่องมือแยกเว็บยอดนิยม

นี่คือการเปรียบเทียบเครื่องมือขูดเว็บที่ดีที่สุดโดยพิจารณาจากระบบปฏิบัติการที่รองรับ ความพร้อมใช้งานทดลองใช้ฟรี และคะแนนโดยรวมของผู้ใช้

| ซอฟต์แวร์ | ระบบปฏิบัติการที่รองรับ | ทดลองฟรี | เรตติ้ง |

| ออคโตพาร์ส | วินโดวส์, แมค | มีอยู่ | 4 |

| ParseHub | วินโดวส์, macOS, ลินุกซ์ | ไม่สามารถใช้ได้ | 4.5 |

| ขูดบอท | วินโดวส์, แมค | มีอยู่ | 3.5 |

| ขูด | บนเว็บ | ใช้ได้ 14 วัน | 4.1 |

| แอพิฟาย | บนเว็บ | ใช้งานได้ฟรี | 4.9 |

| เซนสเครป | บนเว็บ | เครื่องมือแยกวิเคราะห์ข้อมูลฟรี | 3.8 |

| เครื่องมือขูดเว็บ | วินโดวส์, แมค | ใช้ได้ 7 วัน | 4.1 |

บทสรุป

หลังจากอ่านบทความนี้แล้ว คุณอาจเข้าใจเครื่องมือขูดเว็บไซต์และวิธีที่เครื่องมือเหล่านี้สามารถช่วยคุณในการดึงข้อมูลได้ ในบทความนี้ เราได้แสดงรายการซอฟต์แวร์ชั้นนำเพื่อแยกและนำเข้าข้อมูลจากเว็บไซต์

จากคุณสมบัติต่างๆ เช่น การดึงข้อมูล การหมุนเวียน IP การจัดการพร็อกซี ฯลฯ ParseHub และ Scraping Bot กลายเป็นเครื่องมือที่ดีที่สุดสำหรับการขูดเว็บ อย่างไรก็ตาม ก่อนที่จะเลือกเครื่องมือขูดเว็บ โปรดพิจารณาข้อกำหนดด้านราคาและฟีเจอร์ของคุณก่อน

คำถามที่พบบ่อยเกี่ยวกับ Web Scrapper Tools

เครื่องมือแยกเว็บคืออะไร?

เครื่องมือขูดเว็บเป็นโปรแกรมซอฟต์แวร์ที่ออกแบบมาเพื่อปรับปรุงคุณสมบัติการแยกข้อมูลจากเว็บไซต์ เครื่องมือเหล่านี้ช่วยให้คุณสร้างบอทของคุณเองที่สามารถดึงข้อมูลที่จำเป็นจากเว็บไซต์ที่กำหนดได้

การขูดเว็บใช้ทำอะไร?

การขูดเว็บสามารถใช้เพื่อวัตถุประสงค์หลายประการ เช่น การแยกข้อมูลโซเชียลมีเดีย ข้อมูลผู้ติดต่อ ข้อมูลอสังหาริมทรัพย์ ข้อมูลราคาหุ้น และอื่นๆ อีกมากมาย

จะดึงข้อมูลจากเว็บไซต์ได้อย่างไร?

หากต้องการดึงข้อมูลจากเว็บไซต์ของคุณ คุณสามารถใช้เครื่องมือขูดข้อมูลต่างๆ ได้ เครื่องมือที่ดีที่สุดบางส่วนที่คุณสามารถพิจารณาสำหรับการขูดเว็บ ได้แก่ Zenscrape, Apify, Scrapingbee, Smartproxy, Agenty เป็นต้น

การใช้เครื่องมือขูดเว็บสำหรับธุรกิจมีประโยชน์อย่างไร?

ด้วยการใช้เครื่องมือขูดเว็บ ธุรกิจสามารถทำให้กระบวนการดึงข้อมูลเป็นอัตโนมัติ ประหยัดเวลาอันมีค่า และใช้ข้อมูลเพื่อรับข้อมูลเชิงลึกอันมีค่า นอกจากนี้ ธุรกิจยังสามารถดึงข้อมูลจากหลาย ๆ เว็บไซต์พร้อมกันด้วยเครื่องมือแยกวิเคราะห์เว็บเหล่านี้เพื่อประหยัดเวลาและทรัพยากร

ความรู้ด้านการเขียนโค้ดจำเป็นต้องใช้เครื่องมือขูดเว็บหรือไม่?

จำเป็นต้องมีความรู้พื้นฐานเกี่ยวกับการเขียนโค้ดจึงจะใช้เครื่องมือขูดเว็บไซต์ได้ อย่างไรก็ตาม ไม่จำเป็นเนื่องจากเครื่องมือจำนวนมากมีอินเทอร์เฟซที่เป็นมิตรต่อผู้ใช้ และสามารถใช้งานได้โดยมีความรู้ด้านเทคนิคเพียงเล็กน้อยหรือไม่มีเลย

ฉันจะขูดข้อมูลฟรีได้อย่างไร

หากต้องการขูดข้อมูลเว็บไซต์ฟรี คุณสามารถเลือกเครื่องมือขูดข้อมูลฟรีได้ เครื่องมือเหล่านี้เสนอแผนฟรีหรือใช้งานได้ฟรีโดยสมบูรณ์ เครื่องมือเหล่านี้บางส่วน ได้แก่ Apify, Zenscrape, Octoparse เป็นต้น