Crawl Budget คืออะไร & จะปรับให้เหมาะสมได้อย่างไร

เผยแพร่แล้ว: 2022-11-25

งบประมาณการรวบรวมข้อมูลอาจดูเหมือนเป็นแนวคิดต่างประเทศเมื่อคุณเรียนรู้เกี่ยวกับวิธีการทำงานของบอทเครื่องมือค้นหาเป็นครั้งแรก แม้ว่าจะไม่ใช่แนวคิด SEO ที่ง่ายที่สุด แต่ก็ซับซ้อนน้อยกว่าที่เห็น เมื่อคุณเริ่มเข้าใจว่างบประมาณการรวบรวมข้อมูลคืออะไรและวิธีการทำงานของการรวบรวมข้อมูลของเครื่องมือค้นหาแล้ว คุณสามารถเริ่มเพิ่มประสิทธิภาพเว็บไซต์ของคุณเพื่อเพิ่มประสิทธิภาพสำหรับการรวบรวมข้อมูลได้ กระบวนการนี้จะช่วยให้เว็บไซต์ของคุณมีศักยภาพสูงสุดในการจัดอันดับในผลการค้นหาของ Google

งบประมาณการรวบรวมข้อมูลคืออะไร?

งบประมาณการรวบรวมข้อมูลคือจำนวน URL จากเว็บไซต์หนึ่งที่บอทเครื่องมือค้นหาสามารถจัดทำดัชนีได้ภายในหนึ่งเซสชันการจัดทำดัชนี "งบประมาณ" ของเซสชันการรวบรวมข้อมูลจะแตกต่างกันไปในแต่ละเว็บไซต์ โดยขึ้นอยู่กับขนาดของแต่ละไซต์ เมตริกการเข้าชม และความเร็วในการโหลดหน้าเว็บ

หากคุณมาถึงจุดนี้แล้วและคำศัพท์ SEO ไม่คุ้นเคย ให้ใช้ อภิธานศัพท์ SEO ของเราเพื่อทำความคุ้นเคยกับคำ จำกัดความ

ปัจจัยใดบ้างที่ส่งผลต่องบประมาณการรวบรวมข้อมูลของเว็บไซต์

Google ไม่ได้ใช้เวลาหรือจำนวนการรวบรวมข้อมูลเท่ากันกับทุกเว็บไซต์บนอินเทอร์เน็ต Webcrawlers ยังกำหนดหน้าที่พวกเขารวบรวมข้อมูลและความถี่ตามปัจจัยหลายประการ พวกเขากำหนดความถี่และระยะเวลาที่ควรรวบรวมข้อมูลแต่ละไซต์โดยพิจารณาจาก:

Google ไม่ได้ใช้เวลาหรือจำนวนการรวบรวมข้อมูลเท่ากันกับทุกเว็บไซต์บนอินเทอร์เน็ต Webcrawlers ยังกำหนดหน้าที่พวกเขารวบรวมข้อมูลและความถี่ตามปัจจัยหลายประการ พวกเขากำหนดความถี่และระยะเวลาที่ควรรวบรวมข้อมูลแต่ละไซต์โดยพิจารณาจาก:

- ความนิยม: ยิ่งมีการเข้าชมไซต์หรือเพจมากเท่าใด ควรมีการวิเคราะห์การอัปเดตบ่อยครั้งมากขึ้นเท่านั้น นอกจากนี้ หน้าเว็บที่ได้รับความนิยมมากขึ้นจะได้รับลิงก์ขาเข้ามากขึ้นอย่างรวดเร็ว

- ขนาด: เว็บไซต์และเพจขนาดใหญ่ที่มีองค์ประกอบข้อมูลเข้มข้นจะใช้เวลารวบรวมข้อมูลนานกว่า

- สถานภาพ/ปัญหา: เมื่อโปรแกรมรวบรวมข้อมูลเว็บถึงทางตันผ่านลิงก์ภายใน มันต้องใช้เวลากว่าจะพบจุดเริ่มต้นใหม่ หรือหยุดการรวบรวมข้อมูล ข้อผิดพลาด 404 การเปลี่ยนเส้นทาง และเวลาในการโหลดที่ช้าทำให้โปรแกรมรวบรวมข้อมูลเว็บทำงานช้าลงและติดขัด

งบประมาณการรวบรวมข้อมูลของคุณส่งผลต่อ SEO อย่างไร

กระบวนการ สร้างดัชนี เว็บครอว์เลอ ร์ทำให้การค้นหาเป็นไปได้ หากไม่พบเนื้อหาของคุณ จากนั้นจัดทำดัชนีโดยโปรแกรมรวบรวมข้อมูลเว็บของ Google ผู้ค้นหาจะไม่พบหน้าเว็บและเว็บไซต์ของคุณ สิ่งนี้จะทำให้ไซต์ของคุณพลาดปริมาณการค้นหาจำนวนมาก

ทำไม Google รวบรวมข้อมูลเว็บไซต์

Googlebots สำรวจหน้าต่างๆ ของเว็บไซต์อย่างเป็นระบบ เพื่อพิจารณาว่าหน้านั้นและเว็บไซต์โดยรวมเกี่ยวกับอะไร Webcrawler ประมวลผล จัดหมวดหมู่ และจัดระเบียบข้อมูลจากเว็บไซต์นั้นทีละหน้าเพื่อสร้างแคชของ URL พร้อมกับเนื้อหา ดังนั้น Google จึงสามารถกำหนดว่าผลการค้นหาใดควรปรากฏตามคำค้นหา

นอกจากนี้ Google ยังใช้ข้อมูลนี้เพื่อพิจารณาว่าผลการค้นหาใด เหมาะสมกับ คำค้นหามากที่สุด เพื่อกำหนดตำแหน่งที่ผลการค้นหาแต่ละรายการควรปรากฏในรายการผลการค้นหาตามลำดับชั้น

เกิดอะไรขึ้นระหว่างการรวบรวมข้อมูล

Google จัดสรรเวลาจำนวนหนึ่งเพื่อให้ Googlebot ดำเนินการกับเว็บไซต์ เนื่องจากข้อจำกัดนี้ บอทมักจะไม่รวบรวมข้อมูลทั้งไซต์ในช่วงเซสชันการรวบรวมข้อมูลหนึ่งครั้ง แต่จะทำงานในหน้าทั้งหมดของไซต์ตามไฟล์ robots.txt และปัจจัยอื่นๆ (เช่น ความนิยมของหน้า)

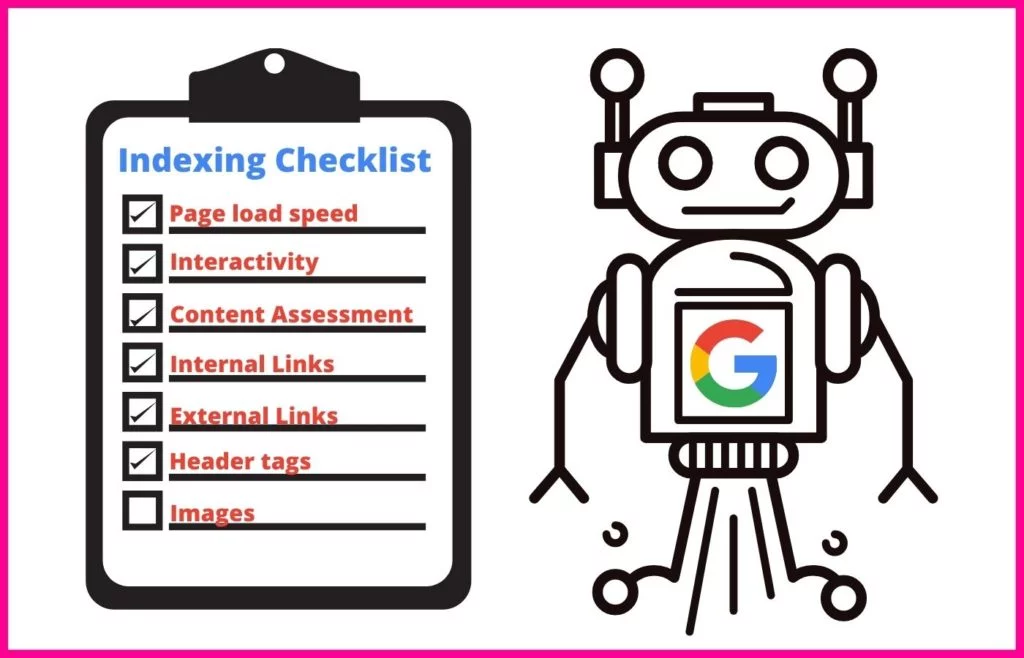

ระหว่างเซสชันการรวบรวมข้อมูล Googlebot จะใช้วิธีการที่เป็นระบบเพื่อทำความเข้าใจเนื้อหาของแต่ละหน้าที่ประมวลผล

ซึ่งรวมถึงการจัดทำดัชนีแอตทริบิวต์เฉพาะ เช่น:

- เมตาแท็กและ การใช้ NLP เพื่อกำหนดความหมาย

- ลิงค์และ สมอข้อความ

- ไฟล์สื่อสมบูรณ์สำหรับการค้นหารูปภาพและการค้นหาวิดีโอ

- มาร์กอัปสคีมา

- มาร์กอัป HTML

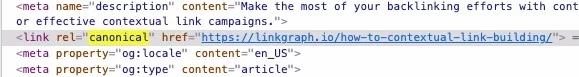

โปรแกรมรวบรวมข้อมูลเว็บจะเรียกใช้การตรวจสอบเพื่อพิจารณาว่าเนื้อหาในหน้านั้นซ้ำกับ Canonical หรือไม่ หากเป็นเช่นนั้น Google จะย้าย URL นั้นลงไปยังการรวบรวมข้อมูลที่มีลำดับความสำคัญต่ำ จึงไม่เสียเวลาในการรวบรวมข้อมูลหน้าเว็บบ่อยๆ

อัตราการรวบรวมข้อมูลและความต้องการรวบรวมข้อมูลคืออะไร

โปรแกรมรวบรวมข้อมูลเว็บของ Google กำหนดระยะเวลาหนึ่งให้กับการรวบรวมข้อมูลทุกครั้งที่ดำเนินการ ในฐานะเจ้าของเว็บไซต์ คุณไม่สามารถควบคุมระยะเวลานี้ได้ อย่างไรก็ตาม คุณสามารถเปลี่ยนความเร็วที่พวกเขารวบรวมข้อมูลหน้าเว็บแต่ละหน้าในไซต์ของคุณได้ในขณะที่พวกเขาอยู่ในไซต์ของคุณ ตัวเลขนี้เรียกว่า อัตราการรวบรวมข้อมูล ของ คุณ

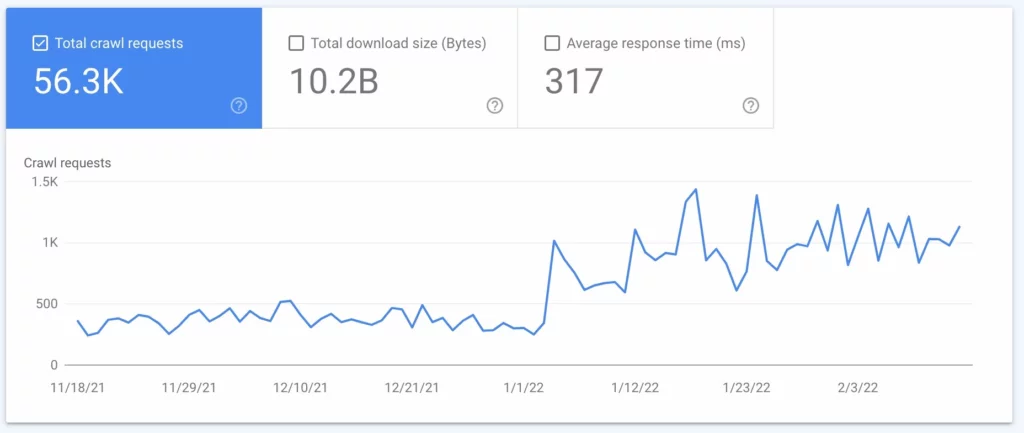

ความต้องการรวบรวมข้อมูล คือความถี่ที่ Google รวบรวมข้อมูลไซต์ของคุณ ความถี่นี้ขึ้นอยู่กับความต้องการของไซต์ของคุณโดยผู้ใช้อินเทอร์เน็ต และความถี่ที่เนื้อหาไซต์ของคุณต้องได้รับการอัปเดตในการค้นหา คุณสามารถค้นพบความถี่ที่ Google รวบรวมข้อมูลไซต์ของคุณโดยใช้การวิเคราะห์ไฟล์บันทึก (ดู #2 ด้านล่าง)

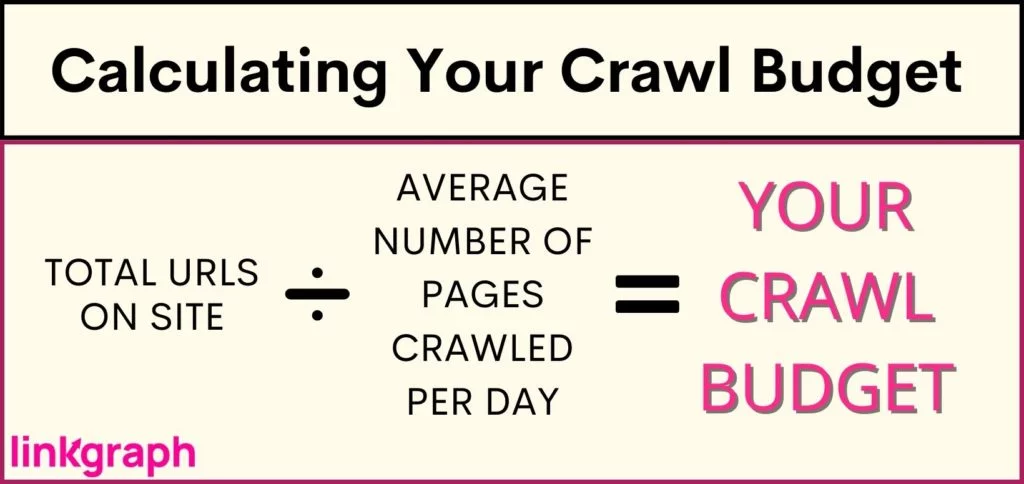

ฉันจะกำหนดงบประมาณการรวบรวมข้อมูลไซต์ของฉันได้อย่างไร

เนื่องจาก Google จำกัดจำนวนครั้งในการรวบรวมข้อมูลเว็บไซต์ของคุณและระยะเวลาเท่าใด คุณจึงต้องการทราบว่างบประมาณในการรวบรวมข้อมูลของคุณคือเท่าใด อย่างไรก็ตาม Google ไม่ได้ให้ข้อมูลนี้แก่เจ้าของไซต์ โดยเฉพาะอย่างยิ่งหากงบประมาณของคุณจำกัดมากจนเนื้อหาใหม่ไม่สามารถเข้าถึง SERP ได้ทันท่วงที สิ่งนี้อาจสร้างความเสียหายให้กับเนื้อหาที่สำคัญและหน้าใหม่ เช่น หน้าผลิตภัณฑ์ซึ่งอาจทำเงินให้คุณได้

เพื่อทำความเข้าใจว่าไซต์ของคุณประสบปัญหาข้อจำกัดด้านงบประมาณในการรวบรวมข้อมูลหรือไม่ (หรือเพื่อยืนยันว่าไซต์ของคุณอยู่ในเกณฑ์ A-OK) คุณจะต้อง: รับสินค้าคงคลังของจำนวน URL บนไซต์ของคุณ หากคุณใช้ Yoast ยอดรวมของคุณจะแสดงที่ด้านบนของ URL แผนผังไซต์ของ คุณ

คุณจะเพิ่มประสิทธิภาพสำหรับงบประมาณการรวบรวมข้อมูลได้อย่างไร

เมื่อถึงเวลาที่ไซต์ของคุณมีขนาดใหญ่เกินไปสำหรับงบประมาณการรวบรวมข้อมูล คุณจะต้องดำดิ่งสู่การเพิ่มประสิทธิภาพงบประมาณการรวบรวมข้อมูล เนื่องจากคุณไม่สามารถบอกให้ Google รวบรวมข้อมูลไซต์ของคุณบ่อยขึ้นหรือใช้เวลานานขึ้น คุณต้องเน้นสิ่งที่คุณควบคุมได้

การเพิ่มประสิทธิภาพงบประมาณการรวบรวมข้อมูลต้องใช้วิธีการแบบหลายแง่มุมและความเข้าใจใน แนวทางปฏิบัติที่ดีที่สุด ของ Google คุณควรเริ่มต้นที่ไหนในการใช้ประโยชน์สูงสุดจากอัตราการรวบรวมข้อมูลของคุณ รายการที่ครอบคลุมนี้เขียนขึ้นตามลำดับชั้น ดังนั้นให้เริ่มที่ด้านบนสุด

1. พิจารณาเพิ่มขีดจำกัดอัตราการรวบรวมข้อมูลเว็บไซต์ของคุณ

Google ส่งคำขอพร้อมกันไปยังหลายหน้าในไซต์ของคุณ อย่างไรก็ตาม Google พยายามที่จะสุภาพและไม่ทำให้เซิร์ฟเวอร์ของคุณล่ม ซึ่งส่งผลให้ผู้เข้าชมไซต์ของคุณโหลดช้าลง หากคุณสังเกตเห็นว่าไซต์ของคุณล้าหลังโดยไม่ทราบสาเหตุ นี่อาจเป็นปัญหา

เพื่อป้องกันไม่ให้ส่งผลกระทบต่อประสบการณ์ของผู้ใช้ Google อนุญาตให้คุณลดอัตราการรวบรวมข้อมูล การทำเช่นนั้นจะจำกัดจำนวนหน้าเว็บที่ Google สามารถจัดทำดัชนีพร้อมกันได้

ที่น่าสนใจคือ Google ยังอนุญาตให้คุณเพิ่มขีดจำกัดอัตราการรวบรวมข้อมูล ซึ่งมีผลให้สามารถดึงหน้าเว็บได้มากขึ้นในคราวเดียว ทำให้มีการรวบรวมข้อมูล URL มากขึ้นในคราวเดียว แม้ว่ารายงานทั้งหมดจะแนะนำว่า Google ตอบสนองต่อการเพิ่มขีดจำกัดอัตราการรวบรวมข้อมูลได้ช้า และไม่ได้รับประกันว่า Google จะรวบรวมข้อมูลไซต์จำนวนมากขึ้นพร้อมๆ กัน

วิธีเพิ่มขีดจำกัดอัตราการรวบรวมข้อมูลของคุณ:

- ใน Search Console ให้ไปที่ "การตั้งค่า"

- จากตรงนั้น คุณสามารถดูได้ว่าอัตราการรวบรวมข้อมูลของคุณเหมาะสมหรือไม่

- จากนั้นคุณสามารถเพิ่มขีดจำกัดเป็นอัตราการรวบรวมข้อมูลที่รวดเร็วยิ่งขึ้นเป็นเวลา 90 วัน

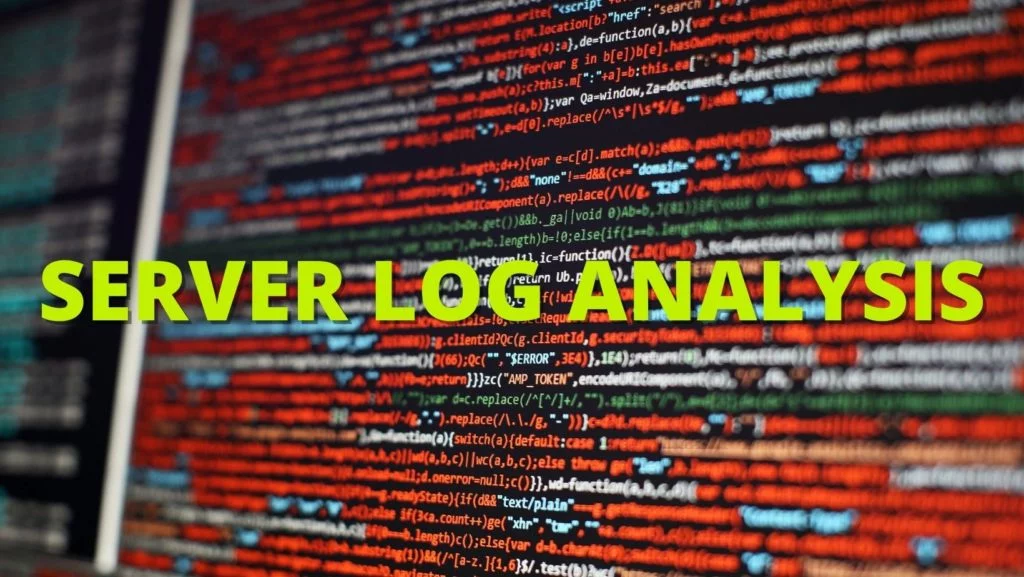

2. ทำการวิเคราะห์ไฟล์บันทึก

การวิเคราะห์ไฟล์บันทึกเป็นรายงานจากเซิร์ฟเวอร์ที่สะท้อนทุกคำขอที่ส่งไปยังเซิร์ฟเวอร์ รายงานนี้จะบอกคุณอย่างชัดเจนว่า Googlebots ทำอะไรในไซต์ของคุณ แม้ว่า SEO ทางเทคนิคมักจะดำเนินการตามขั้นตอนนี้ แต่คุณก็สามารถปรึกษากับผู้ดูแลระบบเซิร์ฟเวอร์ของคุณเพื่อรับขั้นตอนดังกล่าวได้

การใช้ Log File Analysis หรือเซิร์ฟเวอร์ล็อกไฟล์ คุณจะได้เรียนรู้:

- Google รวบรวมข้อมูลไซต์ของคุณบ่อยเพียงใด

- หน้าใดได้รับการรวบรวมข้อมูลมากที่สุด

- หน้าใดมีรหัสเซิร์ฟเวอร์ที่ไม่ตอบสนองหรือขาดหายไป

เมื่อคุณมีข้อมูลนี้แล้ว คุณสามารถใช้มันเพื่อดำเนินการ #3 ถึง #7

3. อัปเดตแผนผังไซต์ XML และ Robots.txt ของคุณอยู่เสมอ

หากไฟล์บันทึกของคุณแสดงว่า Google ใช้เวลามากเกินไปในการรวบรวมข้อมูลหน้าที่คุณไม่ต้องการให้ปรากฏใน SERP คุณสามารถขอให้โปรแกรมรวบรวมข้อมูลของ Google ข้ามหน้าเหล่านี้ได้ ซึ่งจะทำให้งบประมาณในการรวบรวมข้อมูลบางส่วนของคุณว่างสำหรับหน้าที่สำคัญกว่า

แผนผังไซต์ของคุณ (ซึ่งคุณสามารถหาได้จาก Google Search Console หรือ SearchAtlas ) ทำให้ Googlebots แสดงรายการหน้าเว็บทั้งหมดบนไซต์ของคุณที่คุณต้องการให้ Google จัดทำดัชนี เพื่อให้ปรากฏในผลการค้นหา การอัปเดตแผนผังไซต์ของคุณอยู่เสมอด้วยหน้าเว็บทั้งหมดที่คุณต้องการให้เครื่องมือค้นหาค้นหาและละเว้นสิ่งที่คุณไม่ต้องการให้พบสามารถเพิ่มวิธีที่โปรแกรมรวบรวมข้อมูลเว็บใช้เวลากับไซต์ของคุณให้มากที่สุด

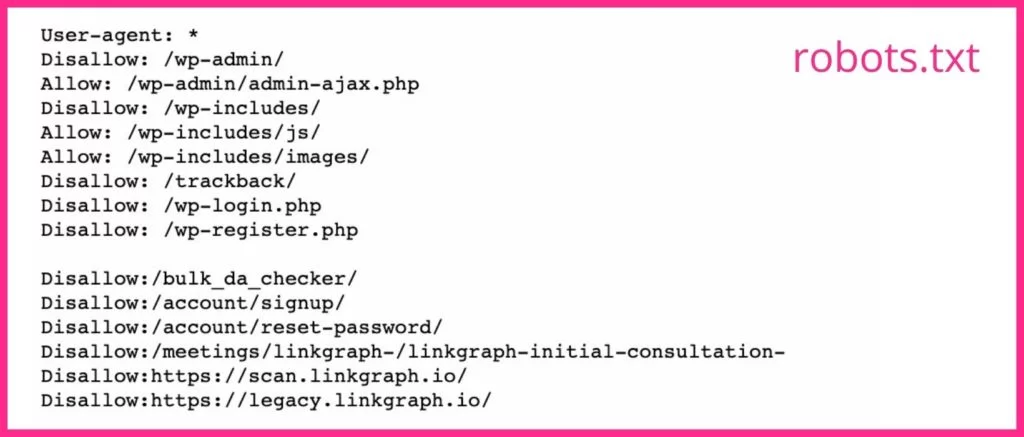

ไฟล์ robots.txt ของคุณจะบอกโปรแกรมรวบรวมข้อมูลของเครื่องมือค้นหาว่าคุณต้องการ และไม่ต้องการ ให้รวบรวมข้อมูลหน้าใด หากคุณมีหน้าเว็บที่สร้างหน้า Landing Page ไม่ดีหรือหน้าที่มี Gate คุณควรใช้ แท็ก noindex สำหรับ URL ในไฟล์ robots.txt ของคุณ Googlebots มักจะข้ามหน้าเว็บที่มีแท็ก noindex

4. ลดการเปลี่ยนเส้นทางและห่วงโซ่การเปลี่ยนเส้นทาง

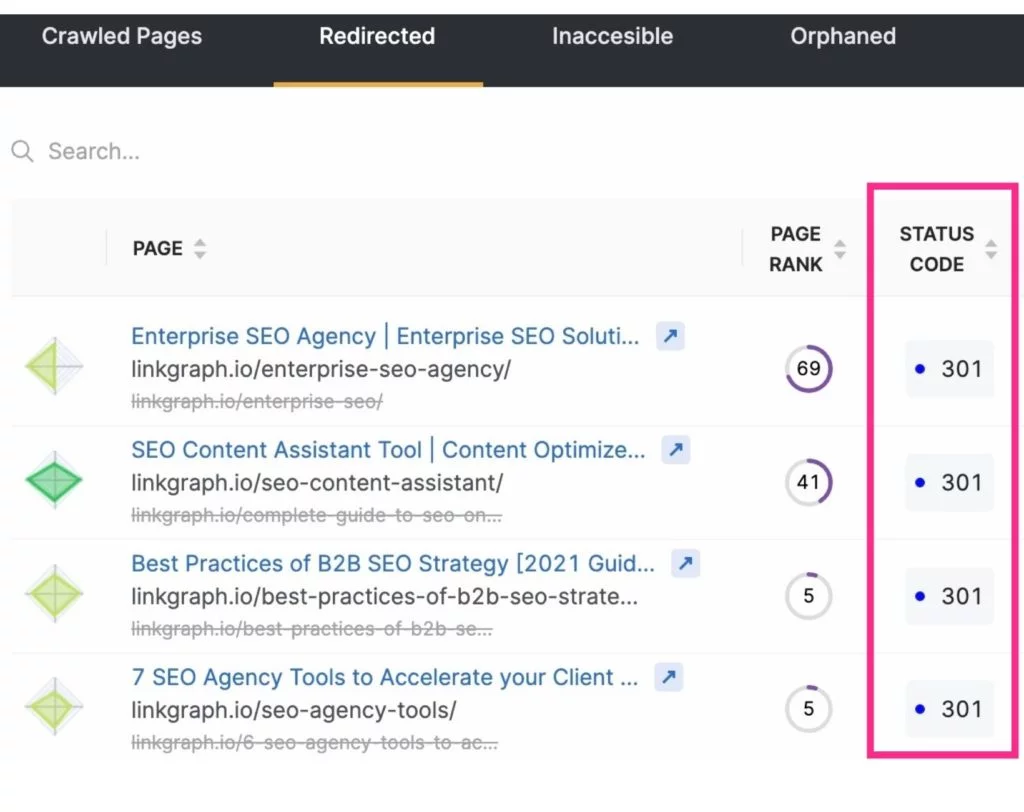

นอกเหนือจากการเพิ่มงบประมาณการรวบรวมข้อมูลโดยการยกเว้นหน้าที่ไม่จำเป็นจากการรวบรวมข้อมูลของเครื่องมือค้นหาแล้ว คุณยังสามารถเพิ่มการรวบรวมข้อมูลได้สูงสุดโดยการลดหรือกำจัดการเปลี่ยนเส้นทาง สิ่งเหล่านี้จะเป็น URL ใดๆ ที่ส่งผลให้เกิดรหัสสถานะ 3xx

URL ที่เปลี่ยนเส้นทางใช้เวลานานกว่าที่ Googlebot จะเรียกข้อมูล เนื่องจากเซิร์ฟเวอร์ต้องตอบสนองด้วยการเปลี่ยนเส้นทาง จากนั้นจึงเรียกหน้าใหม่ แม้ว่าการเปลี่ยนเส้นทางหนึ่งครั้งจะใช้เวลาเพียงไม่กี่มิลลิวินาที แต่ก็สามารถรวมกันได้ และนี่อาจทำให้การรวบรวมข้อมูลไซต์ของคุณโดยรวมใช้เวลานานขึ้น ระยะเวลานี้จะเพิ่มขึ้นเป็นทวีคูณเมื่อ Googlebot ทำงานในห่วงโซ่ของการเปลี่ยนเส้นทาง URL

เพื่อลดการเปลี่ยนเส้นทางและห่วงโซ่การเปลี่ยนเส้นทาง ให้คำนึงถึงกลยุทธ์การสร้างเนื้อหาและเลือกข้อความสำหรับทากของคุณอย่างระมัดระวัง

5. แก้ไขลิงค์เสีย

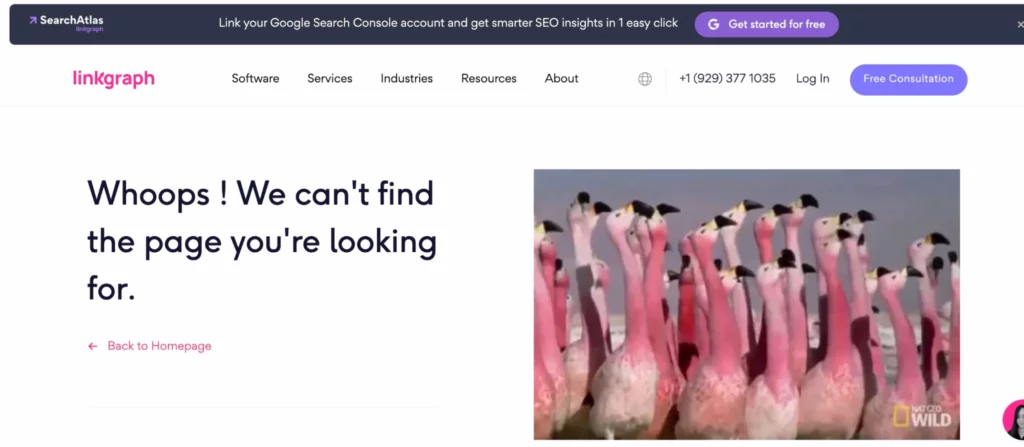

วิธีที่ Google มักจะสำรวจไซต์คือการนำทางผ่านโครงสร้างลิงก์ภายในของคุณ เมื่อมันทำงานผ่านหน้าเว็บของคุณ มันจะสังเกตว่ามีลิงก์นำไปสู่หน้าที่ไม่มีอยู่จริงหรือไม่ (ซึ่งมักเรียกว่าข้อผิดพลาด soft 404) ก็จะไปต่อได้ไม่อยากเสียเวลาจัดทำดัชนีหน้าดังกล่าว

ลิงก์ไปยังหน้าเหล่านี้จำเป็นต้องอัปเดตเพื่อส่งผู้ใช้หรือ Googlebot ไปยังหน้าจริง หรือ (แม้ว่าจะยากที่จะเชื่อ) Googlebot อาจระบุหน้าผิดพลาดเป็นข้อผิดพลาด 4xx หรือ 404 ทั้งที่หน้านั้นมีอยู่จริง เมื่อสิ่งนี้เกิดขึ้น ให้ตรวจสอบว่า URL ไม่มีการพิมพ์ผิด จากนั้นส่งคำขอรวบรวมข้อมูลสำหรับ URL นั้นผ่านบัญชี Google Search Console

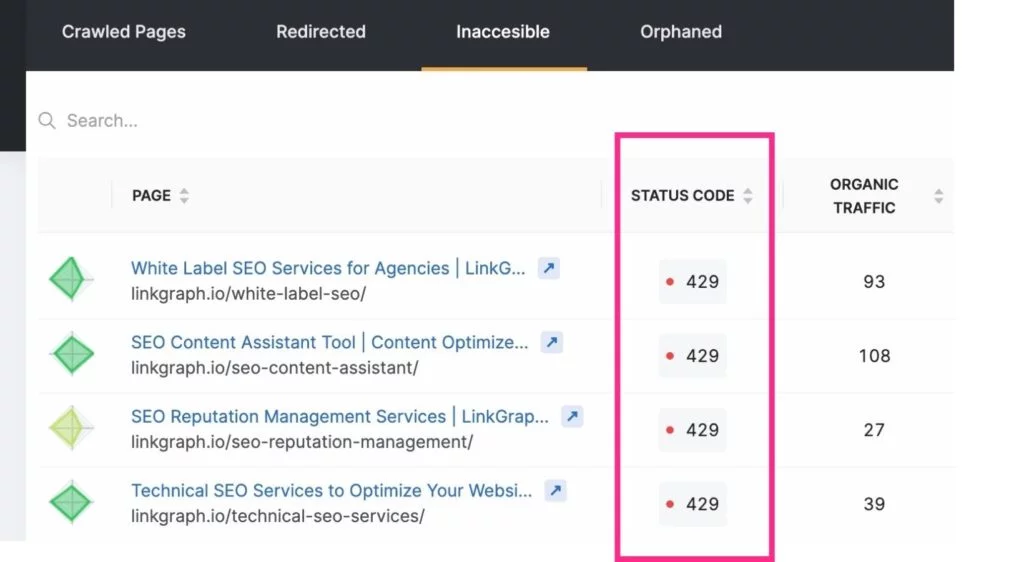

หากต้องการติดตามข้อผิดพลาดที่พบเมื่อเข้ารวบรวมข้อมูลเหล่านี้ คุณสามารถใช้ดัชนี > รายงานความครอบคลุมของบัญชี Google Search Console หรือใช้ เครื่องมือตรวจสอบไซต์ของ SearchAtlas เพื่อค้นหารายงานข้อผิดพลาดไซต์ของคุณเพื่อส่งต่อไปยังนักพัฒนาเว็บของคุณ

หมายเหตุ: URL ใหม่อาจไม่ปรากฏในการวิเคราะห์ไฟล์บันทึกของคุณในทันที ให้เวลา Google ค้นหาก่อนที่จะขอรวบรวมข้อมูล

6. ปรับปรุงความเร็วในการโหลดหน้าเว็บ

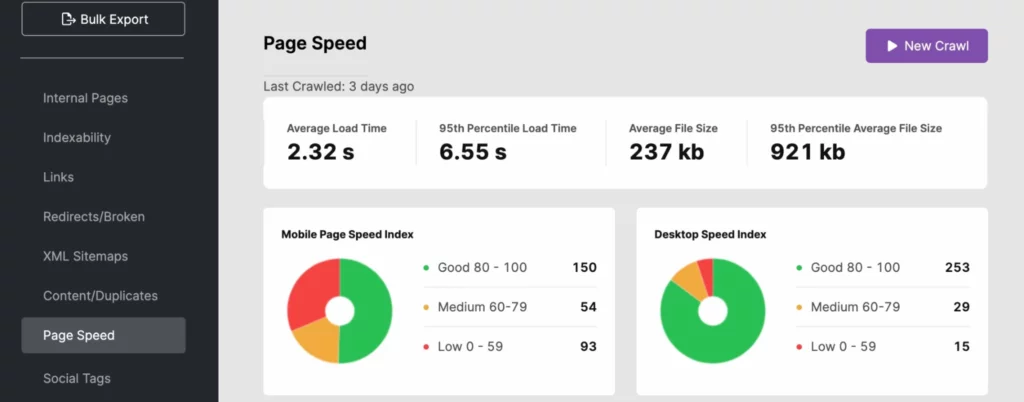

บอทของเครื่องมือค้นหาสามารถเคลื่อนที่ผ่านไซต์ได้อย่างรวดเร็ว อย่างไรก็ตาม หากความเร็วไซต์ของคุณไม่ถึงระดับเดียวกัน อาจต้องใช้งบประมาณในการรวบรวมข้อมูลของคุณอย่างมาก ใช้การวิเคราะห์ไฟล์บันทึกของคุณ, SearchAtlas หรือ PageSpeedInsights เพื่อพิจารณาว่าเวลาในการโหลดไซต์ของคุณส่งผลเสียต่อการมองเห็นการค้นหาของคุณหรือไม่

หากต้องการปรับปรุงเวลาตอบสนองของไซต์ ให้ใช้ URL แบบไดนามิกและปฏิบัติตาม แนวทางปฏิบัติที่ดีที่สุด ของ Google Core Web Vitals ซึ่งอาจรวมถึงการเพิ่มประสิทธิภาพรูปภาพสำหรับสื่อครึ่งหน้าบน

หากปัญหาความเร็วไซต์อยู่ที่ฝั่งเซิร์ฟเวอร์ คุณอาจต้องการลงทุนในทรัพยากรเซิร์ฟเวอร์อื่นๆ เช่น:

- เซิร์ฟเวอร์เฉพาะ (โดยเฉพาะสำหรับไซต์ขนาดใหญ่)

- การอัปเกรดเป็นฮาร์ดแวร์เซิร์ฟเวอร์ที่ใหม่กว่า

- การเพิ่มแรม

การปรับปรุงเหล่านี้จะช่วยเพิ่มประสบการณ์ผู้ใช้ของคุณ ซึ่งสามารถช่วยให้ไซต์ของคุณทำงานได้ดีขึ้นในการค้นหาโดย Google เนื่องจากความเร็วไซต์เป็นสัญญาณสำหรับ PageRank

7. อย่าลืมใช้ Canonical Tags

เนื้อหาที่ซ้ำกันจะถูกมองข้ามโดย Google อย่างน้อยเมื่อคุณไม่รับทราบว่าเนื้อหาที่ซ้ำกันมีหน้าแหล่งที่มา ทำไม Googlebot รวบรวมข้อมูลทุกหน้าเว้นแต่จะหลีกเลี่ยงไม่ได้ เว้นแต่จะได้รับคำแนะนำให้ทำอย่างอื่น อย่างไรก็ตาม เมื่อพบหน้าเว็บที่ซ้ำกันหรือสำเนาของสิ่งที่คุ้นเคย (ในหน้าเว็บหรือนอกไซต์) ก็จะหยุดรวบรวมข้อมูลหน้านั้น และในขณะที่สิ่งนี้ช่วยประหยัดเวลา คุณควรประหยัดเวลาให้โปรแกรมรวบรวมข้อมูลมากยิ่งขึ้นโดยใช้แท็กบัญญัติที่ระบุ URL ตามรูปแบบบัญญัติ

Canonicals บอกให้ Googlebot ไม่ต้องกังวลกับช่วงเวลาการรวบรวมข้อมูลของคุณในการจัดทำดัชนีเนื้อหานั้น สิ่งนี้ทำให้บอทเครื่องมือค้นหามีเวลามากขึ้นในการตรวจสอบหน้าอื่นๆ ของคุณ

8. มุ่งเน้นไปที่โครงสร้างการเชื่อมโยงภายในของคุณ

การมีแนวทางปฏิบัติในการเชื่อมโยงที่มีโครงสร้างที่ดีภายในไซต์ของคุณสามารถเพิ่มประสิทธิภาพในการรวบรวมข้อมูลของ Google ลิงก์ภายในจะบอก Google ว่าหน้าใดในไซต์ของคุณที่สำคัญที่สุด และลิงก์เหล่านี้ช่วยให้โปรแกรมรวบรวมข้อมูลค้นหาหน้าต่างๆ ได้ง่ายขึ้น

โครงสร้างการเชื่อมโยงที่ดีที่สุดจะเชื่อมโยงผู้ใช้และ Googlebots กับเนื้อหาทั่วทั้งเว็บไซต์ของคุณ ใช้ anchor text ที่เกี่ยวข้องเสมอ และวางลิงก์ของคุณอย่างเป็นธรรมชาติในเนื้อหาของคุณ

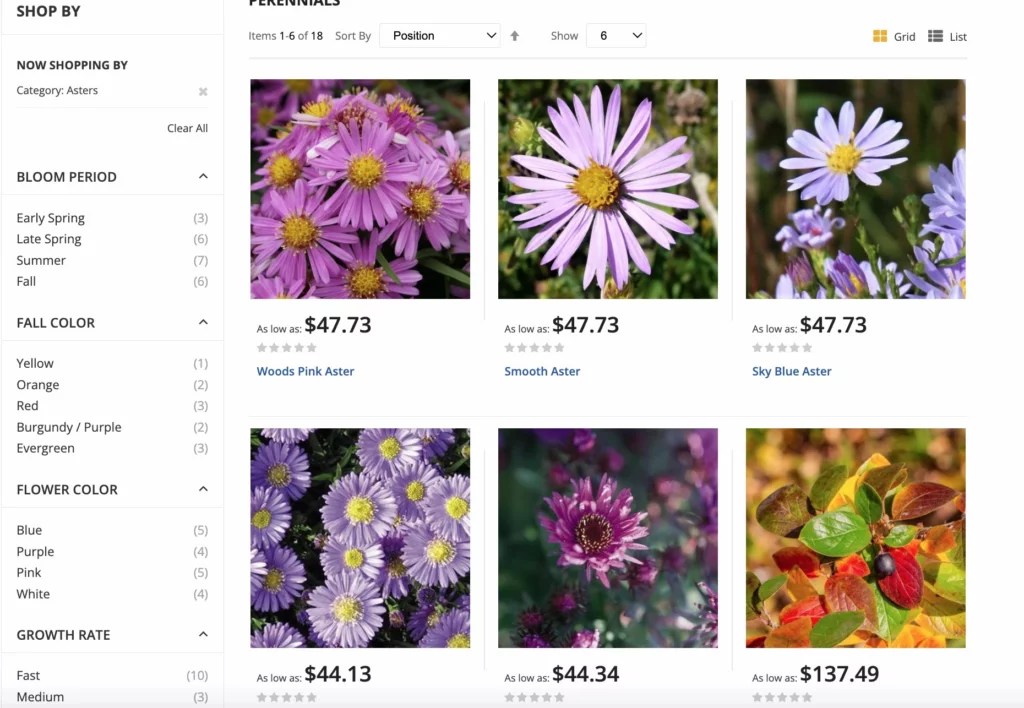

สำหรับไซต์อีคอมเมิร์ซ Google มีแนวทางปฏิบัติที่ดีที่สุดสำหรับตัวเลือกการนำทางแบบเหลี่ยมเพชรพลอย เพื่อเพิ่มการรวบรวมข้อมูลให้ได้มากที่สุด การนำทางแบบประกอบช่วยให้ผู้ใช้ไซต์สามารถกรองผลิตภัณฑ์ตามคุณลักษณะ ทำให้การช็อปปิ้งเป็นประสบการณ์ที่ดียิ่งขึ้น การอัปเดตนี้ช่วยหลีกเลี่ยงความสับสนตามรูปแบบบัญญัติและปัญหาที่ซ้ำกัน นอกเหนือจากการรวบรวมข้อมูล URL ที่มากเกินไป

9. ตัดเนื้อหาที่ไม่จำเป็นออก

Googlebots สามารถเคลื่อนที่ได้เร็วและจัดทำดัชนีหน้าเว็บจำนวนมากทุกครั้งที่รวบรวมข้อมูลไซต์ หากคุณมีหน้าเว็บจำนวนมากที่ไม่ได้รับการเข้าชมหรือมีเนื้อหาที่ล้าสมัยหรือคุณภาพต่ำ ให้ตัดทิ้ง! กระบวนการตัดแต่ง ช่วยให้คุณสามารถตัดสัมภาระส่วนเกินของไซต์ของคุณที่สามารถชั่งน้ำหนักได้

การมีหน้าเว็บมากเกินไปในไซต์ของคุณอาจทำให้ Googlebots เปลี่ยนไปใช้หน้าที่ไม่สำคัญโดยไม่สนใจหน้าต่างๆ

อย่าลืมเปลี่ยนเส้นทางลิงก์ไปยังหน้าเหล่านี้ เพื่อไม่ให้เกิดข้อผิดพลาดที่พบเมื่อเข้ารวบรวมข้อมูล

10. รับลิงก์ย้อนกลับมากขึ้น

เมื่อ Googlebots มาถึงไซต์ของคุณแล้วเริ่มจัดทำดัชนีหน้าตามลิงก์ภายใน พวกเขายังใช้ลิงก์ภายนอกในกระบวนการจัดทำดัชนี หากไซต์อื่นเชื่อมโยงมายังไซต์ของคุณ Googlebot จะเดินทางไปยังไซต์ของคุณและไปยังหน้าดัชนีเพื่อให้เข้าใจเนื้อหาที่เชื่อมโยงได้ดีขึ้น

นอกจากนี้ ลิงก์ย้อนกลับ ยัง ทำให้ไซต์ของคุณได้รับความนิยมและความใหม่มากขึ้นเล็กน้อย ซึ่ง Google ใช้เพื่อกำหนดว่าไซต์ของคุณต้องได้รับการจัดทำดัชนีบ่อยเพียงใด

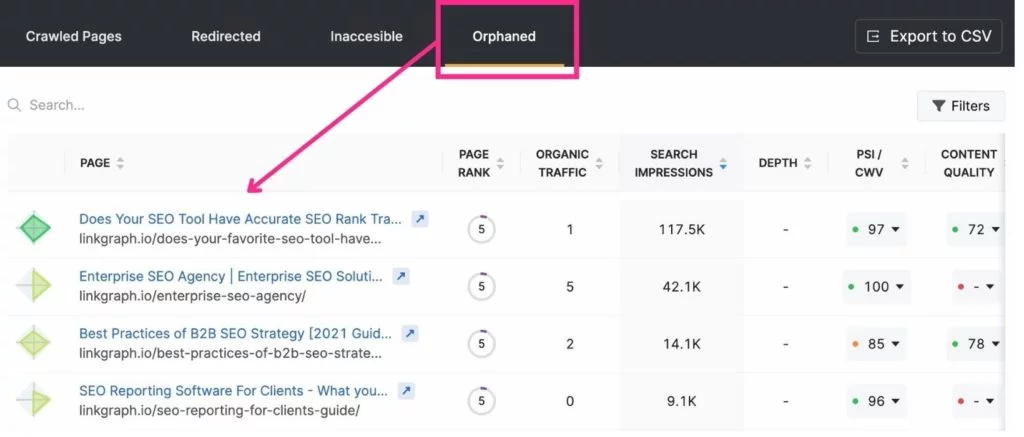

11. กำจัดหน้าเด็กกำพร้า

เนื่องจากโปรแกรมรวบรวมข้อมูลของ Google กระโดดจากหน้าหนึ่งไปยังอีกหน้าหนึ่งผ่านลิงก์ภายใน จึงสามารถค้นหาหน้าที่ลิงก์ไปได้อย่างง่ายดาย อย่างไรก็ตาม หน้าเว็บที่ไม่ได้เชื่อมโยงไปยังที่ใดที่หนึ่งบนไซต์ของคุณมักจะไม่ถูกสังเกตโดย Google สิ่งเหล่านี้เรียกว่า "หน้ากำพร้า"

เมื่อหน้าเด็กกำพร้าเหมาะสม? หากเป็นหน้า Landing Page ที่มีจุดประสงค์หรือผู้ชมที่เฉพาะเจาะจงมาก ตัวอย่างเช่น หากคุณส่งอีเมลถึงนักกอล์ฟที่อาศัยอยู่ในไมอามีโดยมีหน้า Landing Page ที่ใช้ได้กับพวกเขาเท่านั้น คุณอาจไม่ต้องการเชื่อมโยงไปยังหน้าดังกล่าวจากที่อื่น

เครื่องมือที่ดีที่สุดสำหรับการเพิ่มประสิทธิภาพงบประมาณการรวบรวมข้อมูล

Search Console และ Google Analytics มีประโยชน์มากเมื่อต้องการเพิ่มประสิทธิภาพงบประมาณการรวบรวมข้อมูลของคุณ Search Console อนุญาตให้คุณขอโปรแกรมรวบรวมข้อมูลเพื่อจัดทำดัชนีหน้าเว็บและติดตามสถิติการรวบรวมข้อมูลของคุณ Google Analytics ช่วยคุณติดตามเส้นทางการเชื่อมโยงภายในของคุณ

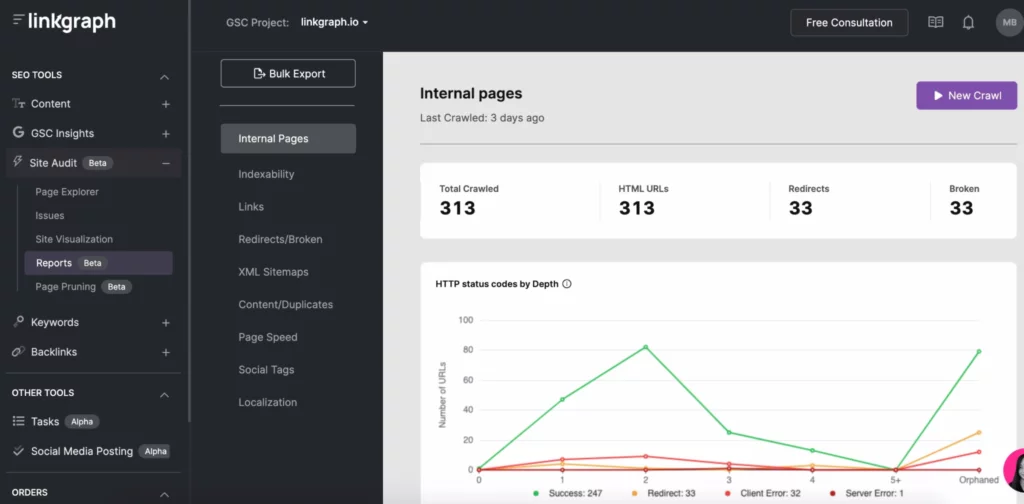

เครื่องมือ SEO อื่นๆ เช่น SearchAtlas ช่วยให้คุณค้นหาปัญหาในการรวบรวมข้อมูลได้อย่างง่ายดายผ่านเครื่องมือตรวจสอบไซต์ ด้วยรายงานเดียว คุณสามารถดูไซต์ของคุณ:

- รายงานการรวบรวมข้อมูลการจัดทำดัชนี

- ความลึกของดัชนี

- ความเร็วหน้า

- เนื้อหาที่ซ้ำกัน

- แผนผังไซต์ XML

- ลิงค์

ปรับงบประมาณการรวบรวมข้อมูลให้เหมาะสมและเป็นเครื่องมือค้นหาที่มีประสิทธิภาพสูงสุด

แม้ว่าคุณจะไม่สามารถควบคุมความถี่ที่เครื่องมือค้นหาจะจัดทำดัชนีไซต์ของคุณหรือนานเท่าใด แต่คุณก็สามารถเพิ่มประสิทธิภาพไซต์ของคุณเพื่อให้ได้รับประโยชน์สูงสุดจากการรวบรวมข้อมูลของเครื่องมือค้นหาแต่ละรายการ เริ่มต้นด้วยบันทึกของเซิร์ฟเวอร์และดูรายงานการรวบรวมข้อมูลใน Search Console ให้ละเอียดยิ่งขึ้น จากนั้นให้แก้ไขข้อผิดพลาดที่พบเมื่อเข้ารวบรวมข้อมูล โครงสร้างลิงก์ และปัญหาเกี่ยวกับความเร็วของหน้าเว็บ

ขณะที่คุณทำงานผ่านกิจกรรมการรวบรวมข้อมูล GSC ให้เน้นไปที่กลยุทธ์ SEO ที่เหลือ รวมถึง การ สร้างลิงก์ และการเพิ่ม เนื้อหาที่มี คุณภาพ เมื่อเวลาผ่านไป คุณจะพบว่าหน้า Landing Page ของคุณไต่ขึ้นหน้าผลลัพธ์ของเครื่องมือค้นหา