BERT: Google'ın Son Yıllardaki En Büyük Güncellemesi

Yayınlanan: 2022-12-01Google'ın BERT'si 2019'un sonlarında yayına girdi ve tüm aramaların neredeyse %10'unu etkiledi. Muhtemelen 2019'un en büyük algoritma güncellemelerinden biri olan SEO uzmanları ve site sahiplerinin Google'ın gelişmiş doğal dil işleme modeli hakkında bilmesi gereken her şey burada.

Google'ın BERT değeri nedir?

BERT, bir derin öğrenme algoritmasıdır ve Transformers'tan Çift Yönlü Kodlayıcı Temsillerinin kısaltmasıdır. Algoritma, karmaşık arama sorguları için daha alakalı sonuçların ortaya çıkmasına yardımcı oldu.

BERT algoritması güncellemesinin Google aramasına etkisi neydi?

Google'ın söylediği buydu:

"BERT, Arama'nın Aramalar'daki kelimelerin nüansını ve bağlamını daha iyi anlamasına ve bu sorguları faydalı sonuçlarla daha iyi eşleştirmesine yardımcı olduğundan, bu iyileştirmeler, özellikle daha doğal dil/konuşma sorguları için dil anlayışını geliştirmeye yöneliktir.

Arama, özellikle daha uzun, daha diyaloglu sorgular veya "for" ve "to" gibi edatların anlam açısından çok önemli olduğu aramalar için, sorgunuzdaki kelimelerin bağlamını anlayabilir. Size doğal gelen bir şekilde arama yapabilirsiniz.”

Aslında, Google'a göre BERT güncellemesi ABD'deki 10 İngilizce aramadan 1'ini etkileyecek, bu da arama sorgularının %10'u demek. Bu, en azından onlara göre Google'ın son 5 yıldaki en önemli güncellemesi:

Son beş yıldaki en büyük sıçramayı ve Arama tarihindeki en büyük sıçramalardan birini temsil eden, sorguları anlama biçimimizde önemli bir iyileştirme yapıyoruz.

BERT'nin tanıtılması, yeni algoritmanın konuşlandırılmasının ilk haftasında büyük sıralama dalgalanmalarına neden oldu. Webmaster World'deki SEO'lar haftanın başından beri dalgalanmalar hakkında yorum yapıyor ve RankBrain'den bu yana SEO dünyasını vuran en büyük sıralama dalgalanmasına dikkat çekiyor.

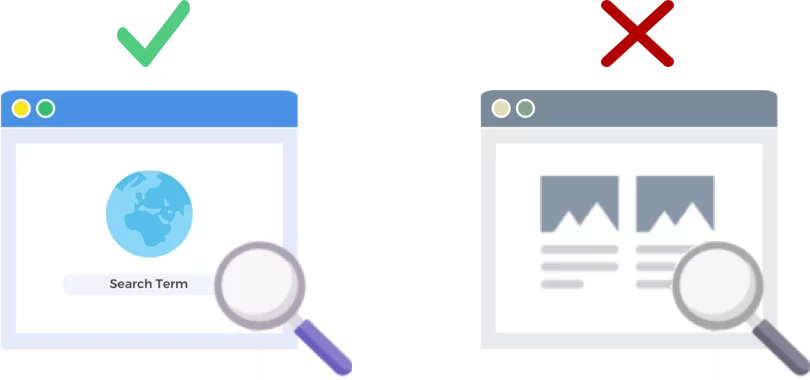

BERT, Web Sayfalarını DEĞİL Arama Sorgularını Analiz Eder

BERT algoritmasının 24 Ekim 2019 tarihli sürümü, arama motoru devinin arama sorgularını (web sayfalarını değil) analiz etme ve anlama şeklini geliştiriyor.

BERT Nasıl Çalışır?

BERT, iki yönlü (BERT'teki B'dir) bağlam modelini kullanarak Google'ın arama sorguları anlayışını geliştirir. Google, BERT'yi Doğal Dil İşleme (NLP) ön eğitimi için yeni bir teknik olarak duyurduklarında, geçen yıl bu zamanlarda BERT'nin mekaniği hakkında biraz konuştu.

Ön eğitim nedir? Ön eğitim, makineye gerçekten iş vermeden önce görevleri nasıl yapacağını öğretmektir. Geleneksel olarak eğitim öncesi veri kümeleri, insan etiketli birkaç bin ila birkaç yüz bin örnekle yüklenir.

Ön eğitim bir süredir var, ancak BERT'yi özel kılan şey, hem bağlamsal (her kelimenin anlamı, etrafındaki kelimelere göre değişir) hem de çift yönlü olmasıdır - bir kelimenin anlamı, hem ondan önceki hem de önceki kelimelere göre anlaşılır. ondan sonra.

Google'ın Bloguna göre:

" Banka hesabına eriştim" cümlesinde tek yönlü bir bağlamsal model, "hesaba" değil " hesaba eriştim "e dayalı " banka "yı temsil eder. Bununla birlikte, BERT, derin bir sinir ağının en altından başlayarak hem önceki hem de sonraki bağlamını - " Hesaba eriştim " - kullanarak " bankayı " temsil eder ve onu derinden çift yönlü hale getirir.

Google BERT güncellemesi, makine öğrenimi ve varlık tanıma alanındaki son gelişmelere dayanmaktadır. Temel olarak BERT, Google'ın bir aramayı işleme koymasından önce konuşmanın tüm bölümlerini ve kelimelerin bağlamını belirlemeye yardımcı olur.

Arama Sonuçları İçin BERT Ne Demektir?

Google'a göre bu, kullanıcıların daha alakalı sonuçlar, kullanıcının arama amacına daha iyi uyan sonuçlar görmeye başlayacakları anlamına geliyor. Bu algoritma iyileştirmesi, düzenli sonuçları ve zengin snippet sonuçlarını kapsayacaktır.

Google, BERT'i duyuran blog girişlerinde birkaç yararlı örnek sağladı.

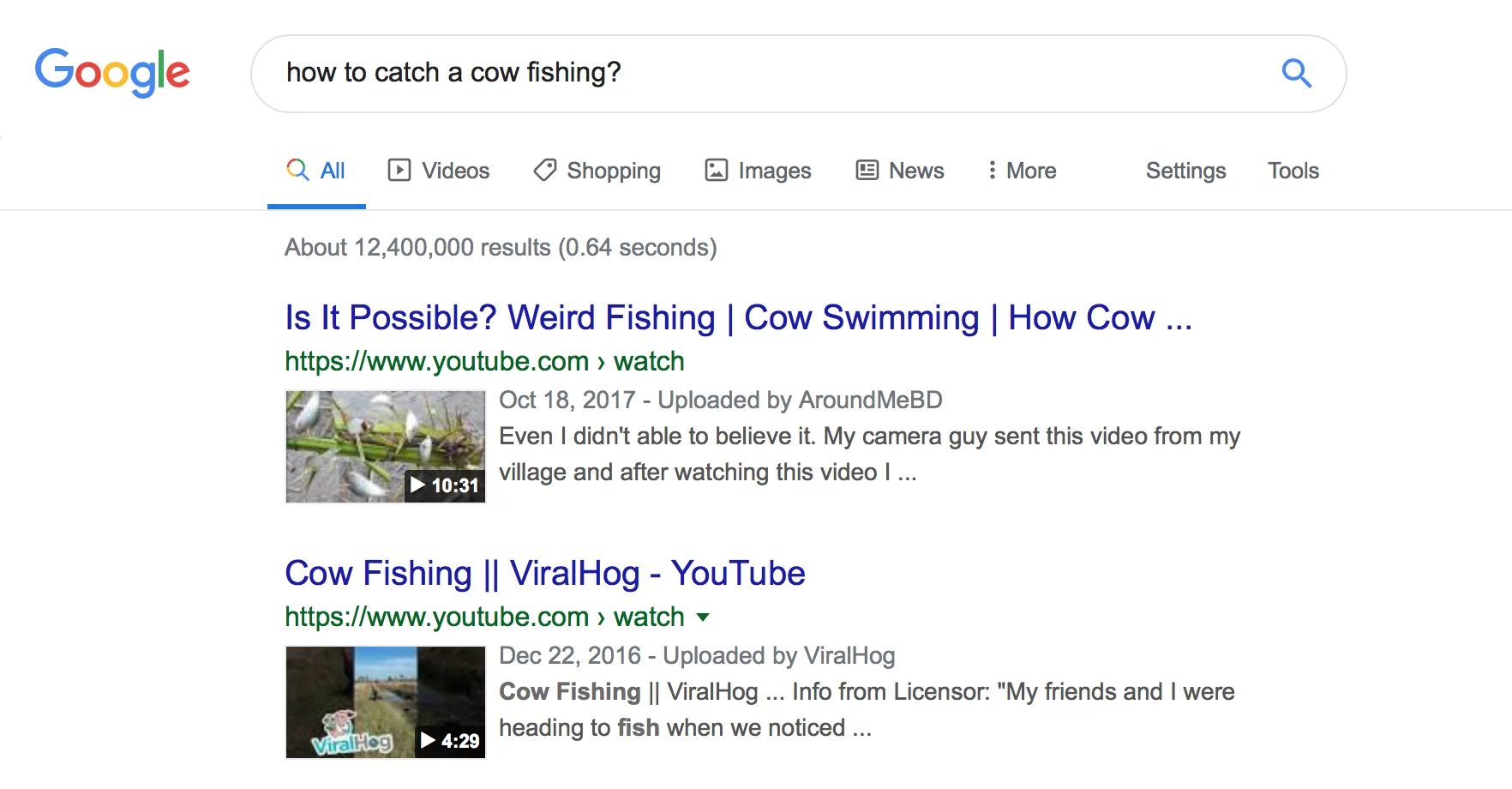

Estetisyen Örneği

İlk olarak, Estetisyenlerin işin bir parçası olarak ayakta çok fazla zaman geçirip geçirmediğini anlamaya çalışan bir kullanıcımız var.

Aşağıda BERT Google'ın “estetisyenler iş başında çok mu duruyor” sorgusunu okuyup estetisyenler için çalışma ortamlarını karşılaştıran bir sonuç ürettiğini aşağıda görebilirsiniz.

BERT'ten sonra Google, bir estetisyen olmanın fiziksel talepleri üzerine, araştırmacının başlangıçta ortaya çıkarmaya çalıştığı bilgilerle çok daha uyumlu bir makale ortaya çıkarıyor.

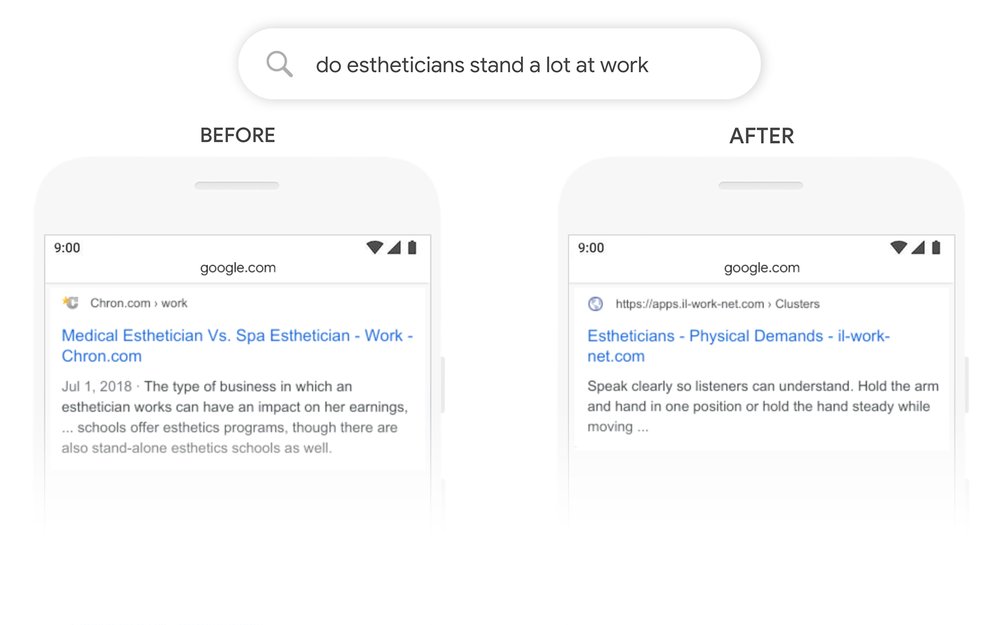

Matematik Alıştırma Kitapları Örneği

Bu örnekte, bir kullanıcı yetişkinler için matematik alıştırma kitapları arıyor, ancak çocuklar için matematik alıştırma kitapları gösteriyor.

BERT'den sonra Google, "yetişkinler için" aramasının ikinci bölümünü daha iyi hesaba katarak sorgunun bağlamını doğru bir şekilde tanır.

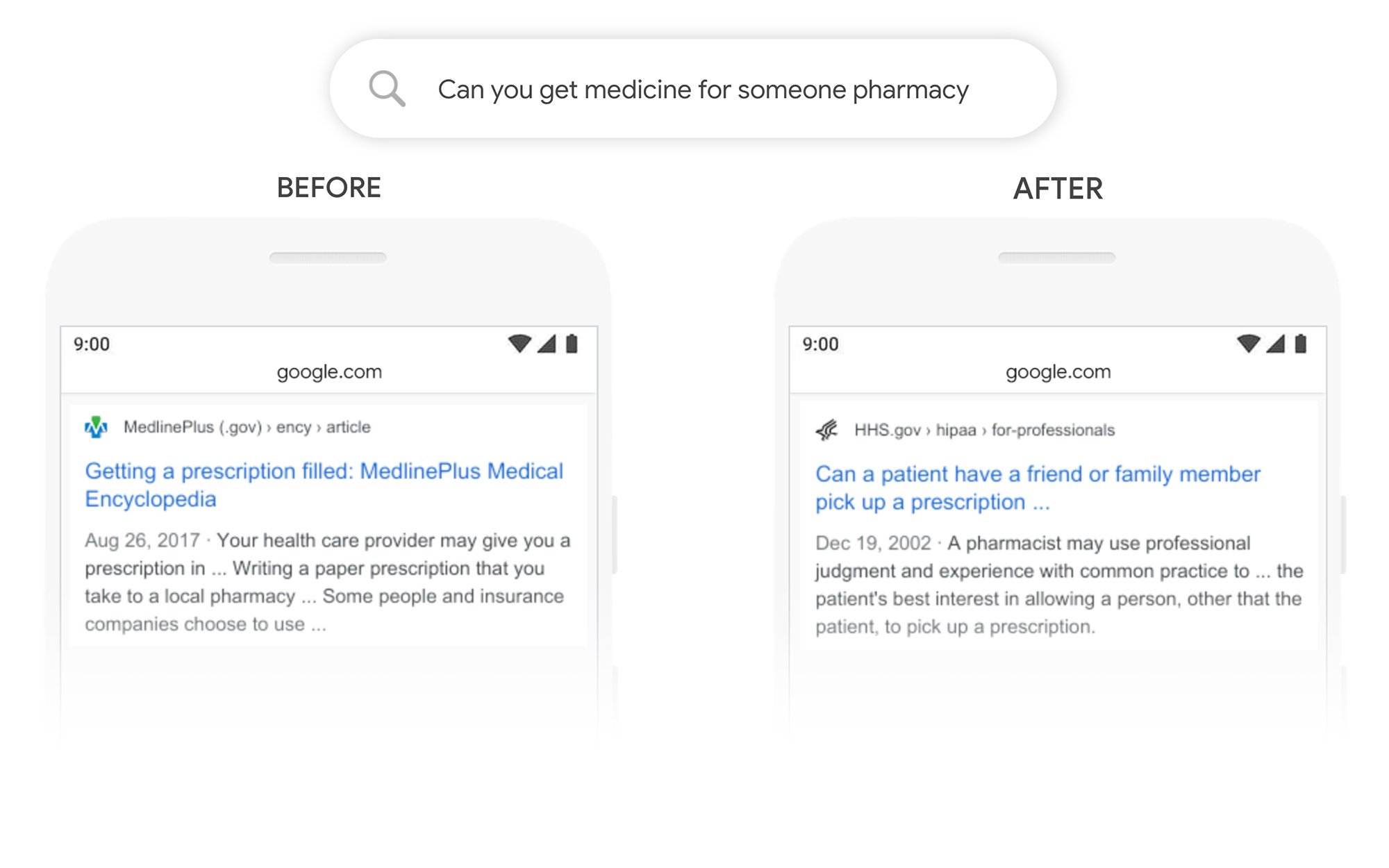

Başkası İçin İlaç Alabilir Misiniz Örneği

Bu örnekte “bir eczane için ilaç alabilir misiniz” sorgusu, reçetelerin 3. bir taraf için nasıl doldurulacağından ziyade genel olarak nasıl doldurulacağı ile ilgili bir sonuç verir. BERT'den sonra Google, kullanıcının amacını daha iyi anlar ve bir hastanın reçetesini kendisi için bir arkadaşına veya aile üyesine teslim alıp alamayacağına dair bir bilgi sunar.

BERT'ten Sonra Daha İyi Sıralanmak İçin Ne Yapabilirim?

Sıralamayı kaybettiğiniz herhangi bir anahtar kelime için, Google'ın hedef terimlerinizin arama amacını nasıl gördüğünü daha iyi anlamak için revize edilmiş arama sonuçları sayfasına bir göz atmalısınız. Ardından, kullanıcının hedeflerini daha iyi karşılamak için içeriğinizi buna göre revize edin.

BERT kapsamında sıralamaları kaybettiyseniz, bunun içerik kalitesi sorunu olmaktan çok, sayfanızın bir kullanıcının arama amacıyla ne kadar iyi eşleştiği (bir kullanıcının hedefine ulaşmasına yardımcı olduğu) ile ilgili bir sorun olması daha olasıdır.

BERT'in sesli arama çabalarını zaman içinde daha fazla destekleyeceği göz önüne alındığında, web sitelerinin açık ve öz bir metin yazmalarını da öneririz. Dolgu dili kullanmayın, belirsiz olmayın, doğrudan konuya gelin.

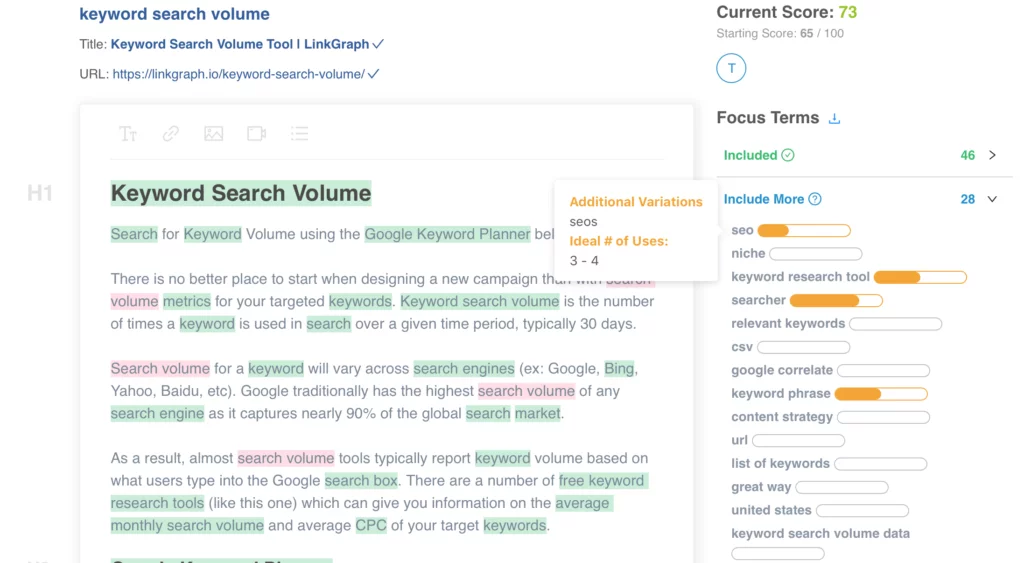

İçeriğinizi optimize etmek için yardıma mı ihtiyacınız var? LinkGraph'ın Sayfa İçi İçerik İyileştiricisine göz atın, [email protected] adresinden ekibimizin bir üyesine ulaşın veya kurulum için bugün bir toplantı planlayın.

Daha Fazlasını Nereden Öğrenebilirim?

Dawn Anderson, bu ayın başlarında Pubcon'da "Google BERT ve Aile ve Doğal Dil Anlama Liderlik Yarışı" konulu harika bir sunum yaptı ve sunumuna göz atabilirsiniz.

#Pubcon'umu aldığınız için teşekkürler. İşte benim destem <3 <3 https://t.co/aGYDI9pfdY

- Dawn Anderson (@dawnieando) 10 Ekim 2019

Jeff Dean ayrıca kısa bir süre önce BERT de dahil olmak üzere Google'da AI üzerine izleyebileceğiniz bir açılış konuşması yaptı.