Tarama bütçesi nedir ve akıllı bir şekilde nasıl optimize edilir?

Yayınlanan: 2021-08-19İçindekiler

Tarama bütçesi analizi, herhangi bir SEO uzmanının (özellikle büyük web siteleriyle uğraşıyorlarsa) iş görevleri arasındadır. Google tarafından sağlanan materyallerde yeterince kapsanan önemli bir görev. Yine de Twitter'da görebileceğiniz gibi, Google çalışanları bile daha iyi trafik ve sıralama elde etmede tarama bütçesinin rolünü küçümsüyor:

Bu konuda haklılar mı?

Google nasıl çalışır ve veri toplar?

Konuyu açarken, arama motorunun bilgileri nasıl topladığını, dizine eklediğini ve düzenlediğini hatırlayalım. Bu üç adımı aklınızın bir köşesinde tutmak, web sitesinde daha sonraki çalışmalarınız sırasında çok önemlidir:

Adım 1: Tarama . Mevcut tüm bağlantıları, dosyaları ve verileri keşfetmek ve bunlar arasında gezinmek amacıyla çevrimiçi kaynakları taramak. Genel olarak Google, Web'deki en popüler yerlerle başlar ve ardından daha az trend olan diğer kaynakları taramaya devam eder.

Adım 2: İndeksleme . Google, sayfanın ne hakkında olduğunu ve analiz edilen içeriğin/belgenin benzersiz mi yoksa yinelenen materyal mi oluşturduğunu belirlemeye çalışır. Bu aşamada Google, içeriği gruplandırır ve bir önem sırası belirler ( rel=”canonical” veya rel=”alternate” etiketlerindeki önerileri okuyarak veya başka bir şekilde).

Adım 3: Servis . Bölümlere ayrıldıktan ve dizine eklendikten sonra veriler, kullanıcı sorgularına yanıt olarak görüntülenir. Bu aynı zamanda Google'ın kullanıcının konumu gibi faktörleri göz önünde bulundurarak verileri uygun şekilde sıraladığı zamandır.

Önemli: Mevcut malzemelerin çoğu 4. Adım: içerik oluşturmayı gözden kaçırır. Varsayılan olarak, Googlebot metin içeriğini dizine ekler. Ancak, web teknolojileri gelişmeye devam ederken, Google'ın sadece “okumayı” bırakıp “görmeye” başlamak için yeni çözümler geliştirmesi gerekti. Rendering bununla ilgili. Google'ın yeni başlatılan web siteleri arasındaki erişimini önemli ölçüde iyileştirmesine ve dizini genişletmesine hizmet eder.

Not : Tarama bütçesinin başarısız olmasının nedeni içerik oluşturmayla ilgili sorunlar olabilir.

Tarama bütçesi nedir?

Tarama bütçesi, tarayıcıların ve arama motoru botlarının web sitenizi dizine ekleme sıklığının yanı sıra tek bir taramada erişebilecekleri toplam URL sayısından başka bir şey değildir. Tarama bütçenizi, bir hizmette veya uygulamada harcayabileceğiniz krediler olarak hayal edin. Tarama bütçenizi "şarj etmeyi" hatırlamıyorsanız, robot yavaşlayacak ve size daha az ziyaret yapacaktır.

SEO'da “ücretlendirme”, bir web sitesinin genel popülaritesini iyileştirmek veya geri bağlantılar elde etmek için yapılan çalışmayı ifade eder. Sonuç olarak, tarama bütçesi, Web'in tüm ekosisteminin ayrılmaz bir parçasıdır. İçerik ve geri bağlantılar üzerinde iyi bir iş çıkardığınızda, mevcut tarama bütçenizin sınırını yükseltmiş olursunuz.

Google, kaynaklarında tarama bütçesini açıkça tanımlamak için hiçbir girişimde bulunmaz. Bunun yerine, Googlebot'un eksiksizliğini ve ziyaretlerinin sıklığını etkileyen iki temel tarama bileşenine işaret eder:

- tarama hızı sınırı;

- tarama talebi.

Tarama hızı limiti nedir ve nasıl kontrol edilir?

En basit ifadeyle, tarama hızı sınırı, Googlebot'un sitenizi tararken kurabileceği eşzamanlı bağlantıların sayısıdır. Google, kullanıcı deneyimine zarar vermek istemediğinden, web sitenizin/sunucunuzun sorunsuz performansını sürdürmek için bağlantı sayısını sınırlar. Kısacası, web siteniz ne kadar yavaşsa, tarama hızı limitiniz o kadar küçük olur.

Önemli: Tarama limiti ayrıca web sitenizin genel SEO sağlığına da bağlıdır – siteniz birçok yönlendirmeyi, 404/410 hatasını tetiklerse veya sunucu genellikle 500 durum kodu döndürürse, bağlantı sayısı da azalır.

Google Arama Konsolunda, Tarama İstatistikleri raporunda bulunan bilgilerle tarama hızı sınırı verilerini analiz edebilirsiniz.

Tarama talebi veya web sitesi popülerliği

Tarama hızı sınırı, web sitenizin teknik ayrıntılarını cilalamanızı gerektirirken, tarama talebi, web sitenizin popülerliği için sizi ödüllendirir. Kabaca söylemek gerekirse, web sitenizdeki (ve üzerindeki) vızıltı ne kadar büyük olursa, tarama talebi de o kadar büyük olur.

Bu durumda, Google iki konunun stokunu alır:

- Genel popülerlik – Google, İnternet'te genellikle popüler olan URL'leri sık sık taramaya daha isteklidir (mutlaka en fazla sayıda URL'den geri bağlantıya sahip olanlar değil).

- Dizin verilerinin güncelliği – Google yalnızca en son bilgileri sunmaya çalışır. Önemli: Gittikçe daha fazla yeni içerik oluşturmak, genel tarama bütçe sınırınızın artacağı anlamına gelmez.

Tarama bütçesini etkileyen faktörler

Önceki bölümde, tarama bütçesini, tarama hızı sınırı ve tarama talebinin bir kombinasyonu olarak tanımlamıştık. Web sitenizin uygun şekilde taranmasını (ve dolayısıyla dizine eklenmesini) sağlamak için her ikisiyle de aynı anda ilgilenmeniz gerektiğini unutmayın.

Aşağıda, tarama bütçesi optimizasyonu sırasında göz önünde bulundurulması gereken noktaların basit bir listesini bulacaksınız.

- Sunucu – ana konu performanstır. Hızınız ne kadar düşükse, Google'ın yeni içeriğinizi dizine eklemek için daha az kaynak ataması riski o kadar yüksek olur.

- Sunucu yanıt kodları – web sitenizdeki 301 yönlendirmeleri ve 404/410 hataları ne kadar büyükse, o kadar kötü indeksleme sonuçları alırsınız. Önemli: Yönlendirme döngülerine dikkat edin – her "atlama", botun bir sonraki ziyareti için web sitenizin tarama hızı sınırını azaltır.

- robots.txt dosyasındaki bloklar – robots.txt yönergelerinizi içgüdüsel bir duyguya dayandırıyorsanız, indeksleme darboğazları yaratabilirsiniz. Sonuç: Dizini temizlersiniz, ancak yeni sayfalar için dizine ekleme etkinliğiniz pahasına (engellenen URL'ler tüm web sitesinin yapısına sağlam bir şekilde yerleştirildiğinde).

- Yönlü gezinme / oturum tanımlayıcıları / URL'lerdeki herhangi bir parametre - en önemlisi, tek parametreli bir adresin herhangi bir kısıtlama olmaksızın daha fazla parametreleştirilebileceği durumlara dikkat edin. Bu olursa, Google sonsuz sayıda adrese ulaşacak ve mevcut tüm kaynakları web sitemizin daha az önemli kısımlarına harcayacaktır.

- Yinelenen içerik – kopyalanan içerik (yamyamlaştırma dışında), yeni içeriğin dizine eklenmesinin etkinliğine önemli ölçüde zarar verir.

- İnce İçerik – bir sayfanın metin/HTML oranı çok düşük olduğunda ortaya çıkar. Sonuç olarak, Google, sayfayı Soft 404 olarak tanımlayabilir ve içeriğinin dizine eklenmesini kısıtlayabilir (içerik anlamlı olduğunda bile, örneğin, tek bir ürün sunan ve benzersiz olmayan bir üreticinin sayfasındaki durum söz konusu olabilir). Metin içeriği).

- Zayıf dahili bağlantı veya bunların eksikliği .

Tarama bütçesi analizi için faydalı araçlar

Tarama bütçesi için bir ölçüt olmadığından (bu, web siteleri arasındaki sınırları karşılaştırmanın zor olduğu anlamına gelir), veri toplama ve analizini kolaylaştırmak için tasarlanmış bir dizi araçla donatın.

Google Arama Konsolu

GSC yıllar içinde güzelce büyüdü. Tarama bütçesi analizi sırasında incelememiz gereken iki ana rapor vardır: Dizin Kapsamı ve Tarama istatistikleri.

GSC'de Endeks Kapsamı

Rapor büyük bir veri kaynağıdır. İndeksleme dışında bırakılan URL'ler hakkındaki bilgileri kontrol edelim. Karşılaştığınız sorunun boyutunu anlamanın harika bir yolu.

Tüm raporlar ayrı bir makaleyi garanti eder, bu nedenle şimdilik aşağıdaki bilgilere odaklanalım:

- 'noindex' etiketi tarafından hariç tutuldu – Genel olarak, daha fazla noindex sayfası daha az trafik anlamına gelir. Hangi soruyu soruyor - onları web sitesinde tutmanın amacı nedir? Bu sayfalara erişim nasıl kısıtlanır?

- Tarandı – şu anda dizine eklenmemiş – bunu görürseniz, içeriğin Googlebot'un gözünde doğru şekilde oluşturulup oluşturulmadığını kontrol edin. Bu durumdaki her URL'nin, organik trafik oluşturmadığı için tarama bütçenizi boşa harcadığını unutmayın.

- Keşfedildi - şu anda dizine eklenmemiş - öncelik listenizin en üstüne koymaya değer daha endişe verici sorunlardan biri.

- Kullanıcı tarafından seçilen standart olmadan kopyalayın - tüm yinelenen sayfalar, yalnızca tarama bütçenize zarar vermekle kalmaz, aynı zamanda yamyamlık riskini de artırdığından son derece tehlikelidir.

- Yinelenen, Google, kullanıcıdan farklı bir standart seçti - teorik olarak endişelenmenize gerek yok. Ne de olsa Google, bizim yerimize sağlıklı bir karar verecek kadar akıllı olmalı. Gerçekte, Google standartlarını oldukça rastgele seçer - genellikle ana sayfayı standart bir işaretle değerli sayfaları keser.

- Soft 404 – tüm "yumuşak" hatalar, kritik sayfaların dizinden kaldırılmasına yol açabileceğinden son derece tehlikelidir.

- Yinelenen, gönderilen URL standart olarak seçilmedi - kullanıcı tarafından seçilen standartların eksikliğiyle ilgili durum raporlamasına benzer.

Tarama istatistikleri

Rapor mükemmel değil ve tavsiyeler söz konusu olduğunda, verilere (ve daha fazla modelleme seçeneği) daha derin bir bakış açısı sağlayan eski güzel sunucu günlükleriyle de oynamanızı şiddetle tavsiye ediyorum.

Daha önce de söylediğim gibi, yukarıdaki rakamlar için kıyaslama yapmakta zorlanacaksınız. Ancak, daha yakından bakmak için iyi bir çağrı:

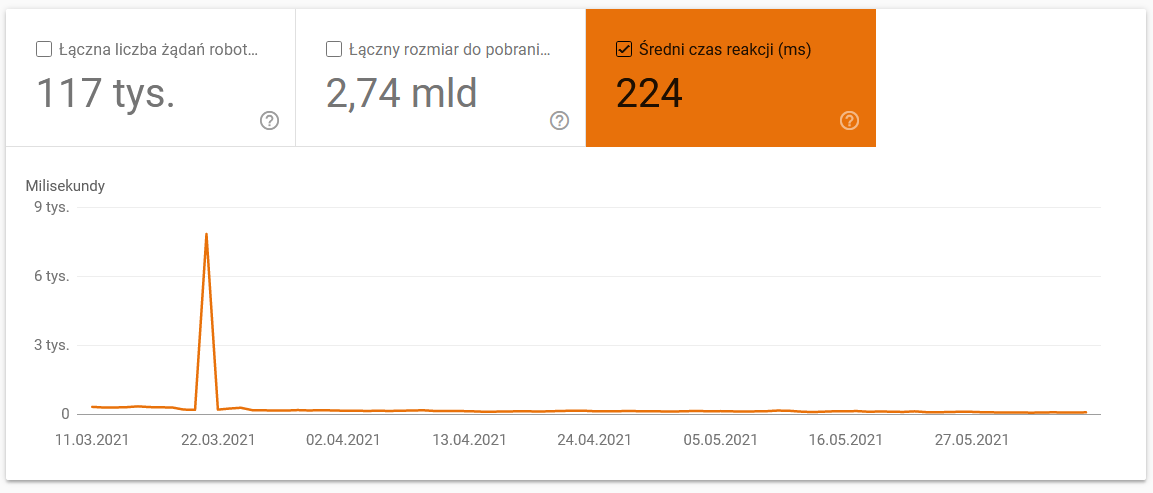

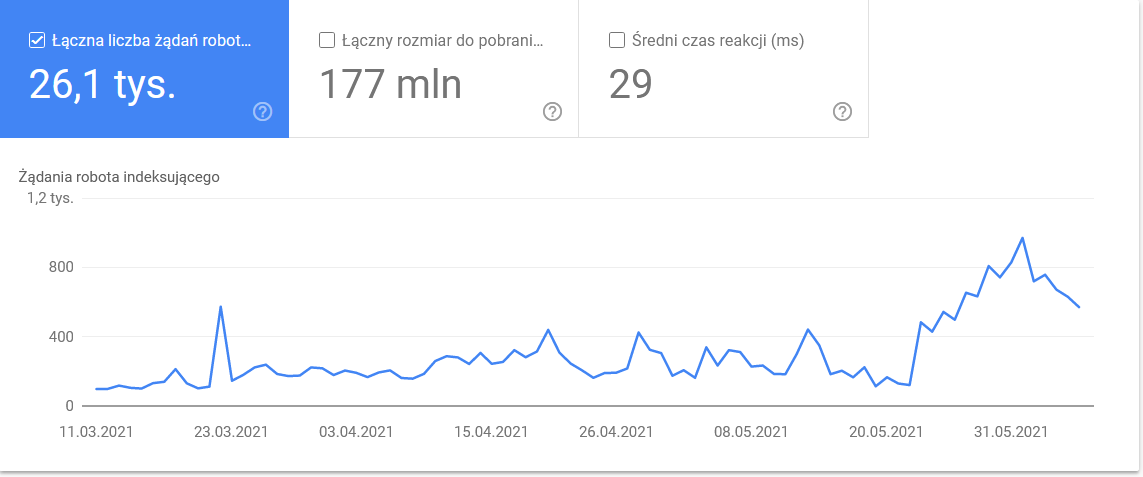

- Ortalama indirme süresi. Aşağıdaki ekran görüntüsü, sunucuyla ilgili sorunlardan kaynaklanan ortalama yanıt süresinin çarpıcı bir şekilde düştüğünü gösteriyor:

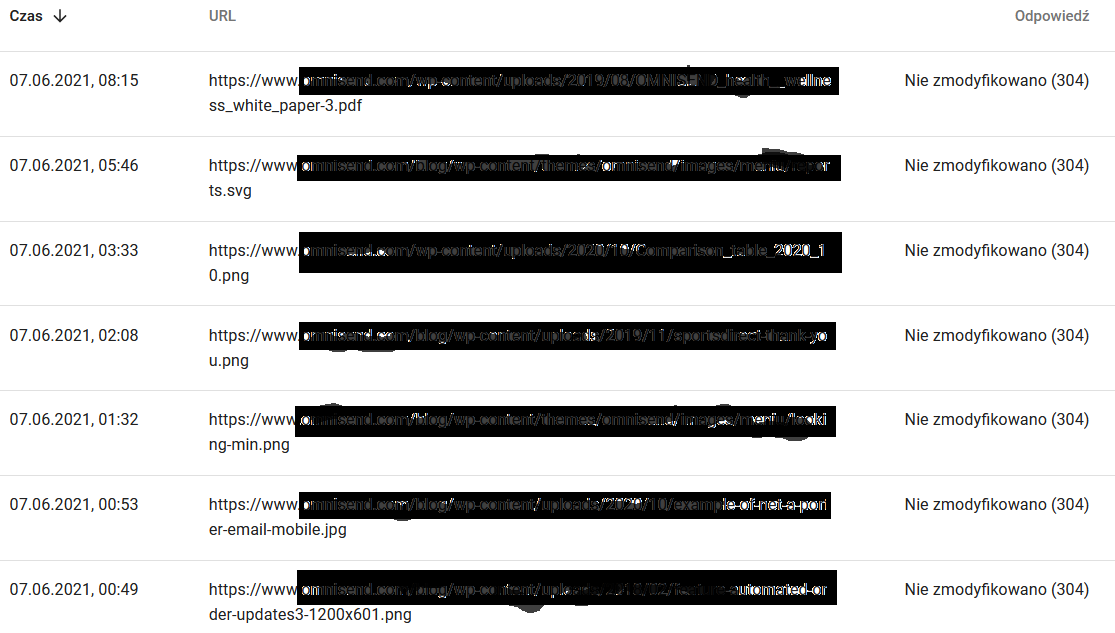

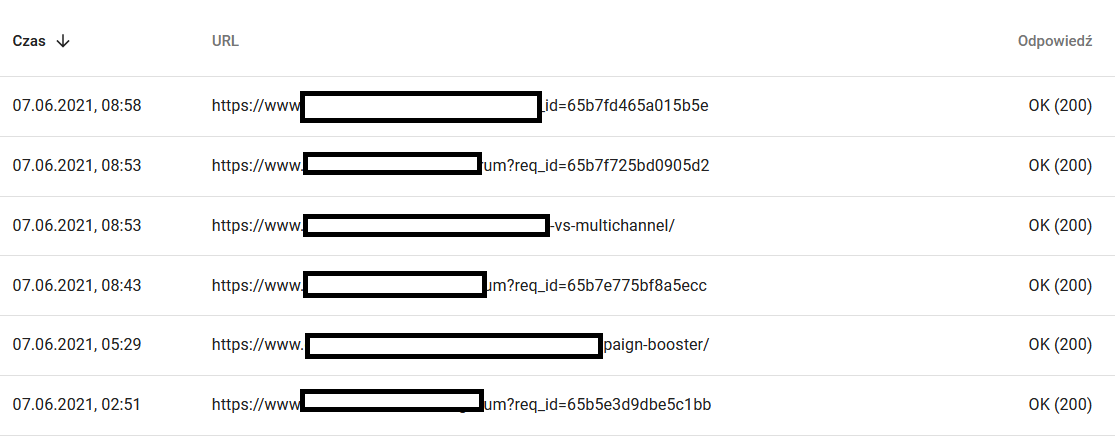

- Tarama yanıtları. Genel olarak web sitenizle ilgili bir sorununuz olup olmadığını görmek için rapora bakın. Aşağıdaki 304'ler gibi atipik sunucu durum kodlarına çok dikkat edin. Bu URL'ler işlevsel bir amaca hizmet etmez, ancak Google kaynaklarını içeriklerini taramak için harcar.

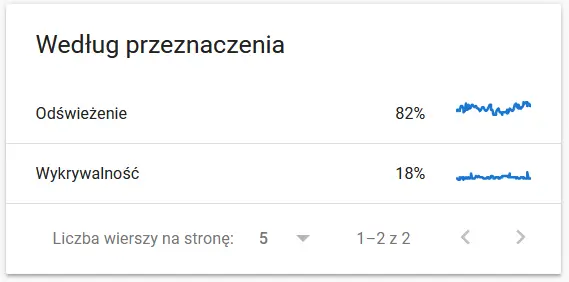

- Tarama amacı. Genel olarak, bu veriler büyük ölçüde web sitesindeki yeni içeriğin hacmine bağlıdır. Google tarafından toplanan bilgiler ile kullanıcı arasındaki farklar oldukça etkileyici olabilir:

Google'ın gözünde yeniden taranan bir URL'nin içeriği:

Bu arada, kullanıcının tarayıcıda gördüğü şey:

Kesinlikle düşünce ve analiz için bir sebep :)

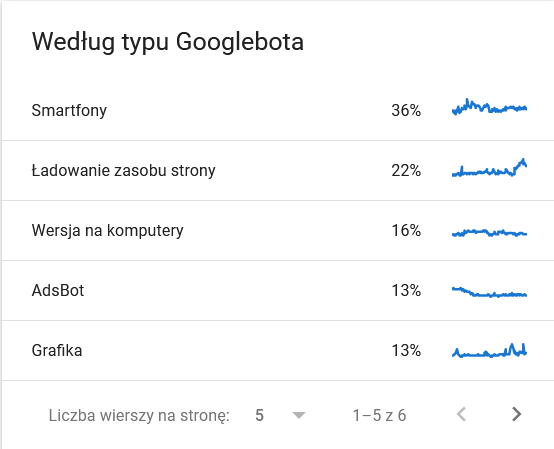

- Googlebot türü . Burada, gümüş tepside web sitenizi ziyaret eden botlar ve içeriğinizi ayrıştırma motivasyonları var. Aşağıdaki ekran görüntüsü, isteklerin %22'sinin sayfa kaynak yüküne atıfta bulunduğunu göstermektedir.

Zaman çerçevesinin son günlerinde balonlanan toplam:

Ayrıntılara bakıldığında, daha yakından ilgilenilmesi gereken URL'ler ortaya çıkıyor:

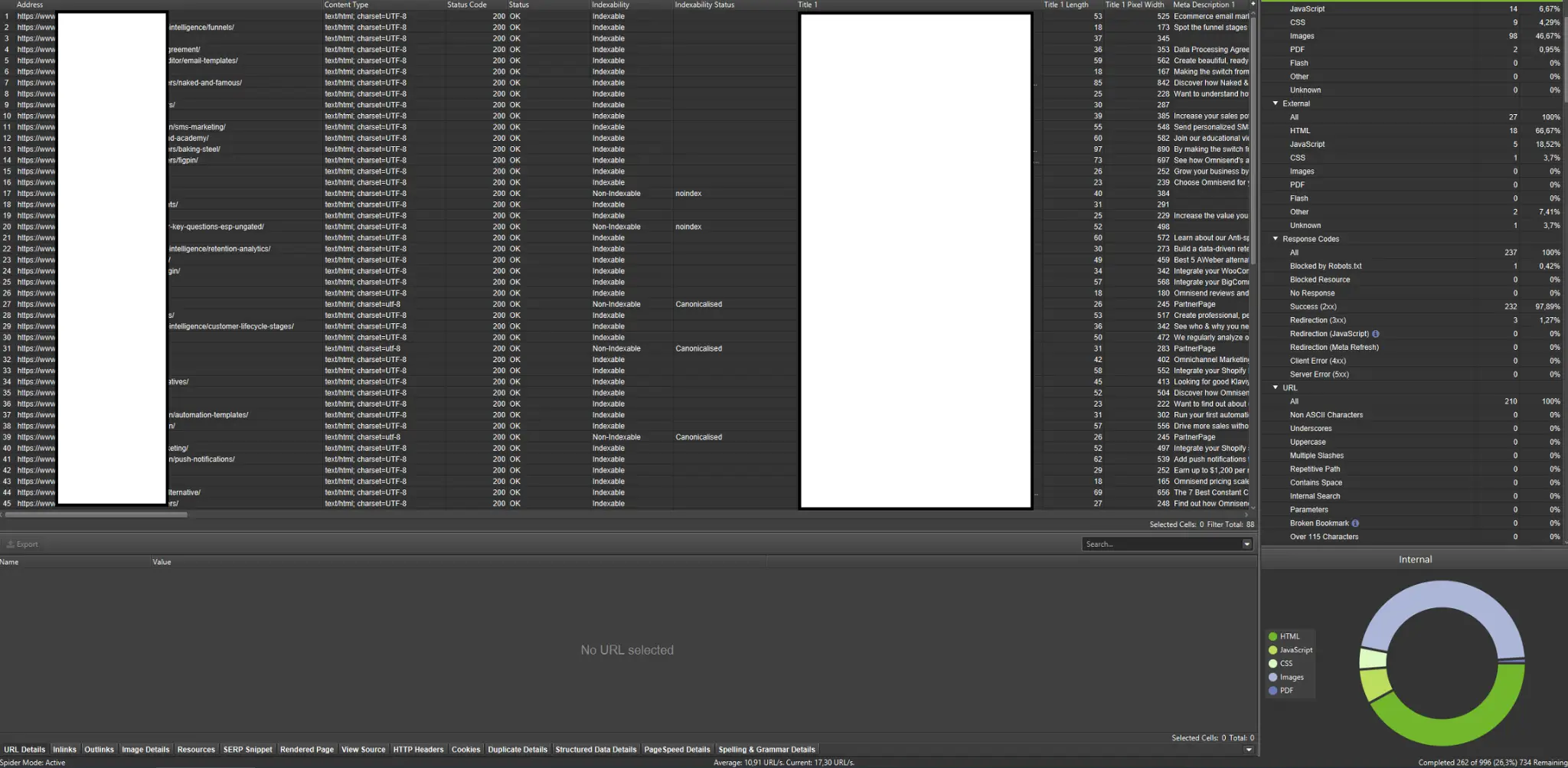

Harici tarayıcılar (Screaming Frog SEO Spider'dan örneklerle birlikte)

Tarayıcılar, web sitenizin tarama bütçesini analiz etmek için en önemli araçlardan biridir. Temel amaçları, web sitesinde gezinen botların hareketlerini taklit etmektir. Simülasyon, her şeyin yolunda gidip gitmediğini bir bakışta gösterir.

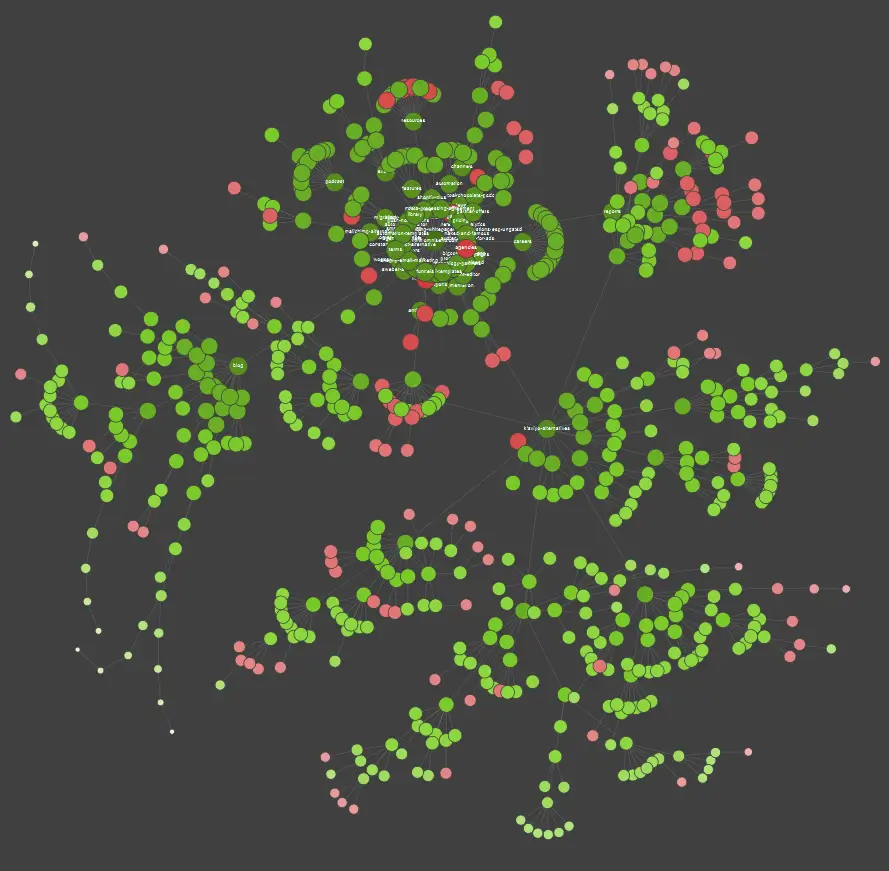

Görsel öğrenen biriyseniz, piyasada bulunan çoğu çözümün veri görselleştirmeleri sunduğunu bilmelisiniz.

Yukarıdaki örnekte, kırmızı noktalar dizine eklenmemiş sayfaları temsil etmektedir. Kullanışlılıklarını ve sitenin işleyişi üzerindeki etkilerini değerlendirmek için biraz zaman ayırın. Sunucu günlükleri, bu sayfaların değer katmadan Google'ın çok fazla zamanını boşa harcadığını ortaya çıkarırsa, onları web sitesinde tutma noktasını ciddi şekilde yeniden gözden geçirmenin zamanı gelmiştir.

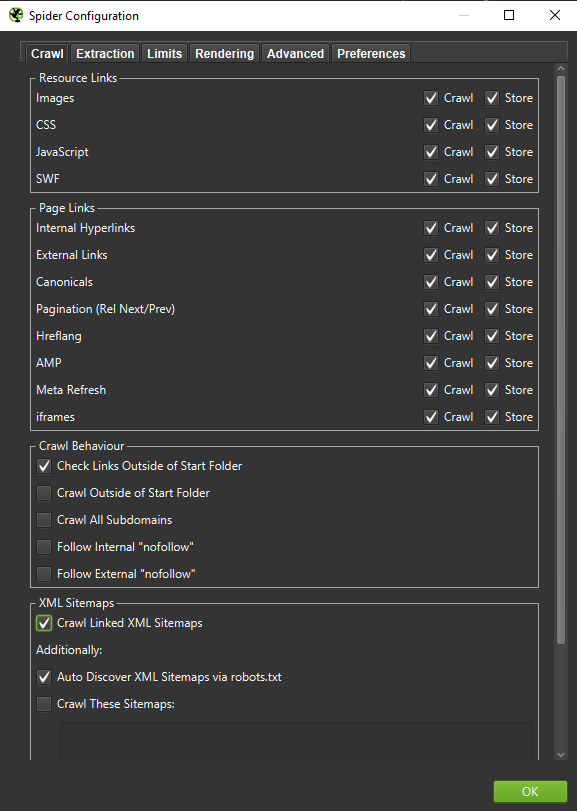

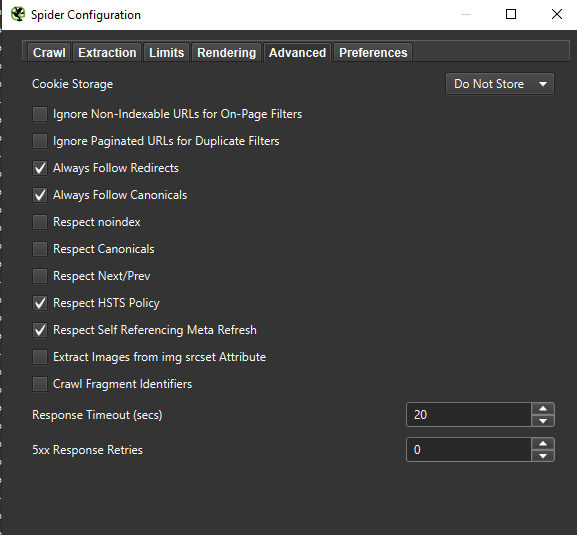

Önemli : Bir Googlebot'un davranışını olabildiğince doğru bir şekilde yeniden oluşturmak istiyorsak, doğru ayarlar şarttır. Burada bilgisayarımdan örnek ayarları görebilirsiniz:

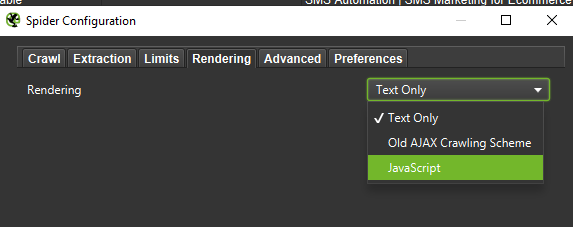

Derinlemesine bir analiz yürütürken, farklılıkları (varsa) karşılaştırmak için iki modu (Yalnızca Metin ve JavaScript'i) test etmek iyi bir çağrıdır.

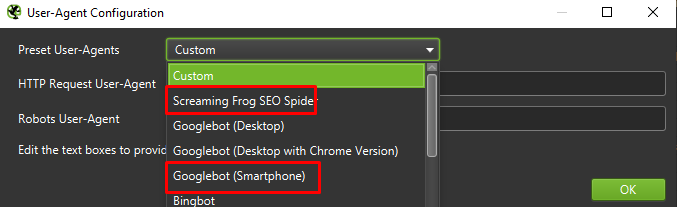

Son olarak, yukarıda sunulan kurulumu iki farklı kullanıcı aracısı üzerinde test etmekten asla zarar gelmez:

Çoğu durumda, yalnızca mobil aracı tarafından taranan / oluşturulan sonuçlara odaklanmanız gerekir.

Önemli: Ayrıca Screaming Frog'un sunduğu fırsatı kullanmanızı ve tarayıcınızı GA ve Google Search Console'dan gelen verilerle beslemenizi öneririm. Entegrasyon, trafik almayan potansiyel olarak gereksiz URL'lerin önemli bir gövdesi gibi tarama bütçesi israfını belirlemenin hızlı bir yoludur.

Günlük analizi için araçlar (Screaming Frog Logfile ve diğerleri)

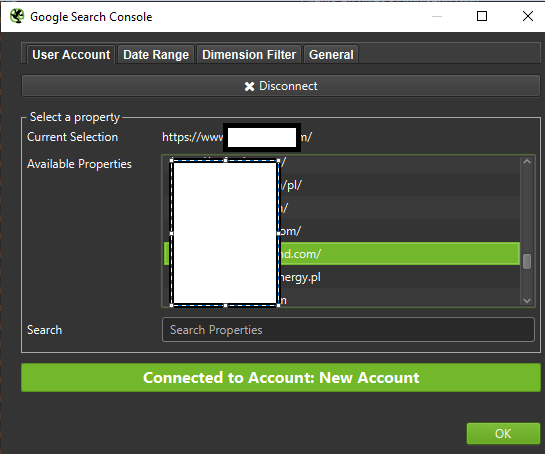

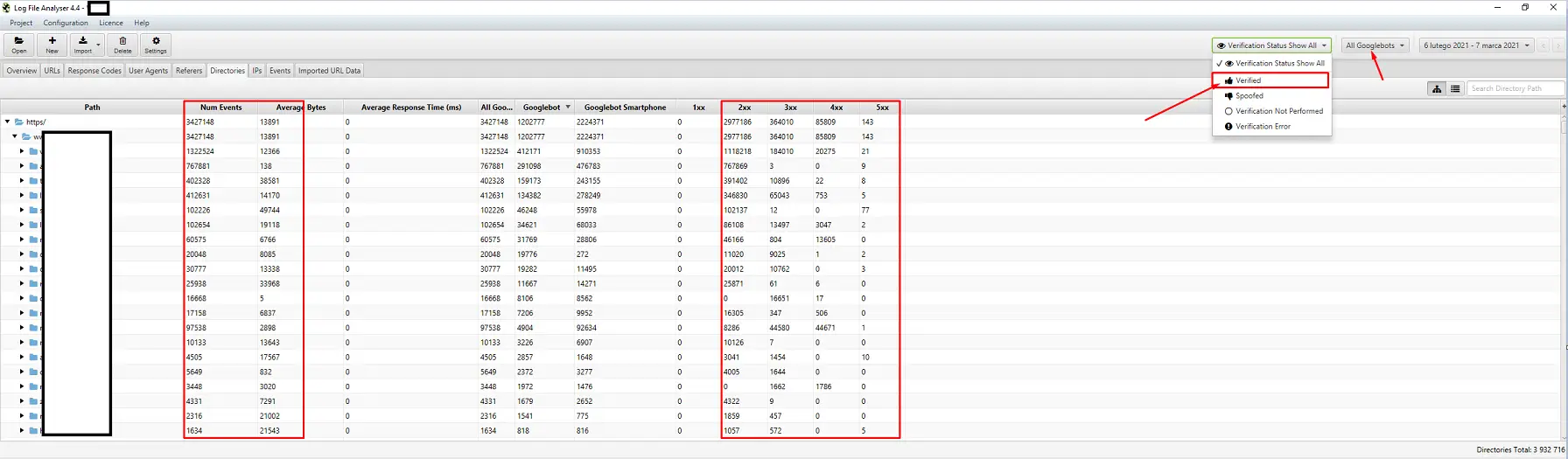

Bir sunucu log analizörü seçimi kişisel tercih meselesidir. Gitmem gereken aracım Screaming Frog Log File Analyzer. En verimli çözüm olmayabilir (büyük bir günlük paketi yüklemek = uygulamayı asmak), ancak arayüzü beğendim. Önemli olan kısım, sisteme yalnızca doğrulanmış Googlebot'ları gösterecek şekilde sipariş vermektir.

Görünürlük takibi için araçlar

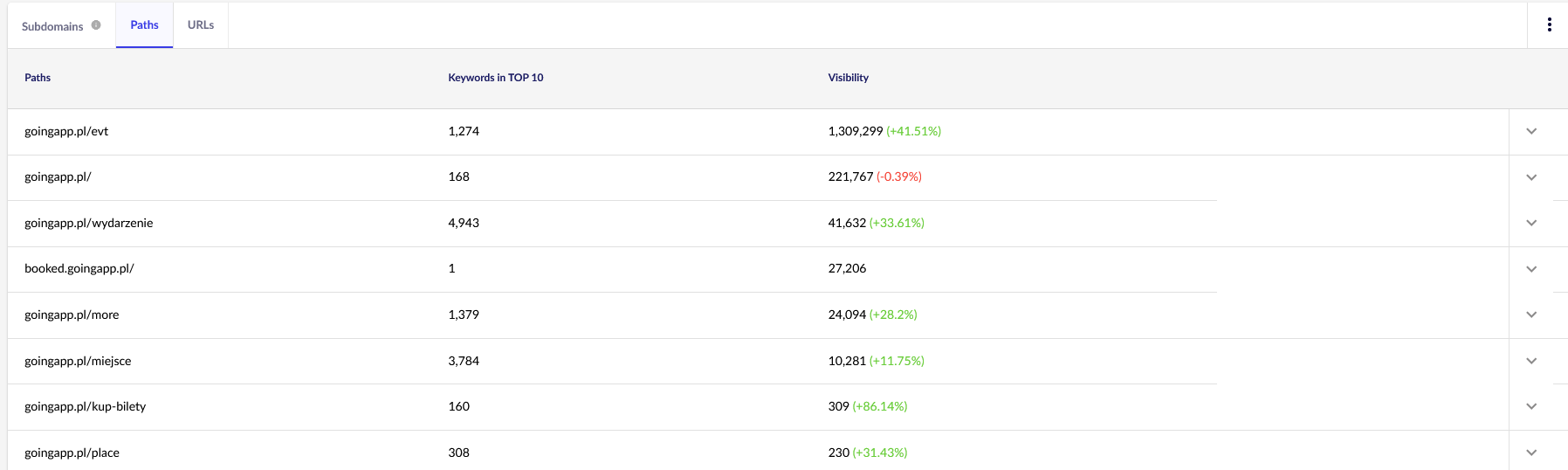

Yararlı bir yardım, çünkü en iyi sayfalarınızı belirlemenize izin veriyorlar. Bir sayfa Google'da birçok anahtar kelime için yüksek sıralanıyorsa (= çok fazla trafik alıyorsa), potansiyel olarak daha büyük bir tarama talebi olabilir (günlüklerde kontrol edin – Google bu belirli sayfa için gerçekten daha fazla isabet oluşturuyor mu?).

Amaçlarımız doğrultusunda, gelecekte sürekli inceleme için Senuto'da genel raporlara – Yollar ve URL'ler – ihtiyacımız olacak. Her iki rapor da Bölümler sekmesindeki Görünürlük Analizi'nde mevcuttur. Bir göz atın:

Bizim asıl ilgi alanımız ikinci rapor. Anahtar kelime görünürlüğümüze (web sitemizin İLK 10'da yer aldığı liste ve toplam anahtar kelime sayısı) bakmak için sıralayalım. Sonuçlar, tarama bütçemizin uyarılması (ve verimli tahsisi) için ana ekseni belirlememize yardımcı olacaktır.

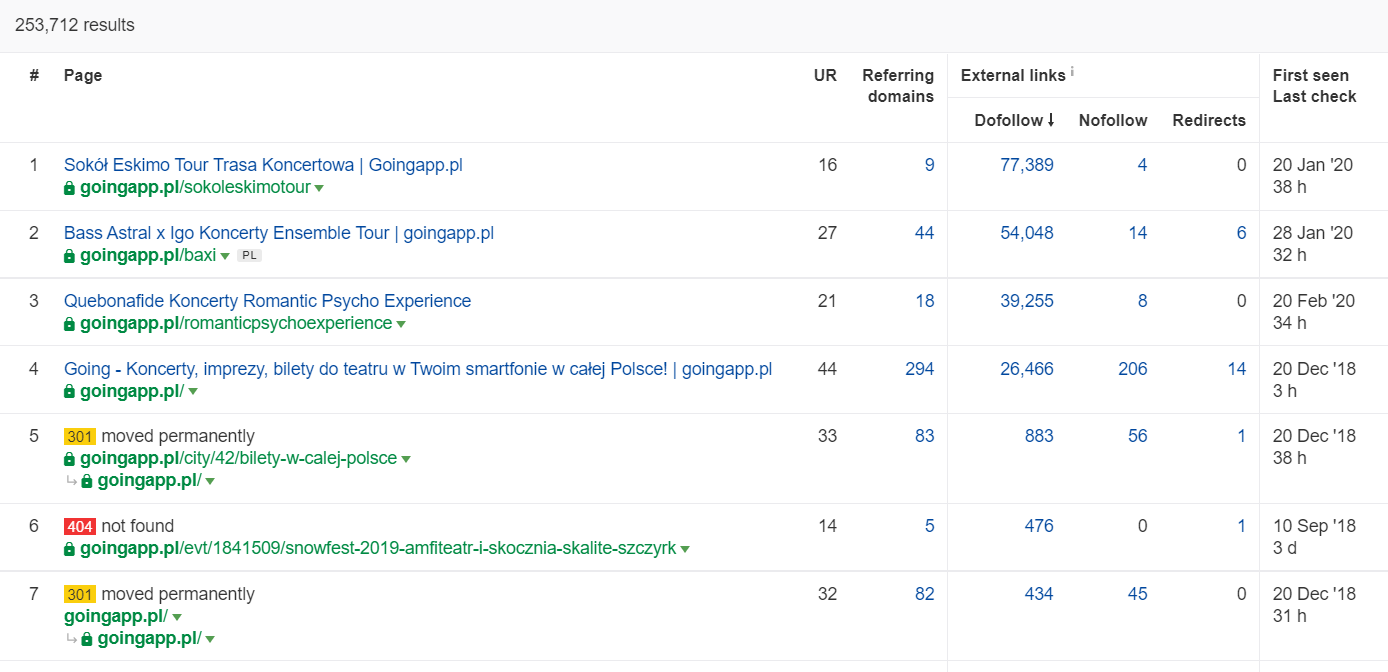

Backlink analizi için araçlar (Ahrefs, Majestic)

Sayfalarınızdan birinde yüksek miktarda gelen bağlantı varsa, bunu tarama bütçesi optimizasyon stratejinizin bir ayağı olarak kullanın. Popüler sayfalar, suyu daha fazla aktaran hub rolünü üstlenebilir. Ek olarak, iyi bir değerli bağlantı havuzuna sahip popüler bir sayfa, sık taramaları çekme konusunda daha iyi bir şansa sahiptir.

Ahrefs'te, Sayfalar raporuna ve daha doğrusu "Bağlantıların en iyisi" başlıklı kısmına ihtiyacımız var:

Yukarıdaki örnek, konserle ilgili bazı LP'lerin geri bağlantılar için sağlam istatistikler oluşturmaya devam ettiğini göstermektedir. Pandemi nedeniyle tüm konserler iptal edilmiş olsa bile, gezinme botlarının merakını uyandırmak ve suyu web sitenizin daha derin köşelerine yaymak için tarihsel olarak güçlü sayfaları kullanmak hala işe yarıyor.

Tarama bütçesi sorununun önemli işaretleri nelerdir?

Sorunlu (aşırı düşük) bir tarama bütçesiyle uğraştığınızı anlamak kolay olmuyor. Neden? Niye? Prensip olarak, çünkü SEO son derece karmaşık bir kuruluştur. Düşük sıralamalar veya indeksleme sorunları, vasat bir bağlantı profilinin veya web sitesinde doğru içeriğin bulunmamasının bir sonucu olabilir.

Tipik olarak, bir tarama bütçesi teşhisi aşağıdakileri kontrol etmeyi içerir:

- Google Arama Konsolu üzerinden dizine ekleme talebinde bulunmadığınızı varsayarsak, yayından yeni sayfaların (blog gönderileri / ürünler) dizine eklenmesine kadar ne kadar zaman geçer?

- Google, geçersiz URL'leri dizininde ne kadar süreyle tutar? Önemli: Yönlendirilen adresler bir istisnadır – Google bunları bilerek saklar.

- Dizine yalnızca daha sonra bırakılmak üzere giren sayfalarınız mı var?

- Google, değer (trafik) üretemeyen sayfalara ne kadar zaman harcıyor? Öğrenmek için günlük analizine gidin.

Tarama bütçesi nasıl analiz edilir ve optimize edilir?

Tarama bütçesi optimizasyonuna girme kararı, esas olarak web sitenizin boyutuna göre belirlenir. Google, genel olarak 1000'den az sayfaya sahip web sitelerinin mevcut tarama sınırlarından en iyi şekilde yararlanma konusunda ıstırap çekmemesi gerektiğini önerir. Benim kitabımda, web siteniz 300'den fazla sayfa içeriyorsa ve içeriğiniz dinamik olarak değişiyorsa (örneğin, yeni sayfalar / blog yazıları eklemeye devam ediyorsanız) daha verimli ve etkili tarama için savaşmaya başlamalısınız .

Neden? Niye? Bu bir SEO hijyeni meselesidir. İyi optimizasyon alışkanlıklarını ve sağlam tarama bütçesi yönetimini ilk günlerde uygulayın; gelecekte düzeltmeniz ve yeniden tasarlamanız için daha az zamanınız olur.

Tarama bütçesi optimizasyonu. Standart bir prosedür

Genel olarak, tarama bütçesi analizi ve optimizasyonu çalışmaları üç aşamadan oluşur:

- Hem web yöneticilerinden hem de harici araçlardan web sitesi hakkında bildiğimiz her şeyi derleme süreci olan veri toplama.

- Görünürlük analizi ve düşük asılı meyvelerin tanımlanması. Saat gibi çalışan ne? Daha iyi ne olabilir? Hangi alanlarda büyüme potansiyeli en yüksek?

- Tarama bütçesi için öneriler.

Tarama bütçesi denetimi için veri toplama

1. Ticari olarak mevcut araçlardan biri ile gerçekleştirilen tam bir web sitesi taraması. Hedef, en az iki taramayı tamamlamaktır: ilki Googlebot'u simüle ederken, diğeri web sitesini varsayılan bir kullanıcı aracısı olarak getirir (bir tarayıcının kullanıcı aracısı yapar). Bu aşamada, içeriğin yalnızca %100'ünü indirmekle ilgileniyorsunuz . Tarayıcının bir döngüye girdiğini fark ederseniz (bir günlük taramadan sonra, sabit diskimizde web sitesinin yalnızca %10'u kaldığında) - bir sorun olduğunu ve taramayı durdurabileceğinizi bilin. Büyük web siteleri söz konusu olduğunda, analiz için makul sayıda URL, yaklaşık 250–300 bin sayfadır.

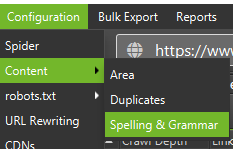

a) Aradığımız esas olarak dahili 301 yönlendirmeleri, 404 hataları, ayrıca metinlerinizin ince içerik olarak kategorize edilebileceği durumlardır. Screaming Frog, neredeyse kopya içeriği algılama seçeneğine sahiptir:

2. Sunucu günlükleri . İdeal zaman çerçevesi geçen ayı kapsamalıdır, ancak büyük web siteleri söz konusu olduğunda, son iki hafta yeterli olabilir. En iyi senaryoda, Googlebot'un her şeyin yolunda gitmediği andaki hareketlerini karşılaştırmak için geçmiş sunucu günlüklerine erişimimiz olmalıdır.

3. Google Arama Konsolundan veri aktarımı . Yukarıdaki 1. ve 2. noktalarla birlikte, Dizin Kapsamı ve Tarama İstatistiklerinden elde edilen veriler, web sitenizdeki tüm olup bitenler hakkında size oldukça kapsamlı bir hesap verecektir.

4. Organik trafik verileri . Google Arama Konsolu, Google Analytics ve ayrıca Senuto ve Ahrefs tarafından belirlenen en iyi sayfalar. Yüksek görünürlük istatistikleri, trafik hacmi veya geri bağlantı sayısı ile kalabalık arasında öne çıkan tüm sayfaları belirlemek istiyoruz. Bu sayfalar, tarama bütçesi üzerindeki çalışmanızın bel kemiği haline gelmelidir . Bunları, en önemli sayfaların taranmasını iyileştirmek için kullanacağız.

5. Manuel dizin incelemesi . Bazı durumlarda, bir SEO uzmanının en iyi arkadaşı basit bir çözümdür. Bu durumda: doğrudan indeksten alınan verilerin bir incelemesi! inurl: + site: operatörlerinin birleşimiyle web sitenizi kontrol etmek için iyi bir çağrı.Son olarak, toplanan tüm verileri birleştirmemiz gerekiyor. Genellikle, harici veri içe aktarmaya (GSC verileri, sunucu günlükleri ve organik trafik verileri) izin veren özelliklere sahip bir harici tarayıcı kullanırız.

Görünürlük analizi ve düşük asılı meyveler

Süreç ayrı bir makaleyi garanti eder, ancak bugünkü hedefimiz, web sitesi için hedeflerimizi ve kaydedilen ilerlemeyi kuş bakışı görmektir. Sıra dışı olan her şeyle ilgileniyoruz: ani trafik düşüşleri (mevsimsel trendlerle açıklanamayan) ve organik görünürlükteki eşzamanlı değişimler. Hangi sayfa gruplarının en güçlü olduğunu kontrol ediyoruz çünkü bunlar Googlebot'u web sitemizin derinliklerine itmek için HUBS'imiz olacak.

Mükemmel bir dünyada, böyle bir çek, web sitemizin lansmanından bu yana tüm geçmişini kapsamalıdır. Ancak, veri hacmi her ay artmaya devam ederken, son 12 aylık dönemdeki görünürlüğü ve organik trafiği analiz etmeye odaklanalım.

Tarama bütçesi – önerilerimiz

Yukarıda listelenen etkinlikler, optimize edilmiş web sitesinin boyutuna bağlı olarak farklılık gösterecektir. Ancak, bir tarama bütçesi analizi yaparken her zaman dikkate aldığım en önemli unsurlardır. En önemli hedef, web sitenizdeki darboğazları ortadan kaldırmaktır. Başka bir deyişle, Googlebot'lar (veya diğer dizin oluşturma aracıları) için maksimum taranabilirliği garanti etmek.

1. Temel bilgilerden başlayalım – her türlü 404/410 hatanın ortadan kaldırılması, dahili yönlendirmelerin analizi ve bunların dahili bağlantıdan kaldırılması . Son bir tarama ile işimizi bitirmeliyiz. Bu sefer, tüm bağlantılar, hiçbir dahili yönlendirme veya 404 hatası olmadan 200 yanıt kodu döndürmelidir.

- Bu aşamada, geri bağlantı raporunda tespit edilen tüm yönlendirme zincirlerini düzeltmek iyi bir fikirdir.

2. Taramadan sonra, web sitemizin yapımızın bariz kopyalardan arınmış olduğundan emin olun .

- Potansiyel yamyamlığa karşı da kontrol edin – aynı anahtar kelimenin birden çok sayfayla hedeflenmesinden kaynaklanan sorunların dışında (kısacası, Google tarafından hangi sayfanın görüntüleneceğini kontrol etmeyi bırakırsınız), yamyamlık tüm tarama bütçenizi olumsuz etkiler.

- Tanımlanan kopyaları tek bir URL'de (genellikle daha üst sırada yer alan) birleştirin.

3. noindex etiketine sahip kaç URL'yi kontrol edin . Bildiğimiz gibi, Google yine de bu sayfalarda gezinebilir. Sadece arama sonuçlarında görünmüyorlar. Web sitemizin yapısında noindex etiketlerinin payını en aza indirmeye çalışıyoruz.

- Örnek olay – bir blog, yapısını etiketlerle düzenler; yazarlar, çözümün kullanıcı rahatlığı tarafından belirlendiğini iddia ediyor. Her gönderi, tutarsız olarak atanan ve dizine eklenmeyen 3-5 etiketle etiketlenir. Günlük analizi, bunun web sitesinde en çok taranan üçüncü yapı olduğunu ortaya koyuyor.

4. robots.txt dosyasını inceleyin . Robots.txt dosyasını uygulamanın, Google'ın adresi dizinde görüntülemeyeceği anlamına gelmediğini unutmayın.

- Engellenen adres yapılarından hangisinin hala tarandığını kontrol edin. Belki onları kesmek bir darboğaza neden olur?

- Eski/gereksiz yönergeleri kaldırın.

5. Web sitenizdeki standart olmayan URL'lerin hacmini analiz edin. Google, rel=”canonical” i katı bir yönerge olarak görmeyi bıraktı. Çoğu durumda, özellik arama motoru tarafından tamamen göz ardı edilir (parametreleri dizinde sıralama – hala bir kabus).

6. Filtreleri ve bunların altında yatan mekanizmaları analiz edin . Listeleri filtrelemek, tarama bütçesi optimizasyonunun en büyük baş ağrısıdır. E-ticaret işletme sahipleri, herhangi bir kombinasyonda uygulanabilir filtreleri uygulamakta ısrar ediyor (örneğin, renk + malzeme + boyut + kullanılabilirliğe göre filtreleme… onuncu kez). Çözüm optimal değildir ve minimum ile sınırlandırılmalıdır.

7. Web sitesindeki bilgi mimarisi – iş hedeflerini, trafik potansiyelini ve mevcut bağlantı profilini dikkate alan bir mimari. İş hedeflerimiz için kritik öneme sahip içeriğe bir bağlantının site genelinde (tüm sayfalarda) veya ana sayfada görünür olması gerektiği varsayımı üzerinde çalışalım. Elbette burada basitleştiriyoruz, ancak ana sayfa ve üst menü / site geneli bağlantılar, dahili bağlantıdan değer oluşturmanın en güçlü göstergeleridir. Aynı zamanda, en uygun alan dağılımını elde etmeye çalışıyoruz: hedefimiz, herhangi bir sayfadan taramayı başlatabileceğimiz ve yine aynı sayıda sayfaya ulaşabileceğimiz bir durumdur (her URL'nin MİNİMUMDA bir gelen bağlantısı olmalıdır) .

- Sağlam bir bilgi mimarisine doğru çalışmak, tarama bütçesi optimizasyonunun temel unsurlarından biridir. Botun kaynaklarının bir kısmını bir yerden serbest bırakmamıza ve başka bir yere yönlendirmemize izin verir. Aynı zamanda en büyük zorluklardan biridir, çünkü iş paydaşlarının işbirliğini gerektirir - bu da genellikle SEO önerilerini baltalayan büyük savaşlara ve eleştirilere yol açar.

8. İçerik oluşturma. Dahili bağlantılarını kullanıcı davranışını yakalayan öneri sistemlerine dayandırmayı amaçlayan web siteleri için kritiktir. Her şeyden önce, bu araçların çoğu çerez dosyalarına dayanır. Google, çerezleri saklamaz, bu nedenle özelleştirilmiş sonuçlar almaz. Sonuç: Google her zaman aynı içeriği görür veya hiç içerik görmez.

- Googlebot'un kritik JS/CSS içeriğine erişmesini engellemek yaygın bir hatadır. Bu hareket, sayfa dizine eklemeyle ilgili sorunlara yol açabilir (ve Google'ın kullanılamayan içeriği oluşturmak için harcadığı zamanı boşa harcar).

9. Web sitesi performansı – Temel Web Verileri . CWV'nin site sıralamaları üzerindeki etkisi konusunda şüpheci olsam da (ticari olarak mevcut cihazların çeşitliliği ve İnternet bağlantısının değişen hızları dahil olmak üzere birçok nedenden dolayı), bir kodlayıcı ile tartışmaya en değer parametrelerden biridir.

10. Sitemap.xml – çalışıp çalışmadığını ve tüm temel öğeleri içerdiğini kontrol edin (200 durum kodu döndüren standart URL'lerden başka bir şey değil).

- sitemap.xml'i optimize etmek için ilk tavsiyem, sayfalarınızı türe veya mümkünse kategoriye göre bölmenizdir. Bölme, Google'ın hareketleri ve içeriğin dizine eklenmesi üzerinde size tam kontrol sağlayacaktır.