BERT:谷歌多年来最大的更新

已发表: 2022-12-01谷歌的 BERT 于 2019 年底上线,影响了近 10% 的搜索。 可以说是 2019 年最大的算法更新之一,这里是 SEO 和网站所有者应该了解的有关 Google 高级自然语言处理模型的所有信息。

什么是谷歌的 BERT?

BERT 是一种深度学习算法,是 Bidirectional Encoder Representations from Transformers 的简称。 该算法有助于为复杂的搜索查询提供更相关的结果。

BERT 算法更新对谷歌搜索有何影响?

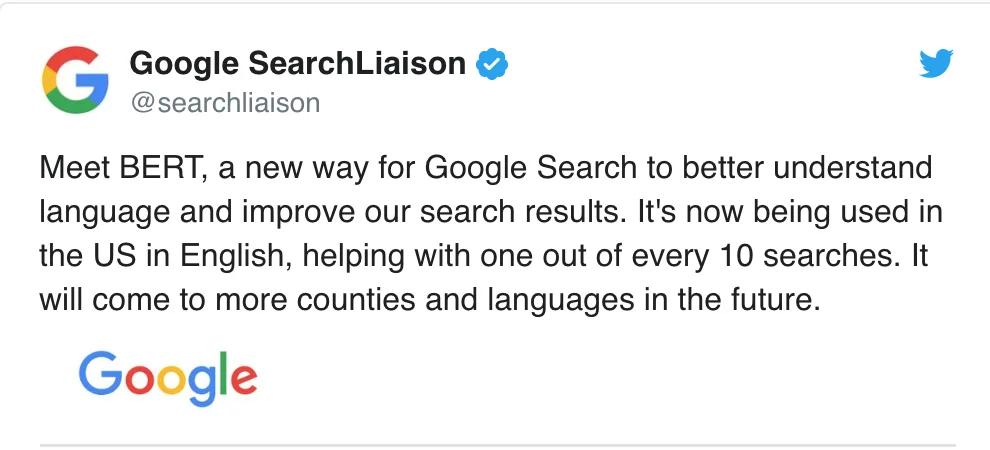

谷歌是这样说的:

“这些改进旨在提高语言理解力,特别是对于更自然的语言/会话查询,因为 BERT 能够帮助搜索更好地理解搜索中单词的细微差别和上下文,并更好地将这些查询与有用的结果相匹配。

特别是对于更长、更多会话的查询,或者搜索中的“for”和“to”等介词对含义有很大影响,Search 将能够理解查询中单词的上下文。 你可以以一种对你来说很自然的方式进行搜索。”

事实上,根据谷歌的说法,BERT 更新将影响美国十分之一的英语搜索,即搜索查询的 10%。 这是 Google 在过去 5 年中最重要的更新,至少根据他们的说法:

我们正在对我们理解查询的方式进行重大改进,这是过去五年中最大的飞跃,也是搜索历史上最大的飞跃之一。

BERT 的引入在新算法部署的第一周引起了较大的排名波动。 Webmaster World 的 SEO 一直在评论自本周初以来的波动,并指出自 RankBrain 以来 SEO 世界的最大排名波动。

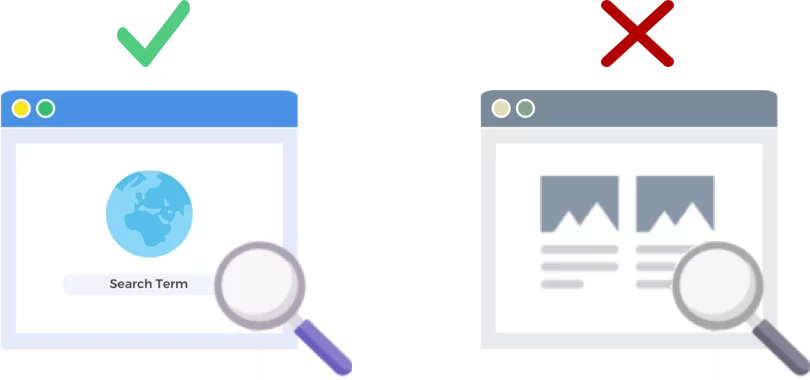

BERT 分析搜索查询而不是网页

2019 年 10 月 24 日发布的 BERT 算法改进了搜索引擎巨头分析和理解搜索查询(而非网页)的方式。

BERT 是如何工作的?

BERT 使用双向(即 BERT 中的 B)上下文模型提高了 Google 对搜索查询的理解。 去年这个时候,谷歌宣布 BERT 作为一种用于自然语言处理 (NLP) 预训练的新技术时,他们实际上谈到了 BERT 的机制。

什么是预训练? 预训练只是在你实际给它工作之前教机器如何做任务。 传统的预训练数据集加载了几千到几十万个人工标记的例子。

预训练已经存在了一段时间,但 BERT 的特别之处在于它既是上下文相关的(每个词的含义根据其周围的词发生变化)又是双向的——一个词的含义是根据它之前和之前的词来理解的在它之后。

根据谷歌的博客:

在“ I accessed the bank account ”这句话中,单向上下文模型将表示基于“ I accessed the ”而非“ account ”的“ bank ”。 然而,BERT 表示“银行”同时使用其上一个和下一个上下文——“我访问了……账户”——从深度神经网络的最底部开始,使其深度双向。

Google BERT 更新建立在机器学习和实体识别的最新进展之上。 基本上,BERT 有助于在 Google 处理搜索之前识别词的所有词性和上下文。

BERT 对搜索结果意味着什么?

据谷歌称,这意味着用户将开始看到更相关的结果,即更符合用户搜索意图的结果。 此算法改进将涵盖常规结果和丰富网页摘要结果。

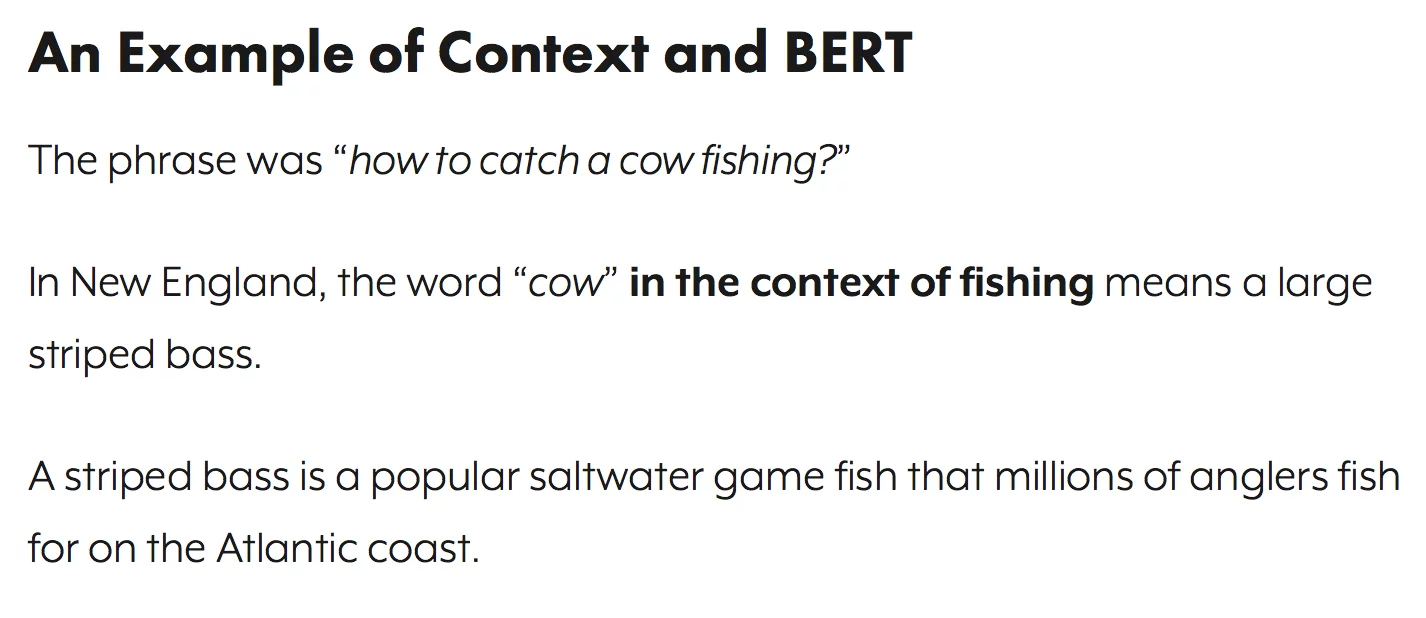

谷歌在他们宣布 BERT 的博客文章中提供了一些有用的例子。

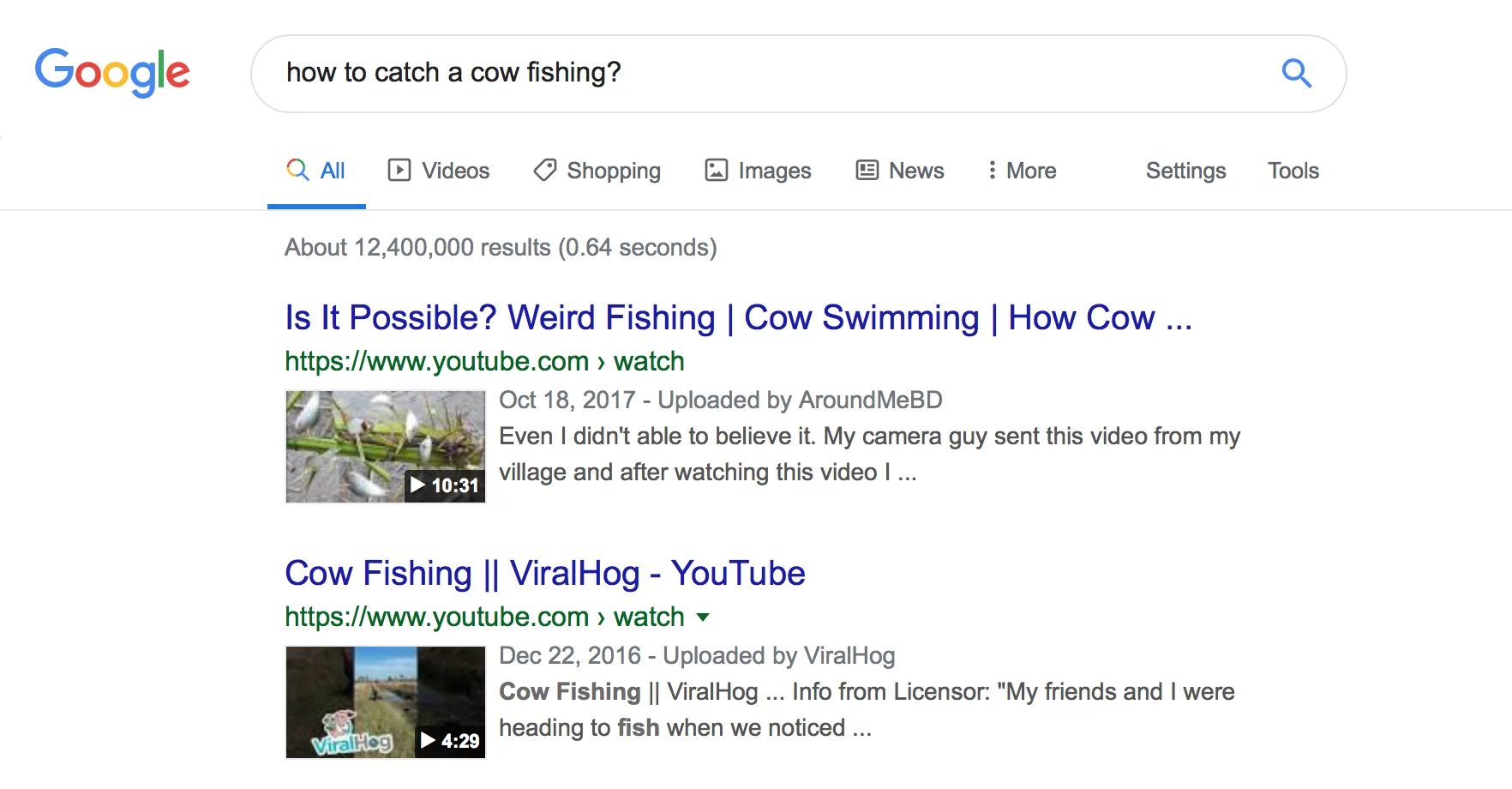

美学家的例子

首先,我们有一位用户试图了解美学家是否在工作中花费大量时间站立。

您可以在下面看到,在 BERT 之前,Google 阅读了“美容师工作时工作量大吗”的查询,并生成了比较美容师工作环境类型的结果。

在 BERT 之后,Google 显示了一篇关于成为美学家的身体要求的文章,这与搜索者最初试图显示的信息更加一致。

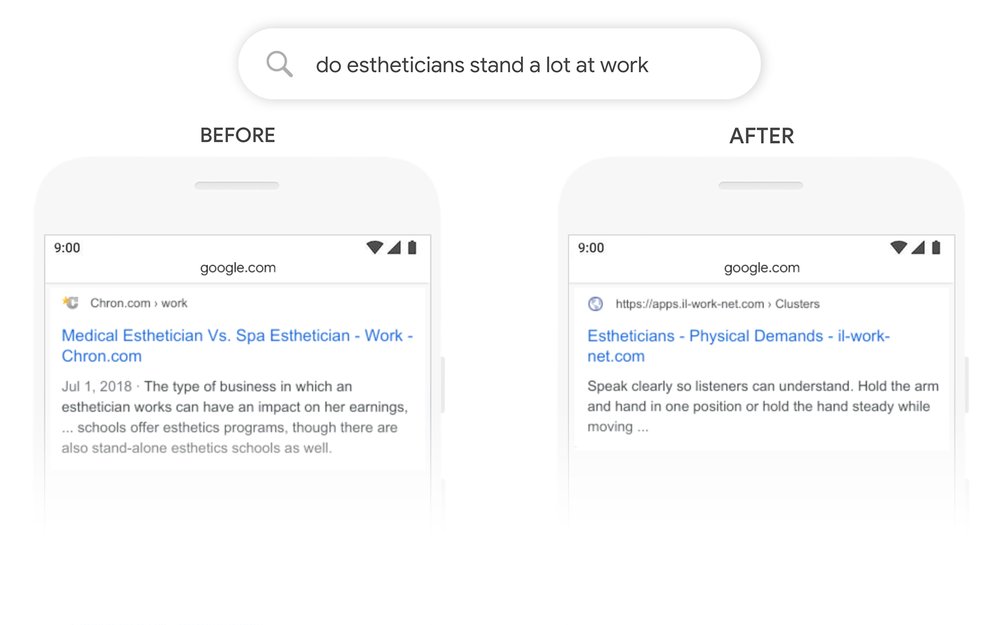

数学练习书示例

在此示例中,用户正在寻找成人数学练习书,但显示了儿童数学练习书。

在 BERT 之后,谷歌正确识别了查询的上下文,更好地解释了“成人”搜索的第二部分。

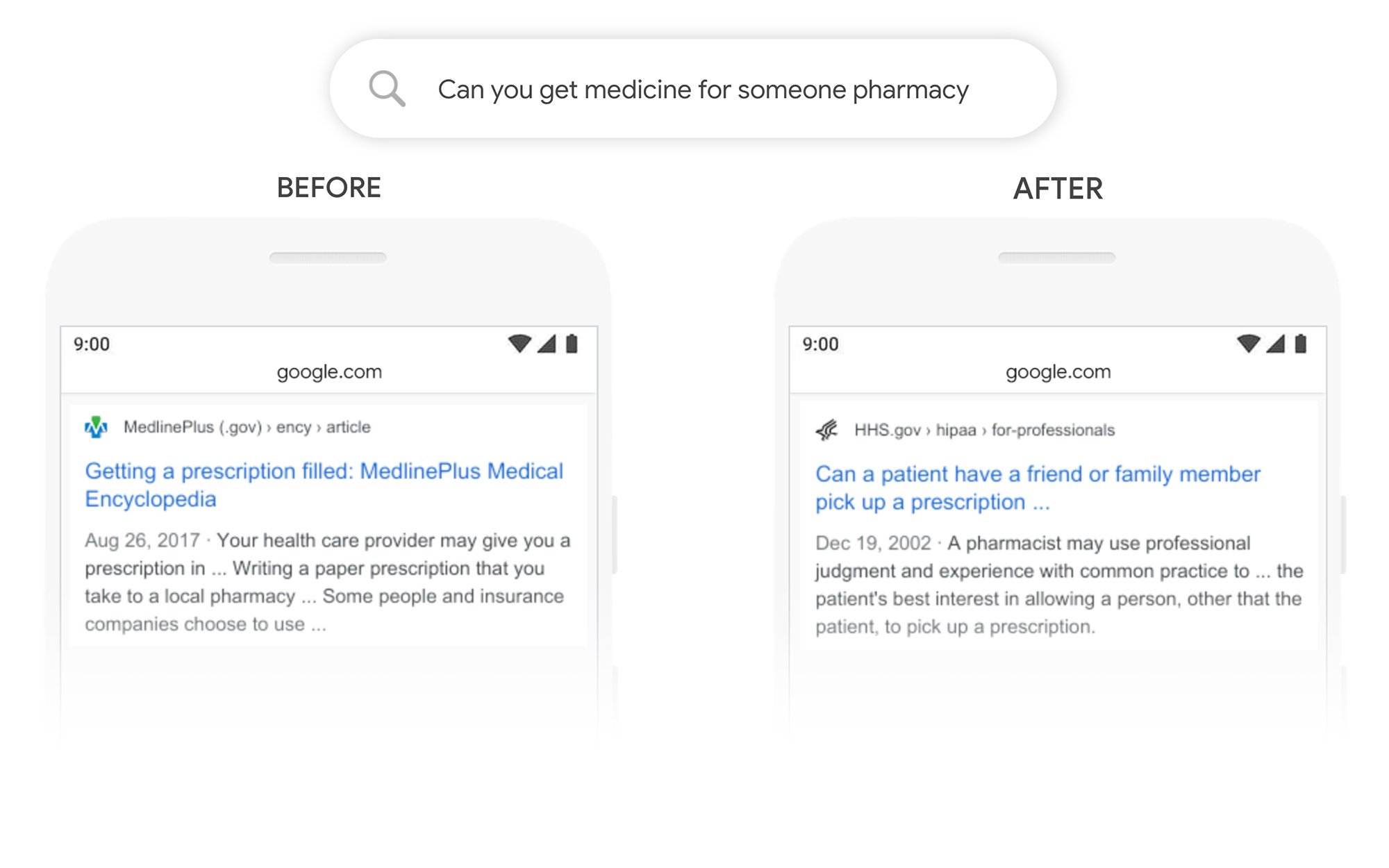

你能为别人拿药吗?

在这个例子中,查询“你能为某人药房买药吗”返回一个关于如何填写处方的结果,而不是如何为第 3 方填写处方。 在 BERT 之后,谷歌更好地理解了用户的目标,并展示了一个关于患者是否可以让朋友或家人为他们取药的文章。

在 BERT 之后我可以做些什么来提高排名?

对于任何失去排名的关键字,您应该查看修改后的搜索结果页面,以更好地了解 Google 如何查看您的目标字词的搜索意图。 然后相应地修改您的内容以更好地满足用户的目标。

如果您在 BERT 下失去排名,则更有可能是与您的页面与用户搜索意图的匹配程度(帮助用户达到他们的目标)相关的问题,而不是内容质量问题。

鉴于 BERT 可能会随着时间的推移进一步支持语音搜索工作,我们还建议网站撰写清晰简洁的文案。 不要使用填充语言,不要含糊不清,开门见山。

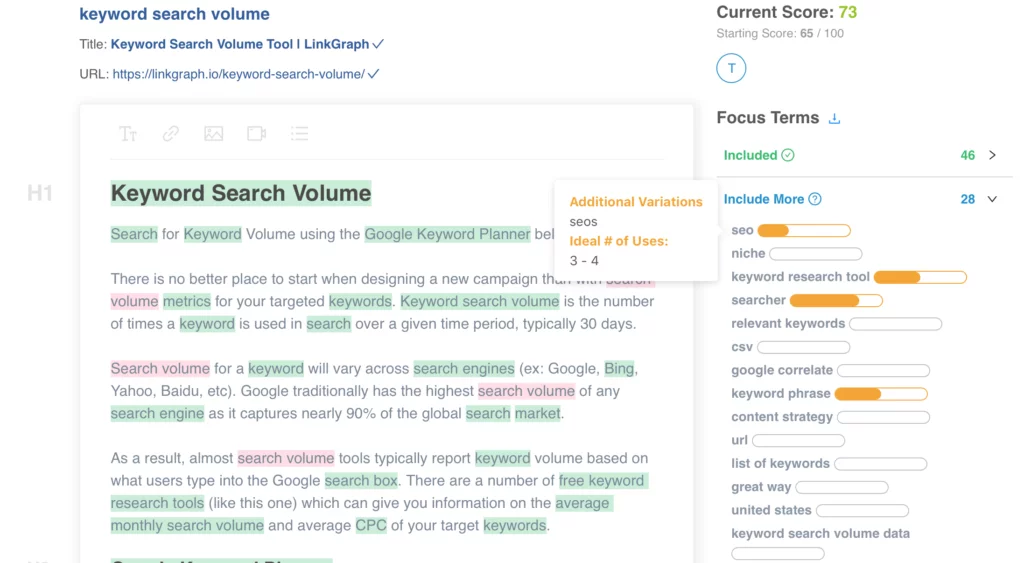

需要帮助优化您的内容? 查看 LinkGraph 的页面内容优化器,通过 [email protected] 联系我们的团队成员,或安排会议以立即进行设置。

我在哪里可以了解更多?

本月早些时候,道恩·安德森 (Dawn Anderson) 在 Pubcon 上就“Google BERT 和 Family and the Natural Language Understanding Leaderboard Race”做了精彩的演讲,您可以看看她的演讲。

感谢您参加我的#Pubcon。 这是我的牌组 <3 <3 https://t.co/aGYDI9pfdY

- 道恩安德森 (@dawnieando) 2019 年 10 月 10 日

Jeff Dean 最近还在 Google 的 AI(包括 BERT)上发表了主题演讲,您可以观看。