如何优化您的抓取预算并提升排名?

已发表: 2017-01-14目录

- 1什么是抓取预算?

- 2为什么抓取预算很重要?

- 3抓取预算何时成为问题?

- 4如何优化您的抓取预算

- 5 1.改善网站结构

- 6 2.解决断开的链接

- 7 3.谨慎使用富媒体内容

- 8 4.清理站点地图

- 9 5.建立外部链接

- 10 6.组织内部链接

- 11 7.利用Feed

- 12 8.删除重定向链

- 13 9.确保您的页面是可抓取的

每个人都知道什么是搜索引擎优化以及结构良好的网站、相关关键字、优质内容、适当的标记、干净的站点地图和其他技术标准的重要性。 但是有机会,你没有考虑过爬行优化。

抓取预算优化是比搜索引擎优化更深层次的东西。 虽然搜索引擎优化更侧重于优化用户查询的过程,但抓取优化侧重于搜索引擎机器人(网络蜘蛛)如何访问您的网站。

在本文中,我们将介绍搜索引擎如何将抓取预算分配给网站的机制,以及帮助您充分利用抓取预算以最大化排名、自然流量和最重要的索引的技巧。

什么是抓取预算?

抓取预算只是搜索引擎蜘蛛在给定时间段内抓取您网站的页面数量。 抓取预算通常取决于您网站的大小和健康状况以及指向您网站的链接数量。

抓取预算是一个重要的 SEO 因素,但往往没有得到足够的重视。 搜索引擎使用蜘蛛机器人来抓取网页、收集信息并将其添加到索引中。 此外,他们还指出他们访问的页面上的链接,并尝试抓取这些新页面。

例如,Googlebot 是一种网络蜘蛛,它发现新页面并将它们添加到 Google 索引中。 大多数网络服务和 SEO 工具都信任这些网络蜘蛛来收集有用的信息。

为什么抓取预算很重要?

网站的可抓取性是确保其可搜索性的主要和关键步骤。 如果您想知道优化抓取预算对您的网站是否重要,答案当然是肯定的。 您的 SEO 努力和抓取优化可能会齐头并进。

尽管它很简单,但您应该关注抓取预算是很合乎逻辑的,因为它使 Google 更容易发现您的网站并将其编入索引。 如果您的网站上的抓取次数更多,则意味着您在发布新内容时将获得更快的更新。 因此,您的抓取预算越大,这种情况发生的速度就越快。

这还将帮助您改善网站的整体用户体验,从而提高知名度,并最终提高 SERP 排名。 事实是,最近被抓取的页面在 SERP 中获得了更多的可见性,如果一个页面有一段时间没有被抓取,它的排名就不会很好。

抓取预算何时成为问题?

抓取预算并不是经常会产生问题。 如果您为网站的 URL 分配了按比例的抓取,这不是问题。 但是,假设您的网站有 200,000 个 URL,而 Google 每天只在您的网站上抓取 2,000 个页面,那么 Google 可能需要 100 天才能识别或更新这些 URL – 现在这是一个问题。

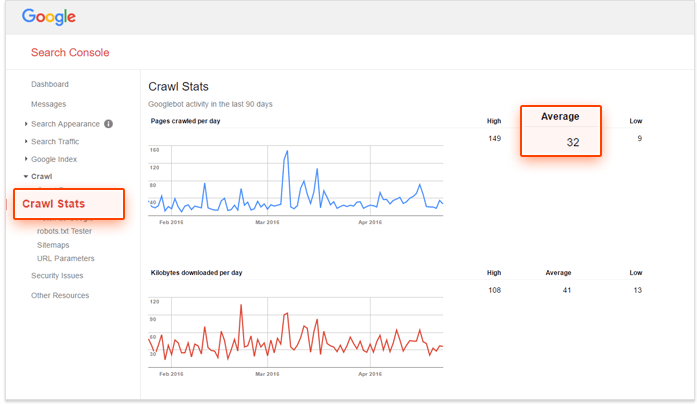

如果您正在寻找解决方案并想检查您的抓取预算是否需要优化,请使用 Google Search Console 和您网站上的网址数量来计算您网站的“抓取数量”。 这个怎么做?

–首先,您需要评估您的网站上有多少页面,您可以通过做一个网站来做到这一点:在 Google 上搜索,

–其次,转到您的 Google Search Console 帐户并转到 Crawl,然后转到 Crawl Stats。 如果您的帐户配置不正确,您将无法获得此数据。

–第三步是将您网站上的页面总数除以您网站上每天抓取的平均页面数。

如果此数字大于 10,则需要考虑优化抓取预算。 如果小于 5,那就太好了! 您无需进一步阅读。

如何优化您的抓取预算

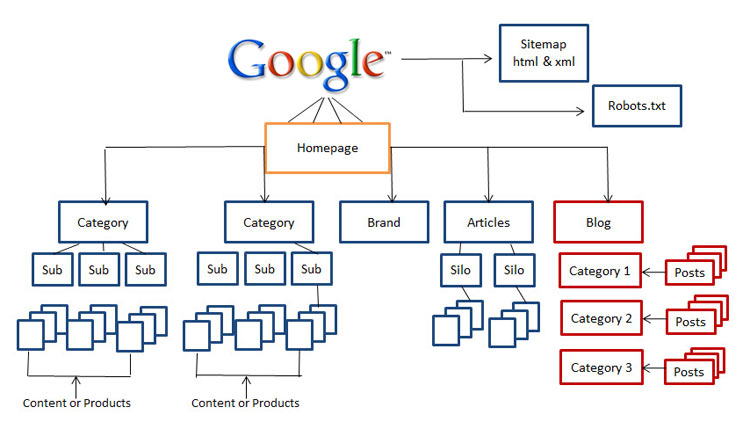

1.改善网站结构

今天,网站结构的重要性是一个至关重要的因素。 像 Rand Fishkin 这样的 SEO 大师建议确保您网站的用户在访问期间距离主页不超过三下。 就可用性而言,这对于 SEO 来说确实是一个很好的建议,因为您的访问者不太可能深入挖掘您的网站。

因此,如果您没有一个干净、易于导航且对搜索引擎友好的网站,那么现在是时候开始重组您的网站了。

2.解决断开的链接

这是搜索引擎优化和爬网优化之间的基本区别之一,不仅断开的链接在降低您的排名方面发挥了重要作用,它们还极大地阻碍了 Googlebot 对您的网站进行索引和排名的能力。

多年来,谷歌的算法有了很大的改进,任何影响用户体验的事情都可能影响 SERP。 谷歌一直试图复制用户行为并更新算法。 因此,当我们为搜索引擎优化网站时,我们应该始终考虑用户体验。

3.谨慎使用富媒体内容

今天,Google 很难抓取 Silverlight 和其他一些文件,但有时 Google 无法抓取 Flash、javascript 和 HTML 等富媒体内容。

但是,尽管 Google 可以读取您的大部分富媒体文件,但其他搜索引擎可能无法读取。 这意味着您应该明智地使用这些文件,有时您可能希望在要排名的页面上完全避免使用它们。

4.清理站点地图

努力清理您的站点地图并使其保持最新状态,以防止可能会损害您网站可用性的混乱情况,包括被阻止的页面、非规范页面、不必要的重定向和 400 级页面。 使用 XML 站点地图是帮助您的用户和蜘蛛机器人的最佳方式。

市场上有各种工具可以清理您的站点地图。 您可以使用 XML 站点地图生成器创建一个干净的站点地图,排除所有阻止索引的页面,查找并修复 301 和 302 重定向和非规范页面等内容。

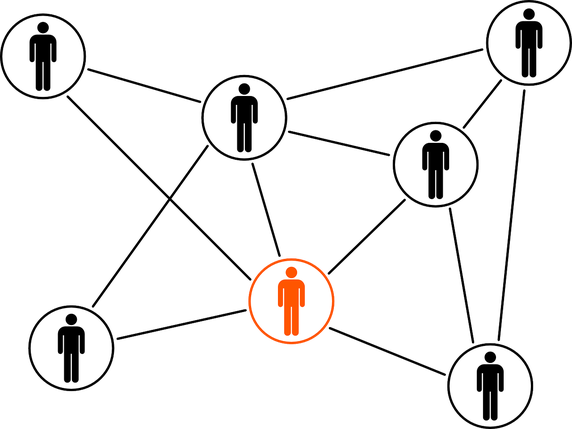

5.建立外部链接

链接建设是一个空前的热门话题,并且在不久的将来不会消失。 发现新社区、建立在线关系和建立品牌价值是您在链接建立过程中应该已经拥有的一些好处。

当通过最佳实践完成时,外部链接是指向外部域的链接,也是获得更高排名的最重要来源。 尽管外部链接是最难操作的指标,但它们是搜索引擎了解网页受欢迎程度和相关性的好方法。

6.组织内部链接

虽然内部链接建设与爬虫预算优化没有太大关系,但这并不意味着你可以忽略它。 组织良好且维护良好的网站结构有助于用户和蜘蛛机器人轻松查看您的内容,而无需花费足够的抓取预算。

结构良好的内部链接系统还可以增强用户体验。 帮助用户通过点击几下即可到达任何区域并使事物易于访问通常会使访问者在您的网站上停留更长时间,这将提高您的 SERP 排名。

7.利用Feed

RSS、Atom 和 XML 等各种提要可帮助您的网站向用户提供内容,即使他们没有浏览您的网站。 这是用户订阅最受青睐的网站并在发布新内容时获得定期更新的最佳方式。

长期以来,RSS 提要被证明是提高网站读者人数和参与度的好方法。 此外,它们也是谷歌网络蜘蛛访问量最大的网站之一。 当您的网站有更新时,您可以将其提交到 Google 的 Feed Burner,以确保它已正确编入索引。

8.删除重定向链

您重定向到的每个 URL 都会浪费一点您的抓取预算。 当您的网站有很长的重定向链,这意味着连续有大量的 301 和 302 重定向时,网络蜘蛛可能会在到达您的目标页面之前就掉线,最终您的页面不会被索引。 如果您正在寻找重定向的最佳实践,最好在您的网站上使用尽可能少的重定向,并且连续不超过两个。

9.确保您的页面是可抓取的

如果搜索引擎蜘蛛机器人能够找到您的网页,找到并跟踪您网站中的链接,那么它们就是可抓取的。 因此,您需要配置您的 robots.txt 和 .htaccess 文件,以免它们阻止您网站的关键页面。

您可能还需要提供支持富媒体内容(如 flash、silverlight 等)的页面的文本文件。

仅通过在 robots.txt 中禁止,您不能保证阻止页面被取消索引。 如果有外部内容(例如传入链接)继续将流量引导到您已禁止的页面,Google 可能会认为该页面仍然相关。 在这种情况下,您需要手动阻止该页面被编入索引。 您可以使用 X-Robots-Tag HTTP 标头或 noindex robots 元标记轻松完成此操作。

请注意,如果您使用 noindex 元标记或 X-Robots-Tag,则不应禁止 robots.txt 中的页面,必须先抓取该页面,然后才能看到并遵守该标记。

结论:抓取预算优化不是一件容易的事,当然也不是“速赢”。 如果您有一个中小型网站,并且维护得很好,那么您可能没问题。 但是,如果您有一个包含数千个 URL 的复杂且无组织的站点结构,并且服务器日志文件超出您的想象 - 可能是时候请专业人士或专家来帮助您了。