什麼是抓取預算以及如何針對它進行優化

已發表: 2022-11-25

當您第一次了解搜索引擎機器人的工作原理時,抓取預算似乎是一個陌生的概念。 雖然不是最簡單的 SEO 概念,但它們並沒有看起來那麼複雜。 一旦您開始了解什麼是抓取預算以及搜索引擎抓取的工作原理,您就可以開始優化您的網站以優化可抓取性。 此過程將幫助您的網站在 Google 搜索結果中發揮最大的排名潛力。

什麼是抓取預算?

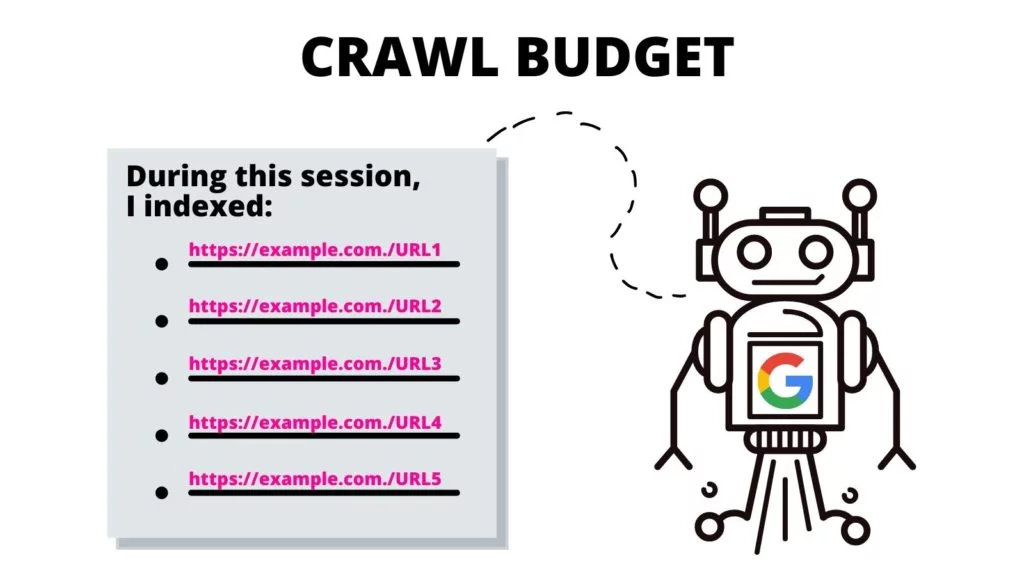

抓取預算是搜索引擎機器人在一次索引會話中可以索引的來自一個網站的 URL 數量。 爬行會話的“預算”因網站而異,具體取決於每個網站的大小、流量指標和頁面加載速度。

如果您已經走到這一步並且對 SEO 術語不熟悉,請使用我們的SEO 詞彙表來更加熟悉這些定義。

哪些因素會影響網站的抓取預算?

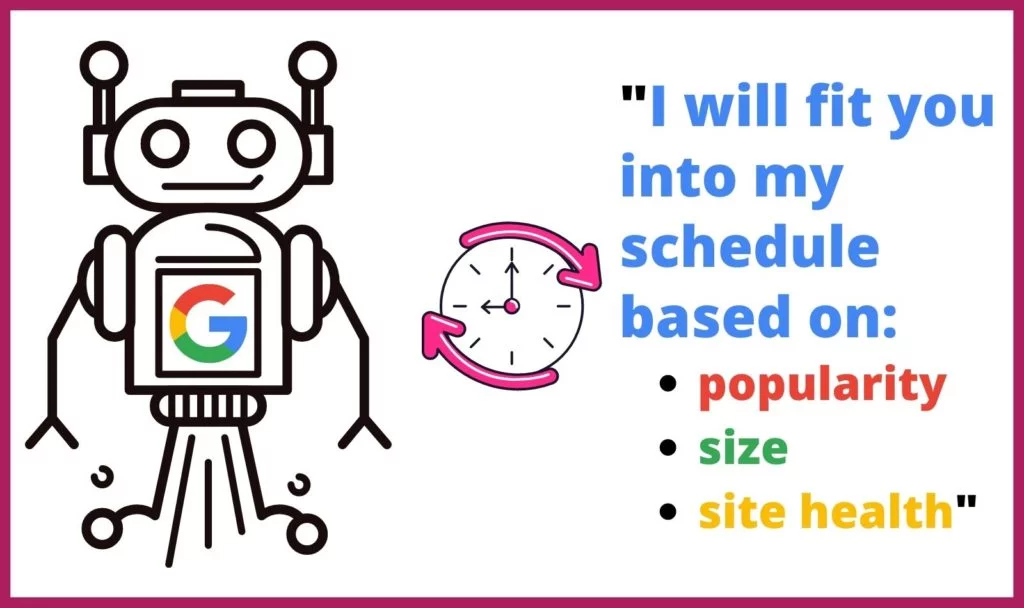

Google 不會對互聯網上的每個網站投入相同的時間或抓取次數。 網絡爬蟲還根據多種因素確定他們爬取哪些頁面以及頻率。 他們根據以下因素確定每個站點應該被抓取的頻率和時間:

Google 不會對互聯網上的每個網站投入相同的時間或抓取次數。 網絡爬蟲還根據多種因素確定他們爬取哪些頁面以及頻率。 他們根據以下因素確定每個站點應該被抓取的頻率和時間:

- 受歡迎程度:訪問站點或頁面的次數越多,分析更新的頻率就越高。 此外,更受歡迎的頁面將更快地積累更多的入站鏈接。

- 大小:具有更多數據密集型元素的大型網站和頁面需要更長的時間來抓取。

- 健康/問題:當網絡爬蟲通過內部鏈接到達死胡同時,它需要時間才能找到新的起點——或者它會放棄爬行。 404 錯誤、重定向和緩慢的加載時間會減慢並阻礙網絡爬蟲。

您的抓取預算如何影響 SEO?

網絡爬蟲索引過程使搜索成為可能。 如果您的內容無法被 Google 的網絡爬蟲編入索引,您的網頁和網站將不會被搜索者發現。 這會導致您的網站錯失大量搜索流量。

為什麼谷歌抓取網站?

Googlebots 系統地瀏覽網站頁面以確定頁面和整個網站的內容。 網絡爬蟲逐頁處理、分類和組織來自該網站的數據,以便創建 URL 及其內容的緩存,以便 Google 可以確定應顯示哪些搜索結果以響應搜索查詢。

此外,Google 使用此信息來確定哪些搜索結果最適合搜索查詢,以確定每個搜索結果應出現在分層搜索結果列表中的什麼位置。

爬行過程中會發生什麼?

Google 會為 Googlebot 分配一定的時間來處理網站。 由於此限制,機器人可能不會在一次抓取會話期間抓取整個站點。 相反,它將根據 robots.txt 文件和其他因素(例如頁面的受歡迎程度)遍歷網站的所有頁面。

在抓取會話期間,Googlebot 將使用系統的方法來理解它處理的每個頁面的內容。

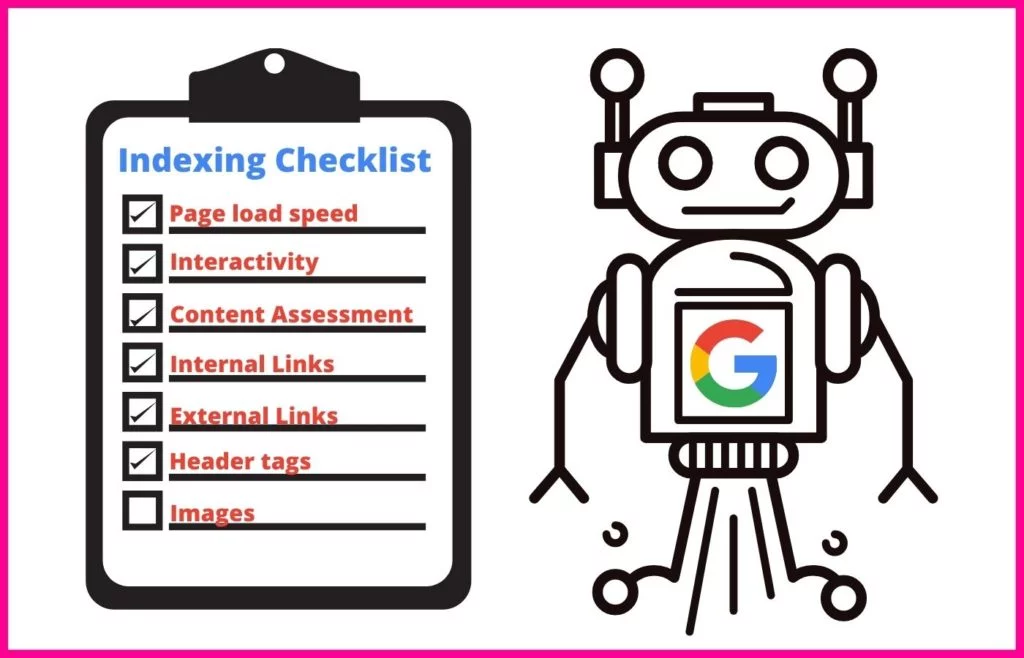

這包括索引特定屬性,例如:

- 元標記並使用 NLP 確定其含義

- 鏈接和錨文本

- 用於圖像搜索和視頻搜索的富媒體文件

- 架構標記

- HTML 標記

網絡爬蟲還將運行檢查以確定頁面上的內容是否與規範內容重複。 如果是這樣,Google 會將 URL 降低到低優先級抓取,這樣它就不會浪費時間抓取該頁面。

什麼是抓取率和抓取需求?

Google 的網絡抓取工具會為其執行的每次抓取分配一定的時間。 作為網站所有者,您無法控制這段時間。 但是,當他們在您的網站上時,您可以更改他們抓取您網站上各個頁面的速度。 這個數字稱為您的抓取率。

抓取需求是指 Google 抓取您網站的頻率。 此頻率基於互聯網用戶對您網站的需求以及您網站內容需要在搜索中更新的頻率。 您可以使用日誌文件分析了解 Google 抓取您網站的頻率(請參閱下面的 #2)。

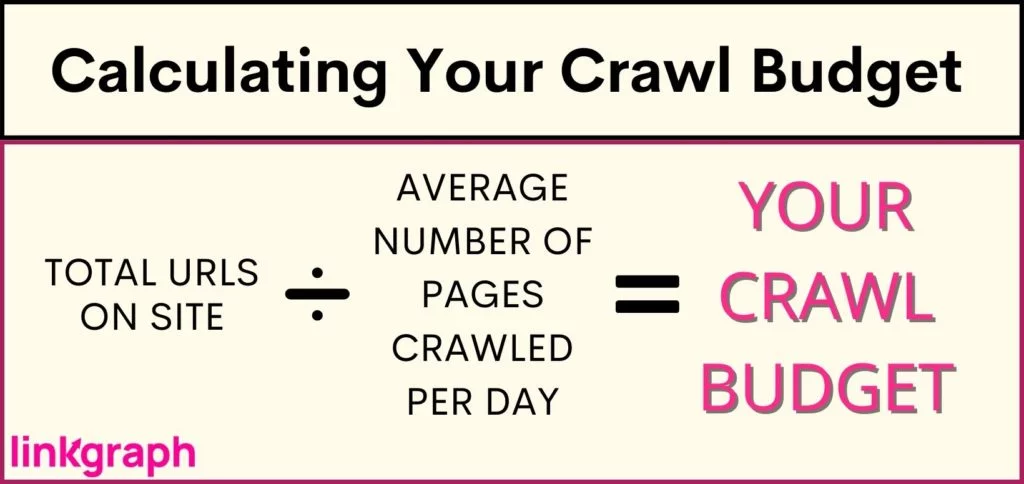

如何確定我網站的抓取預算?

由於 Google 限制了他們抓取您網站的次數和抓取時間,因此您需要了解自己的抓取預算。 然而,谷歌不會向網站所有者提供這些數據——尤其是當你的預算非常有限以至於新內容無法及時出現在 SERP 上時。 這對於重要內容和新頁面(例如可以賺錢的產品頁面)來說可能是災難性的。

要了解您的網站是否面臨抓取預算限制(或確認您的網站是 A-OK),您需要: 獲取您網站上有多少 URL 的清單。 如果您使用 Yoast,您的總數將列在站點地圖 URL的頂部。

您如何優化您的抓取預算?

當您的網站變得太大而無法滿足其抓取預算時,您將需要深入研究抓取預算優化。 因為您不能告訴 Google 更頻繁地或更長時間地抓取您的網站,所以您必須專注於您可以控制的內容。

抓取預算優化需要多方面的方法和對Google 最佳實踐的理解。 在充分利用抓取速度方面,您應該從哪裡開始? 這份綜合列表是按層次順序編寫的,因此請從頂部開始。

1.考慮增加您網站的抓取速度限制

Google 同時向您網站上的多個頁面發送請求。 但是,Google 盡量保持禮貌,不會讓您的服務器陷入困境,從而導致您的網站訪問者的加載時間變慢。 如果您發現您的網站無緣無故地滯後,這可能就是問題所在。

為了防止影響用戶體驗,Google 允許您降低抓取速度。 這樣做會限制 Google 可以同時索引的頁面數量。

不過,有趣的是,Google 還允許您提高抓取速度限制——效果是他們可以一次拉取更多頁面,從而導致一次抓取更多 URL。 雖然,所有報告都表明谷歌對抓取速度限制增加的反應很慢,並且不能保證谷歌會同時抓取更多網站。

如何提高抓取速度限制:

- 在 Search Console 中,轉到“設置”。

- 從那裡,您可以查看您的抓取速度是否最佳。

- 然後,您可以將限制提高到 90 天內更快的抓取速度。

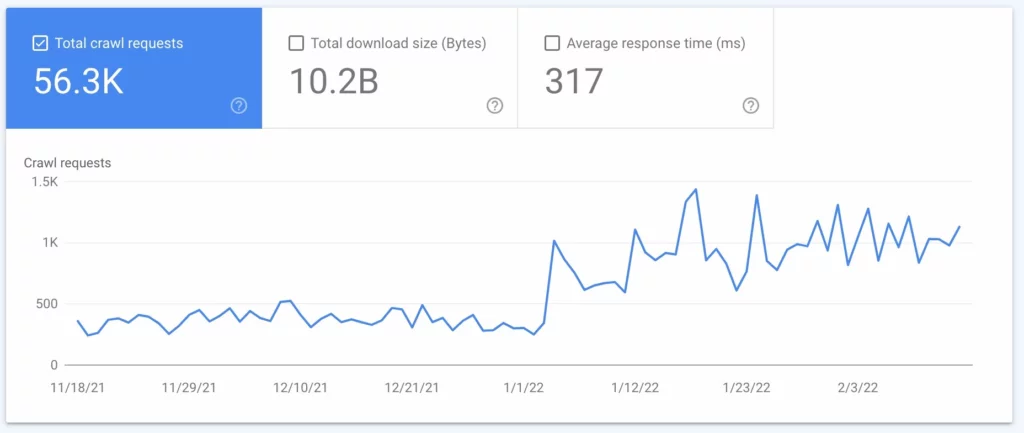

2.執行日誌文件分析

日誌文件分析是來自服務器的報告,反映了發送到服務器的每個請求。 該報告將準確告訴您 Googlebots 在您的網站上做了什麼。 雖然此過程通常由技術 SEO 執行,但您可以與您的服務器管理員聯繫以獲得一個。

使用您的日誌文件分析或服務器日誌文件,您將了解到:

- Google 抓取您網站的頻率

- 哪些頁面被抓取最多

- 哪些頁面有無響應或缺少服務器代碼

獲得此信息後,您可以使用它來執行#3 到#7。

3. 更新您的 XML 站點地圖和 Robots.txt

如果您的日誌文件顯示 Google 花費過多時間抓取您不希望出現在 SERP 中的頁面,您可以請求 Google 的抓取工具跳過這些頁面。 這可以釋放您的一些抓取預算,用於更重要的頁面。

您的站點地圖(您可以從 Google Search Console 或SearchAtlas 獲得)為 Googlebots 提供了您網站上所有您希望 Google 編制索引以便它們可以顯示在搜索結果中的頁面的列表。 使用您希望搜索引擎找到的所有網頁更新您的站點地圖,並忽略您不希望他們找到的網頁,可以最大限度地利用網絡爬蟲在您網站上花費的時間。

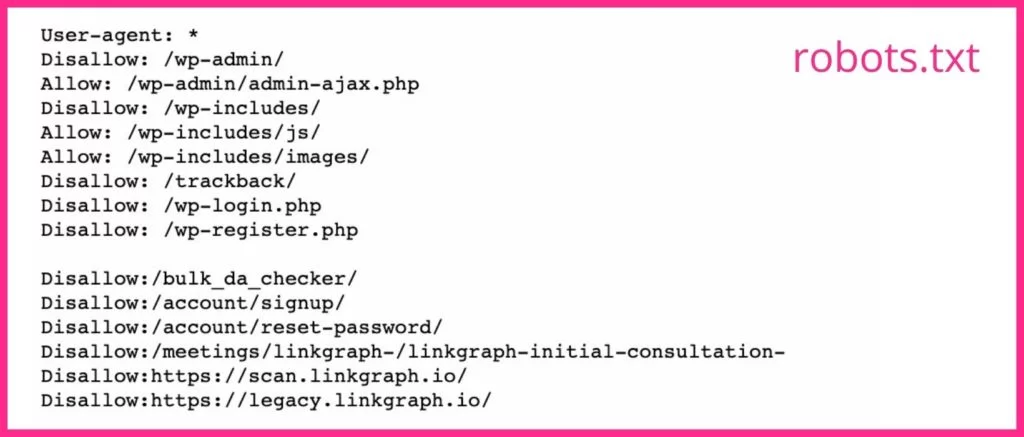

您的 robots.txt 文件告訴搜索引擎抓取工具您想要和不希望他們抓取哪些頁面。 如果您的網頁無法成為良好的著陸頁或被門控的網頁,您應該在 robots.txt 文件中為它們的 URL使用noindex 標記。 Googlebots 可能會跳過任何帶有 noindex 標籤的網頁。

4.減少重定向和重定向鏈

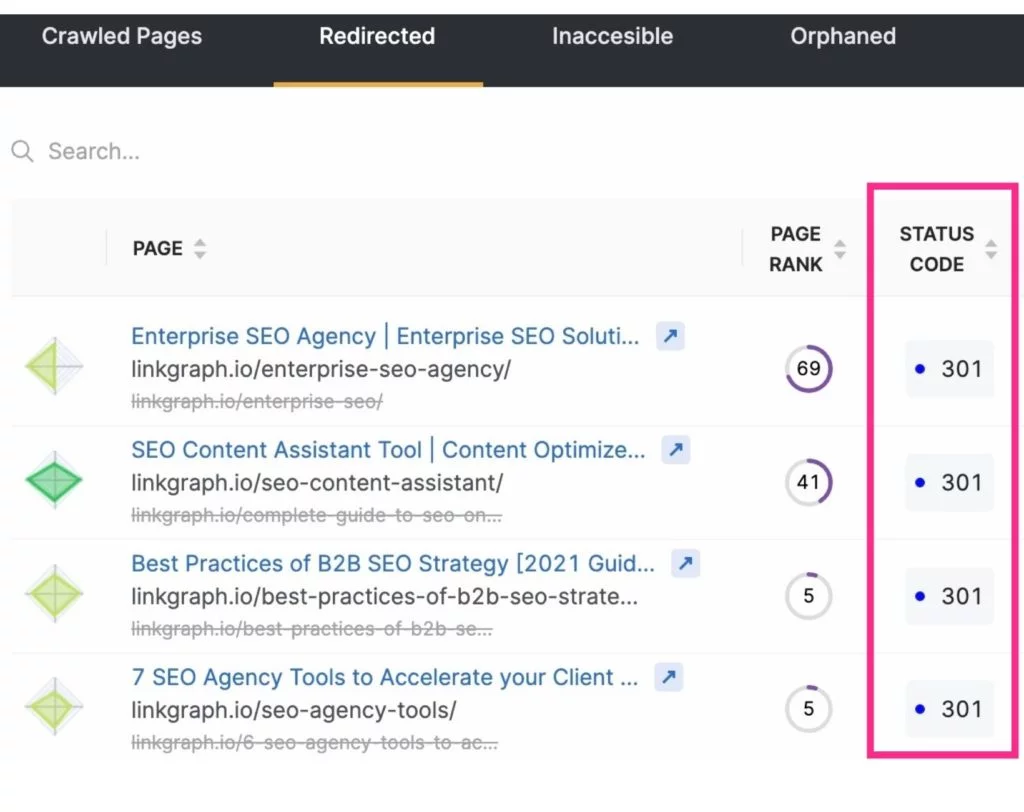

除了通過從搜索引擎抓取中排除不必要的頁面來釋放抓取預算外,您還可以通過減少或消除重定向來最大化抓取。 這些將是導致 3xx 狀態代碼的任何 URL。

Googlebot 檢索重定向的 URL 需要更長的時間,因為服務器必須響應重定向,然後檢索新頁面。 雖然一個重定向只需要幾毫秒,但它們可以加起來。 這會使抓取您的網站總體上花費更長的時間。 當 Googlebot 遇到一系列 URL 重定向時,這段時間會成倍增加。

要減少重定向和重定向鏈,請注意您的內容創建策略並仔細選擇 slug 的文本。

5.修復損壞的鏈接

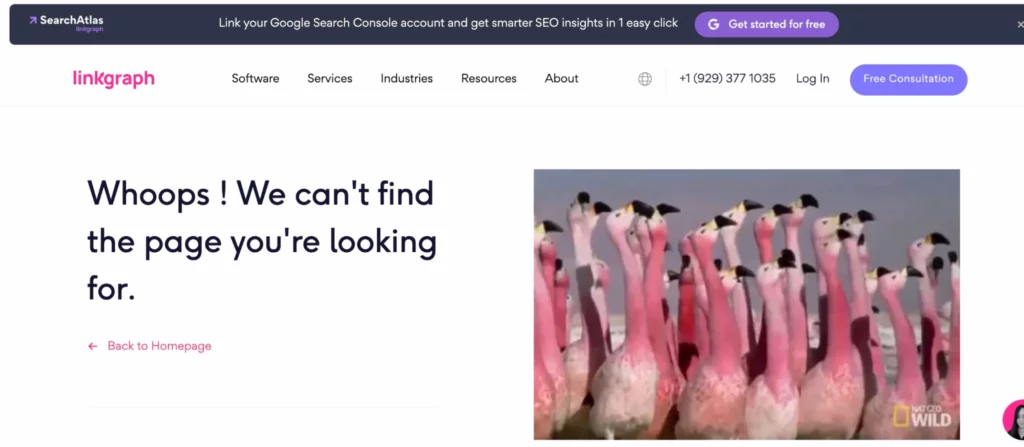

谷歌瀏覽網站的方式通常是通過您的內部鏈接結構進行導航。 當它在您的頁面中運行時,它會注意到鏈接是否指向不存在的頁面(這通常稱為軟 404 錯誤)。 然後它會繼續前進,不想浪費時間索引所述頁面。

這些頁面的鏈接需要更新才能將用戶或 Googlebot 發送到真實頁面。 或者(雖然很難相信)Googlebot 可能在頁面實際存在時將頁面錯誤識別為 4xx 或 404 錯誤。 發生這種情況時,請檢查 URL 是否有任何拼寫錯誤,然後通過您的 Google Search Console 帳戶提交對該 URL 的抓取請求。

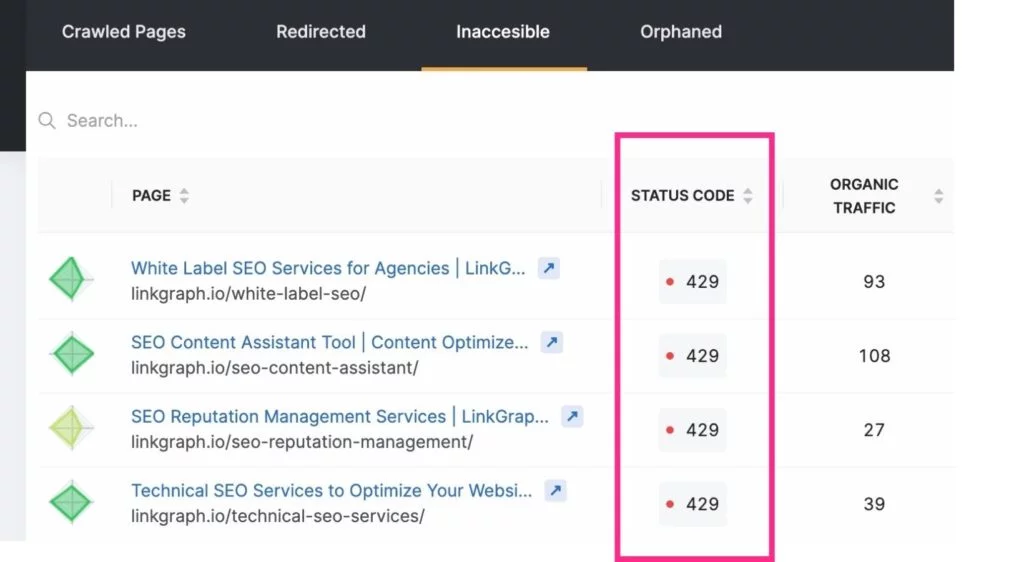

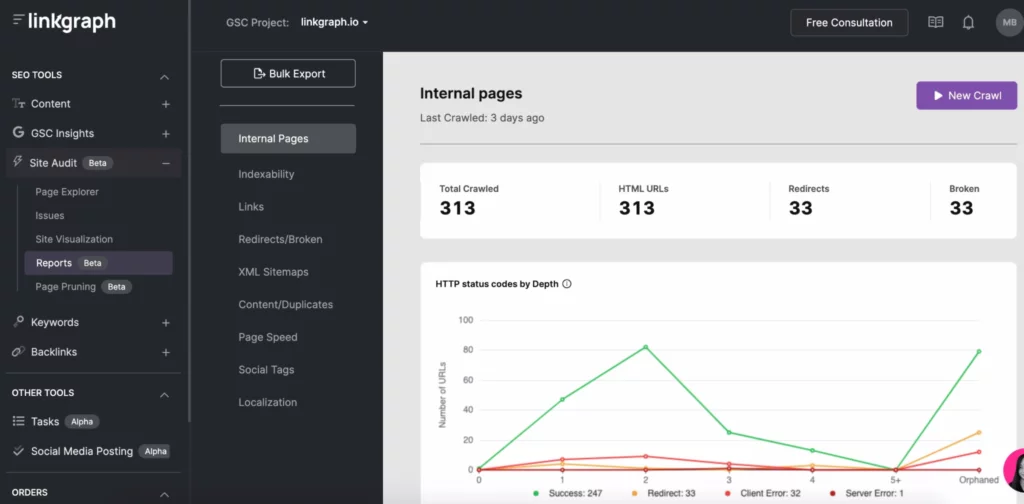

要及時了解這些抓取錯誤,您可以使用 Google Search Console 帳戶的索引 > 覆蓋率報告。 或者使用SearchAtlas的站點審核工具來查找您的站點錯誤報告以傳遞給您的網絡開發人員。

注意:新 URL 可能不會立即出現在您的日誌文件分析中。 在請求抓取之前給谷歌一些時間來找到它們。

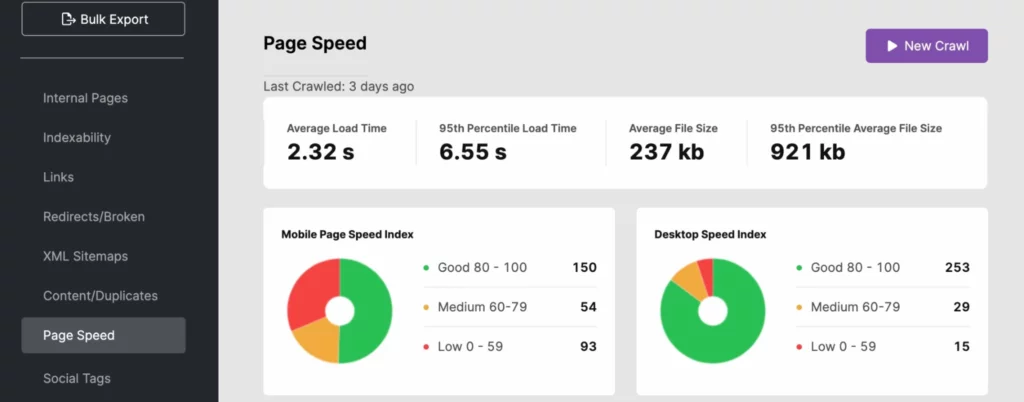

6.努力提高頁面加載速度

搜索引擎機器人可以快速瀏覽網站。 但是,如果您的網站速度沒有達到標準,它確實會對您的抓取預算造成重大損失。 使用您的日誌文件分析、 SearchAtlas或 PageSpeedInsights 來確定您網站的加載時間是否對您的搜索可見性產生負面影響。

要縮短您網站的響應時間,請使用動態 URL 並遵循Google 的 Core Web Vitals 最佳實踐。 這可以包括首屏媒體的圖像優化。

如果站點速度問題出在服務器端,您可能需要投資其他服務器資源,例如:

- 專用服務器(尤其適用於大型網站)

- 升級到更新的服務器硬件

- 增加內存

這些改進還將提升您的用戶體驗,這可以幫助您的網站在 Google 搜索中表現更好,因為網站速度是 PageRank 的一個信號。

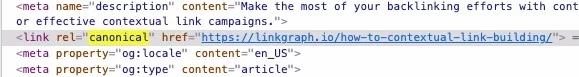

7. 不要忘記使用規範標籤

Google 不贊成重複內容——至少當您不承認重複內容有源頁面時。 為什麼? 除非不可避免,否則 Googlebot 會抓取每個頁面,除非另有指示。 但是,當它遇到重複頁面或它熟悉的內容的副本(在您的頁面上或站點外)時,它將停止抓取該頁面。 雖然這可以節省時間,但您應該通過使用標識規範 URL 的規範標籤來為爬蟲節省更多時間。

Canonicals告訴 Googlebot 不要費心使用您的抓取時間段來索引該內容。 這使搜索引擎機器人有更多時間檢查您的其他頁面。

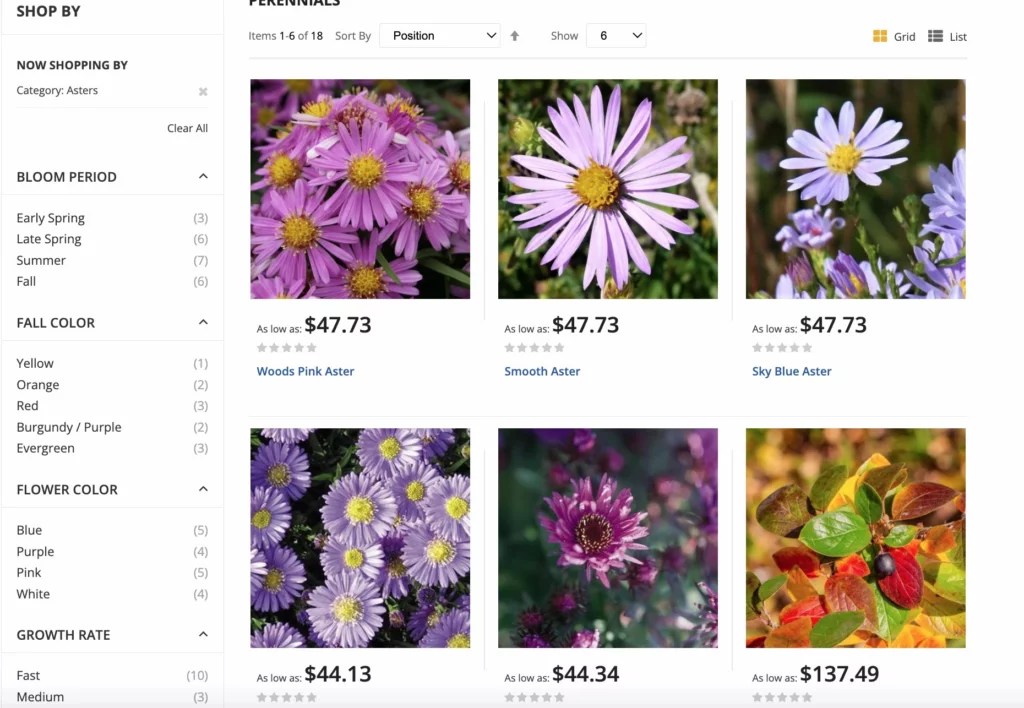

8.關注你的內部鏈接結構

在您的站點中採用結構良好的鏈接做法可以提高 Google 抓取的效率。 內部鏈接告訴 Google 您網站上的哪些頁面最重要,這些鏈接有助於爬蟲更輕鬆地找到頁面。

最好的鏈接結構將用戶和 Googlebot 連接到整個網站的內容。 始終使用相關的錨文本並在您的內容中自然放置 yoru 鏈接。

對於電子商務網站,谷歌擁有分面導航選項的最佳實踐,以最大限度地提高抓取率。 分面導航允許站點用戶按屬性過濾產品,從而使購物成為更好的體驗。 除了過多的 URL 爬網之外,此更新還有助於避免規範混淆和重複問題。

9. 刪除不必要的內容

每次抓取網站時,Googlebots 只能如此快速地移動並索引如此多的頁面。 如果您有大量頁面沒有收到流量或內容過時或質量低下,請將其刪除! 修剪過程可讓您剪掉可能拖累網站的多餘包袱。

在您的網站上擁有過多的頁面可能會在忽略頁面的同時將 Googlebot 轉移到不重要的頁面上。

請記住將任何鏈接重定向到這些頁面,這樣您就不會遇到抓取錯誤。

10.積累更多反向鏈接

正如 Googlebots 到達您的站點然後開始根據內部鏈接對頁面進行索引一樣,他們也在索引過程中使用外部鏈接。 如果其他網站鏈接到您的網站,Googlebot 將轉到您的網站並為頁面編制索引,以便更好地理解鏈接內容。

此外,反向鏈接讓您的網站更受歡迎和新近度更高,谷歌使用它來確定您的網站需要多久被索引一次。

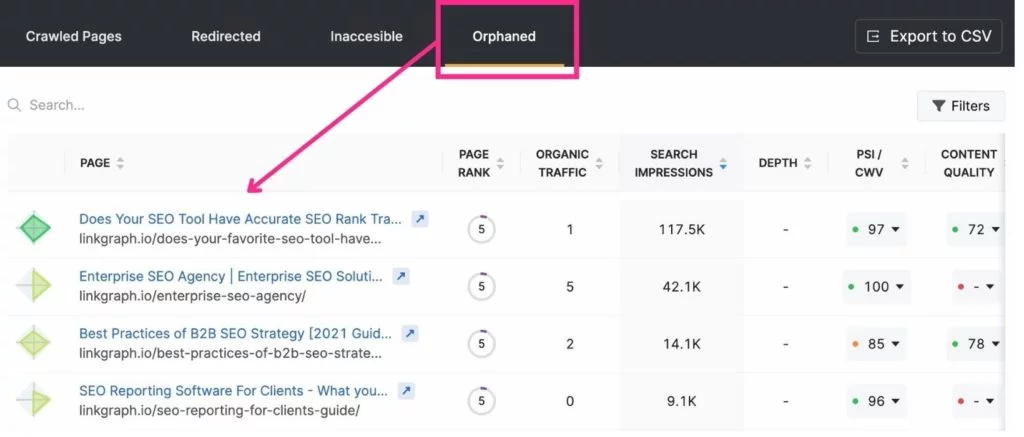

11. 消除孤兒頁面

因為 Google 的爬蟲通過內部鏈接從一個頁面跳到另一個頁面,所以它可以毫不費力地找到鏈接到的頁面。 但是,未鏈接到您網站上某處的頁面通常不會被 Google 注意到。 這些被稱為“孤立頁面”。

什麼時候它是一個孤兒頁面合適? 如果它是具有非常特定目的或受眾的著陸頁。 例如,如果您向居住在邁阿密的高爾夫球手發送了一封電子郵件,其中包含僅適用於他們的登錄頁面,您可能不想鏈接到其他頁面。

抓取預算優化的最佳工具

在優化抓取預算方面,Search Console 和 Google Analytics 可以派上用場。 Search Console 允許您請求抓取工具來索引頁面並跟踪您的抓取統計信息。 Google Analytics 幫助您跟踪您的內部鏈接之旅。

其他 SEO 工具,例如 SearchAtlas,可讓您通過站點審核工具輕鬆找到抓取問題。 通過一份報告,您可以查看您網站的:

- 可索引性抓取報告

- 索引深度

- 頁面速度

- 重複內容

- 網站地圖

- 鏈接

優化您的抓取預算並成為搜索引擎最佳執行者

雖然您無法控制搜索引擎為您的網站編制索引的頻率或時間,但您可以優化您的網站以充分利用每次搜索引擎抓取。 從您的服務器日誌開始,仔細查看 Search Console 上的抓取報告。 然後深入修復所有抓取錯誤、鏈接結構和頁面速度問題。

當您完成 GSC 抓取活動時,請專注於您的 SEO 策略的其餘部分,包括鏈接構建和添加優質內容。 隨著時間的推移,您會發現您的著陸頁爬升到搜索引擎結果頁。