如何優化您的抓取預算並提升排名?

已發表: 2017-01-14目錄

- 1什麼是抓取預算?

- 2為什麼抓取預算很重要?

- 3抓取預算何時成為問題?

- 4如何優化您的抓取預算

- 5 1.改善網站結構

- 6 2.解決斷開的鏈接

- 7 3.謹慎使用富媒體內容

- 8 4.清理站點地圖

- 9 5.建立外部鏈接

- 10 6.組織內部鏈接

- 11 7.利用Feed

- 12 8.刪除重定向鏈

- 13 9.確保您的頁面是可抓取的

每個人都知道什麼是搜索引擎優化以及結構良好的網站、相關關鍵字、優質內容、適當的標記、乾淨的站點地圖和其他技術標準的重要性。 但是有機會,你沒有考慮過爬行優化。

抓取預算優化是比搜索引擎優化更深層次的東西。 雖然搜索引擎優化更側重於優化用戶查詢的過程,但抓取優化側重於搜索引擎機器人(網絡蜘蛛)如何訪問您的網站。

在本文中,我們將介紹搜索引擎如何將抓取預算分配給網站的機制,以及幫助您充分利用抓取預算以最大化排名、自然流量和最重要的索引的技巧。

什麼是抓取預算?

抓取預算只是搜索引擎蜘蛛在給定時間段內抓取您網站的頁面數量。 抓取預算通常取決於您網站的大小和健康狀況以及指向您網站的鏈接數量。

抓取預算是一個重要的 SEO 因素,但往往沒有得到足夠的重視。 搜索引擎使用蜘蛛機器人來抓取網頁、收集信息並將其添加到索引中。 此外,他們還指出他們訪問的頁面上的鏈接,並嘗試抓取這些新頁面。

例如,Googlebot 是一種網絡蜘蛛,它發現新頁面並將它們添加到 Google 索引中。 大多數網絡服務和 SEO 工具都信任這些網絡蜘蛛來收集有用的信息。

為什麼抓取預算很重要?

網站的可抓取性是確保其可搜索性的主要和關鍵步驟。 如果您想知道優化抓取預算對您的網站是否重要,答案當然是肯定的。 您的 SEO 努力和抓取優化可能會齊頭並進。

儘管它很簡單,但您應該關注抓取預算是很合乎邏輯的,因為它使 Google 更容易發現您的網站並將其編入索引。 如果您的網站上的抓取次數更多,則意味著您在發布新內容時將獲得更快的更新。 因此,您的抓取預算越大,這種情況發生的速度就越快。

這還將幫助您改善網站的整體用戶體驗,從而提高知名度,並最終提高 SERP 排名。 事實是,最近被抓取的頁面在 SERP 中獲得了更多的可見性,如果一個頁面有一段時間沒有被抓取,它的排名就不會很好。

抓取預算何時成為問題?

抓取預算並不是經常會產生問題。 如果您為網站的 URL 分配了按比例的抓取,這不是問題。 但是,假設您的網站有 200,000 個 URL,而 Google 每天只在您的網站上抓取 2,000 個頁面,那麼 Google 可能需要 100 天才能識別或更新這些 URL – 現在這是一個問題。

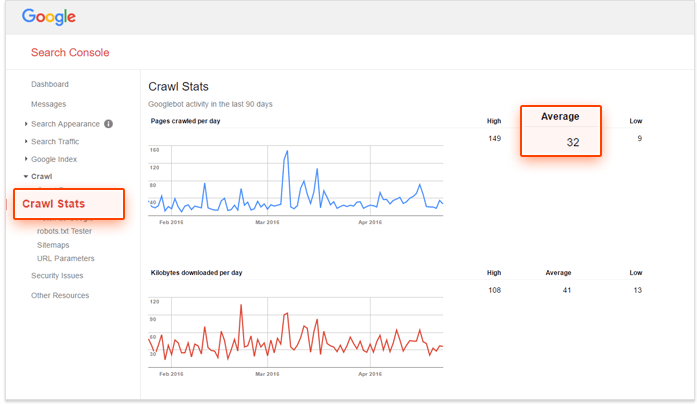

如果您正在尋找解決方案並想檢查您的抓取預算是否需要優化,請使用 Google Search Console 和您網站上的網址數量來計算您網站的“抓取數量”。 這個怎麼做?

–首先,您需要評估您的網站上有多少頁面,您可以通過做一個網站來做到這一點:在 Google 上搜索,

–其次,轉到您的 Google Search Console 帳戶並轉到 Crawl,然後轉到 Crawl Stats。 如果您的帳戶配置不正確,您將無法獲得此數據。

–第三步是將您網站上的頁面總數除以您網站上每天抓取的平均頁面數。

如果此數字大於 10,則需要考慮優化抓取預算。 如果小於 5,那就太好了! 您無需進一步閱讀。

如何優化您的抓取預算

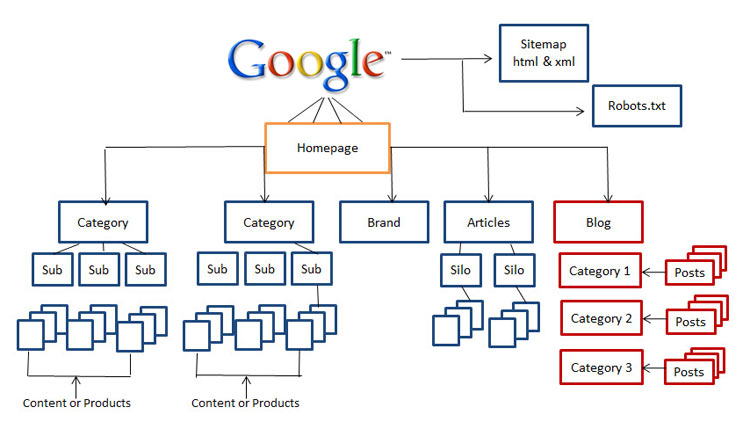

1.改善網站結構

今天,網站結構的重要性是一個至關重要的因素。 像 Rand Fishkin 這樣的 SEO 大師建議確保您網站的用戶在訪問期間距離主頁不超過三下。 就可用性而言,這對於 SEO 來說確實是一個很好的建議,因為您的訪問者不太可能深入挖掘您的網站。

因此,如果您沒有一個乾淨、易於導航且對搜索引擎友好的網站,那麼現在是時候開始重組您的網站了。

2.解決斷開的鏈接

這是搜索引擎優化和爬網優化之間的基本區別之一,不僅斷開的鏈接在降低您的排名方面發揮了重要作用,它們還極大地阻礙了 Googlebot 對您的網站進行索引和排名的能力。

多年來,谷歌的算法有了很大的改進,任何影響用戶體驗的事情都可能影響 SERP。 谷歌一直試圖複製用戶行為並更新算法。 因此,當我們為搜索引擎優化網站時,我們應該始終考慮用戶體驗。

3.謹慎使用富媒體內容

今天,Google 很難抓取 Silverlight 和其他一些文件,但有時 Google 無法抓取 Flash、javascript 和 HTML 等富媒體內容。

但是,儘管 Google 可以讀取您的大部分富媒體文件,但其他搜索引擎可能無法讀取。 這意味著您應該明智地使用這些文件,有時您可能希望在要排名的頁面上完全避免使用它們。

4.清理站點地圖

努力清理您的站點地圖並使其保持最新狀態,以防止出現可能損害您網站可用性的混亂情況,包括被阻止的頁面、非規範頁面、不必要的重定向和 400 級頁面。 使用 XML 站點地圖是幫助您的用戶和蜘蛛機器人的最佳方式。

市場上有各種工具可以清理您的站點地圖。 您可以使用 XML 站點地圖生成器創建一個乾淨的站點地圖,排除所有阻止索引的頁面,查找並修復 301 和 302 重定向和非規範頁面等內容。

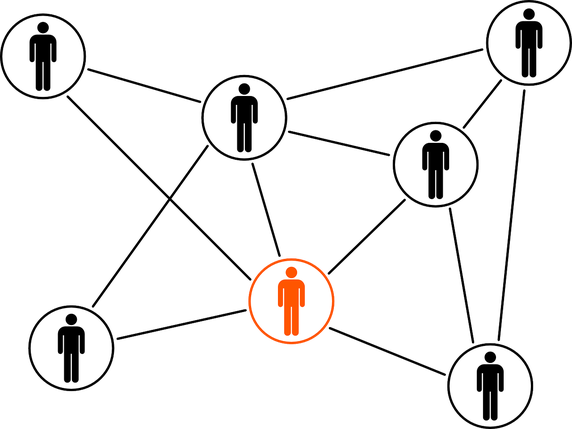

5.建立外部鏈接

鏈接建設是一個空前的熱門話題,並且在不久的將來不會消失。 發現新社區、建立在線關係和建立品牌價值是您在鏈接建立過程中應該已經擁有的一些好處。

當通過最佳實踐完成時,外部鏈接是指向外部域的鏈接,也是獲得更高排名的最重要來源。 儘管外部鏈接是最難操作的指標,但它們是搜索引擎了解網頁受歡迎程度和相關性的好方法。

6.組織內部鏈接

雖然內部鏈接建設與爬蟲預算優化沒有太大關係,但這並不意味著你可以忽略它。 組織良好且維護良好的網站結構有助於用戶和蜘蛛機器人輕鬆查看您的內容,而無需花費足夠的抓取預算。

結構良好的內部鏈接系統還可以增強用戶體驗。 幫助用戶通過點擊幾下即可到達任何區域並使事物易於訪問通常會使訪問者在您的網站上停留更長時間,這將提高您的 SERP 排名。

7.利用Feed

RSS、Atom 和 XML 等各種提要可幫助您的網站向用戶提供內容,即使他們沒有瀏覽您的網站。 這是用戶訂閱最受青睞的網站並在發布新內容時獲得定期更新的最佳方式。

長期以來,RSS 提要被證明是提高網站讀者人數和參與度的好方法。 此外,它們也是谷歌網絡蜘蛛訪問量最大的網站之一。 當您的網站有更新時,您可以將其提交到 Google 的 Feed Burner,以確保它已正確編入索引。

8.刪除重定向鏈

您重定向到的每個 URL 都會浪費一點您的抓取預算。 當您的網站具有較長的重定向鏈時,這意味著連續有大量的 301 和 302 重定向,那麼網絡蜘蛛可能會在到達您的目標頁面之前下降,最終您的頁面將不會被索引。 如果您正在尋找重定向的最佳實踐,最好在您的網站上使用盡可能少的重定向,並且連續不超過兩個。

9.確保您的頁面是可抓取的

如果搜索引擎蜘蛛機器人能夠找到您的網頁,找到並跟踪您網站中的鏈接,那麼它們就是可抓取的。 因此,您需要配置您的 robots.txt 和 .htaccess 文件,以免它們阻止您網站的關鍵頁面。

您可能還需要提供支持富媒體內容(如 flash、silverlight 等)的頁面的文本文件。

僅通過在 robots.txt 中禁止,您不能保證阻止頁面被取消索引。 如果有外部內容(例如傳入鏈接)繼續將流量引導到您已禁止的頁面,Google 可能會認為該頁面仍然相關。 在這種情況下,您需要手動阻止該頁面被編入索引。 您可以使用 X-Robots-Tag HTTP 標頭或 noindex robots 元標記輕鬆完成此操作。

請注意,如果您使用 noindex 元標記或 X-Robots-Tag,則不應禁止 robots.txt 中的頁面,必須先抓取該頁面,然後才能看到並遵守該標記。

結論:抓取預算優化不是一件容易的事,當然也不是“速贏”。 如果您有一個中小型網站,並且維護得很好,那麼您可能沒問題。 但是,如果您有一個包含數千個 URL 的複雜且無組織的站點結構,並且服務器日誌文件超出您的想像 - 可能是時候請專業人士或專家來幫助您了。