高風險,高回報:品牌如何合乎道德地使用人工智能

已發表: 2023-07-18生成式人工智能已經改變了世界,但閃光的並非都是金子。 雖然消費者對 ChatGPT 等產品的興趣很高,但專家和消費者越來越擔心人工智能對社會的危險。 對失業、數據安全、錯誤信息和歧視的擔憂是引起恐慌的主要領域。

人工智能是美國增長最快的恐懼,比一個季度前增長了 26%。

人工智能無疑將改變我們的工作方式,但公司需要意識到隨之而來的問題。 在這篇博客中,我們將探討消費者對工作和數據安全的擔憂,品牌如何減輕擔憂,並保護自己和消費者免受潛在風險。

1. 保護生成式人工智能

ChatGPT 和圖像創建器 DALL-E 等生成式 AI 內容正在迅速成為日常生活的一部分,超過一半的消費者至少每週都會看到 AI 生成的內容。 由於這些工具需要大量數據來學習和生成響應,因此敏感信息可能會混入其中。

生成式人工智能平台具有許多移動部件,允許用戶以各種方式貢獻代碼,以期改進流程和性能。 缺點是,由於許多人做出了貢獻,漏洞常常被忽視,並且個人信息可能會被洩露。 這正是 2023 年 5 月上旬 ChatGPT 發生的情況。

超過一半的消費者表示數據洩露會導致他們抵制某個品牌,因此需要優先考慮數據隱私。 在製定人工智能法律的同時,品牌需要自行製定透明度規則和使用指南,並向公眾公佈。

三分之二的消費者希望創建人工智能工具的公司對其開發方式保持透明。

這樣做可以建立品牌信任,這是目前特別令人垂涎的貨幣。 除了質量之外,數據安全是值得信賴的品牌最重要的因素。 隨著品牌忠誠度日益脆弱,品牌需要向消費者保證他們的數據是安全的。

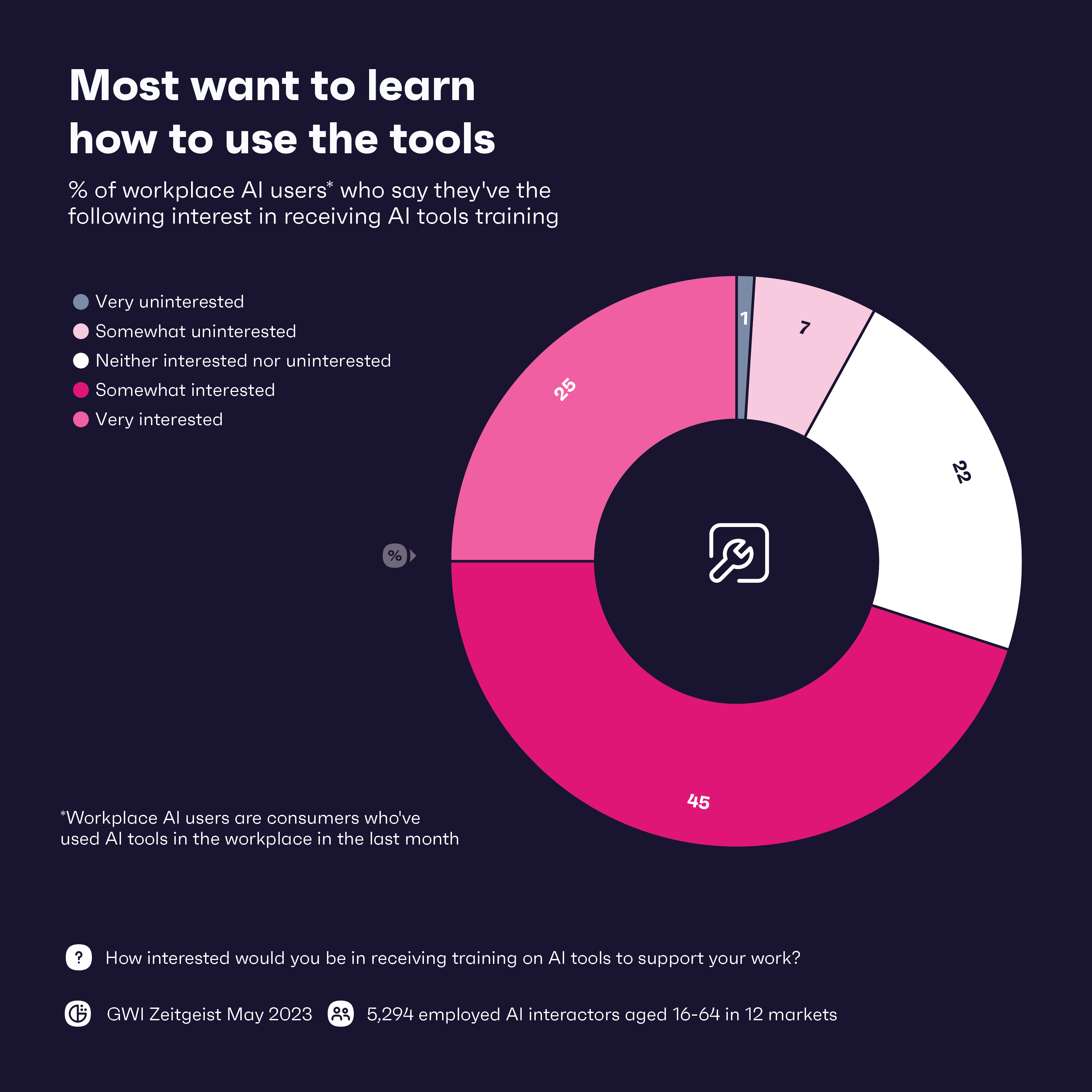

那麼,在人工智能時代保護數據的最佳方法之一是什麼? 第一道防線是對員工進行人工智能工具培訓,71% 的員工表示他們對培訓感興趣。 將其與數據保護培訓相結合同樣重要。 教育在這裡確實很關鍵——為員工提供確保數據隱私成為首要任務所需的知識將大有幫助。

2. 在假新聞世界中保持真實

Facebook用了4.5年的時間才達到1億用戶。 相比之下,ChatGPT 僅用了兩個多月的時間就達到了這一里程碑。

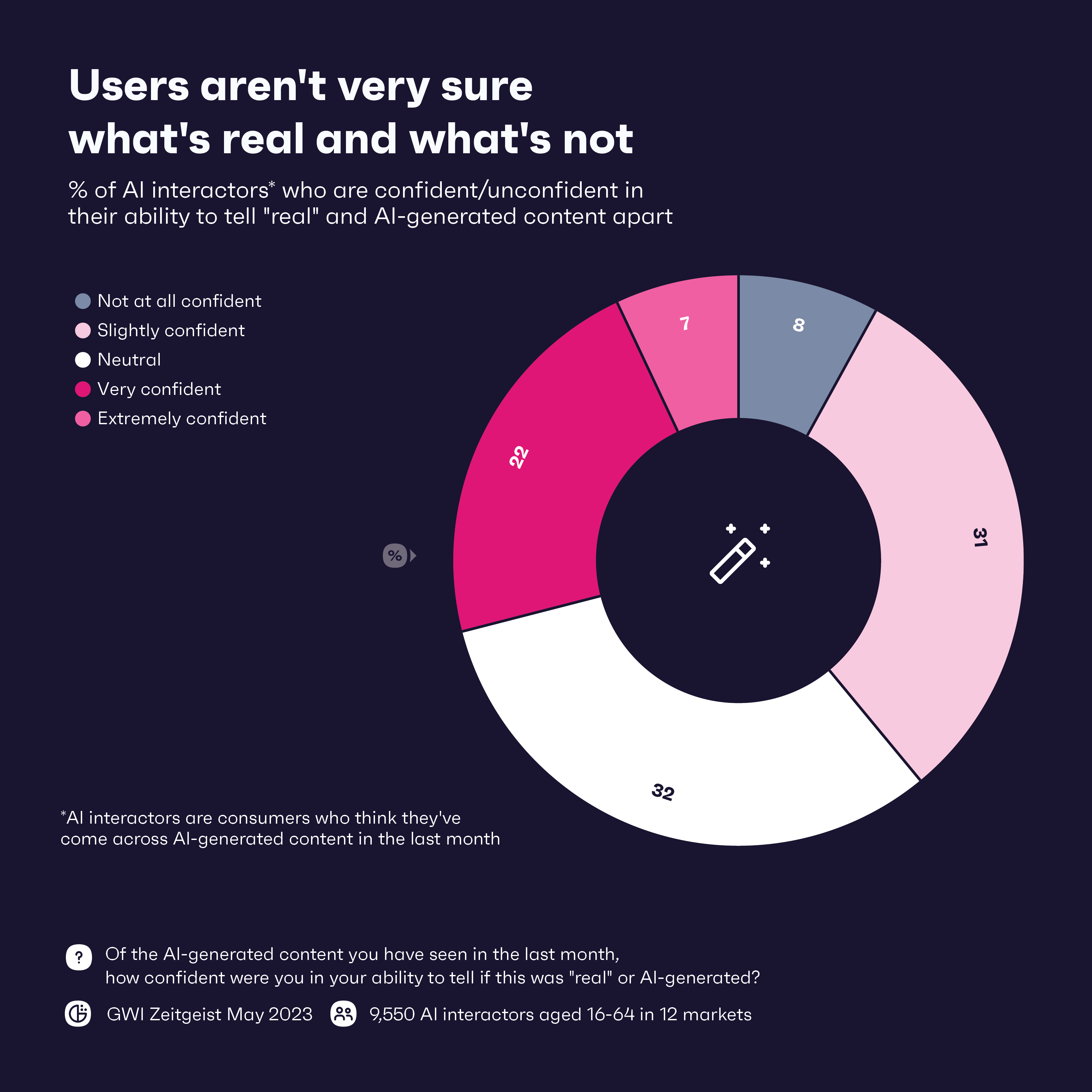

儘管生成式人工智能的崛起令人印象深刻,但它一直吸引著以音頻和視頻形式創作假新聞(即“深度偽造”)。 該技術已被用來在全球範圍內傳播錯誤信息。 只有 29% 的消費者對自己區分人工智能生成的內容和“真實”內容的能力充滿信心,隨著深度造假變得更加複雜,這種情況可能會變得更糟。

近三分之二的 ChatGPT 用戶表示,他們與該工具的交互就像與真人一樣,這表明該工具的說服力有多大。

但消費者已經預見到了這一點; 64% 的人表示他們擔心人工智能工具可能被用於不道德的目的。 考慮到這種擔憂,以及對檢測深度造假的信心不足,品牌可以在保護消費者免受最新一波假新聞影響並提供如何識別此類內容的教育方面發揮重要作用。

品牌可以首先實施來源驗證並對他們想要分享或推廣的任何信息進行盡職調查。 同樣,他們可以對可能收到的任何新聞報導進行合作或使用內部事實核查流程。 對於大多數品牌來說,這些措施可能已經到位,因為多年來假新聞和錯誤信息一直猖獗。

但隨著深度假貨變得越來越聰明,品牌將需要保持領先地位。 為了擊敗它們,品牌可能需要再次求助於人工智能,以基於人工智能的檢測工具的形式,這些工具可以識別和標記人工智能生成的內容。 這些工具將成為人工智能時代的必需品,但這可能還不夠,因為不良行為者通常會先行一步。 但是,結合檢測工具和人工監督來正確解釋上下文和可信度可能會阻止最壞的情況發生。

透明度也很關鍵。 讓消費者知道您正在採取措施應對人工智能生成的假新聞,可以贏得他們的信任,並有助於製定行業標準,幫助每個人與深度偽造保持同步。

3. 消除固有偏見

沒有人想要一場公關噩夢,但如果品牌不對從人工智能工具獲得的信息進行雙重檢查,這種可能性就確實存在。 請記住,人工智能工具從互聯網上抓取的數據中學習——這些數據充滿了人類偏見、錯誤和歧視。

為了避免這種情況,品牌應該使用多樣化且具有代表性的數據集來訓練人工智能模型。 雖然完全消除偏見和歧視幾乎是不可能的,但使用廣泛的數據集可以幫助消除其中的一些偏見和歧視。 更多的消費者關心人工智能工具的開發方式,而該主題的一些透明度可能會讓他們更加信任這些工具。

雖然所有品牌都應該關心使用公正的數據,但某些行業必須比其他行業更加小心。 銀行和醫療保健品牌尤其需要高度了解他們如何使用人工智能,因為這些行業有系統性歧視的歷史。 根據我們的數據,對特定社區造成傷害的行為是消費者抵制某個品牌的首要原因,而用於訓練人工智能工具的數 TB 數據中蘊藏著潛在的有害數據。

除了對所使用的數據集進行詳細審查之外,品牌還需要人員(最好是接受過多元化、公平和包容性 (DE&I) 培訓的人員)來監督整個過程。 根據我們的 GWI USA Plus 數據集,DE&I 對 70% 的美國人很重要,他們更有可能從與其價值觀相同的品牌購買產品。

4. 在工作場所與自動化取得適當的平衡

讓我們談談房間裡的大象。 人工智能對於工人來說是朋友還是敵人? 毫無疑問,正如我們所知,它將改變工作,但人工智能對工作場所的影響有多大取決於你問的是誰。

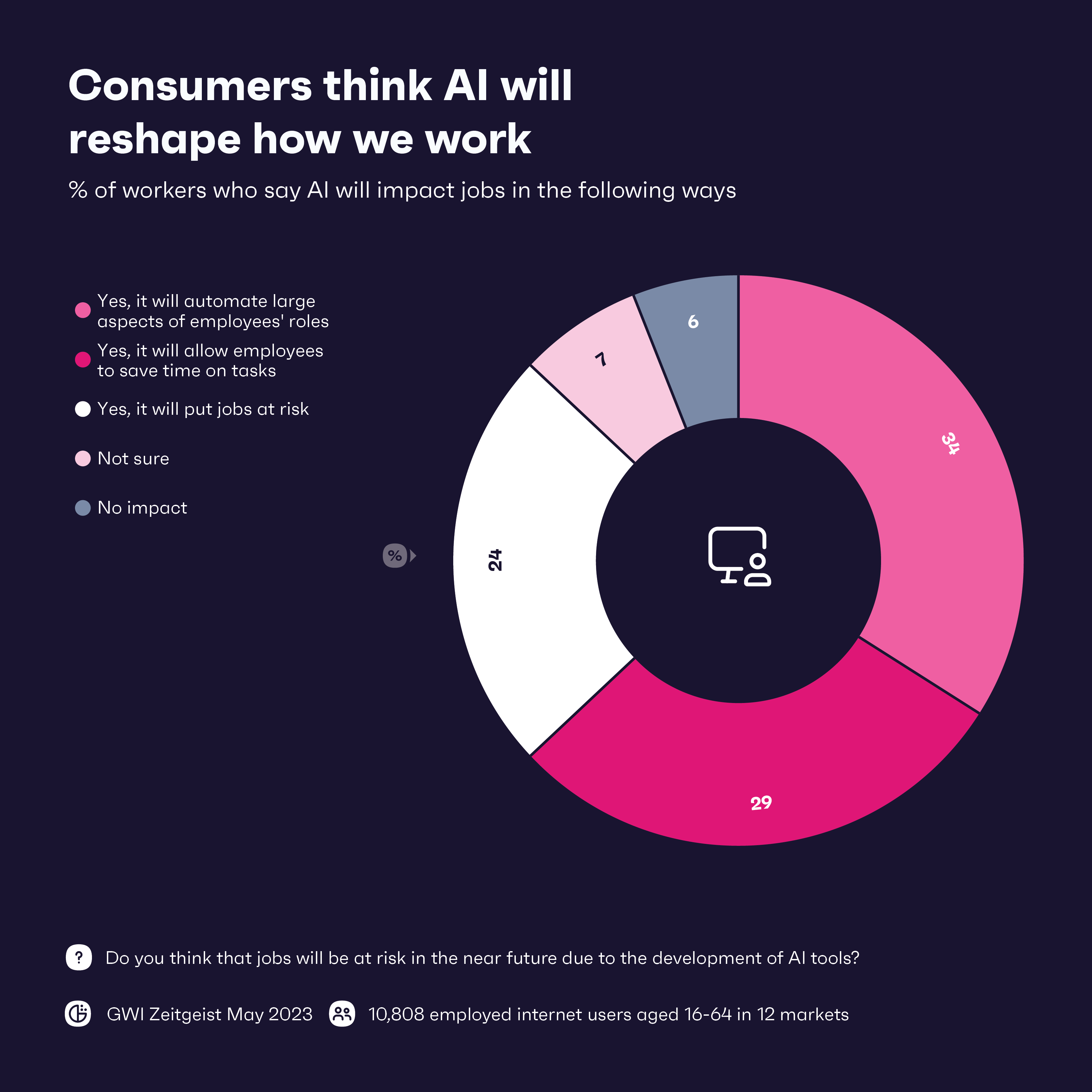

我們所知道的是,絕大多數工人希望人工智能對他們的工作產生某種影響。 預計員工角色的大部分方面將實現自動化,特別是在科技和製造/物流行業。 總體而言,工人們似乎對人工智能感到興奮,12 個行業中有 8 個行業表示自動化將產生積極影響。

另一方面,近 25% 的員工認為人工智能對就業構成威脅,而那些在旅遊、健康和美容行業工作的人尤其緊張。 生成式人工智能似乎每個月都在呈指數級增長,所以問題是:如果人工智能現在可以處理平凡的任務,那麼接下來會發生什麼?

即使人工智能確實在全球範圍內奪去了約 8000 萬個工作崗位,工人也可以找到有效使用人工智能的方法來提高自己的技能,即使是在脆弱的行業。 人工智能的客戶服務將經歷重大升級,但如果沒有人類,這一切就不可能發生。 生成式人工智能可以處理大多數查詢,但人類需要在那里處理敏感信息並提供同理心。 人類還可以與人工智能合作,提供更加個性化的解決方案和建議,這在旅遊和美容行業尤其重要。

人工智能自動化某些任務可以讓員工騰出時間以其他方式做出貢獻。 他們可以投入額外的時間進行戰略思考並提出創新解決方案,可能會產生新產品和服務。 每個公司和行業都會有所不同,但那些能夠在人工智能和人類工人之間取得適當平衡的人應該在人工智能時代蓬勃發展。

最後提示:您需要了解什麼

人工智能可能很強大,但品牌需要意識到其中的風險。 他們需要保護消費者數據並警惕假新聞。 透明度將是關鍵。 消費者對人工智能的未來感到緊張,品牌向他們表明他們的行為符合道德和負責任,這將大有幫助。

這項技術令人興奮,並且可能會對整個工作場所產生積極影響。 但品牌應該謹慎行事,並努力在技術和人力資本之間取得適當的平衡。 員工需要接受有關道德、安全和正確應用的廣泛培訓,這樣做可以提高他們的技能。 通過整合人工智能工具與人們一起工作,而不是徹底取代它們,品牌可以取得平衡,為人工智能增強的未來做好準備。